Tutoriel pour l’Outil de consolidation du flux de travail OpenVINO™

À propos

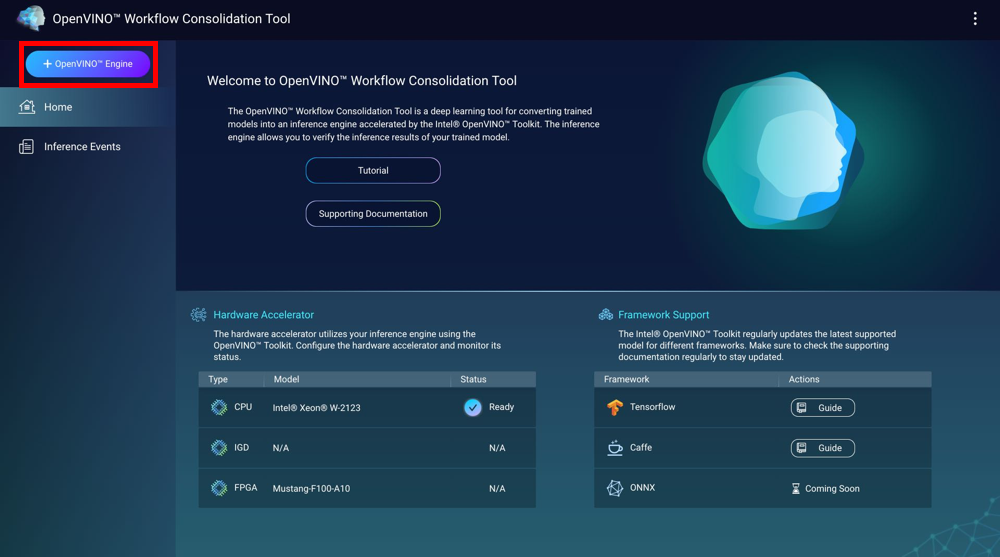

L’outil de consolidation du flux de travail OpenVINO™ (OWCT) est un outil d’apprentissage approfondi destiné à convertir les modèles formés en service de déduction accéléré par la distribution Intel® du kit d’outils OpenVINO™. Les moteurs d’inférence vous permettent de vérifier les résultats d’inférence des modèles formés.

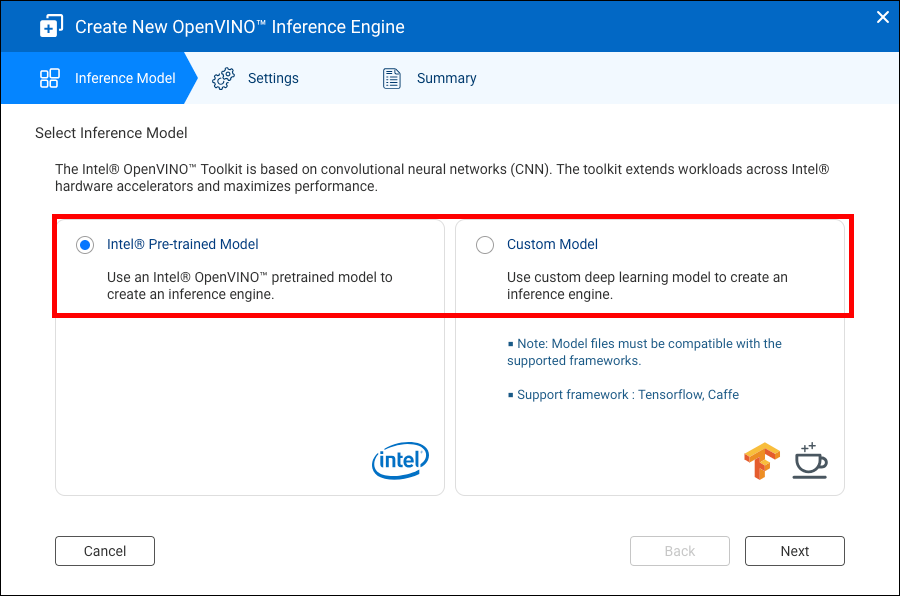

La distribution Intel® du kit d’outils OpenVINO™ se base sur les réseaux de neurones convolutifs (CNN). Le kit d’outils augmente les charges de travail sur les accélérateurs matériels Intel® afin de maximiser les performances.

Container Station doit être installé pour utiliser l’OWCT.

- Compatibilité

- Accélérateurs matériels

- Créer des moteurs d’inférence

- Utiliser la vision par ordinateur avec les moteurs d’inférence

- Gérer les moteurs d’inférence

Compatibilité

|

Plateforme |

Assistance |

|---|---|

|

Modèles de NAS |

Remarque :

Seuls les modèles de NAS sous Intel prennent en charge l’Outil de consolidation du flux de travail OpenVINO™. |

|

Système d'exploitation |

QTS 4.4 |

|

Distribution Intel® de la version du kit d’outils OpenVINO™ |

2018R5 Pour des détails, rendez-vous sur https://software.intel.com/en-us/articles/OpenVINO-RelNotes. |

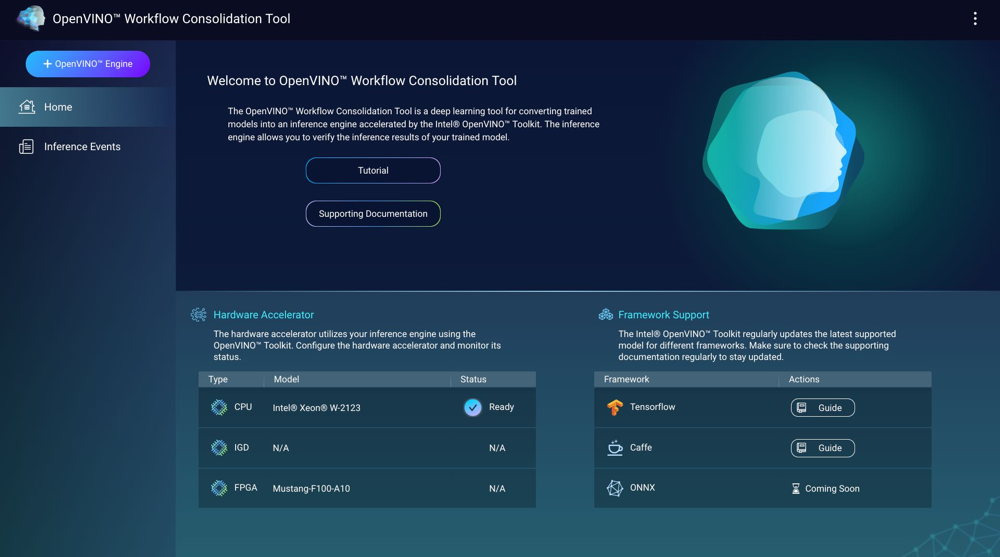

Accélérateurs matériels

Vous pouvez installer les accélérateurs matériels installés dans votre NAS afin d’améliorer les performances de vos moteurs d’inférence.

Les accélérateurs matériels installés dans le NAS sont affichés à l’écran Home.

Les accélérateurs matériels avec le statut Prêt peuvent être utilisés lors de la création de moteurs d’inférence.

Si le statut affiché est Paramètres, allez dans afin de configurer l’accélérateur matériel.

-

Pour utiliser les cartes de réseau de portes programmables (FPGA) sur un NAS QNAP, vous devez désactiver le passthrough des machines virtuelles (VM).

-

Chaque ressource FPGA peut créer un moteur d’inférence.

- Chaque ressource de processeur de réalité virtuelle (VPU) peut créer un moteur d’inférence.

Créer des moteurs d’inférence

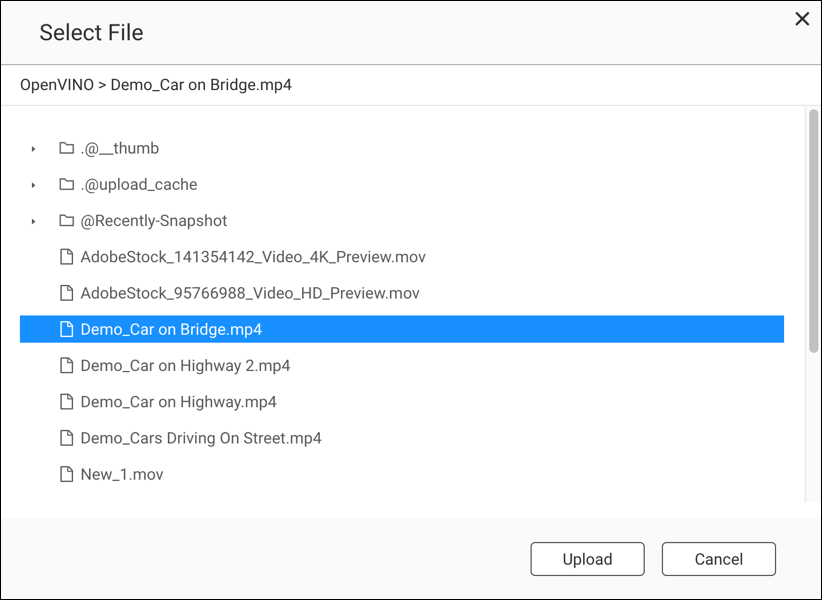

Utilisez l’OWCT pour créer des moteurs d’inférence et pour configurer les paramètres d’inférence.

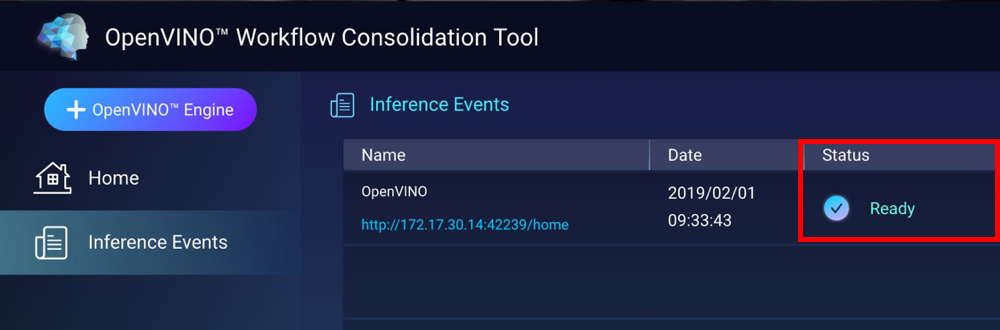

L’OWCT crée le moteur d’inférence et l’affiche à l’écran des Événements d’inférence.

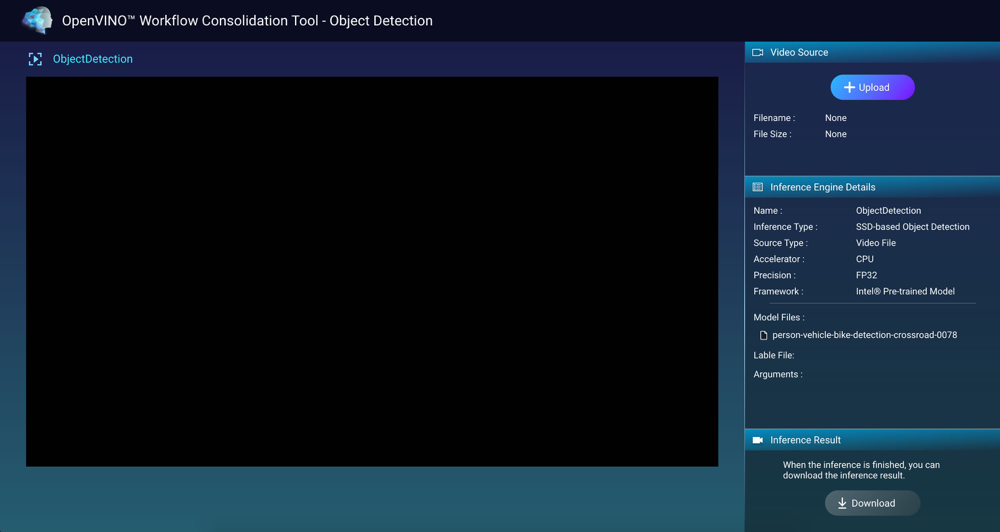

Utiliser la vision par ordinateur avec les moteurs d’inférence

Gérer les moteurs d’inférence

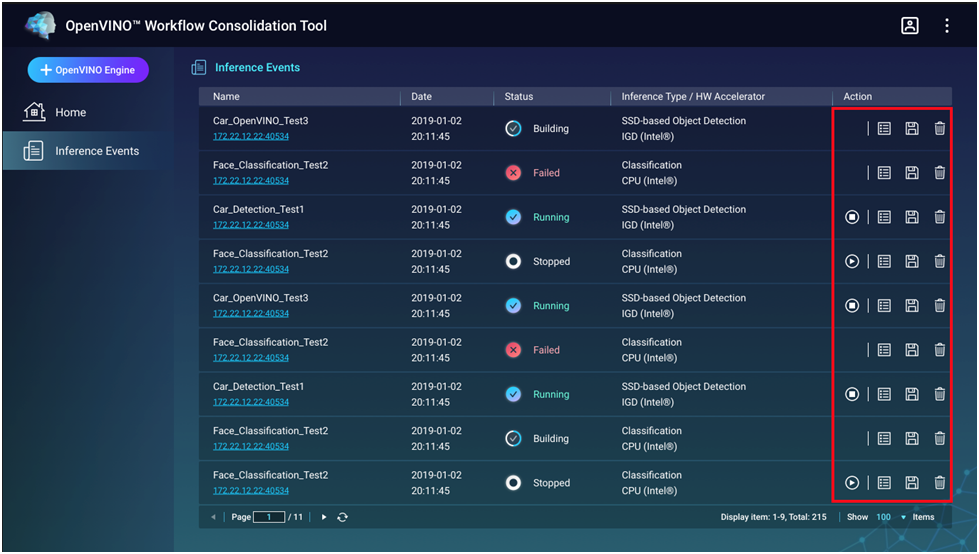

Vous pouvez afficher et gérer les moteurs d’inférence à l’écran Événements d’inférence.

|

Bouton |

Description |

|---|---|

|

|

Démarre le processus d’inférence. |

|

|

Arrête le processus d’inférence. |

|

|

Affiche les détails et le statut des journaux du moteur d’inférence. |

|

|

Enregistre le moteur d’inférence en tant que fichier de Représentation intermédiaire (IR) pour des applications avancées. |

|

|

Supprime le moteur d'inférence. |