Tutorial per lo Strumento di consolidamento del flusso di lavoro OpenVINO™

Informazioni su

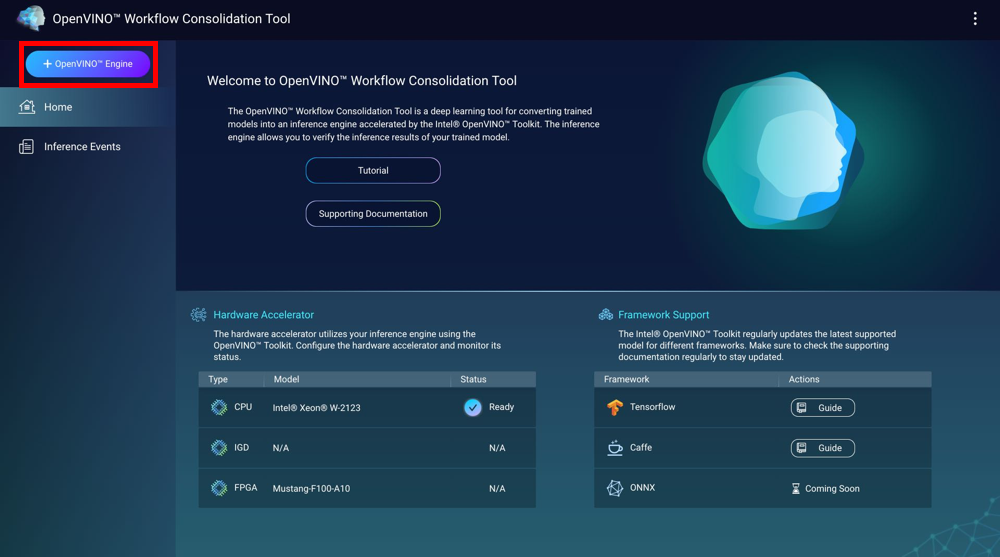

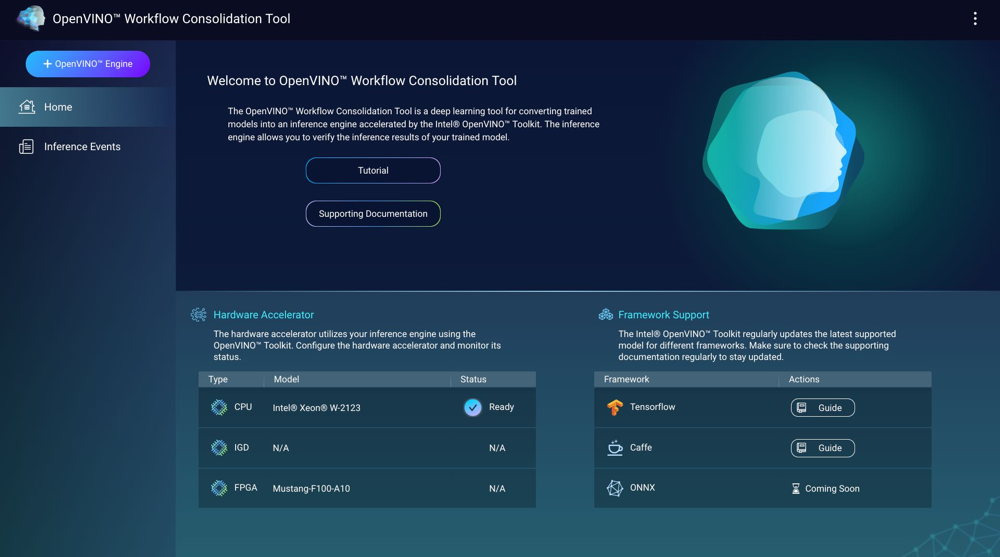

Lo Strumento consolidamento del flusso di lavoro OpenVINO™ è uno strumento di apprendimento profondo per la conversione di modelli formati in motori di inferenza accelerati dal kit di strumenti Intel® Distribution of OpenVINO™ Toolkit. I motori di inferenza consentono di verificare i risultati dell’inferenza dei modelli formati.

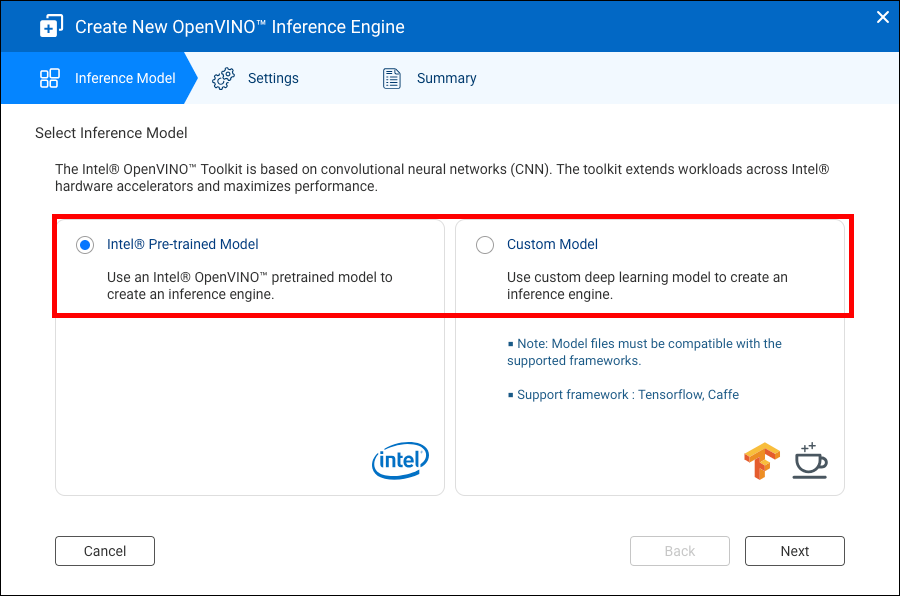

Il kit di strumenti Intel® Distribution of OpenVINO™ si basa sulle reti neurali convoluzionali (CNN). Il kit di strumenti estende i flussi di lavoro sugli acceleratori hardware Intel® e massimizza le prestazioni.

Per utilizzare OWCT è necessario installare Container Station.

- Compatibilità

- Acceleratori hardware

- Creazione di motori di inferenza

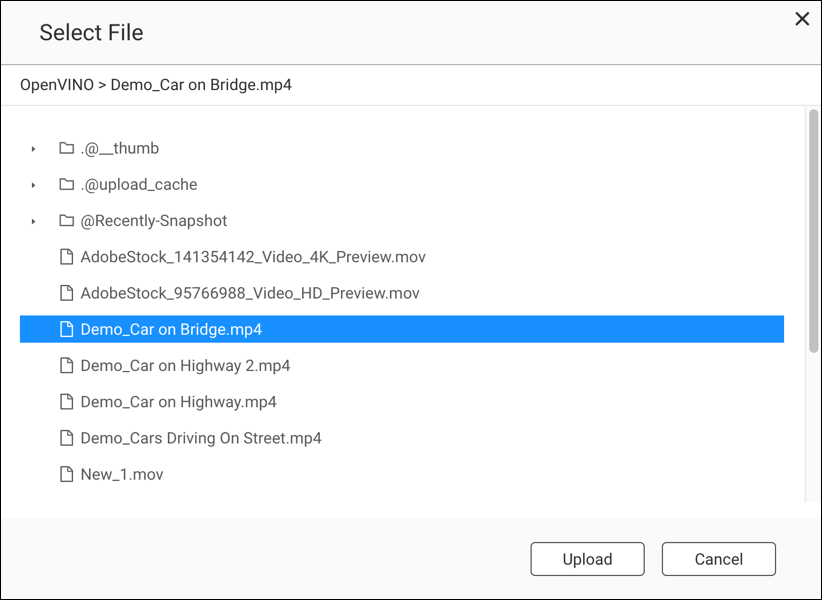

- Uso della visione computer con i motori di inferenza

- Gestione dei motori di inferenza

Compatibilità

|

Piattaforma |

Supporto |

|---|---|

|

Modelli NAS |

Nota:

solo i modelli di NAS basati su Intel supportano lo Strumento di consolidamento del flusso di lavoro OpenVINO™. |

|

OS |

QTS 4.4 |

|

Versione kit di strumenti Intel® Distribution of OpenVINO™ |

2018R5 Per i dettagli andare su https://software.intel.com/en-us/articles/OpenVINO-RelNotes. |

Acceleratori hardware

È possibile usare gli acceleratori hardware installati nel NAS per migliorare le prestazioni dei motori di inferenza.

Gli acceleratori hardware installati nel NAS sono visualizzati nella schermata Home.

Acceleratori hardware con stato Pronto possono essere usati durante la creazione di motori di inferenza.

Se lo stato visualizzato è Impostazioni, andare su per configurare l'acceleratore hardware.

-

Per usare le schede FPGA (field-programmable gate array) su un QNAP NAS, è necessario disabilitare il passthough della macchina virtuale (VM).

-

Ciascuna risorsa FPGA può creare un motore di inferenza.

- Ciascuna risorsa unità di elaborazione della visione (VPU) può creare un motore di inferenza.

Creazione di motori di inferenza

Usare OWCT per creare i motori di inferenza e configurare i parametri di inferenza.

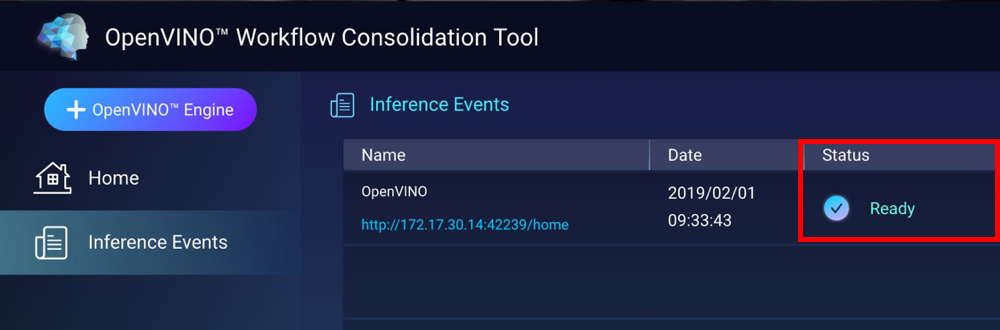

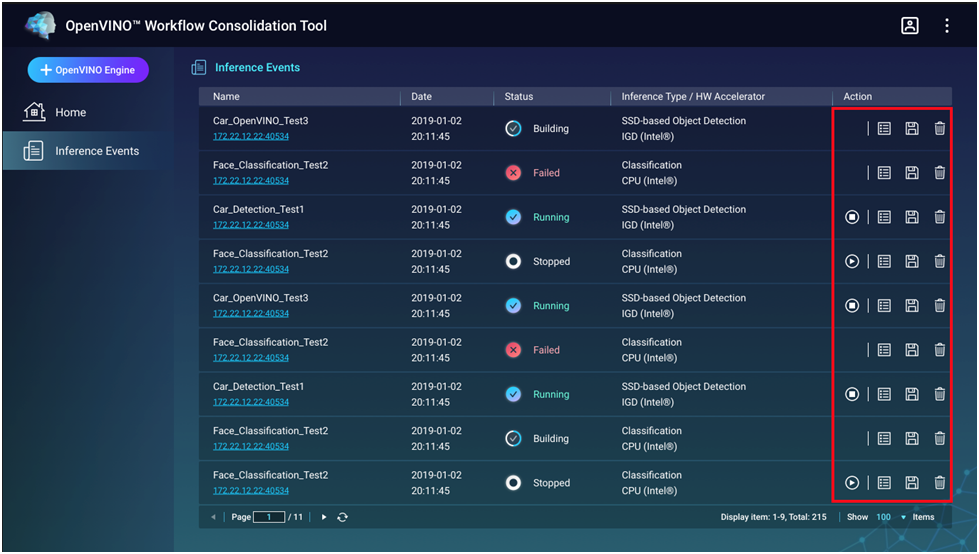

OWCT crea il motore di inferenza e lo visualizza nella schermata Eventi inferenza.

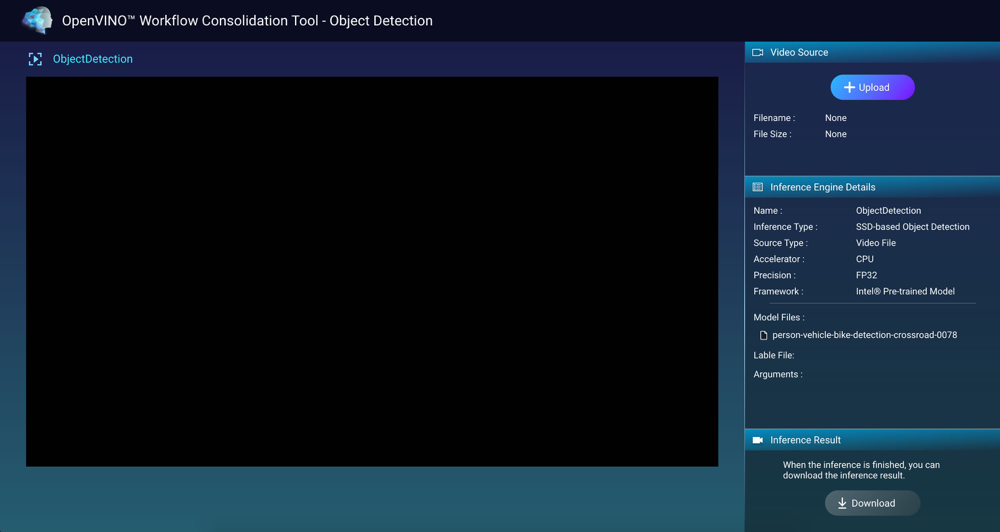

Uso della visione computer con i motori di inferenza

Gestione dei motori di inferenza

È possibile visualizzare e gestire i motori di inferenza nella schermata Eventi inferenza.

|

Pulsante |

Descrizione |

|---|---|

|

|

Avvia il processo di inferenza. |

|

|

Arresta il processo di inferenza. |

|

|

Visualizza i dettagli e lo stato del log del motore di inferenza. |

|

|

Salvare il motore di inferenza come file IR (Rappresentazione intermedia) per le applicazioni avanzate. |

|

|

Elimina il motore di inferenza. |