Självstudier till OpenVINO™ Workflow Consolidation Tool

Om

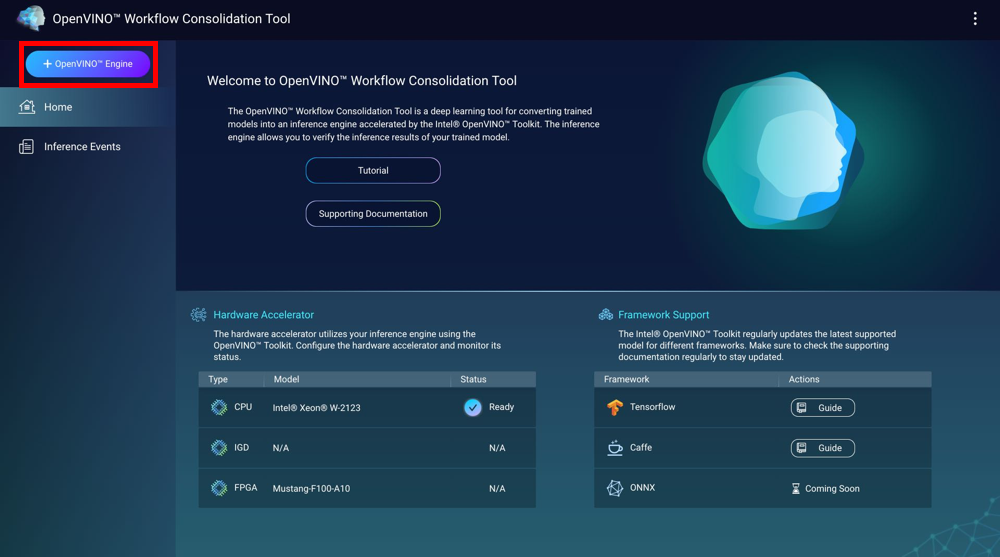

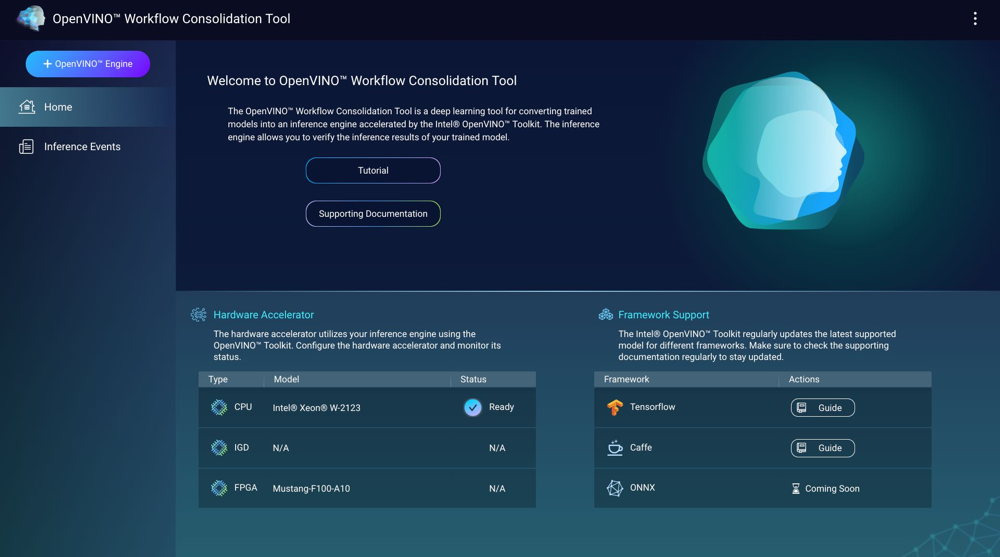

OpenVINO™ Workflow Consolidation Tool (OWCT) är ett djupinlärningspaket för konvertera inlärda modeller till inferensmotorer accelererade av Intel Distribution of OpenVINO™ Toolkit. Inferensmotorer gör det möjligt att verifiera inlärda modellers inferensresultat.

Intel Distribution of OpenVINO™ Toolkit grundas på CNN (Convolutional Neural Networks). Verktyget utökar arbetsbelastningar på Intel maskinvaruacceleratorer för att maximera prestanda.

Du måste installera Container Station för att använda OWCT.

- Kompatibilitet

- Maskinvaruacceleratorer

- Skapa inferensmotorer

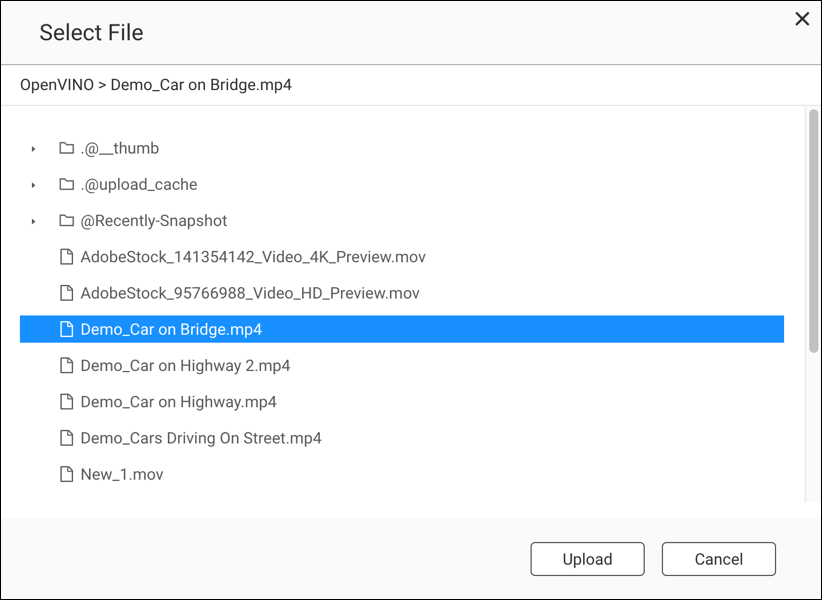

- Använda datorseende med inferensmotorer

- Hantera inferensmotorer

Kompatibilitet

|

Plattform |

Stöds |

|---|---|

|

NAS-modeller |

Obs!

Endast Intel-baserade NAS-modeller stöder OpenVINO™ Workflow Consolidation Tool. |

|

Operativsystem |

QTS 4.4 |

|

Intel Distribution of OpenVINO™ Toolkit-version |

2018R5 Mer information finns på https://software.intel.com/en-us/articles/OpenVINO-RelNotes. |

Maskinvaruacceleratorer

Det går att använda maskinvaruacceleratorer installerade på NAS-enheten för att förbättra inferensmotorernas prestanda.

Maskinvaruacceleratorer installerade på NAS-enheten visas på startsidan.

Maskinvaruacceleratorer med status Klar går att använda till att skapa inferensmotorer.

Om visad status är Inställningar, öppna för att konfigurera maskinvaruacceleratorn.

-

För att använda FPGA-kort (Field-Programmable Gate Array) på en QNAP NAS måste du inaktivera genomströmning för virtuell dator (VM).

-

Varje FPGA-resurs kan skapa en inferensmotor.

- Varje VPU-resurs (Vision Processing Unit) kan skapa en inferensmotor.

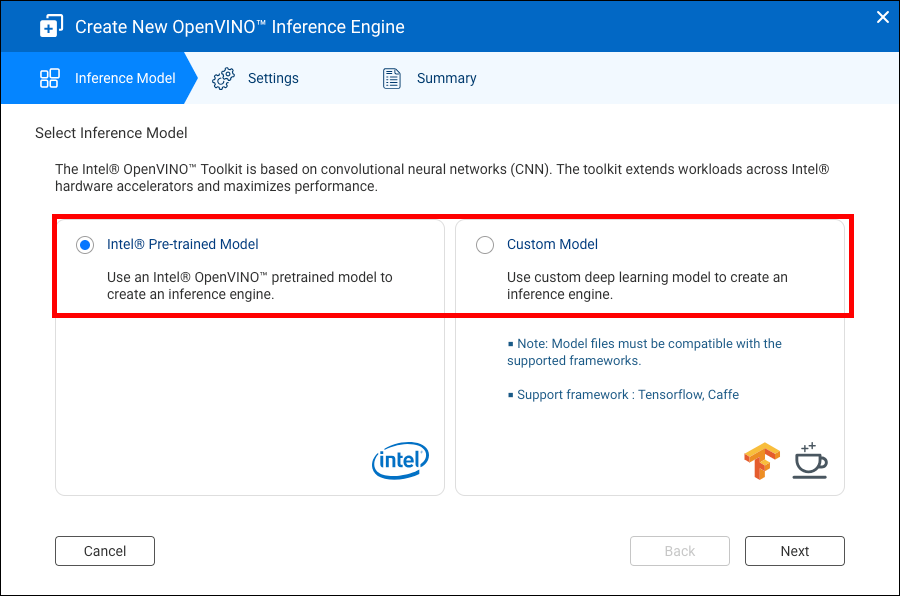

Skapa inferensmotorer

Använd OWCT till att skapa inferensmotorer och konfigurera inferensparametrar.

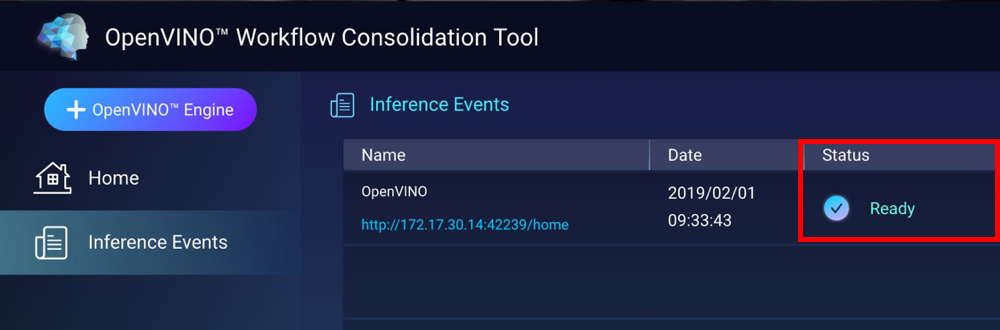

OWCT skapar en inferensmotor och visar den på skärmen Inferenshändelser.

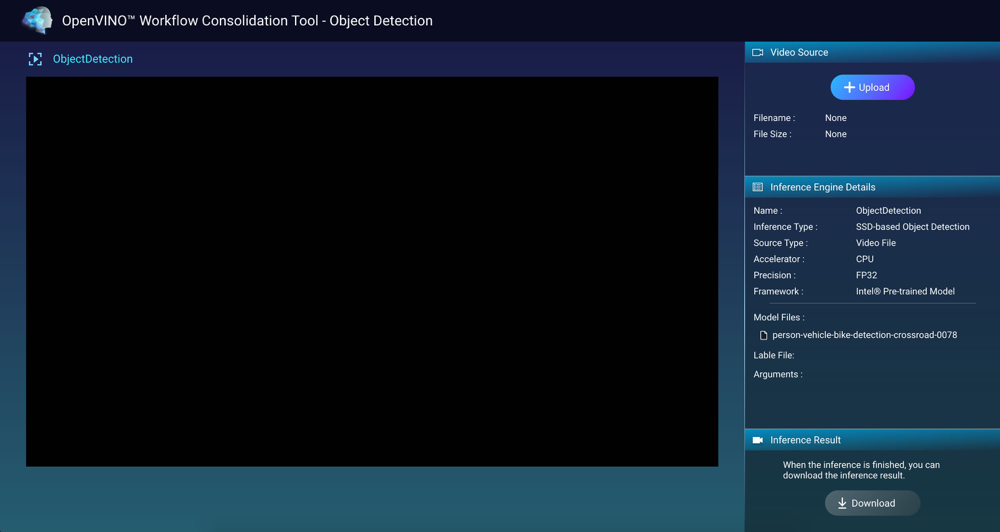

Använda datorseende med inferensmotorer

Hantera inferensmotorer

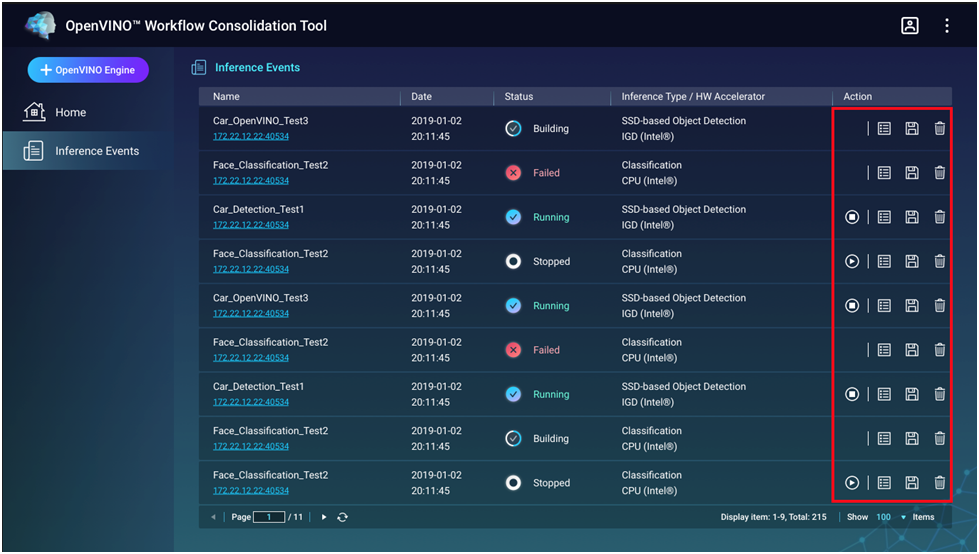

Det går att visa och hantera inferensmotorer på skärmen Inferenshändelser.

|

Knapp |

Beskrivning |

|---|---|

|

|

Startar inferensprocessen. |

|

|

Stoppar inferensprocessen. |

|

|

Visar information och inferensmotorns loggstatus. |

|

|

Spara inferensmotorn som en IR-fil (Intermediate Representation) för avancerade tillämpningar. |

|

|

Tar bort inferensmotorn. |