Samouczek do narzędzia OpenVINO™ Workflow Consolidation Tool

Informacje

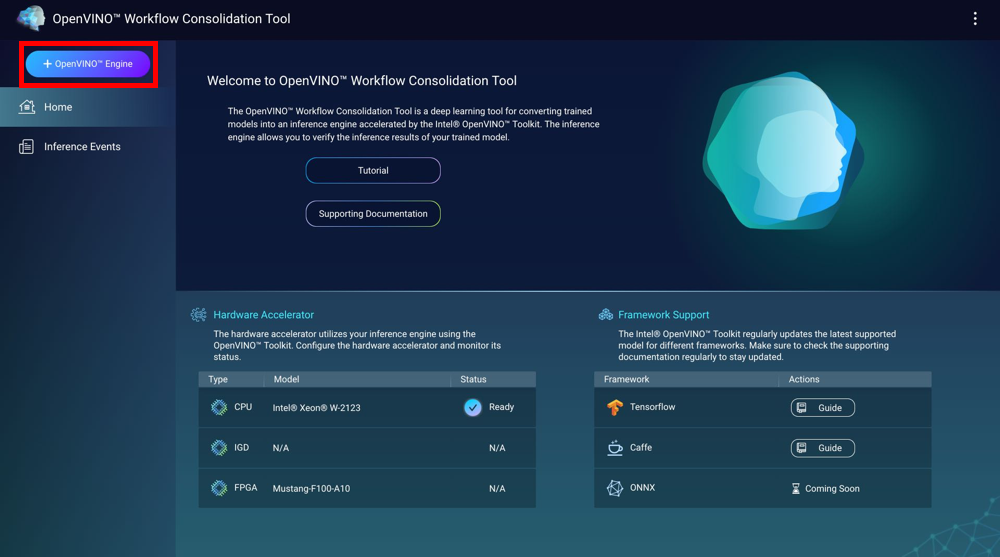

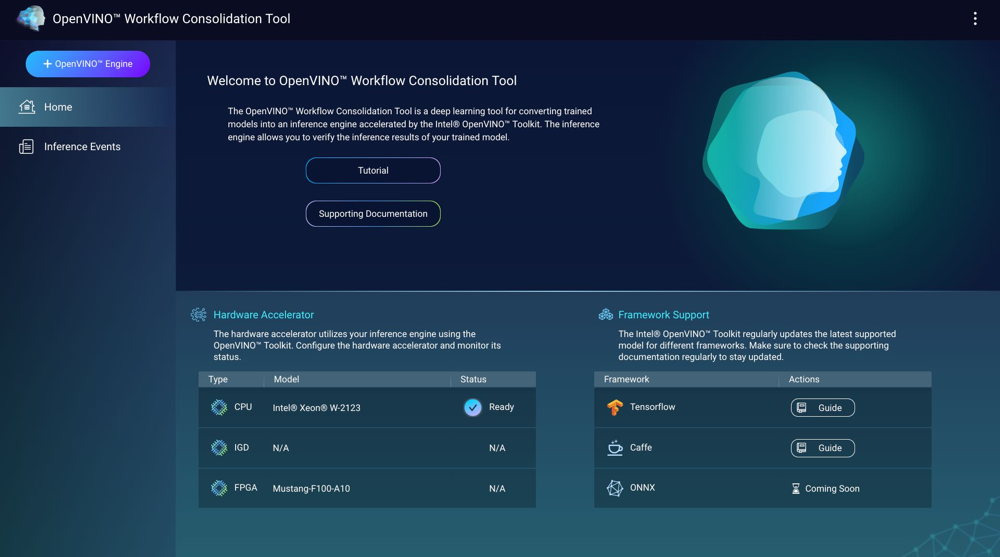

Narzędzie OpenVINO™ Workflow Consolidation Tool (OWCT) to narzędzie głębokiego uczenia do konwersji modeli szkoleniowych w silniki inferencji z przyspieszeniem przy użyciu zestawu narzędzi Intel® Distribution of OpenVINO™. Silniki inferencji pozwalają na weryfikację wyników inferencji modeli szkoleniowych.

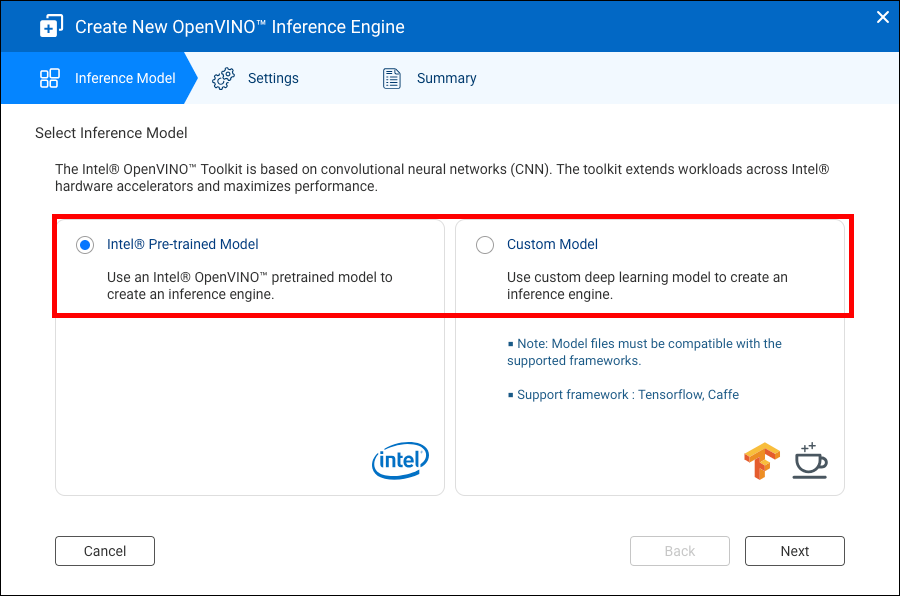

Zestaw narzędzi Intel® Distribution of OpenVINO™ jest oparty na sieciach CNN (ang. convolutional neural networks). Zestaw narzędzi umożliwia dystrybucję obciążenia pracą na akceleratory osprzętu Intel®, zwiększając maksymalnie wydajność.

Aby korzystać z OWCT, konieczne jest zainstalowanie aplikacji Container Station.

- Kompatybilność

- Akceleratory sprzętowe

- Tworzenie silników inferencji

- Korzystanie z wizji komputerowej przy użyciu silników inferencji

- Zarządzanie silnikami inferencji

Kompatybilność

|

Platforma |

Pomoc techniczna |

|---|---|

|

Modele serwera NAS |

Uwaga:

Tylko modele NAS oparte na Intel obsługują narzędzie OpenVINO™ Workflow Consolidation Tool. |

|

System operacyjny |

QTS 4.4 |

|

Zestaw narzędzi Intel® Distribution of OpenVINO™ |

2018R5 Szczegółowe informacje można znaleźć na stronie https://software.intel.com/en-us/articles/OpenVINO-RelNotes. |

Akceleratory sprzętowe

Można użyć akceleratorów sprzętowych zainstalowanych na posiadanym serwerze NAS, w celu zwiększenia wydajności posiadanych silników inferencji.

Akceleratory sprzętowe zainstalowane na serwerze NAS są wyświetlane na ekranie głównym.

Akceleratory sprzętowe ze stanemGotoweMożna używać podczas tworzenia silników inferencji.

Jeśli wyświetlany stan to Ustawienia, przejdź do obszaru , aby skonfigurować akcelerator sprzętowy.

-

Aby korzystać z kart FPGA (ang. field-programmable gate array) na serwerze QNAP NAS, należy wyłączyć funkcję Passthrough wirtualnej maszyny (VM).

-

Każdy zasób FPGA może utworzyć jeden silnik inferencji.

- Każdy zasób VPU (ang. vision processing unit) może utworzyć jeden silnik inferencji.

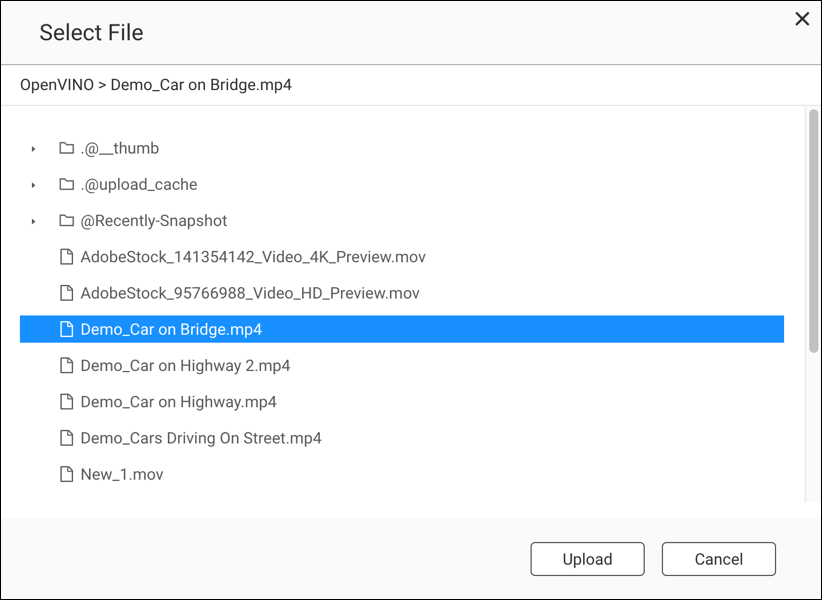

Tworzenie silników inferencji

Przy użyciu OWCT można tworzyć silniki inferencji oraz konfigurować parametry inferencji.

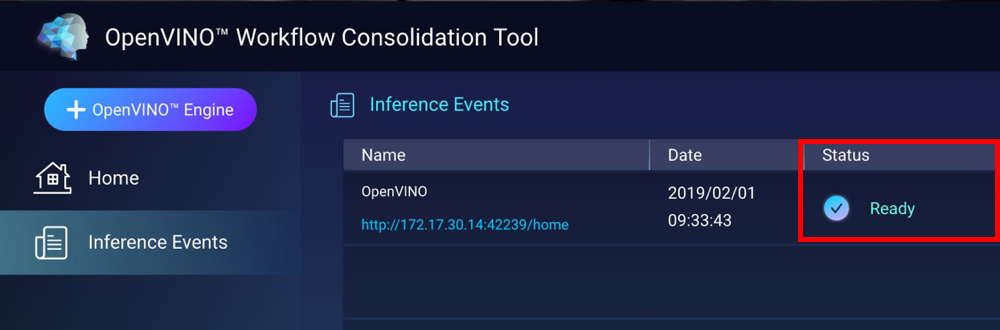

OWCT tworzy silnik inferencji i wyświetla go na ekranie Zdarzenia inferencji.

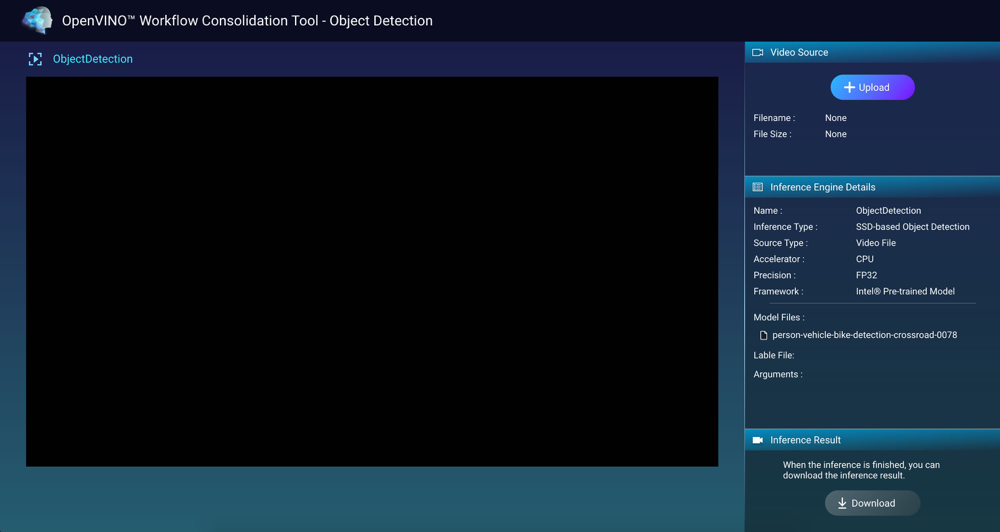

Korzystanie z wizji komputerowej przy użyciu silników inferencji

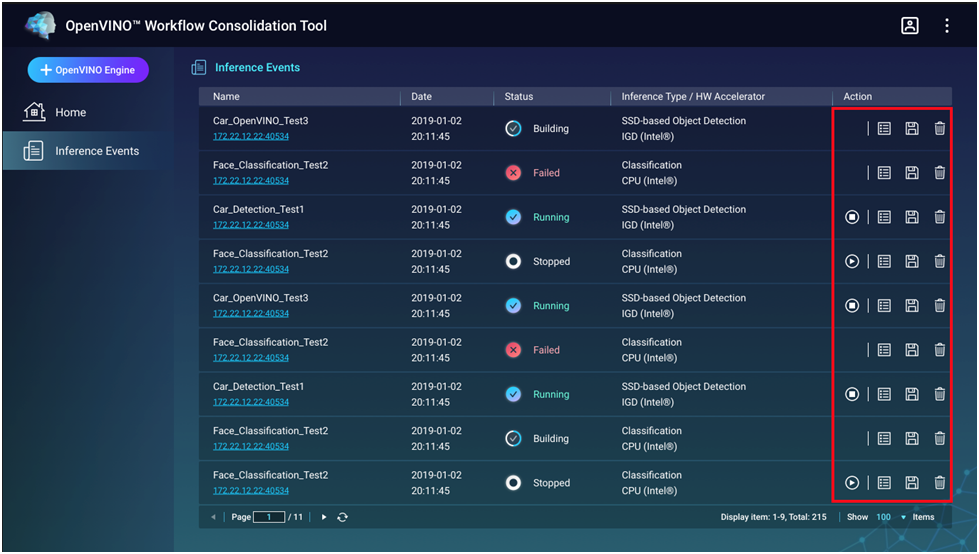

Zarządzanie silnikami inferencji

Możesz wyświetlić i zarządzać silnikami inferencji na ekranie Zdarzenia inferencji.

|

Przycisk |

Opis |

|---|---|

|

|

Uruchamia proces inferencji. |

|

|

Zatrzymuje proces inferencji. |

|

|

Wyświetla szczegółowe informacje i stan logowania silnika inferencji. |

|

|

Zapisz silnik inferencji jako plik Intermediate Representation (IR) do zaawansowanych zastosowań. |

|

|

Usuwa silnik inferencji. |