Tutorial da Ferramenta de Consolidação de Fluxo de Trabalho do OpenVINO™

Sobre

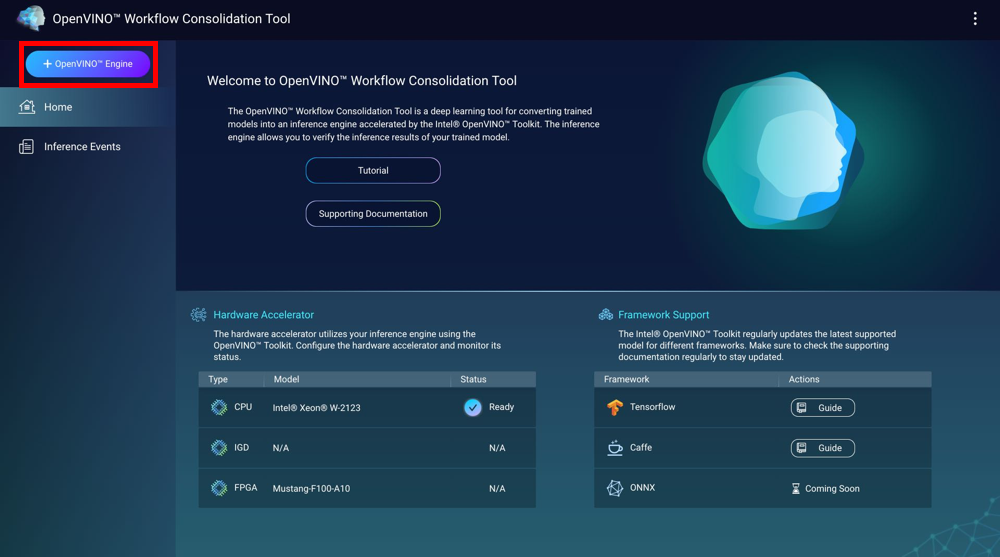

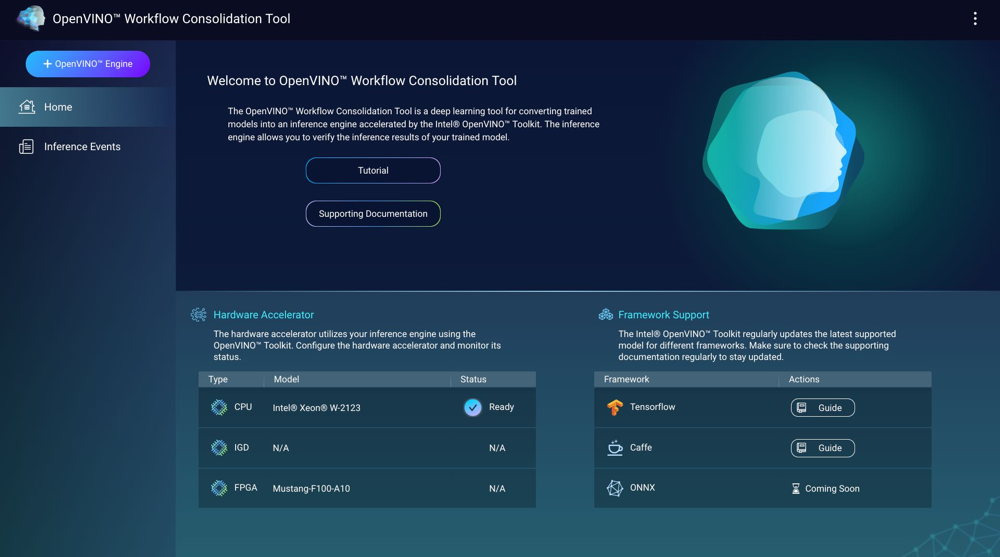

A Ferramenta de Consolidação de Fluxo de Trabalho do OpenVINO™ (OWCT) é uma ferramenta de aprendizagem profunda para converter modelos treinados em mecanismos de inferência acelerados pela Distribuição da Intel® do Kit de Ferramentas OpenVINO™. Os mecanismos de inferência permitem verificar os resultados de inferência de modelos treinados.

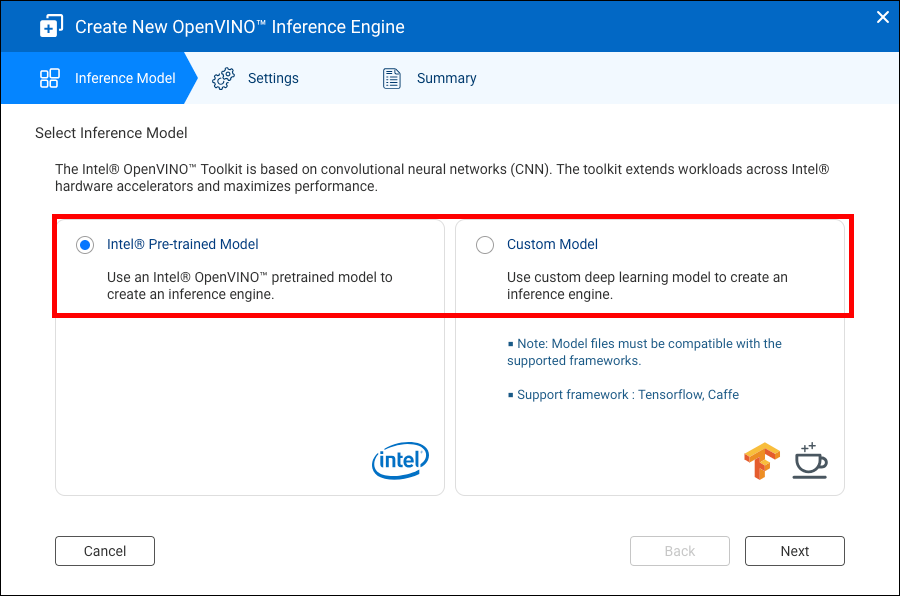

A Distribuição da Intel® do Kit de Ferramentas OpenVINO ™ baseia-se em redes neurais convolucionais (CNN). O kit de ferramentas amplia as cargas de trabalho entre aceleradores de hardware da Intel® para maximizar o desempenho.

O Container Station deve estar instalado para que seja possível usar o OWCT.

- Compatibilidade

- Aceleradores de hardware

- Criar mecanismos de inferência

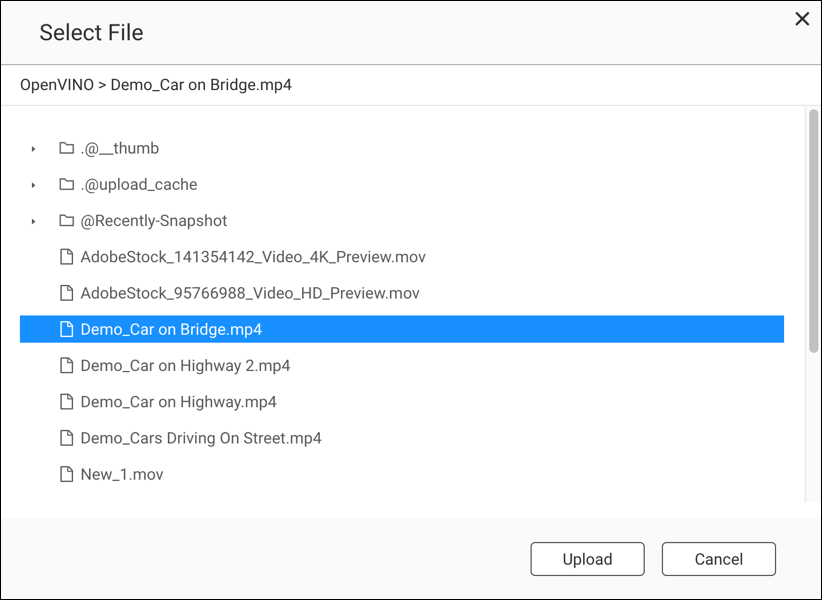

- Usar a visão computacional com mecanismos de inferência

- Gerenciar mecanismos de inferência

Compatibilidade

|

Plataforma |

Suporte |

|---|---|

|

Modelos NAS |

Nota:

Somente os modelos de NAS com processadores Intel são compatíveis com a Ferramenta de Consolidação de Fluxo de Trabalho do OpenVINO™. |

|

OS |

QTS 4.4 |

|

Versão da Distribuição da Intel® do Kit de Ferramentas OpenVINO™ |

2018R5 Para obter detalhes, acesse https://software.intel.com/en-us/articles/OpenVINO-RelNotes. |

Aceleradores de hardware

Você pode usar os aceleradores de hardware instalados em seu NAS para melhorar o desempenho de seus mecanismos de inferência.

Os aceleradores de hardware instalados no NAS são exibidos na Tela Inicial.

Aceleradores de hardware com o status Pronto podem ser usados na criação de mecanismos de inferência.

Se o status exibido for Configurações, vá para para configurar o acelerador de hardware.

-

Para usar placas FPGA (matriz de portas programáveis de campo) em um QNAP NAS, a passagem de máquina virtual (VM) deve ser desativada.

-

Cada recurso FPGA pode criar um mecanismo de inferência.

- Cada recurso de unidade de processamento de visão (VPU) pode criar um mecanismo de inferência.

Criar mecanismos de inferência

Use o OWCT para criar mecanismos de inferência e configurar parâmetros de inferência.

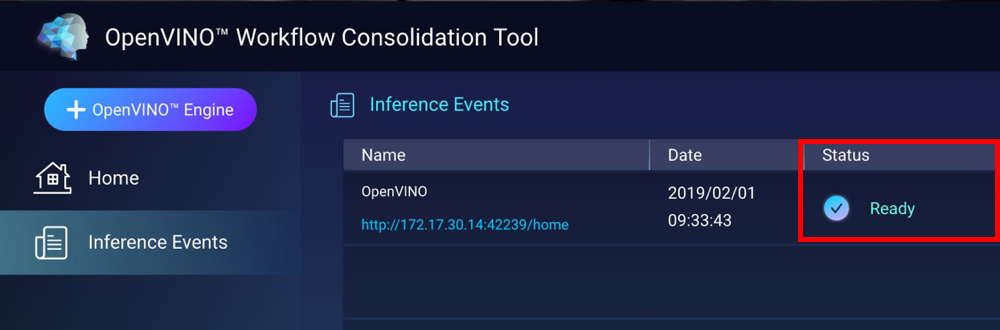

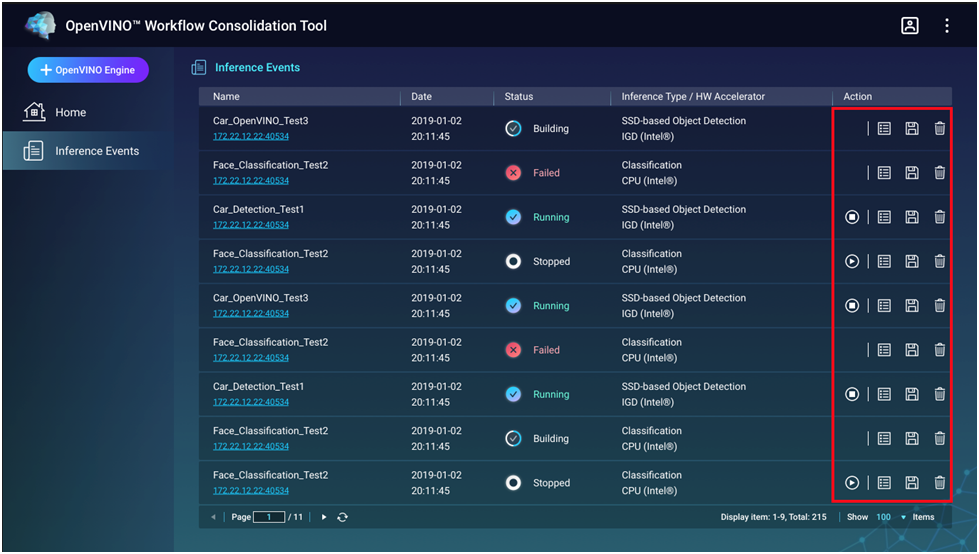

O OWCT criará e exibirá o mecanismo de inferência na tela Eventos de inferência.

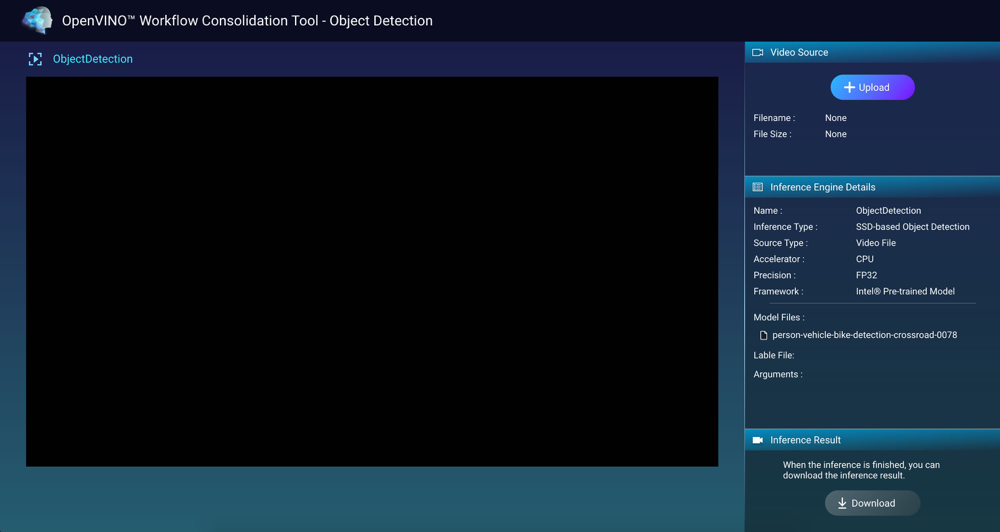

Usar a visão computacional com mecanismos de inferência

Gerenciar mecanismos de inferência

Você pode visualizar e gerenciar mecanismos de inferência na tela Eventos de inferência.

|

Botão |

Descrição |

|---|---|

|

|

Inicia o processo de inferência. |

|

|

Interrompe o processo de inferência. |

|

|

Exibe detalhes e o status de registro do mecanismo de inferência. |

|

|

Salva o mecanismo de inferência como um arquivo IR (representação imediataa) para aplicações avançadas. |

|

|

Exclui o mecanismo de inferência. |