OpenVINO™ Workflow Consolidation Tool 튜토리얼

정보

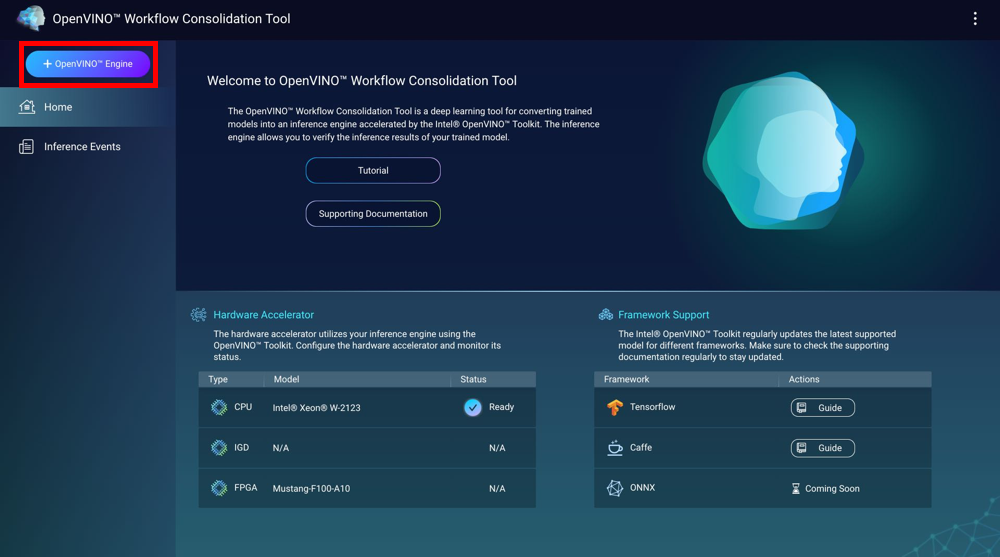

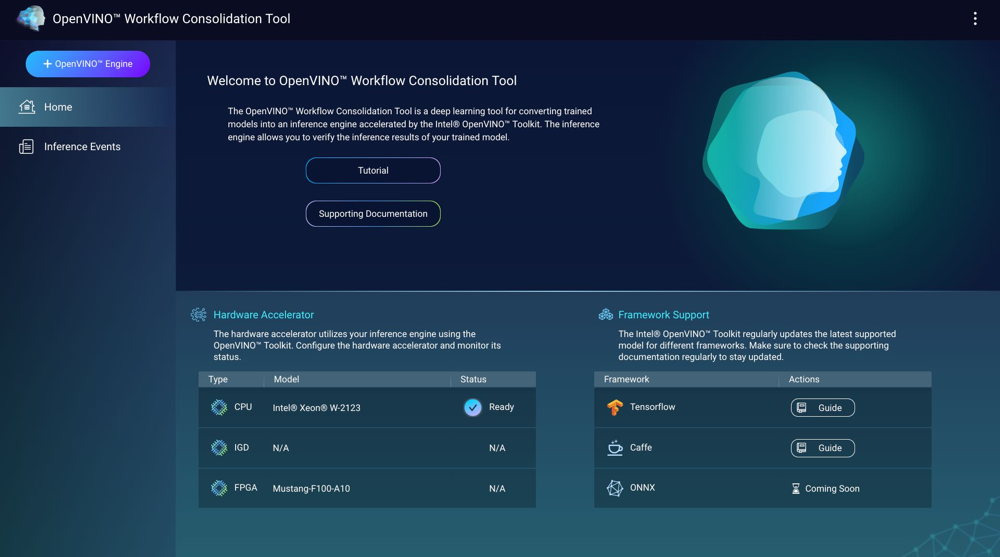

OpenVINO™ Workflow Consolidation Tool (OWCT)은 훈련된 모델을 Intel® Distribution of OpenVINO™ 툴킷에 의해 가속화된 추론 엔진으로 변환하기 위한 딥 러닝 도구입니다. 추론 엔진을 사용하면 훈련된 모델의 추론 결과를 검증할 수 있습니다.

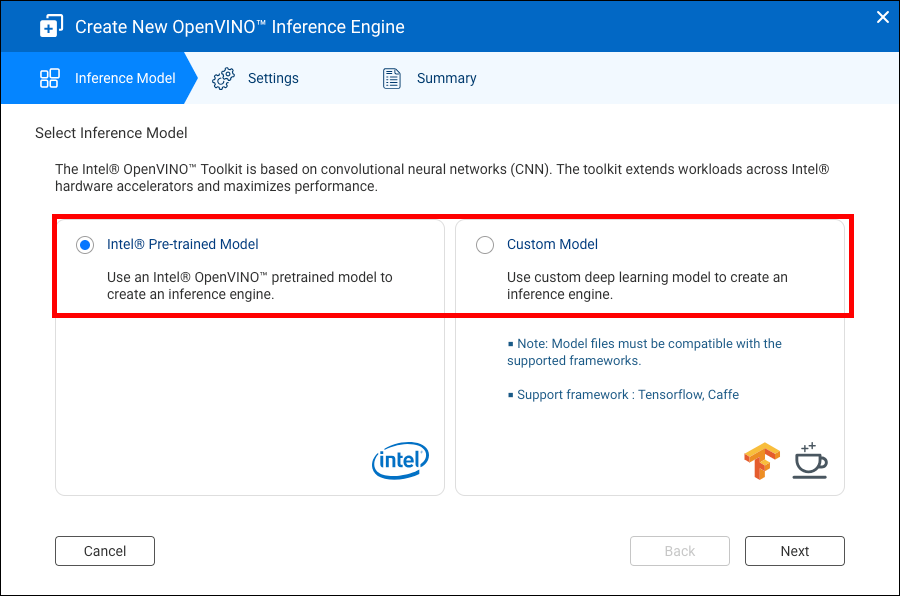

Intel® Distribution of OpenVINO™ 툴킷은 콘볼류션 신경망(CNN)을 기반으로 합니다. 툴킷은 워크로드를 Intel® 하드웨어 가속기 전체로 확장하여 성능을 극대화합니다.

OWCT를 사용하려면 Container Station이 설치되어 있어야 합니다.

호환성

|

플랫폼 |

지원 |

|---|---|

|

NAS 모델 |

참고:

Intel 기반 NAS 모델에서만 OpenVINO™ Workflow Consolidation Tool을 지원합니다. |

|

OS |

QTS 4.4 |

|

Intel® Distribution of OpenVINO™ 툴킷 버전 |

2018R5 자세한 내용을 보려면 https://software.intel.com/en-us/articles/OpenVINO-RelNotes로 이동하십시오. |

하드웨어 가속기

NAS에 설치된 하드웨어 가속기를 사용하여 추론 엔진의 성능을 높일 수 있습니다.

NAS에 설치된 하드웨어 가속기는 홈 화면에 표시됩니다.

상태가확인합니다인 하드웨어 가속기를 추론 엔진을 생성할 때 사용할 수 있습니다.

표시된 상태가설정인 경우,로 이동하여 하드웨어 가속기를 설정합니다.

-

QNAP NAS에서 필드-프로그램 가능 게이트 어레이(FPGA) 카드를 사용하려면, 가상 머신(VM) 패스스루를 비활성화해야 합니다.

-

각 FPGA 리소스는 한 개의 추론 엔진을 생성할 수 있습니다.

- 각 비전 프로세싱 장치(VPU) 리소스는 한 개의 추론 엔진을 생성할 수 있습니다.

추론 엔진 생성

OWCT를 사용하여 추론 엔진을 생성하고 추론 매개변수를 구성합니다.

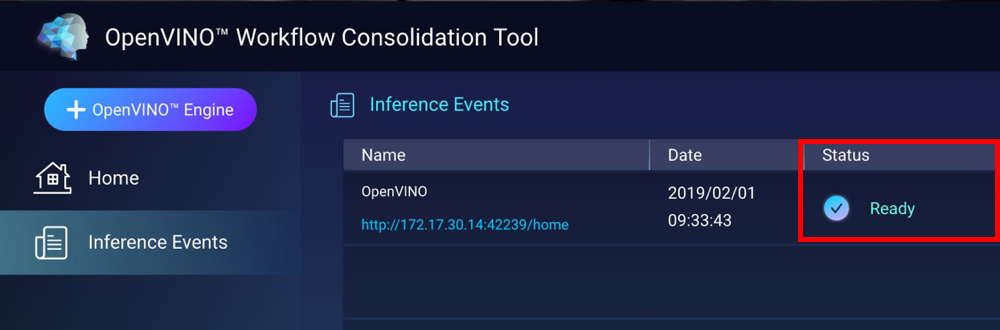

OWCT가 추론 엔진을 생성하고 추론 이벤트 화면에 표시합니다.

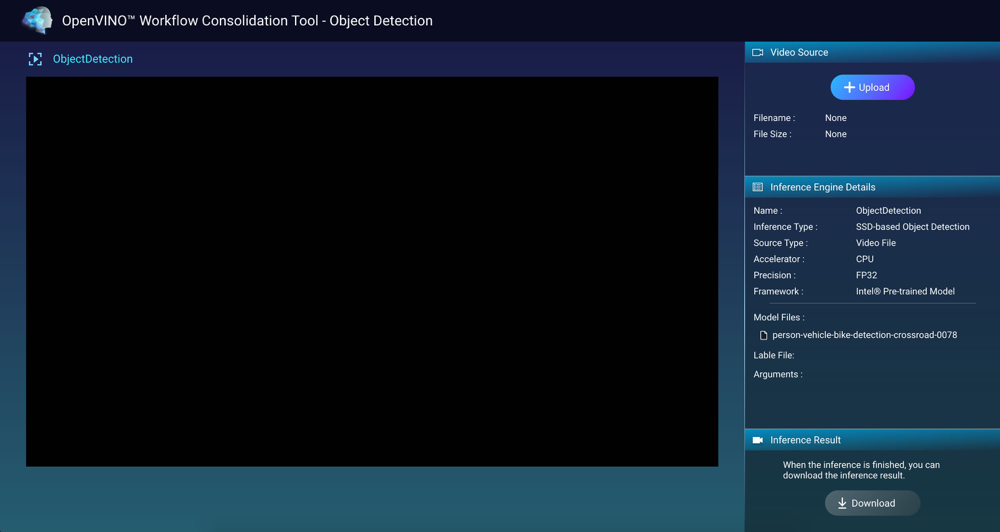

추론 엔진이 있는 컴퓨터 비전 사용

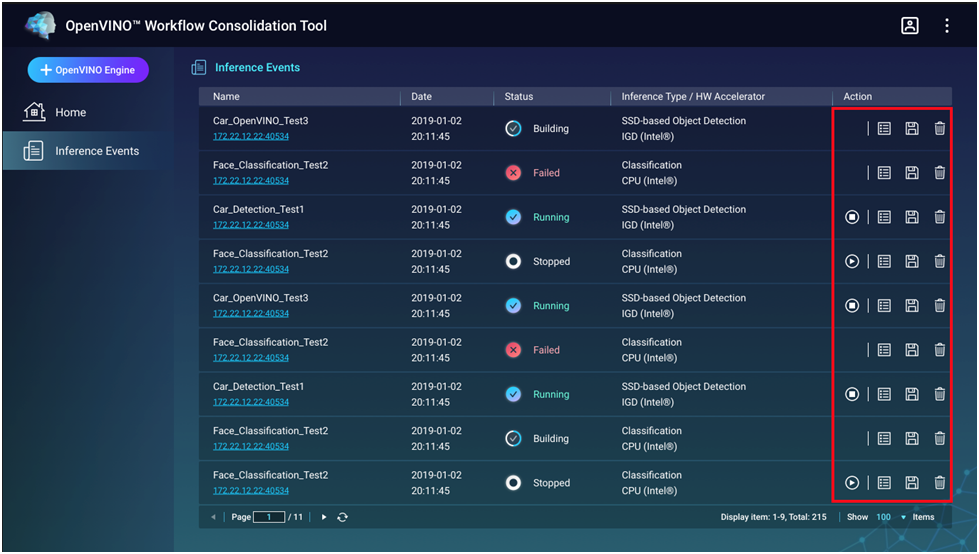

추론 엔진 관리

추론 이벤트 화면에서 추론 엔진을 보고 관리할 수 있습니다.

|

버튼 |

설명 |

|---|---|

|

|

추론 프로세스를 시작합니다. |

|

|

추론 프로세스를 중지합니다. |

|

|

추론 엔진의 상세 정보와 로그 상태를 표시합니다. |

|

|

고급 애플리케이션을 위해 추론 엔진을 IR(Intermediate Representation) 파일로 저장합니다. |

|

|

추론 엔진을 삭제합니다. |