OpenVINO™ワークフロー統合ツールチュートリアル

情報

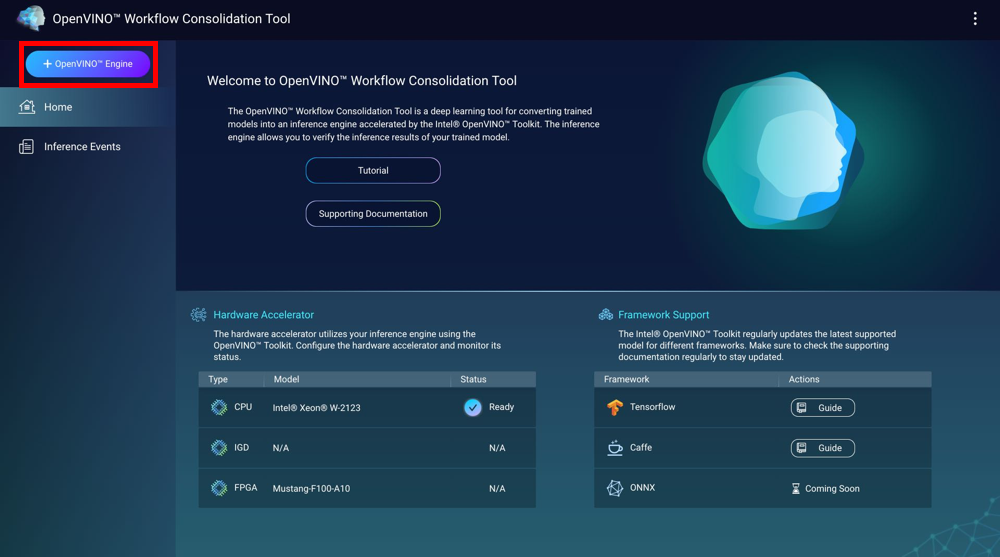

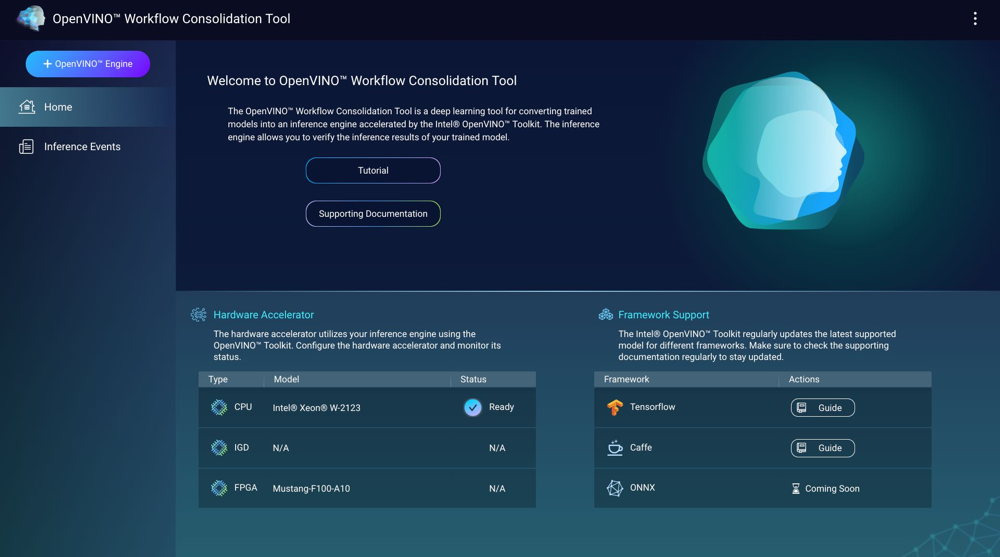

OpenVINO™ワークフロー統合ツール(OWCT)は、Intel® Distribution of OpenVINO™ツールキットで加速した推論エンジンに、訓練を施したモデルを変換するためのディープラーニングツールです。推論エンジンでは、トレーニングを施したモデルの推論結果を検証することができます。

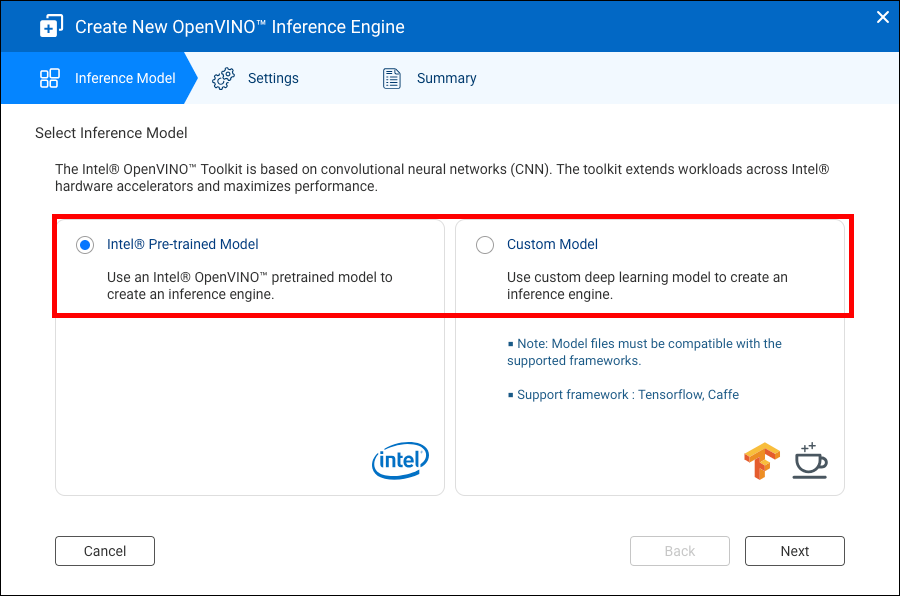

Intel® Distribution of OpenVINO™ツールキットは、畳み込みニューラルネットワーク(CNN)に基づいています。このツールキットは、Intel®ハードウェアアクセラレーターを拡張し、パフォーマンスを最大化します。

OWCTを使用するには、Container Stationをイントールする必要があります。

互換性

|

プラットフォーム |

サポート |

|---|---|

|

NAS モデル |

注意:

IntelベースのNASモデルのみがOpenVINO™ワークフロー統合ツールに対応しています。 |

|

OS |

QTS 4.4 |

|

Intel® Distribution of OpenVINO™ツールキットバージョン |

2018R5 詳細については、https://software.intel.com/en-us/articles/OpenVINO-RelNotesにアクセスしてください。 |

ハードウェアアクセラレーション

NASにインストールされているハードウェアアクセラレーターを使用することで、推論エンジンのパフォーマンスを向上することができます。

NASにインストールされているハードウェアアクセラレーターは、ホーム画面に表示されます。

ステータスが「準備完了」のハードウェアアクセラレーターはインターフェイスエンジンの作成時に使用できます。

表示されているステータスが「設定」の場合は に移動してハードウェアアクセラレーターのセットアップを行います。

-

フィールドプログラマブルゲートアレイ(FPGA)カードをQNAP NAS上で使用するには、仮想マシン(VM)パススルーを無効にする必要があります。

-

各FPGAリソースは、1つの推論エンジンを作成できます。

- 各ビジョンプロセッシングユニット(VPU)リソースは、1つの推論エンジンを作成できます。

推論エンジンの作成

OWCTを使用して、推論エンジンを作成し、推論パラメーターを設定します。

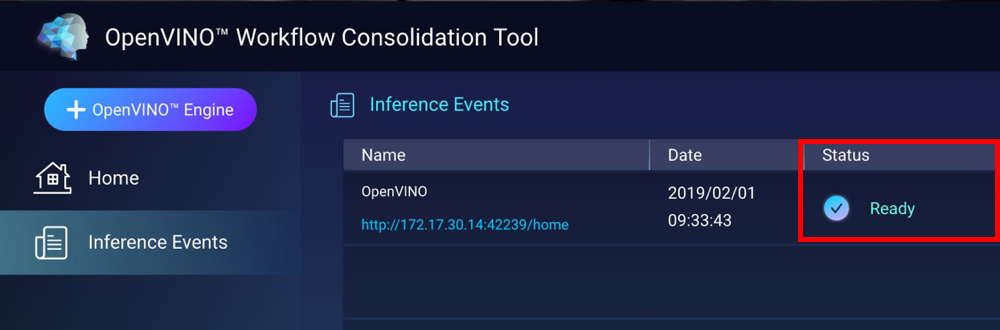

OWCTは推論エンジンを作成し、推論イベントに表示します。

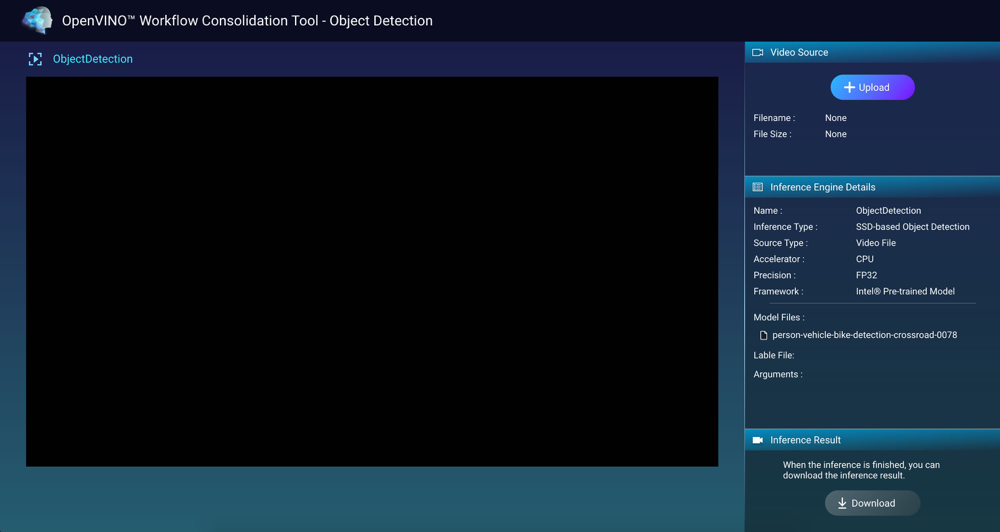

推論エンジンとコンピュータービジョンの使用

推論エンジンの管理

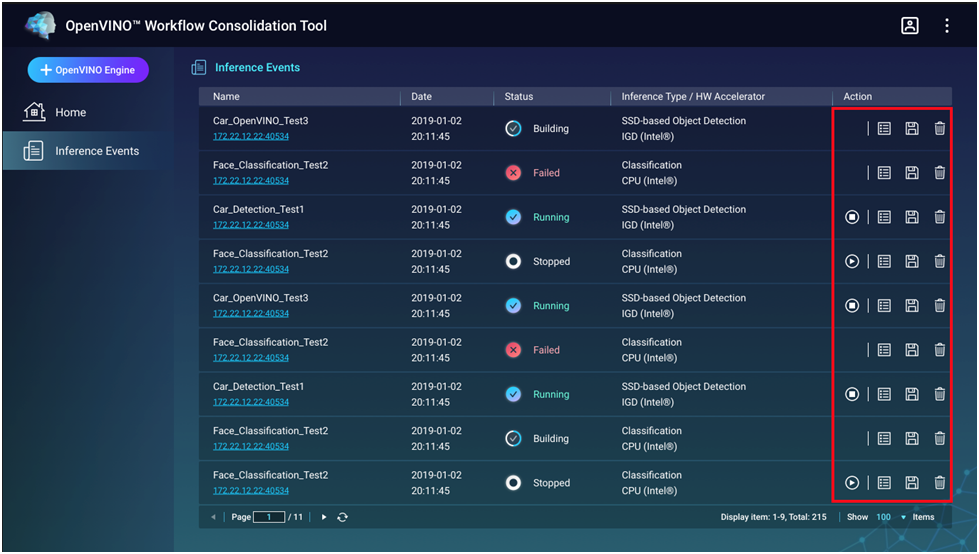

[インターフェイスイベント] 画面で推論エンジンの表示・管理を行うことができます。

|

ボタン |

説明 |

|---|---|

|

|

推論プロセスを開始します。 |

|

|

推論プロセスを停止します。 |

|

|

推論エンジンの詳細とログステータスを表示します。 |

|

|

高度なアプリケーションのために中間表現(IR)ファイルとして推論エンジンを保存します。 |

|

|

推論エンジンを削除します。 |