OpenVINO™ Workflow Consolidation Tool Tutorial

Info

De OpenVINO™ Workflow Consolidation Tool is een deep learning tool voor het converteren van getrainde modellen naar inference engines, versneld door de Intel Distribution of OpenVINO™ toolkit. Met inference engines is het mogelijk om de logische conclusies van getrainde modellen te verifiëren.

De Intel Distribution of OpenVINO™ toolkit is gebaseerd op CNN (convolutional neural networks). De toolkit verspreidt de workloads over Intel hardware accelerators voor verbetering van prestaties.

Container Station moet geïnstalleerd zijn om OWCT te kunnen gebruiken.

- Compatibiliteit

- Hardware Accelerators

- Het maken van Inference Engines

- Het gebruik van Computer Vision met Inference Engines

- Het beheer van Inference Engines

Compatibiliteit

|

Platform |

Ondersteuning |

|---|---|

|

NAS-modellen |

Opmerking:

Alleen modellen van NAS op basis van Intel ondersteunen de OpenVINO™ Workflow Consolidation Tool. |

|

OS |

QTS 4.4 |

|

Versie van Intel Distribution of OpenVINO™ toolkit |

2018R5 Ga voor meer informatie naar https://software.intel.com/en-us/articles/OpenVINO-RelNotes. |

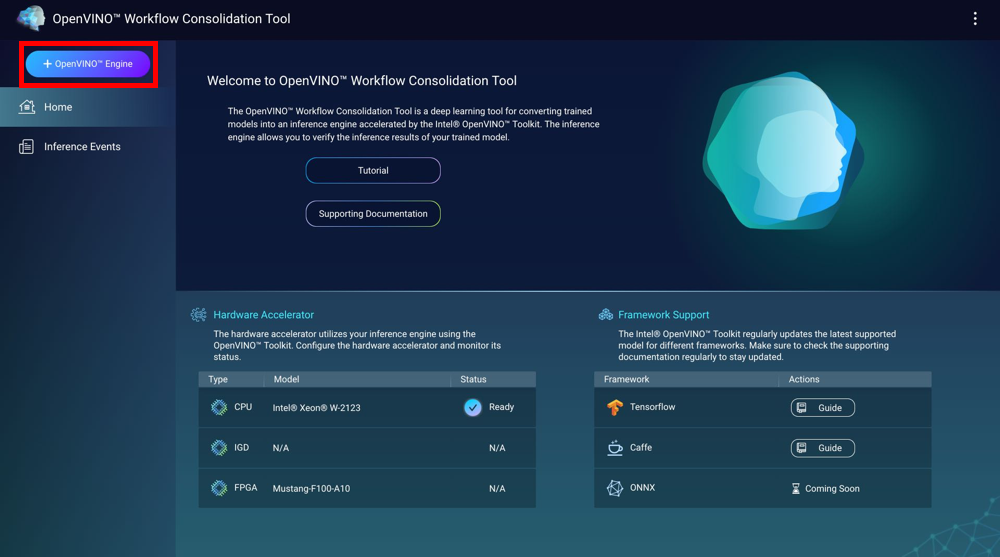

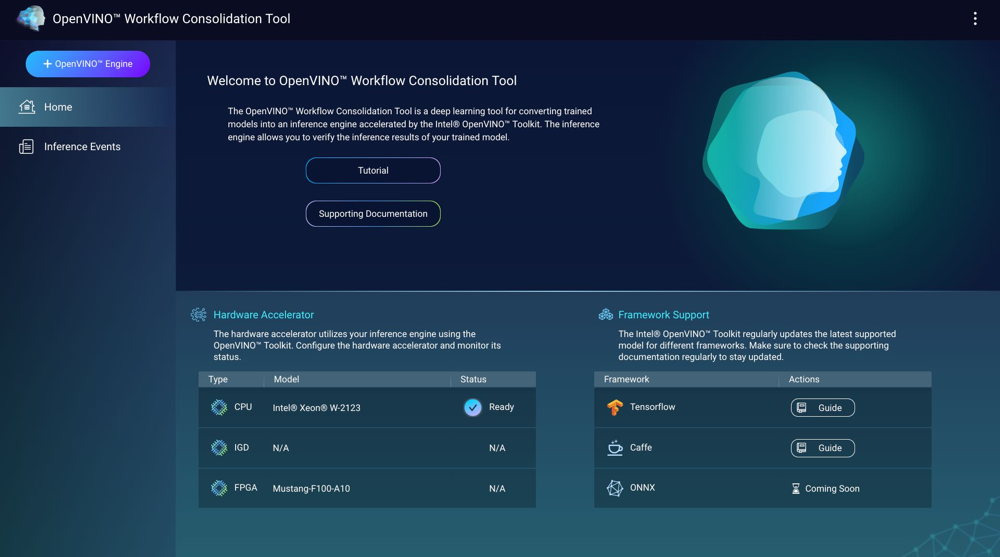

Hardware Accelerators

U kunt de in de NAS geïnstalleerde hardware accelerators gebruiken voor betere prestaties van de inference engines.

U kunt de in de NAS geïnstalleerde hardware accelerators zien in het Startscherm.

Hardware accelerators met de status Gereed kunnen worden gebruikt voor het maken van inference engines.

Met de status Instellingen, ga naar om de hardware accelerator in te stellen.

-

Om FPGA (field-programmable gate array)-kaarten te kunnen gebruiken op QNAP NAS, moet virtual machine (VM) pass-through ingeschakeld zijn.

-

Elke FPGA-bron kan één inference engine maken.

- Elke VPU (vision processing unit)-bron kan één inference engine maken.

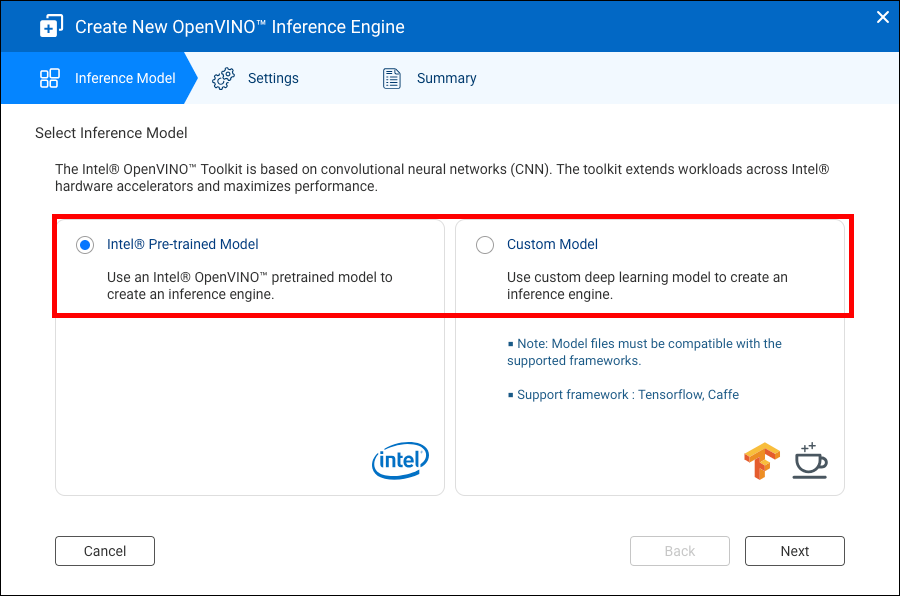

Het maken van Inference Engines

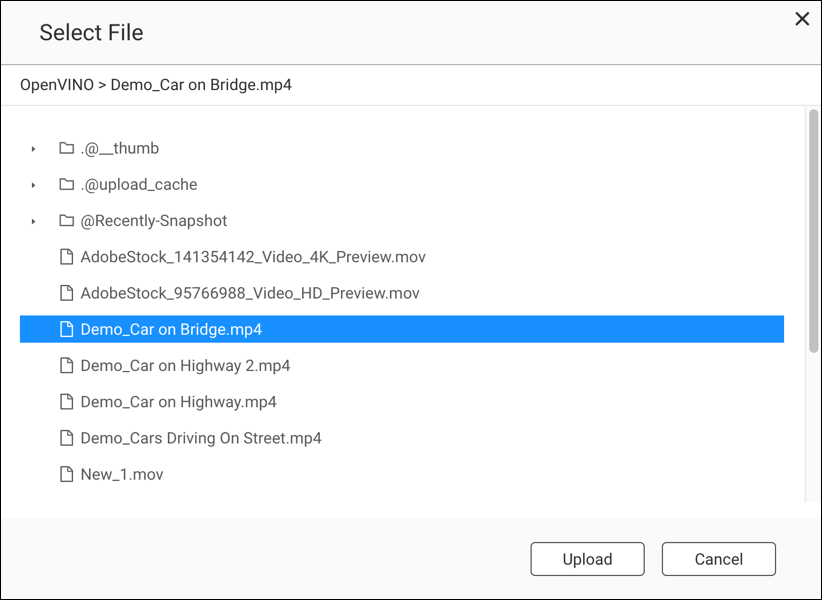

Gebruik de OWCT om inference engines te maken en parameters te configureren.

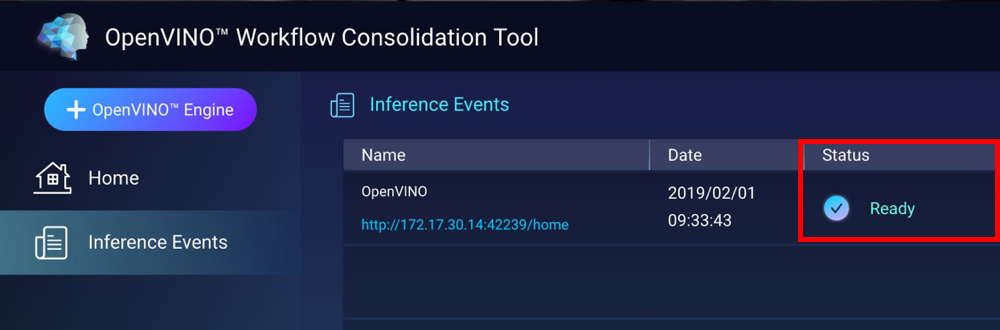

De OWCT maakt de inference engine en toont deze in het scherm Inference Gebeurtenissen.

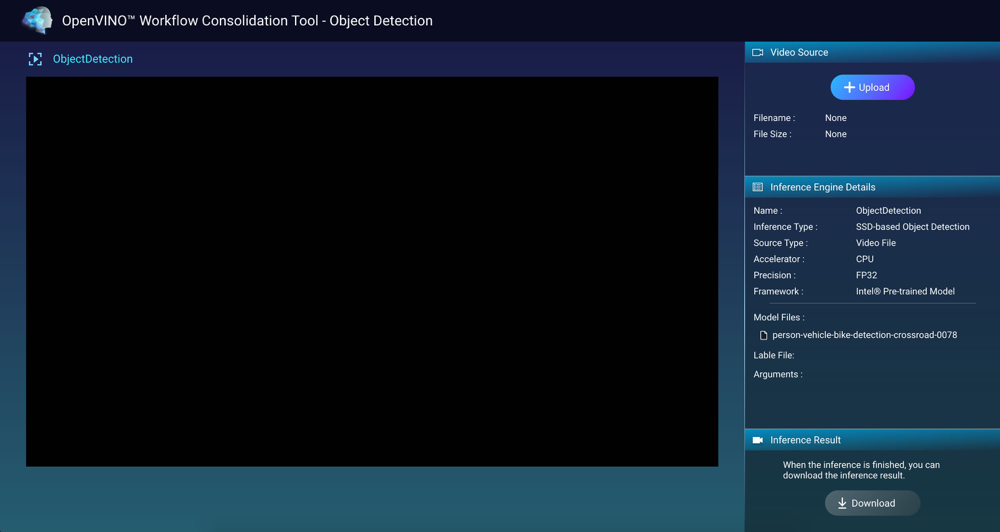

Het gebruik van Computer Vision met Inference Engines

Het beheer van Inference Engines

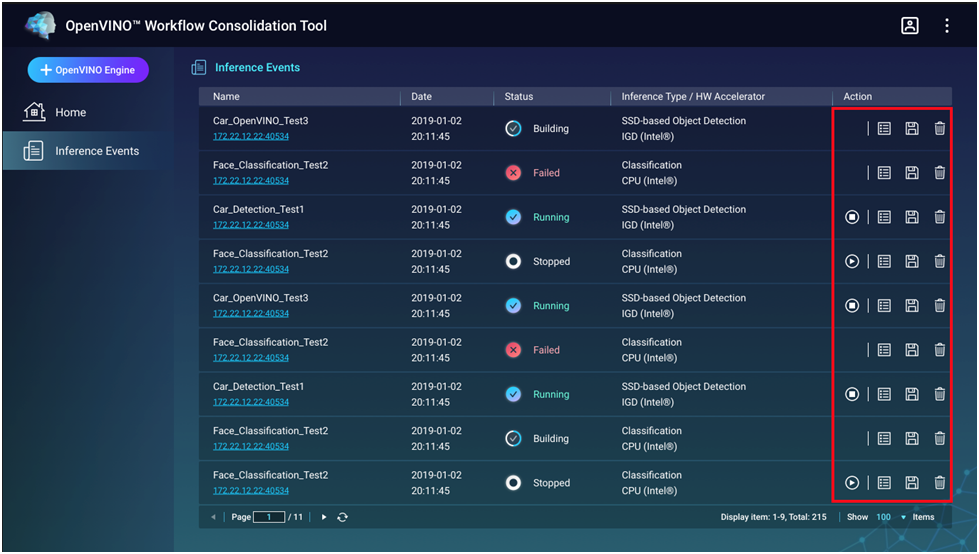

In het scherm Inference Gebeurtenissen kunt u inference engines zien en beheren.

|

Knop |

Beschrijving |

|---|---|

|

|

Start het proces van inference. |

|

|

Stopt het proces van inference. |

|

|

Toont details en logstatus van de inference engine. |

|

|

Bewaar de inference engine als een IR (Intermediate Representation)-bestand voor geavanceerde toepassingen. |

|

|

Verwijdert de inference engine. |