OpenVINO™ Workflow Consolidation Tool Anleitung

Über

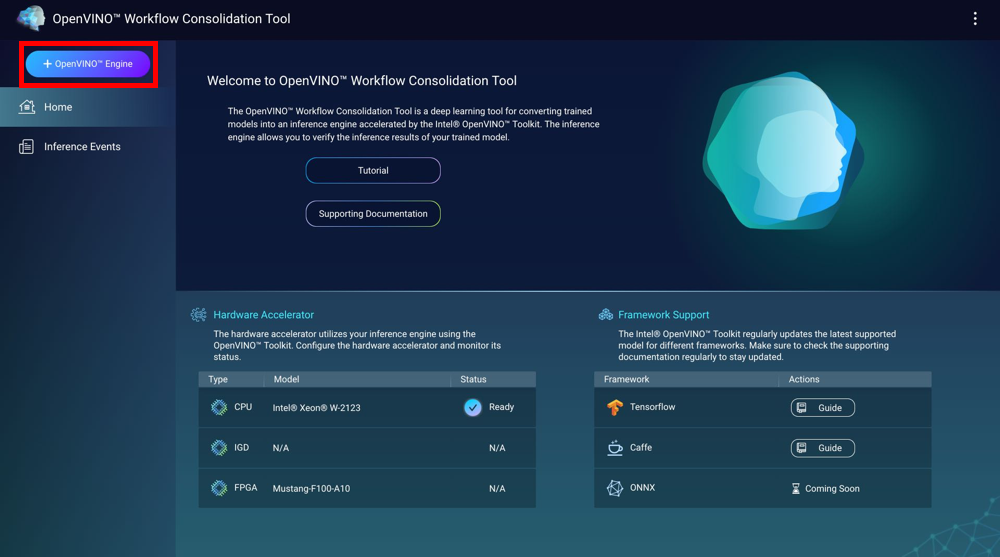

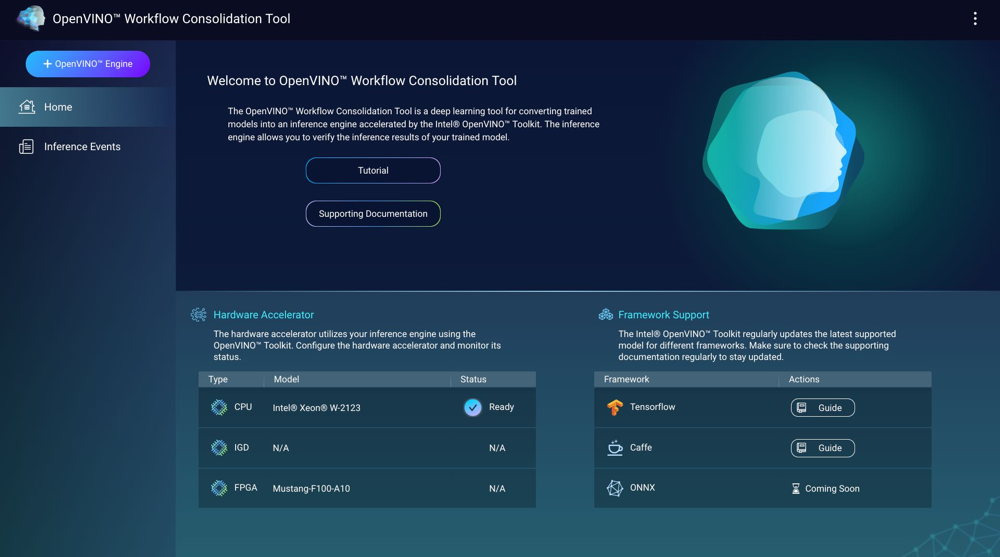

Das OpenVINO™ Workflow Consolidation Tool (OWCT) ist ein Deep Learning Tool zur Umwandlung von trainierten Modellen in Inferenzmaschinen, das durch das Intel® Distribution of OpenVINO™ Toolkit beschleunigt wird. Inferenzmaschinen ermöglichen es Ihnen, die Inferenzergebnisse von trainierten Modellen zu überprüfen.

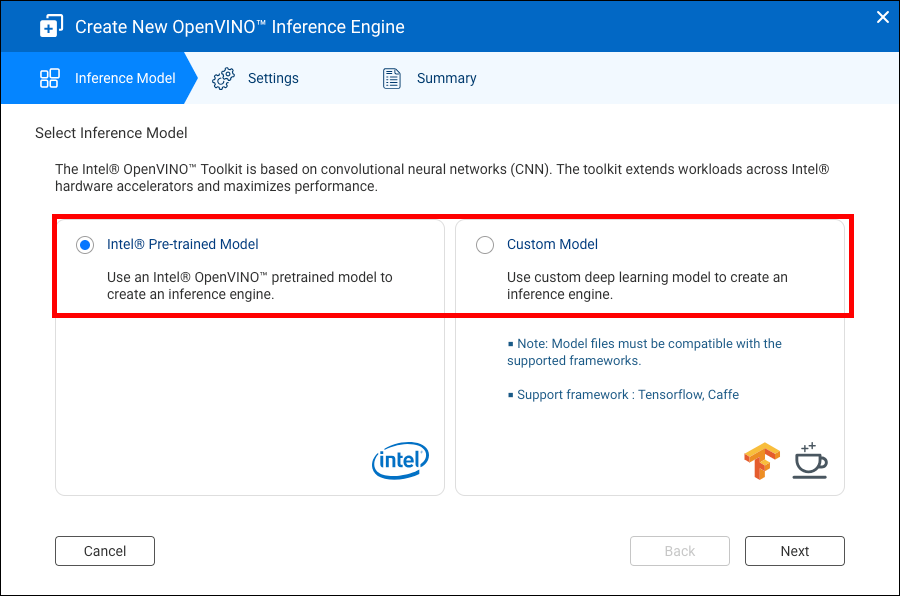

Das Intel® Distribution of OpenVINO™ Toolkit basiert auf Convolutional Neural Networks (CNN). Das Toolkit erweitert die Arbeitslasten auf Intel® Hardware Beschleuniger, um die Leistung zu maximieren.

Container Station muss installiert sein, um das OWCT nutzen zu können.

- Kompatibilität

- Hardware Beschleuniger

- Erstellen von Inferenzmaschinen

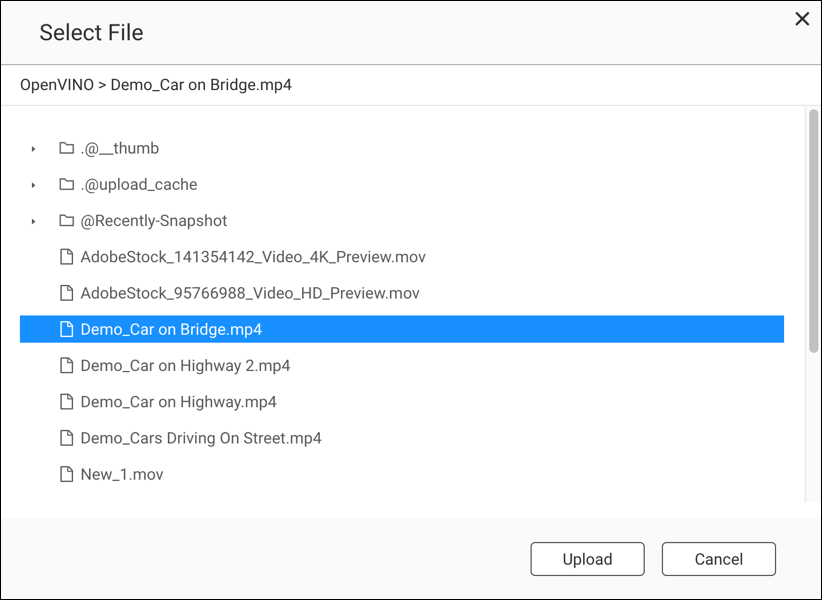

- Verwendung von Computer Vision mit Inferenzmaschinen

- Inferenzmaschinen verwalten

Kompatibilität

|

Plattform |

Unterstützung |

|---|---|

|

NAS-Modelle |

Hinweis:

Nur Intel-basierte NAS-Modelle unterstützen das OpenVINO™ Workflow Consolidation Tool. |

|

Betriebssystem |

QTS 4.4 |

|

Intel® Distribution of OpenVINO™ Toolkit Version |

2018R5 Weitere Informationen finden Sie unter https://software.intel.com/en-us/articles/OpenVINO-RelNotes. |

Hardware Beschleuniger

Sie können Hardwarebeschleuniger verwenden, die in Ihrem NAS installiert sind, um die Leistung Ihrer Inferenzmaschinen zu verbessern.

Im NAS installierte Hardwarebeschleuniger werden auf dem Start Bildschirm angezeigt.

Hardwarebeschleuniger mit dem Status Bereit können bei der Erstellung von Inferenzmaschinen verwendet werden.

Wenn der angezeigte Status Einstellungen lautet, gehen Sie zu , um den Hardwarebeschleuniger einzurichten.

-

Um Field-Programmable Gate Array (FPGA) Karten auf einem QNAP NAS verwenden zu können, muss Passthrough für virtuelle Maschinen (VM) deaktiviert werden.

-

Jede FPGA Ressource kann eine Inferenzmaschine erstellen.

- Jede Vision Processing Unit (VPU) Ressource kann eine Inferenzmaschine erstellen.

Erstellen von Inferenzmaschinen

Verwenden Sie das OWCT, um Inferenzmaschinen zu erstellen und Inferenzparameter zu konfigurieren.

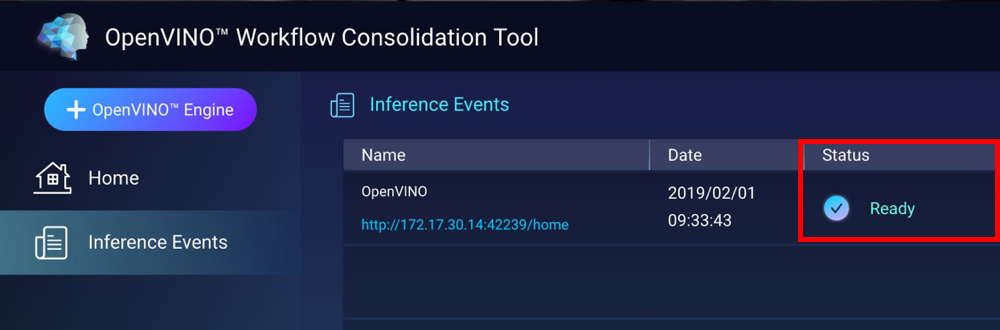

Das OWCT erstellt die Inferenzmaschine und zeigt sie auf dem Bildschirm Inferenzereignisse an.

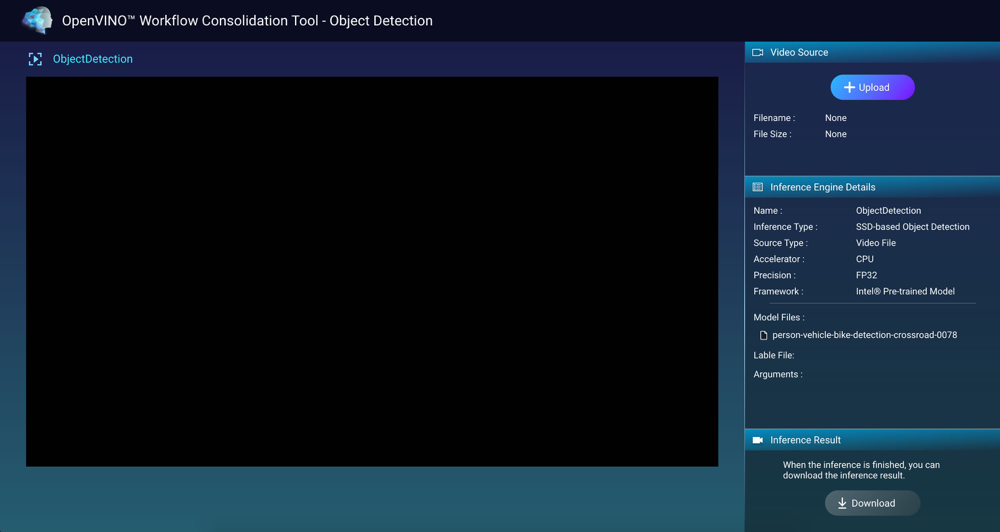

Verwendung von Computer Vision mit Inferenzmaschinen

Inferenzmaschinen verwalten

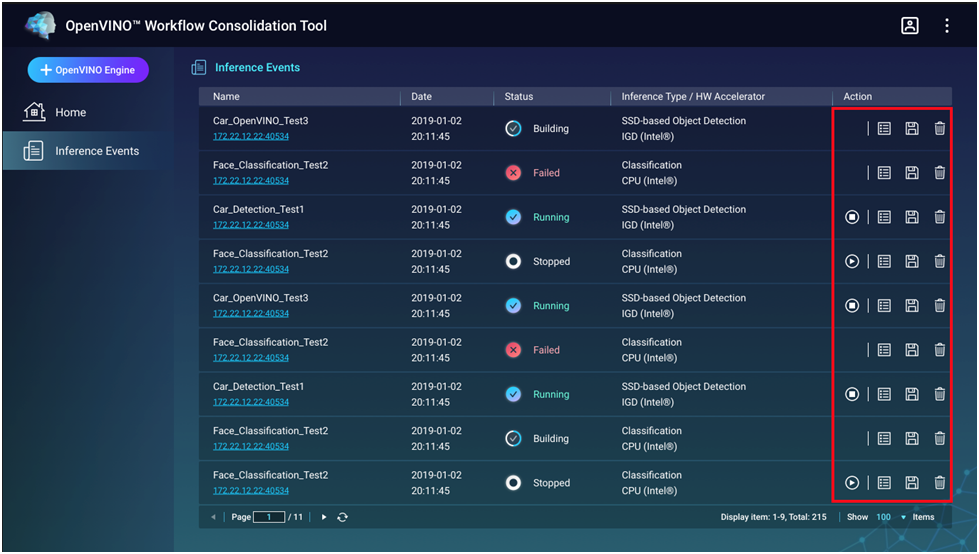

Sie können Inferenzmaschinen auf dem Bild Inferenzereignisse anzeigen und verwalten.

|

Schaltfläche |

Beschreibung |

|---|---|

|

|

Startet den Inferenzprozess. |

|

|

Stoppt den Inferenzprozess. |

|

|

Zeigt Details und den Protokollstatus der Inferenzmaschine an. |

|

|

Speichert die Inferenzmaschine als Intermediate Representation (IR) Datei für erweiterte Anwendungen. |

|

|

Löscht die Inferenzmaschine. |