OpenVINO™ Workflow Consolidation Tool 使用教學

關於

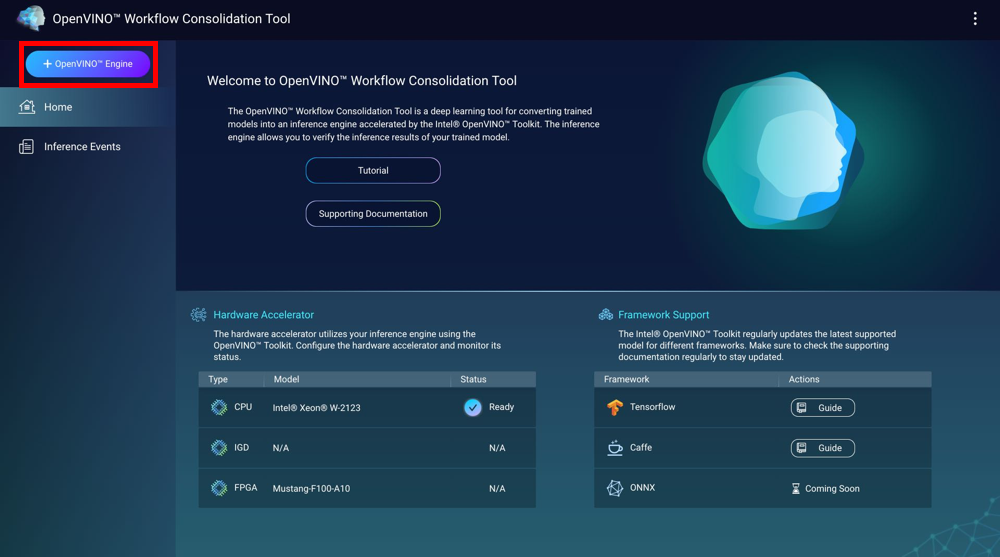

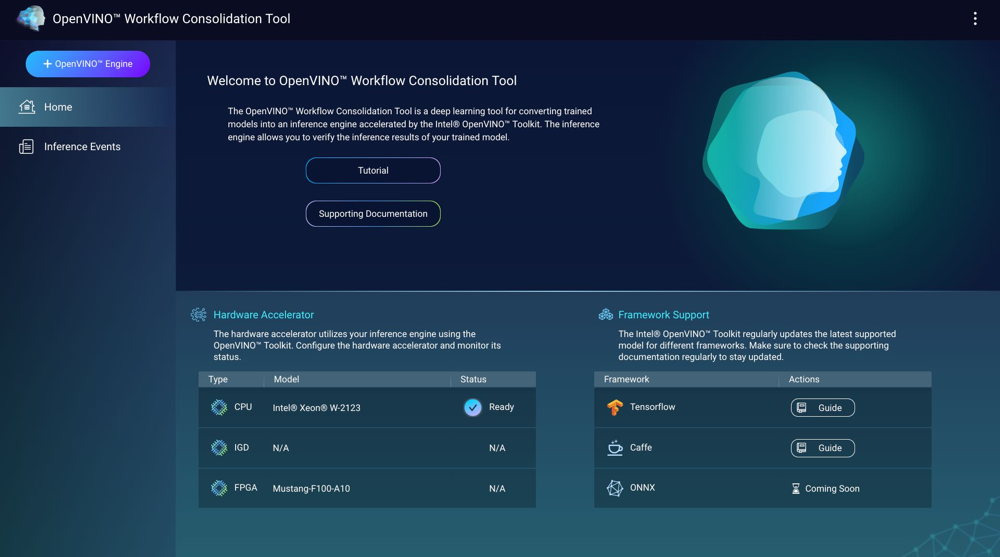

OpenVINO™ Workflow Consolidation Tool (OWCT) 是一款深度學習應用工具,可將訓練完成的模型轉換為採用 Intel® Distribution of OpenVINO™ Toolkit 技術加速運行的推論引擎。 推論引擎可讓您針對訓練完成之模型驗證推論結果。

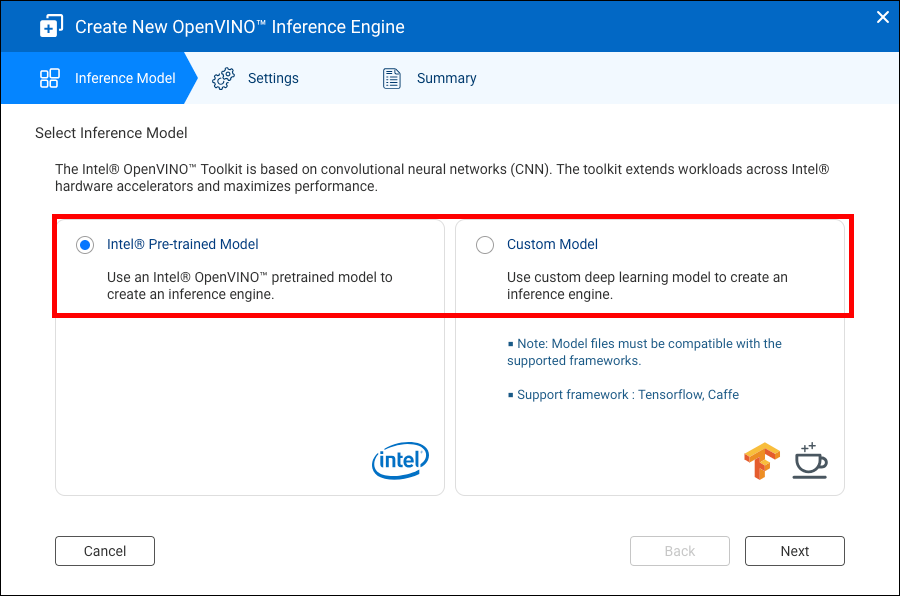

Intel® Distribution of OpenVINO™ Toolkit 的運作原理是卷積神經網路 (CNN)。 此工具組透過 Intel® 硬體加速器擴充工作負載,藉此發揮最大效能。

必須安裝 Container Station 才能使用 OWCT。

相容性列表

|

平台 |

支援 |

|---|---|

|

NAS 型號 |

注意:

只有 Intel 型的 NAS 裝置才支援 OpenVINO™ Workflow Consolidation Tool。 |

|

作業系統 |

QTS 4.4 |

|

Intel® Distribution of OpenVINO™ Toolkit 版本 |

2018R5 如需詳細資訊,請前往 https://software.intel.com/en-us/articles/OpenVINO-RelNotes。 |

硬體加速器

您可以使用安裝在 NAS 的硬體加速器來提升推論引擎的效能。

安裝在 NAS 的硬體加速器會顯示於〔首頁〕畫面。

若硬體加速器的狀態為 〔就緒〕 ,該硬體加速器就可用於建立推論引擎。

如果顯示的狀態為 〔設定〕,請前往設定硬體加速器。

-

若要在 QNAP NAS 使用現場可程式邏輯閘陣列 (FPGA) 卡,必須先啟用虛擬機 (VM) pass-through 功能。

-

每個 FPGA 資源可以建立一個推論引擎。

- 每個視覺處理器 (VPU) 資源可以建立一個推論引擎。

建立推論引擎

使用 OWCT 建立推論引擎並設定推論參數。

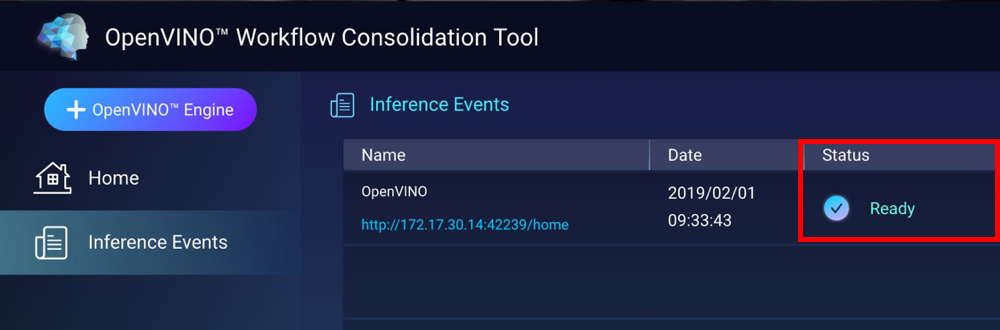

OWCT 隨即建立推論引擎並顯示在〔推論事件〕畫面。

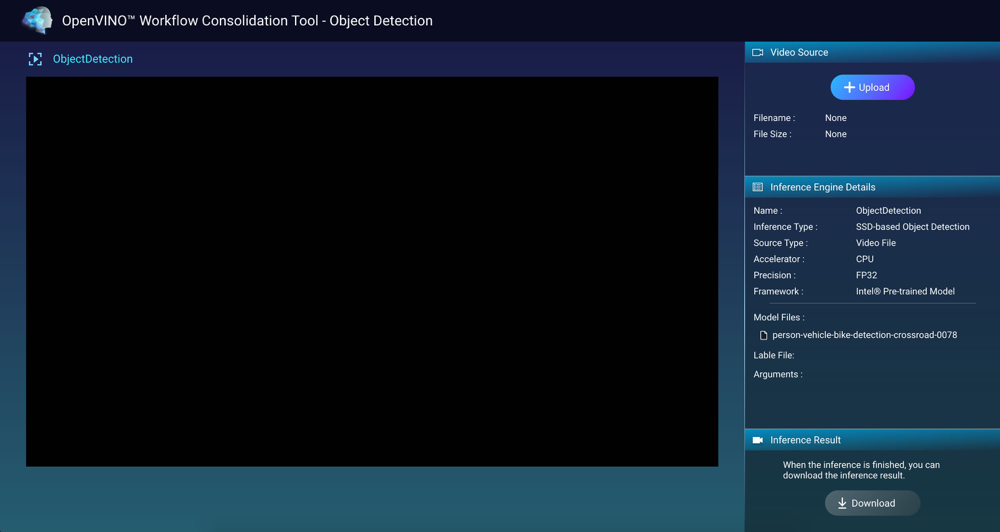

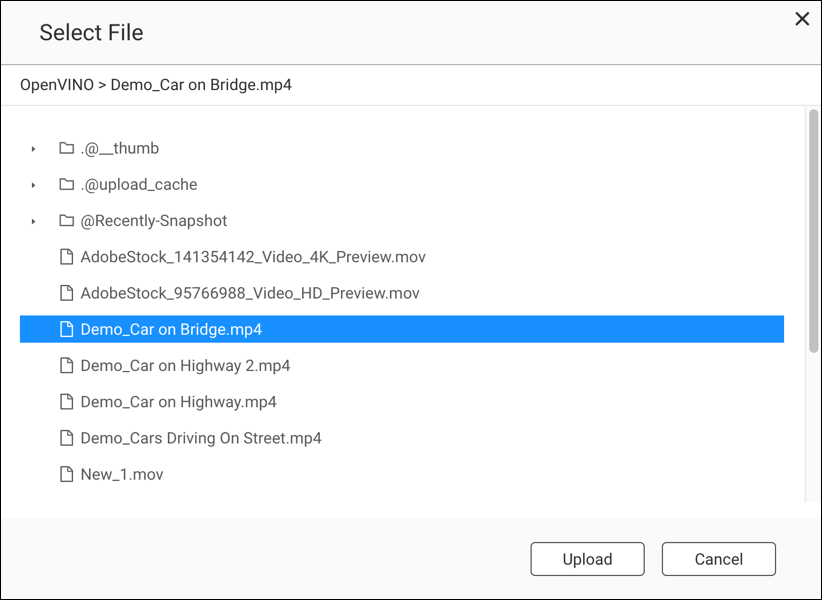

透過推論引擎運用電腦視覺

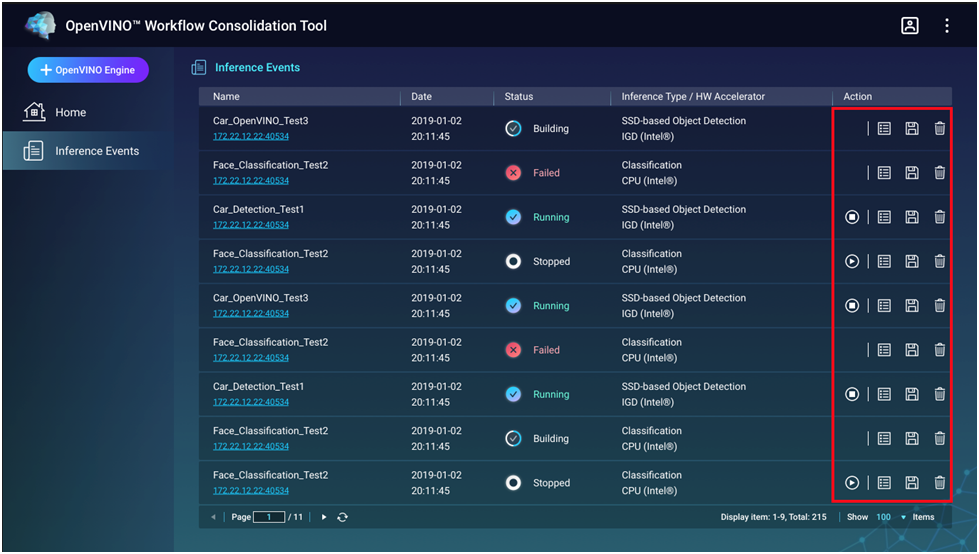

管理推論引擎

您可以在〔推論事件〕畫面中檢視和管理推論引擎。

|

按鈕 |

描述 |

|---|---|

|

|

啟動推論程序。 |

|

|

停止推論程序。 |

|

|

顯示推論引擎的詳細資料和記錄狀態。 |

|

|

將推論引擎儲存為中間語言 (IR) 檔案,以供進階應用程式使用。 |

|

|

刪除推論引擎。 |