Comment utiliser les grands modèles de langage pour la recherche Qsirch RAG ?

Produits Applicables

Qsirch 6.0.0 (ou version ultérieure) sur toutes les plateformes

Qsirch RAG Search avec Cloudet LLMs sur site

Qsirch prend en charge l'utilisation de la génération augmentée par récupération (RAG) avec des modèles de langage de grande taille (LLM) basés sur le cloud pour fournir des réponses précises et contextuelles. Lorsque vous entrez une requête, Qsirch récupère les documents pertinents de votre NAS et les utilise comme contexte pour le modèle de langage. Cette combinaison de recherche et d'IA générative permet à Qsirch de générer des réponses précises et informées basées sur vos propres données.

Qsirch prend également en charge la conversation multi-tours, permettant des interactions naturelles et contextuelles. Les utilisateurs peuvent poser des questions de suivi sans répéter le contexte précédent, et le contexte est préservé d'un tour à l'autre pour des réponses cohérentes. La prise en charge de la conversation multi-tours fonctionne avec les modes RAG cloud et sur site.

Intégrer RAG avec les services d'IA basés sur le cloud

Pour intégrer la recherche RAG, vous devez d'abord obtenir une clé API d'un service d'IA de votre choix.

ChatGPT (API OpenAI)

ChatGPT (API OpenAI) fournit des modèles GPT puissants pour les embeddings RAG et les réponses génératives. Suivez les étapes ci-dessous pour demander une clé API :

- Inscrivez-vous pour un compte sur OpenAI : https://auth.openai.com/create-account

- Créez une clé API dans les paramètres du compte.

Pour plus d'informations, voir Documentation de l'API OpenAI.

Azure OpenAI

Azure OpenAI offre un accès aux modèles OpenAI (comme GPT-4.1) via l'infrastructure Azure, idéale pour les solutions d'entreprise. Suivez les étapes ci-dessous pour demander une clé API :

- Connectez-vous au Portail Azure.

- Sélectionnez votre ressource OpenAI (ou créez-en une si vous n'en avez pas déjà une).

- Dans le menu de gauche, cliquez sur Clés et Point de terminaison.

- Copiez une clé API et copiez le point de terminaison (URL de base) pour les requêtes API.

Pour plus d'informations, voir Documentation Azure OpenAI.

Gemini (Google Cloud AI)

Gemini (Google Cloud AI) fournit un ensemble de modèles conçus pour un raisonnement haute performance et RAG. Suivez les étapes ci-dessous pour demander une clé API :

- Visitez le Documentation de l'API Google Gemini.

- Obtenez une clé API Gemini dans Google AI Studio.

- Connectez-vous à votre compte Google.

- Cliquez sur Créer une clé API.

Pour plus d'informations, voir Documentation de Google Cloud AI.

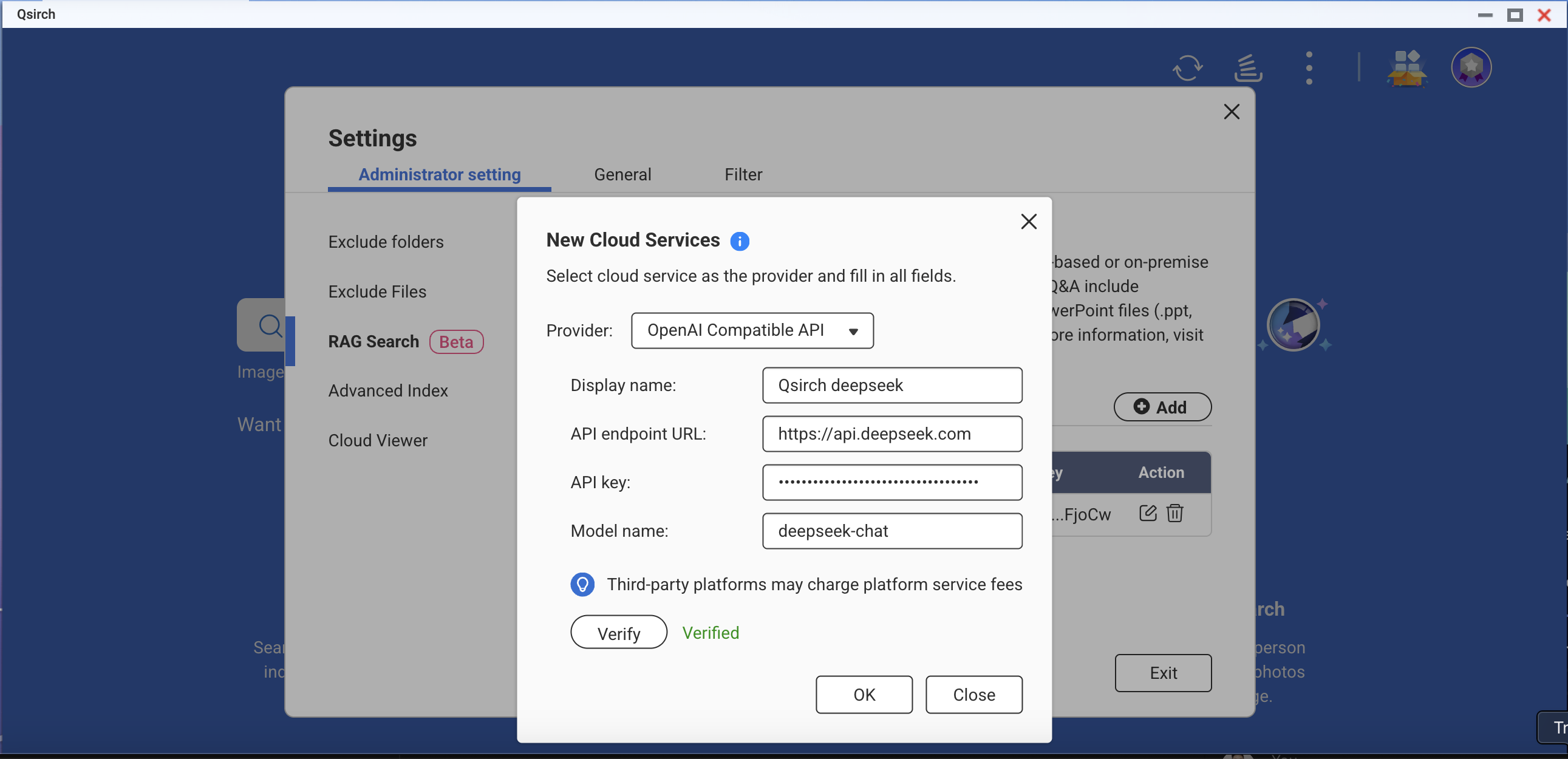

API compatible avec OpenAI

L'API compatible avec OpenAI permet aux utilisateurs d'accéder à divers modèles d'IA au-delà des offres propres d'OpenAI, y compris des modèles comme DeepSeek et Grok, en utilisant le même format d'API. Cela permet une intégration transparente avec les applications existantes conçues pour l'API OpenAI. Suivez les étapes ci-dessous pour demander une clé API :

- Choisissez un fournisseur qui prend en charge l'API compatible avec OpenAI (par exemple, DeepSeek ou Grok).

- Inscrivez-vous sur la plateforme du fournisseur.

- Générez une clé API dans les paramètres du compte.

- Mettez à jour votre point de terminaison API et les paramètres du modèle selon les besoins.

Pour plus d'informations, consultez la documentation officielle de l'API du fournisseur.

Recherche RAG sur site

Pour activer la recherche RAG sur site :

- Assurez-vous que le noyau LLM est prêt.

- Réglez le GPU sur le mode Container Station (Accédez à Panneau de configuration > Matériel > Ressources matérielles > Utilisation des ressources > mode Container Station ).

Comment utiliser la recherche RAG dans Qsirch

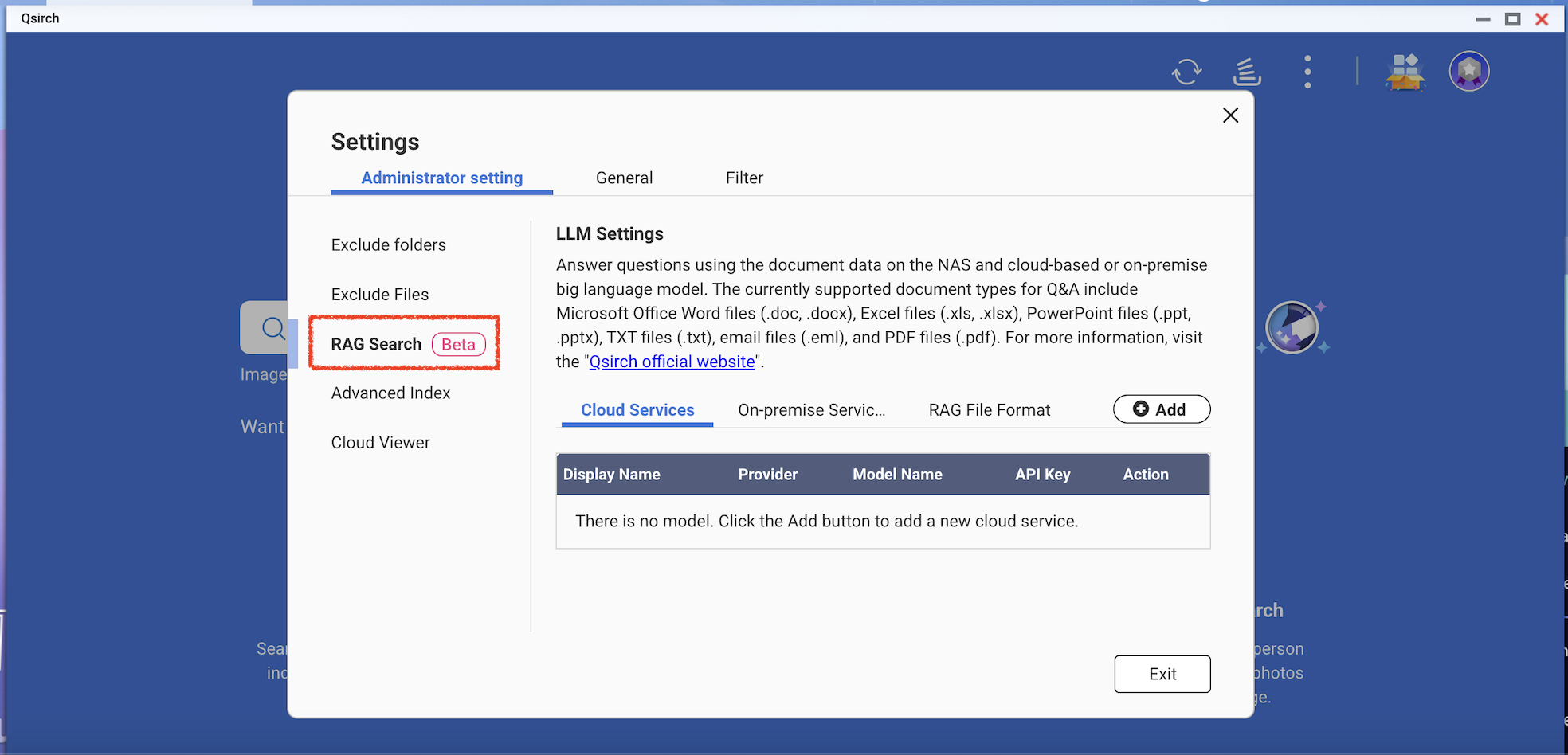

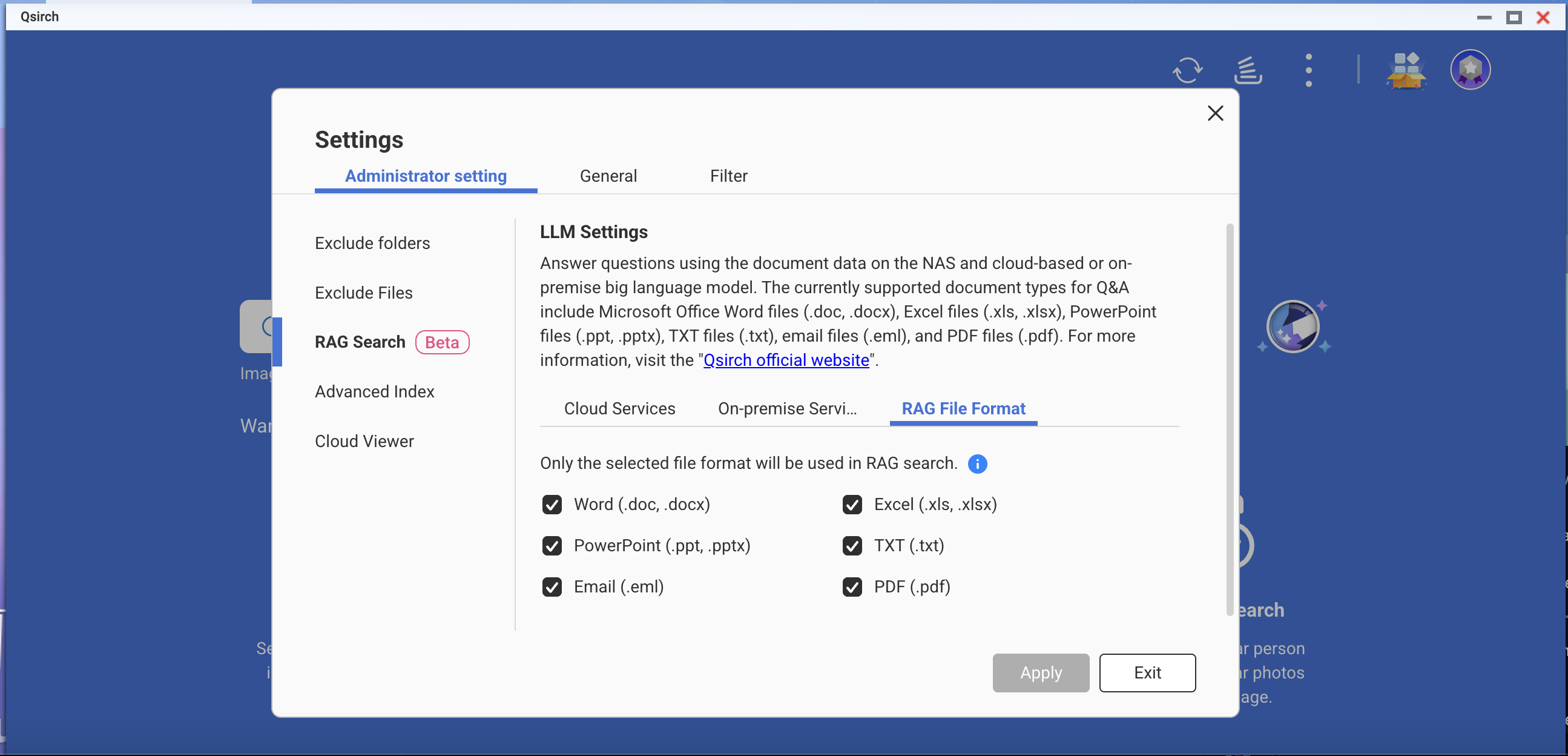

- Accédez à Paramètres > Paramètre administratif > Recherche RAG.

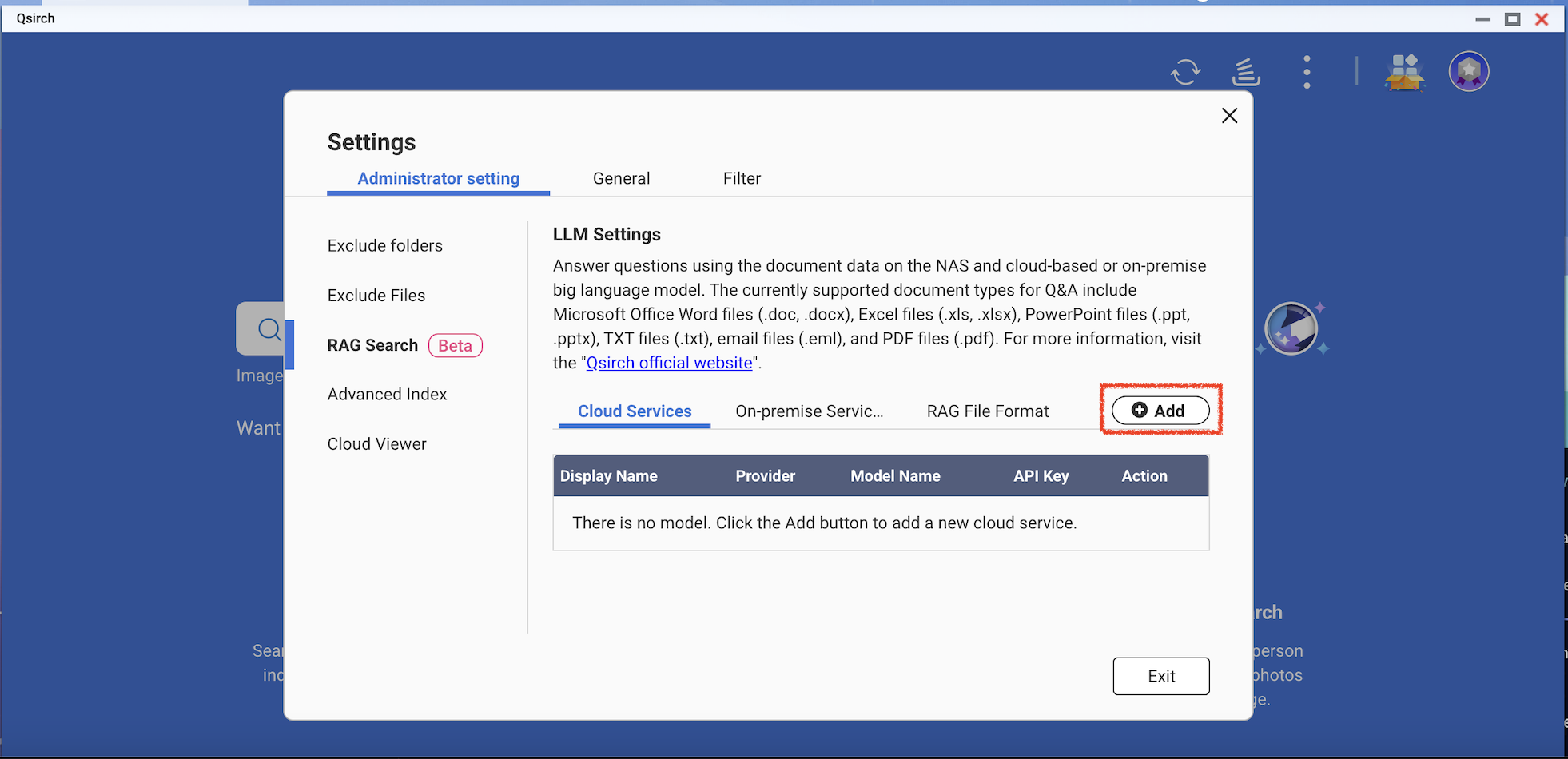

- Ajoutez un ou plusieurs services cloud pour utiliser la recherche RAG.

(Optionnel) Vérifiez votre clé API. Cela aide à vérifier si une clé API est valide.

Téléchargez un ou plusieurs modèles Edge à partir des services sur site. Cette fonctionnalité ne peut être utilisée que sur les modèles de NAS spécifiques.

- Ajoutez plus de modèles d'IA compatibles avec l'API OpenAI, y compris la série GPT, les modèles DeepSeek et les modèles Grok.

- Choisissez les formats de fichiers pour votre recherche RAG.

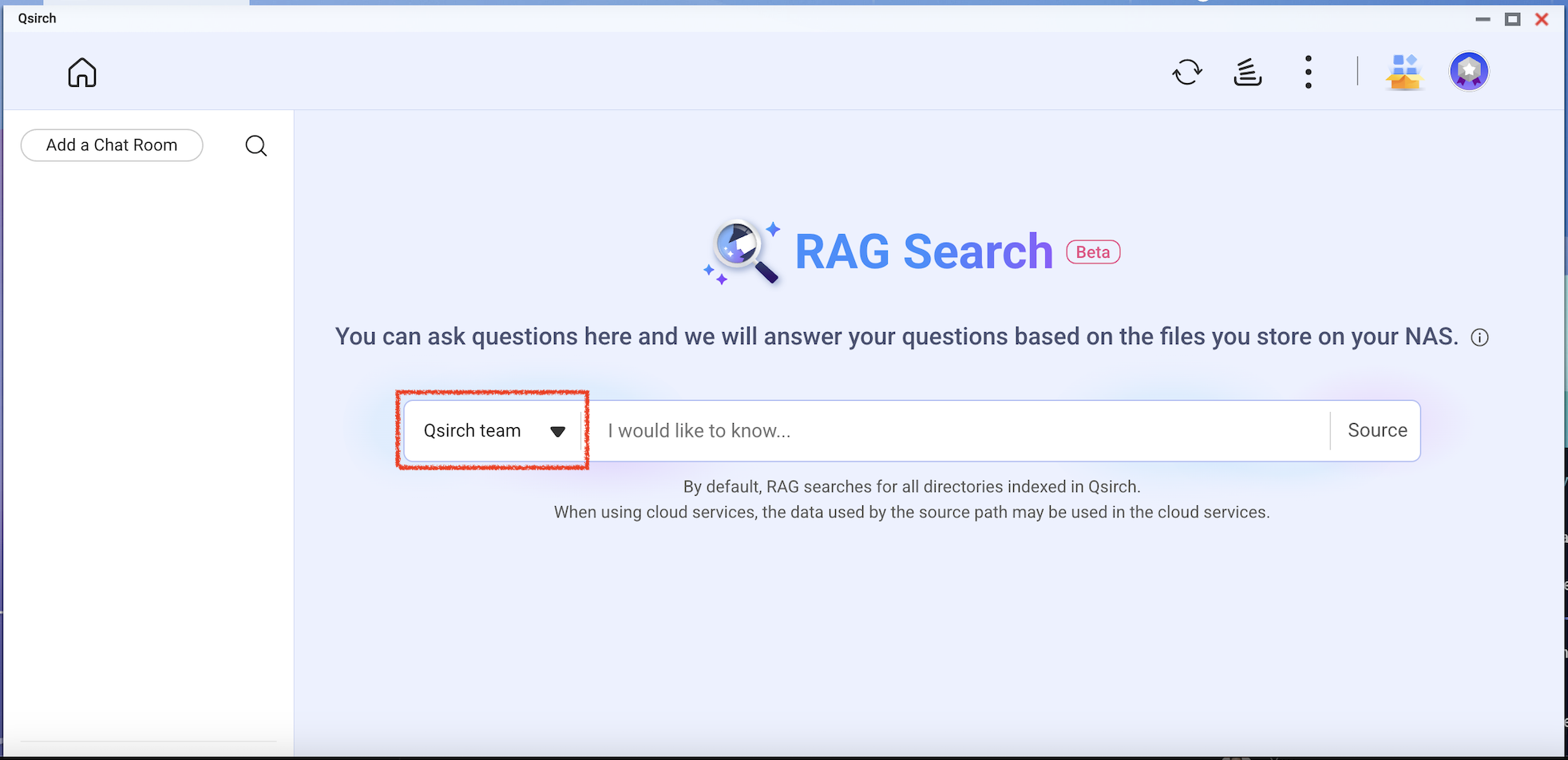

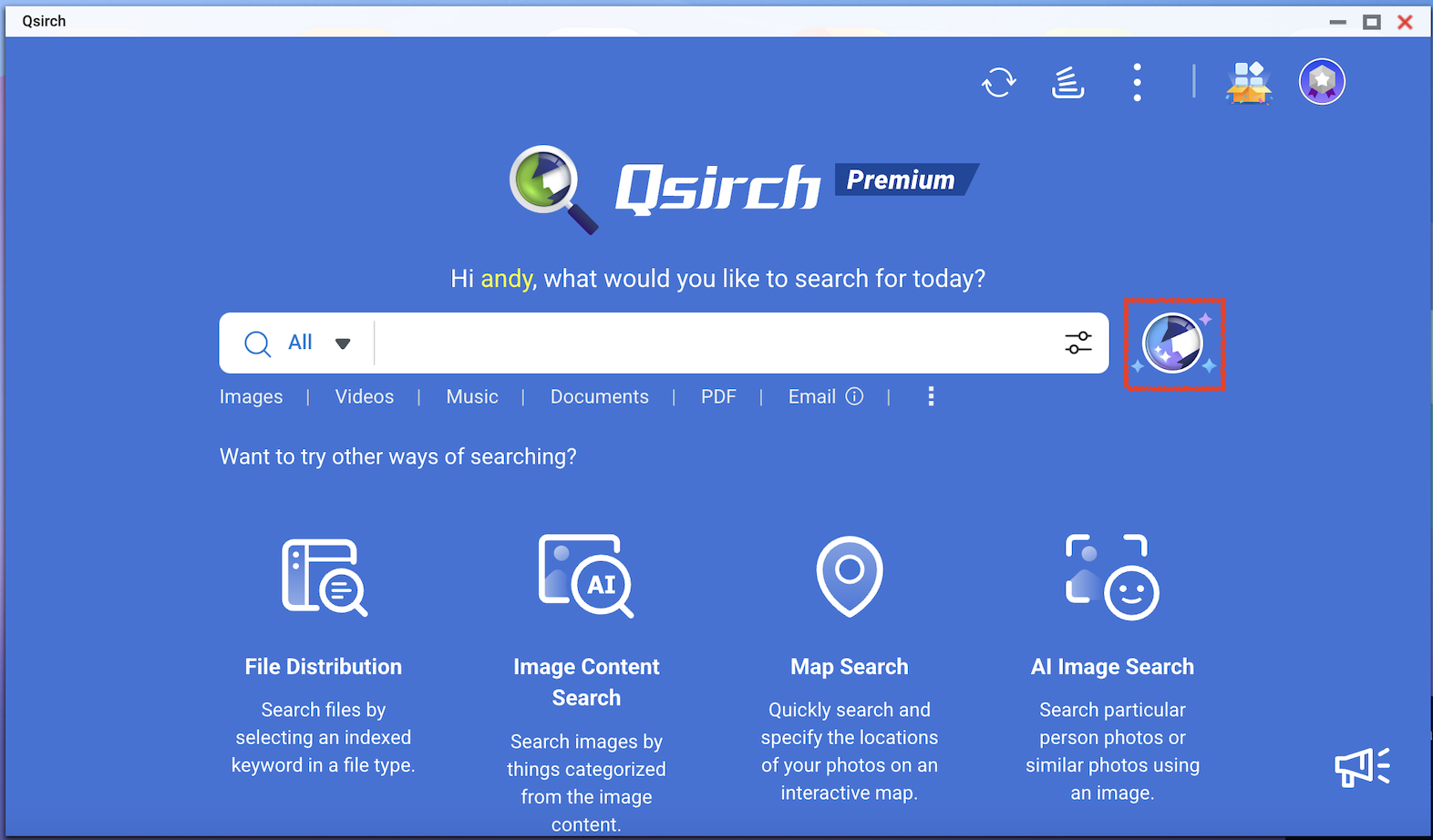

- Accédez à la page d'accueil de Qsirch et cliquez sur le bouton de recherche RAG.

La recherche RAG de Qsirch n'utilisera que les fichiers inclus dans "Source" pour la récupération de données.

Vérifiez le modèle que vous souhaitez utiliser, puis commencez à utiliser la recherche RAG.