Como usar modelos de linguagem grandes para pesquisa RAG no Qsirch?

Produtos Aplicáveis

Qsirch 6.0.0 (ou posterior) em todas as plataformas

Pesquisa RAG do Qsirch com Cloude LLMs no Local

O Qsirch suporta a utilização de Geração Aumentada por Recuperação (RAG) com grandes modelos de linguagem (LLMs) baseados na nuvem para fornecer respostas precisas e com consciência de contexto. Quando insere uma consulta, o Qsirch recupera documentos relevantes do seu NAS e utiliza-os como contexto para o modelo de linguagem. Esta combinação de pesquisa e IA generativa permite ao Qsirch gerar respostas precisas e informadas com base nos seus próprios dados.

O Qsirch também suporta conversação multi-turn, permitindo interações naturais e com consciência de contexto. Os utilizadores podem fazer perguntas de seguimento sem repetir o contexto anterior, e o contexto é preservado ao longo das interações para respostas coerentes. O suporte para conversação multi-turn funciona tanto com modos RAG na nuvem como no local.

Integrar RAG com Serviços de IA Baseados na Nuvem

Para integrar a pesquisa RAG, deve primeiro obter uma chave API de um serviço de IA à sua escolha.

ChatGPT (API OpenAI)

O ChatGPT (API OpenAI) fornece modelos GPT poderosos tanto para embeddings RAG como para respostas generativas. Siga os passos abaixo para solicitar uma chave API:

- Registe-se para uma conta na OpenAI: https://auth.openai.com/create-account

- Crie uma chave API nas definições da conta.

Para mais informações, consulte Documentação da API OpenAI.

Azure OpenAI

O Azure OpenAI fornece acesso a modelos OpenAI (como o GPT-4.1) através da infraestrutura Azure, ideal para soluções empresariais. Siga os passos abaixo para solicitar uma chave API:

- Inicie sessão no Portal Azure .

- Selecione o seu recurso OpenAI (ou crie um se ainda não tiver um).

- No menu à esquerda, clique em Chaves e Endpoint.

- Copie uma chave API e copie o endpoint (URL base) para pedidos de API.

Para mais informações, consulte Documentação do Azure OpenAI.

Gemini (Google Cloud AI)

O Gemini (Google Cloud AI) fornece um conjunto de modelos concebidos para raciocínio de alto desempenho e RAG. Siga os passos abaixo para solicitar uma chave API:

- Visite o Documentação da API Google Gemini.

- Obtenha uma chave API Gemini no Google AI Studio.

- Inicie sessão na sua conta Google.

- Clique em Criar chave API.

Para mais informações, consulte Documentação da Google Cloud AI.

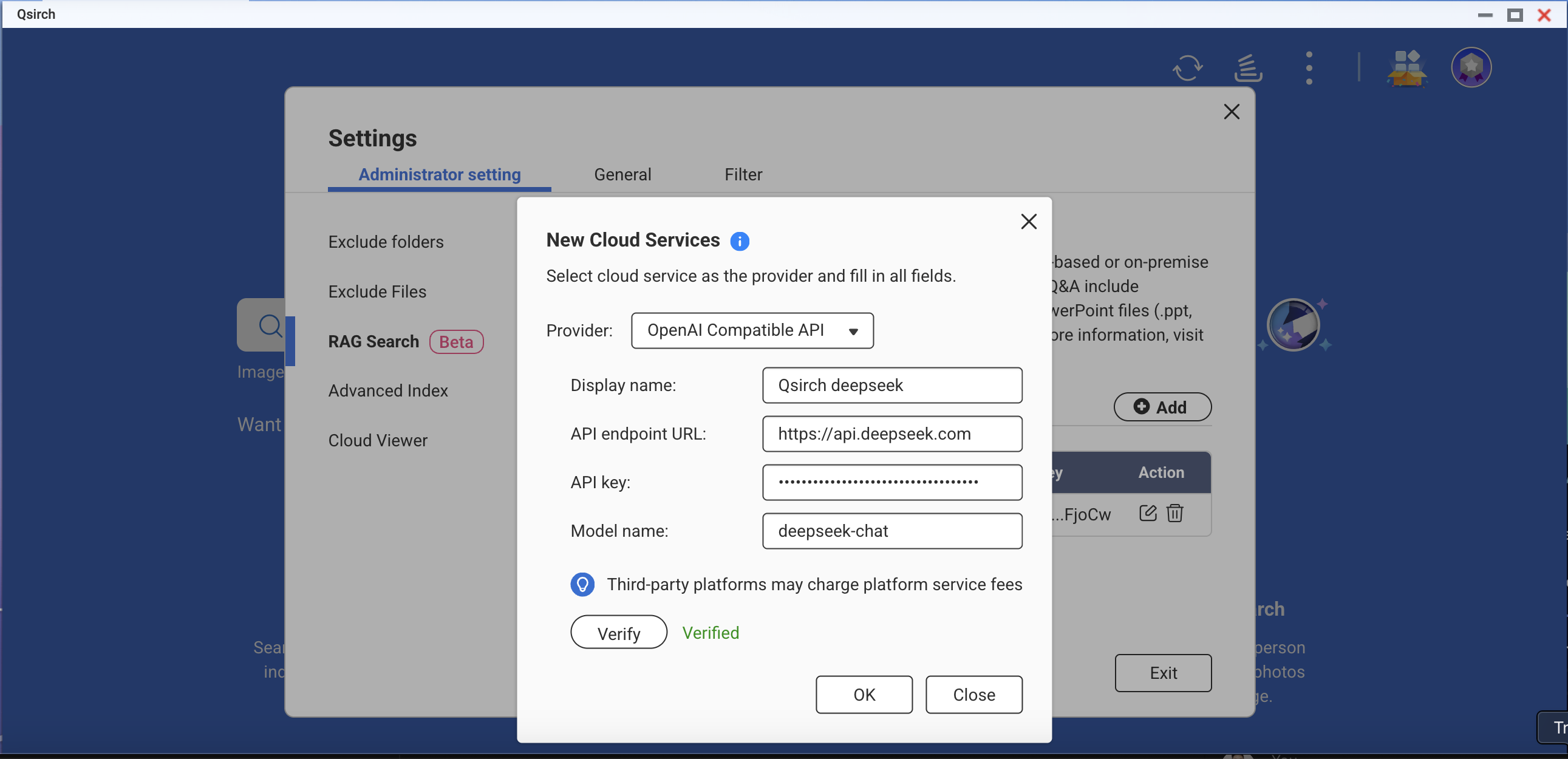

API Compatível com OpenAI

A API Compatível com OpenAI permite aos utilizadores aceder a vários modelos de IA além das ofertas próprias da OpenAI, incluindo modelos como DeepSeek e Grok, utilizando o mesmo formato de API. Isto permite uma integração perfeita com aplicações existentes construídas para a API OpenAI. Siga os passos abaixo para solicitar uma chave de API:

- Escolha um fornecedor que suporte a API compatível com OpenAI (por exemplo, DeepSeek ou Grok).

- Registe-se na plataforma do fornecedor.

- Gere uma chave de API nas definições da conta.

- Atualize o seu endpoint de API e as definições do modelo conforme necessário.

Para mais informações, consulte a documentação oficial da API do fornecedor.

Pesquisa RAG On-Premise

Para ativar a RAG on-premise:

- Certifique-se de que o LLM Core está pronto.

- Defina a GPU para o modo Container Station (Vá para Painel de Controlo > Hardware > Recursos de hardware > Utilização de Recursos > modo Container Station ).

Como Usar a Pesquisa RAG no Qsirch

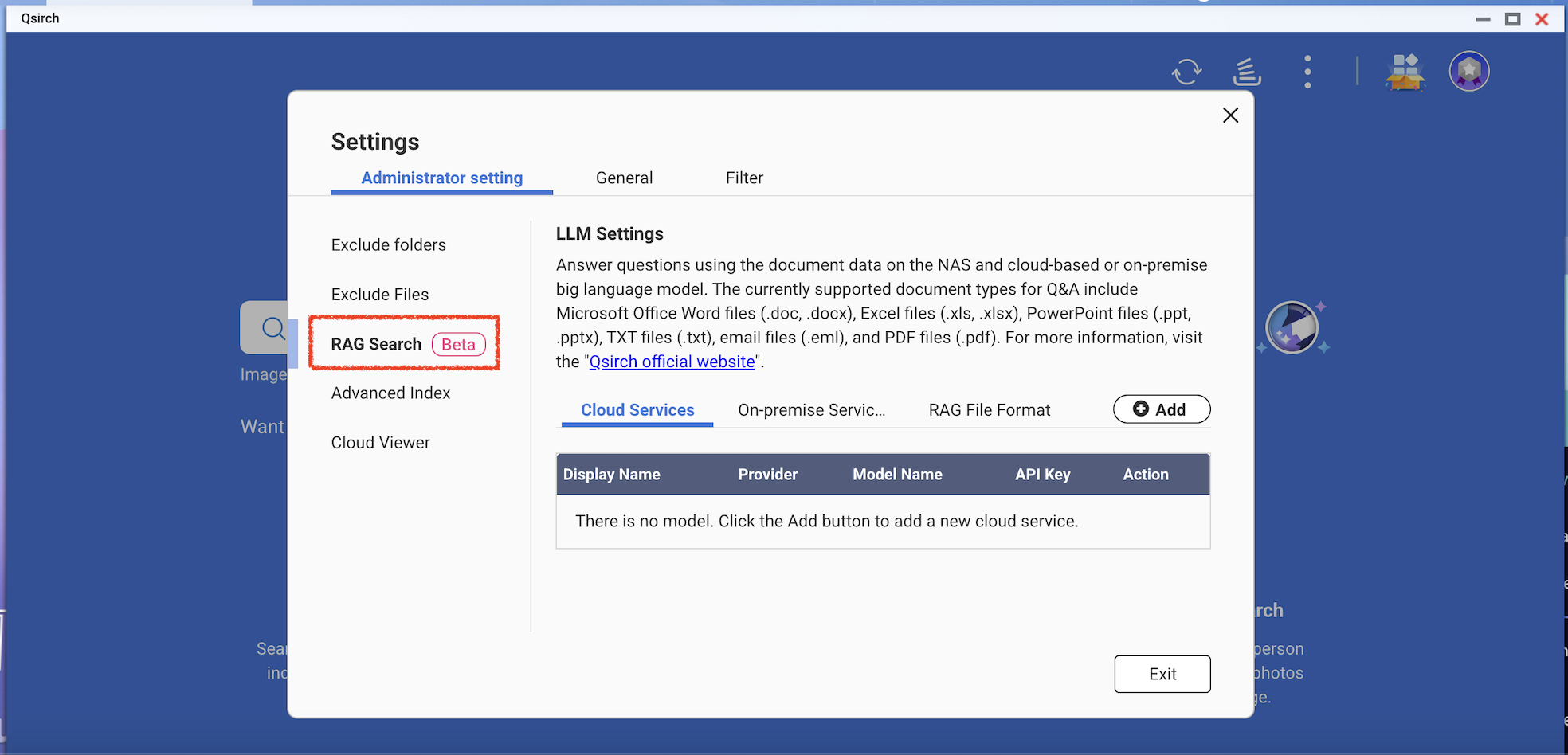

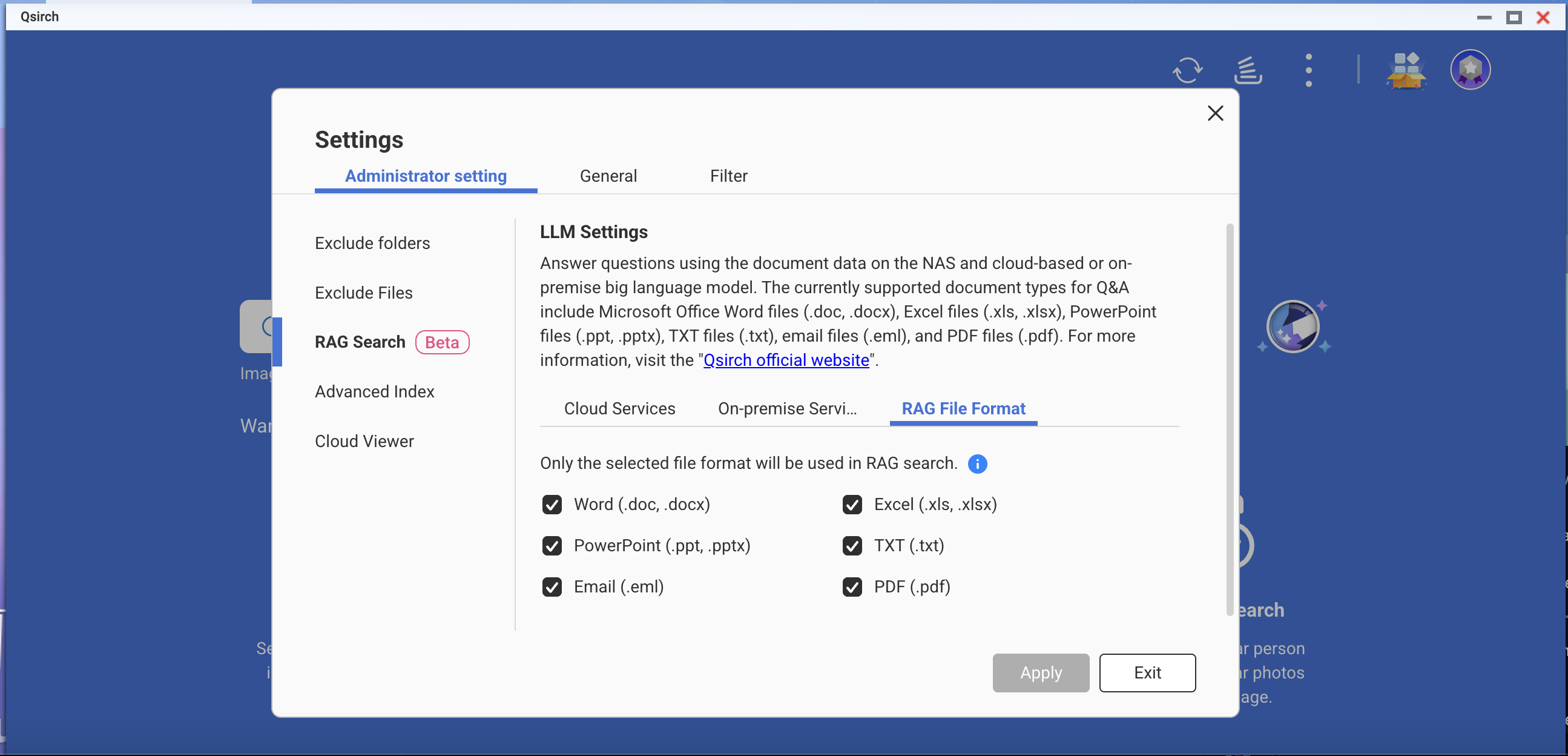

- Vá para Definições > Definições Administrativas > Pesquisa RAG.

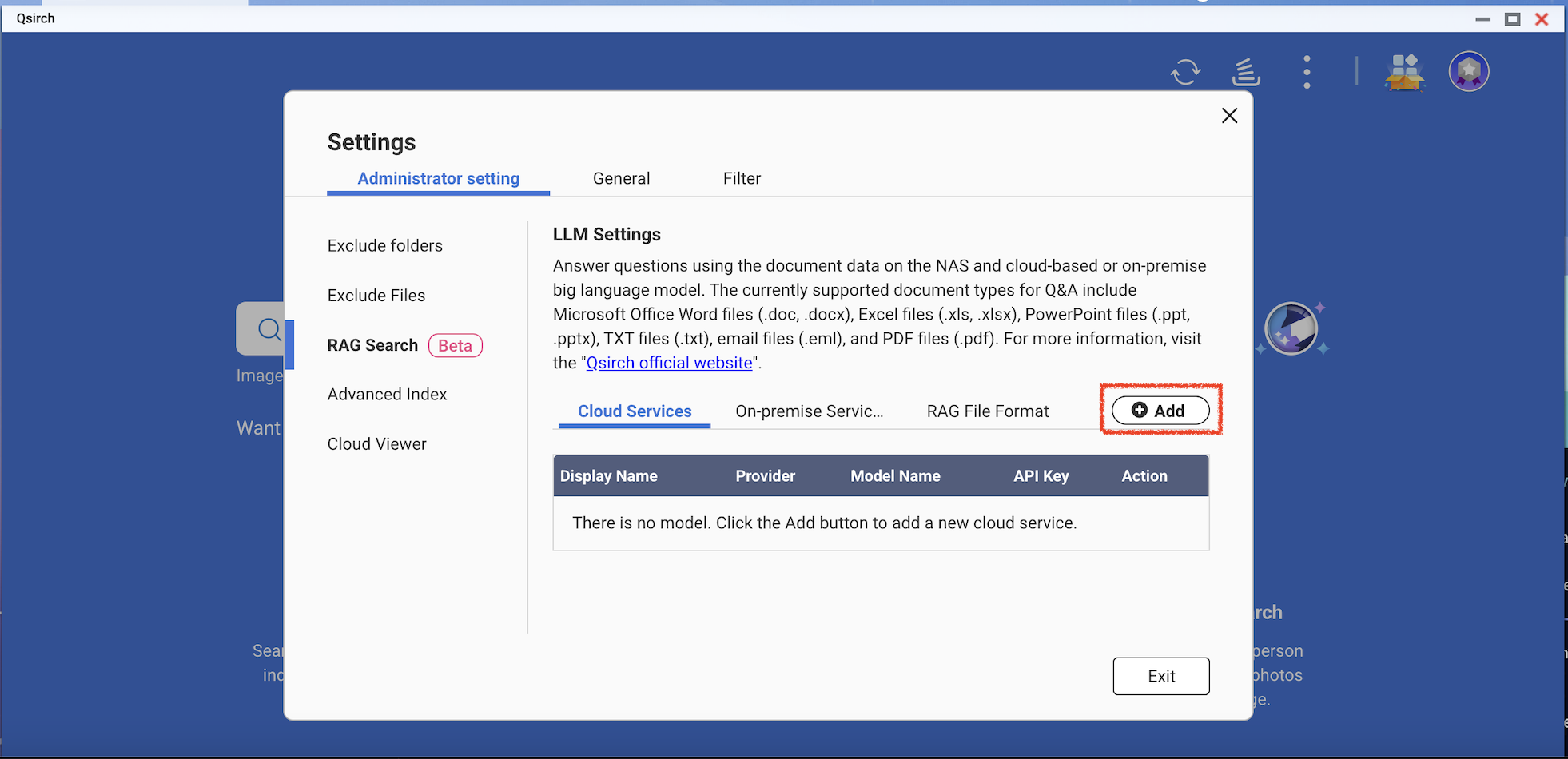

- Adicione um ou mais serviços de nuvem para usar a pesquisa RAG.

(Opcional) Verifique a sua chave de API. Isto ajuda a verificar se uma chave de API é válida.

Descarregue um ou mais modelos Edge dos serviços on-premise. Esta funcionalidade só pode ser utilizada nos modelos específicos de NAS.

- Adicione mais modelos de IA que sejam compatíveis com a API OpenAI, incluindo a série GPT, modelos DeepSeek e modelos Grok.

- Escolha formatos de ficheiro para a sua pesquisa RAG.

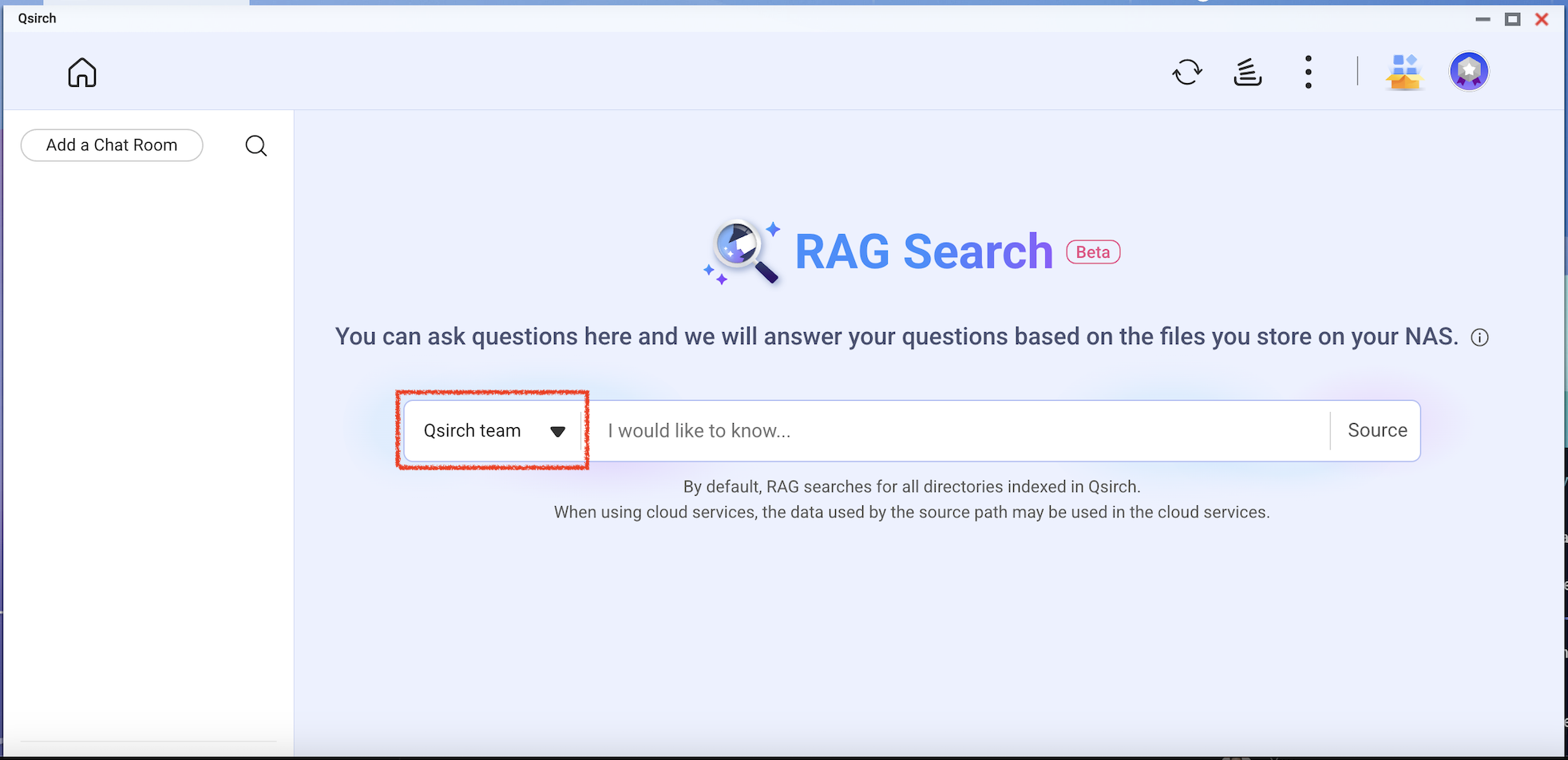

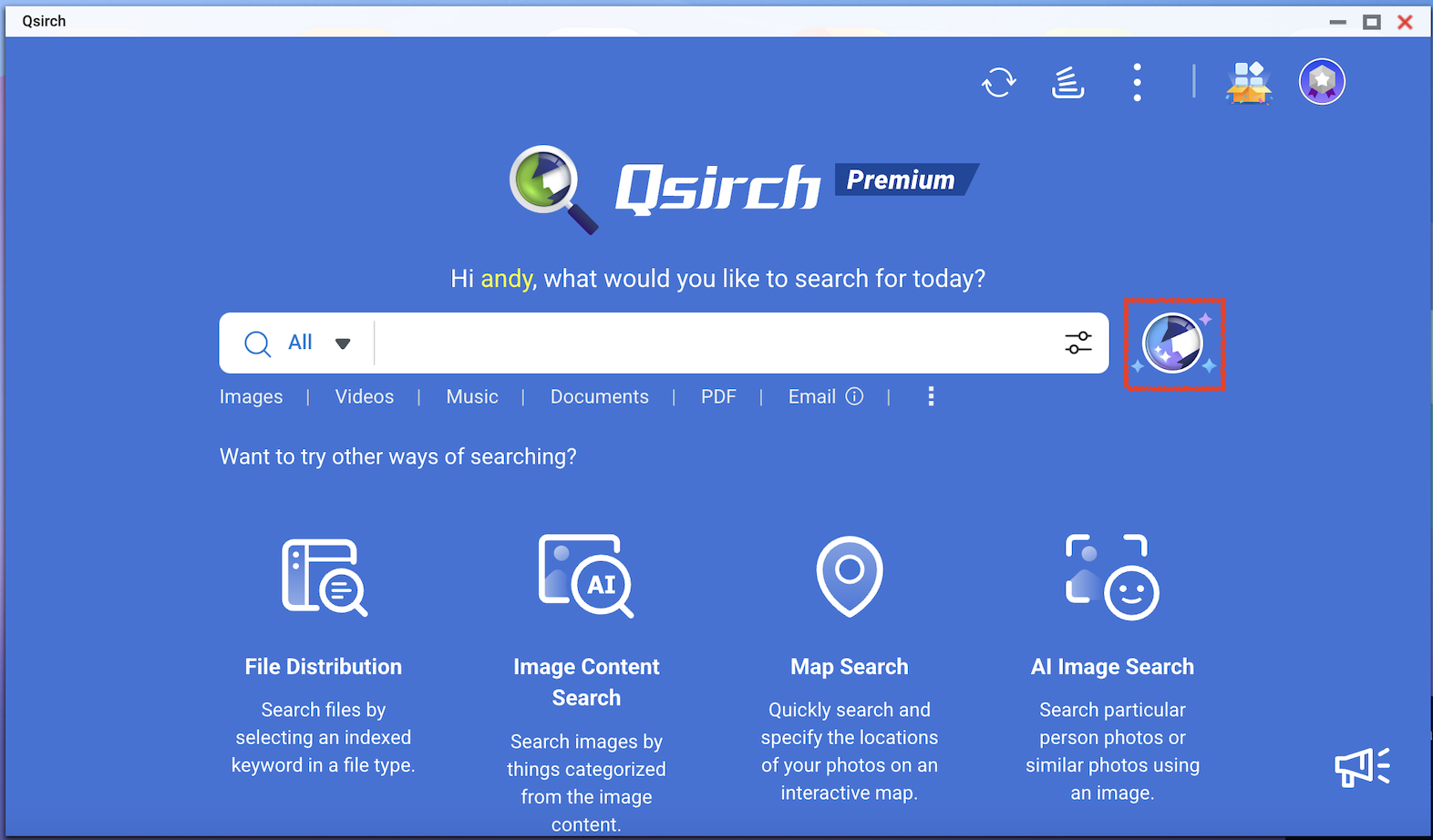

- Vá para a página inicial do Qsirch e clique no botão de pesquisa RAG.

A pesquisa RAG do Qsirch só utilizará os ficheiros incluídos em "Fonte" para a recuperação de dados.

Verifique o modelo que deseja usar e depois comece a usar a pesquisa RAG.