¿Cómo utilizar modelos de lenguaje grande para la búsqueda RAG de Qsirch?

Productos aplicables

Qsirch 6.0.0 (o posterior) en todas las plataformas

Búsqueda RAG de Qsirch con la nubey LLMs en las instalaciones

Qsirch admite el uso de Generación aumentada por recuperación (RAG) con modelos de lenguaje grandes (LLM) basados en la nube para ofrecer respuestas precisas y conscientes del contexto. Cuando introduces una consulta, Qsirch recupera documentos relevantes de tu NAS y los utiliza como contexto para el modelo de lenguaje. Esta combinación de búsqueda e IA generativa permite a Qsirch generar respuestas precisas e informadas basadas en tus propios datos.

Qsirch también admite conversaciones de múltiples turnos, lo que permite interacciones naturales y conscientes del contexto. Los usuarios pueden hacer preguntas de seguimiento sin repetir el contexto anterior, y el contexto se conserva a lo largo de los turnos para respuestas coherentes. El soporte para conversaciones de múltiples turnos funciona tanto con modos RAG en la nube como en las instalaciones.

Integrar RAG con servicios de IA basados en la nube

Para integrar la búsqueda RAG, primero debes obtener una clave API de un servicio de IA de tu elección.

ChatGPT (API de OpenAI)

ChatGPT (API de OpenAI) proporciona potentes modelos GPT tanto para incrustaciones RAG como para respuestas generativas. Sigue los pasos a continuación para solicitar una clave API:

- Regístrate para obtener una cuenta en OpenAI: https://auth.openai.com/create-account

- Crea una clave API en la configuración de la cuenta.

Para obtener más información, consulta Documentación de la API de OpenAI.

Azure OpenAI

Azure OpenAI proporciona acceso a modelos de OpenAI (como GPT-4.1) a través de la infraestructura de Azure, lo cual es ideal para soluciones empresariales. Sigue los pasos a continuación para solicitar una clave API:

- Inicia sesión en el Portal de Azure .

- Selecciona tu recurso de OpenAI (o crea uno si aún no tienes uno).

- En el menú de la izquierda, haz clic en Claves y punto final.

- Copia una clave API y copia el punto final (URL base) para solicitudes de API.

Para obtener más información, consulta Documentación de Azure OpenAI.

Gemini (Google Cloud AI)

Gemini (Google Cloud AI) proporciona un conjunto de modelos diseñados para razonamiento de alto rendimiento y RAG. Sigue los pasos a continuación para solicitar una clave API:

- Visita el Documentación de la API de Google Gemini.

- Obtén una clave API de Gemini en Google AI Studio.

- Inicia sesión en tu cuenta de Google.

- Haz clic en Crear clave API.

Para obtener más información, consulta Documentación de Google Cloud AI.

API Compatible con OpenAI

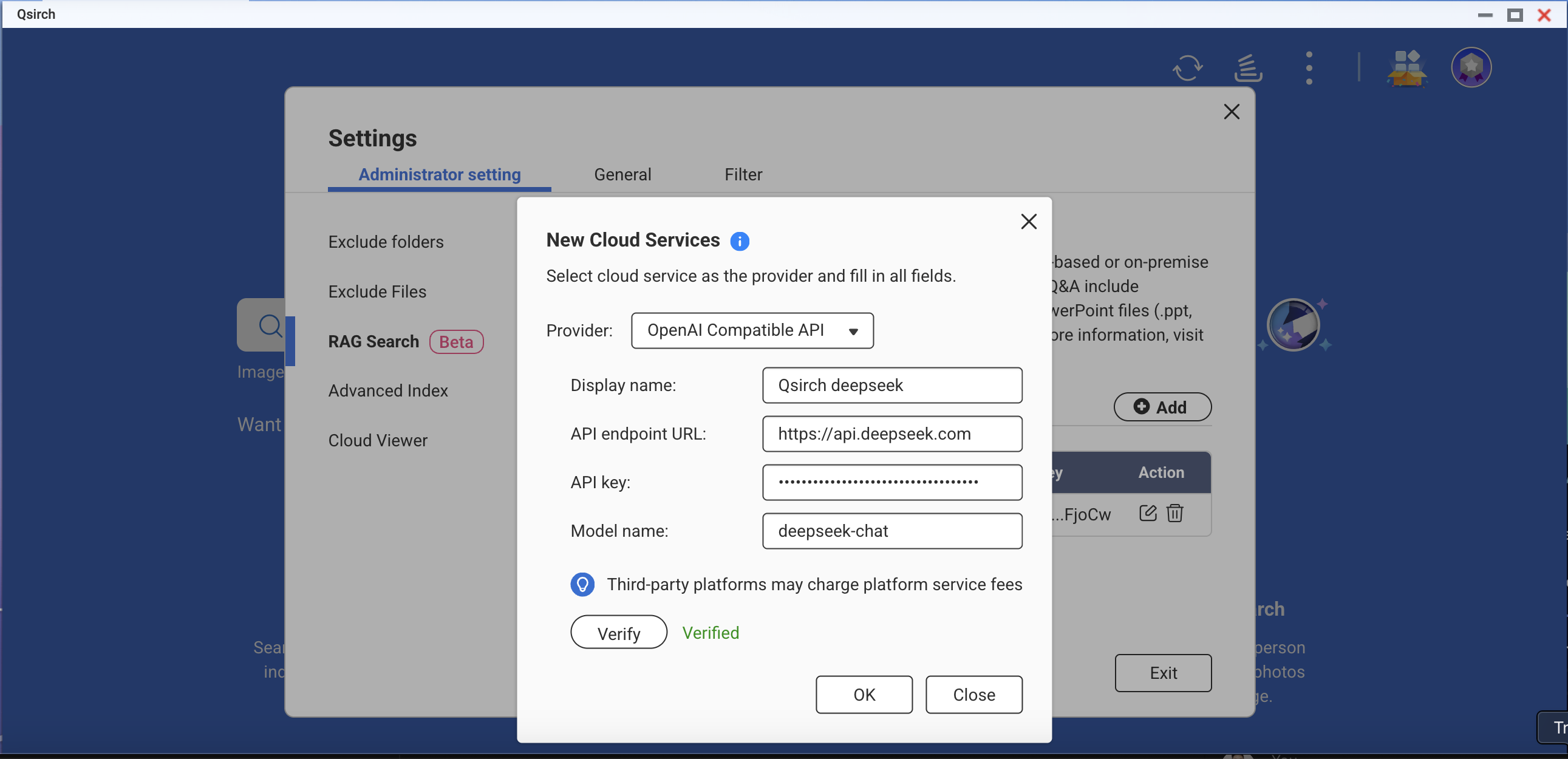

La API compatible con OpenAI permite a los usuarios acceder a varios modelos de IA más allá de las ofertas propias de OpenAI, incluidos modelos como DeepSeek y Grok, utilizando el mismo formato de API. Esto permite una integración sin problemas con aplicaciones existentes construidas para la API de OpenAI. Siga los pasos a continuación para solicitar una clave API:

- Elija un proveedor que admita la API compatible con OpenAI (por ejemplo, DeepSeek o Grok).

- Regístrese en la plataforma del proveedor.

- Genere una clave API en la configuración de la cuenta.

- Actualice su punto final de API y la configuración del modelo según sea necesario.

Para más información, consulte la documentación oficial de la API del proveedor.

Búsqueda RAG en las instalaciones

Para habilitar la búsqueda RAG en las instalaciones:

- Asegúrese de que el núcleo LLM esté listo.

- Configure la GPU en modo Container Station (Vaya a Panel de control > Hardware > Recursos de hardware > Uso de recursos > modo Container Station ).

Cómo usar la búsqueda RAG en Qsirch

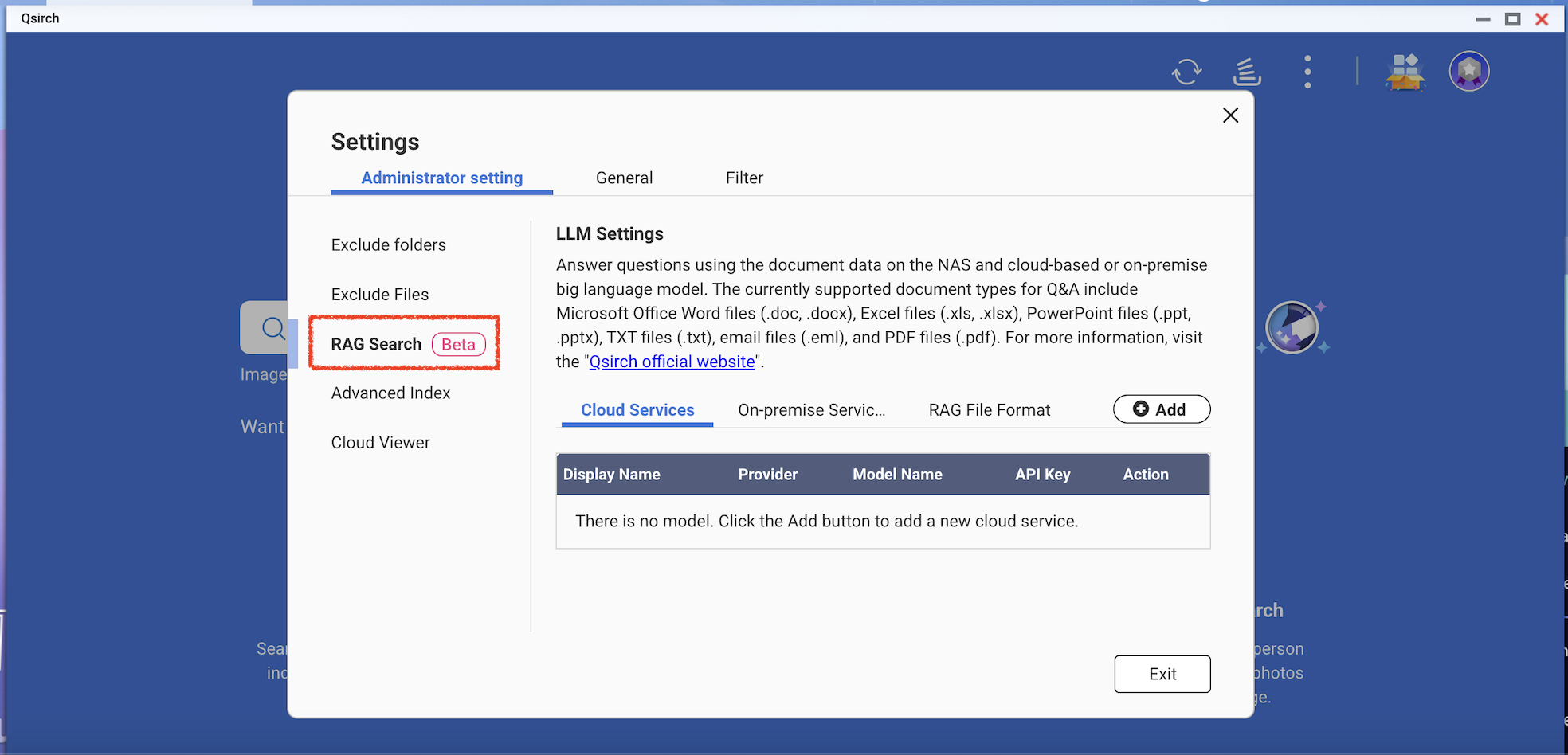

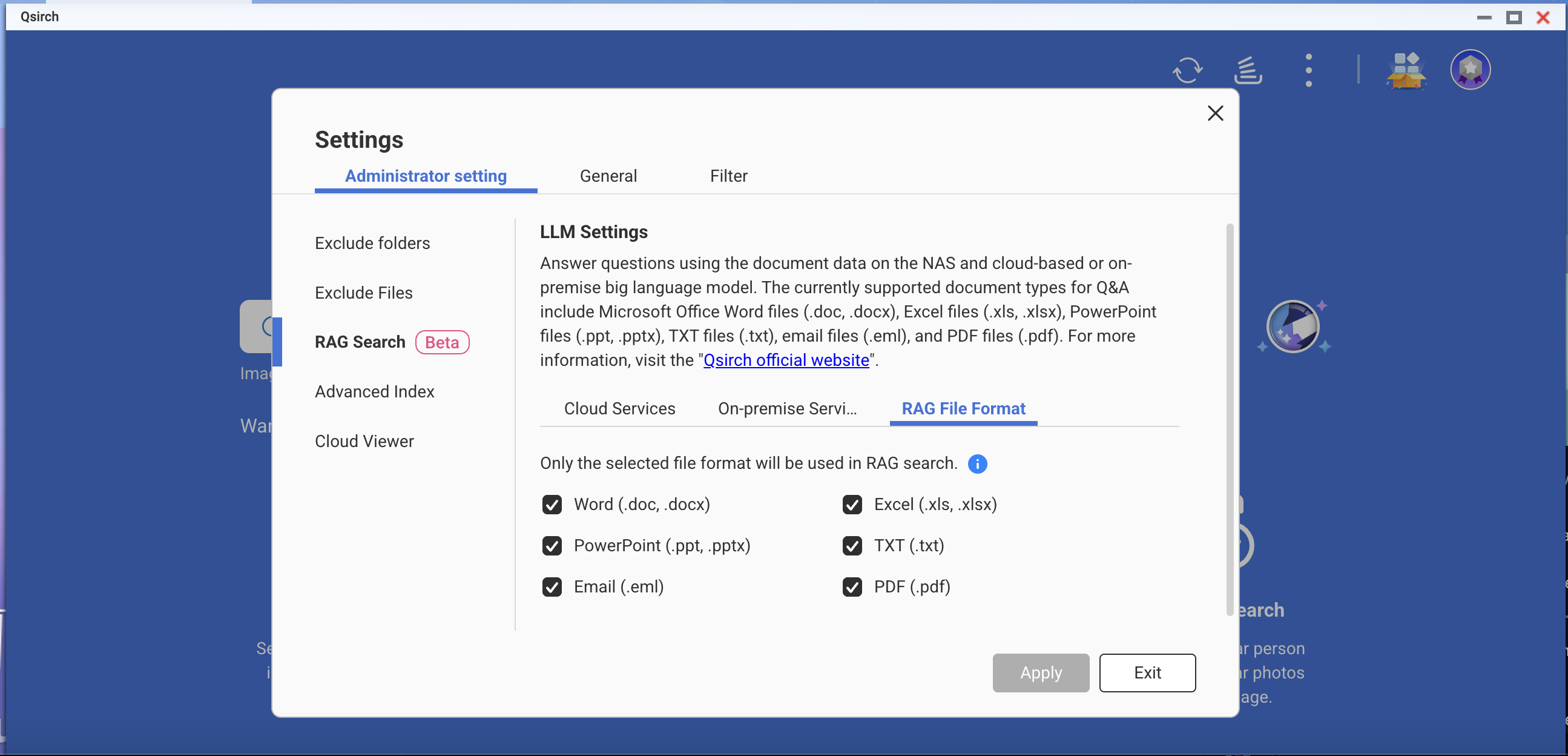

- Vaya a Configuración > Configuración administrativa > Búsqueda RAG.

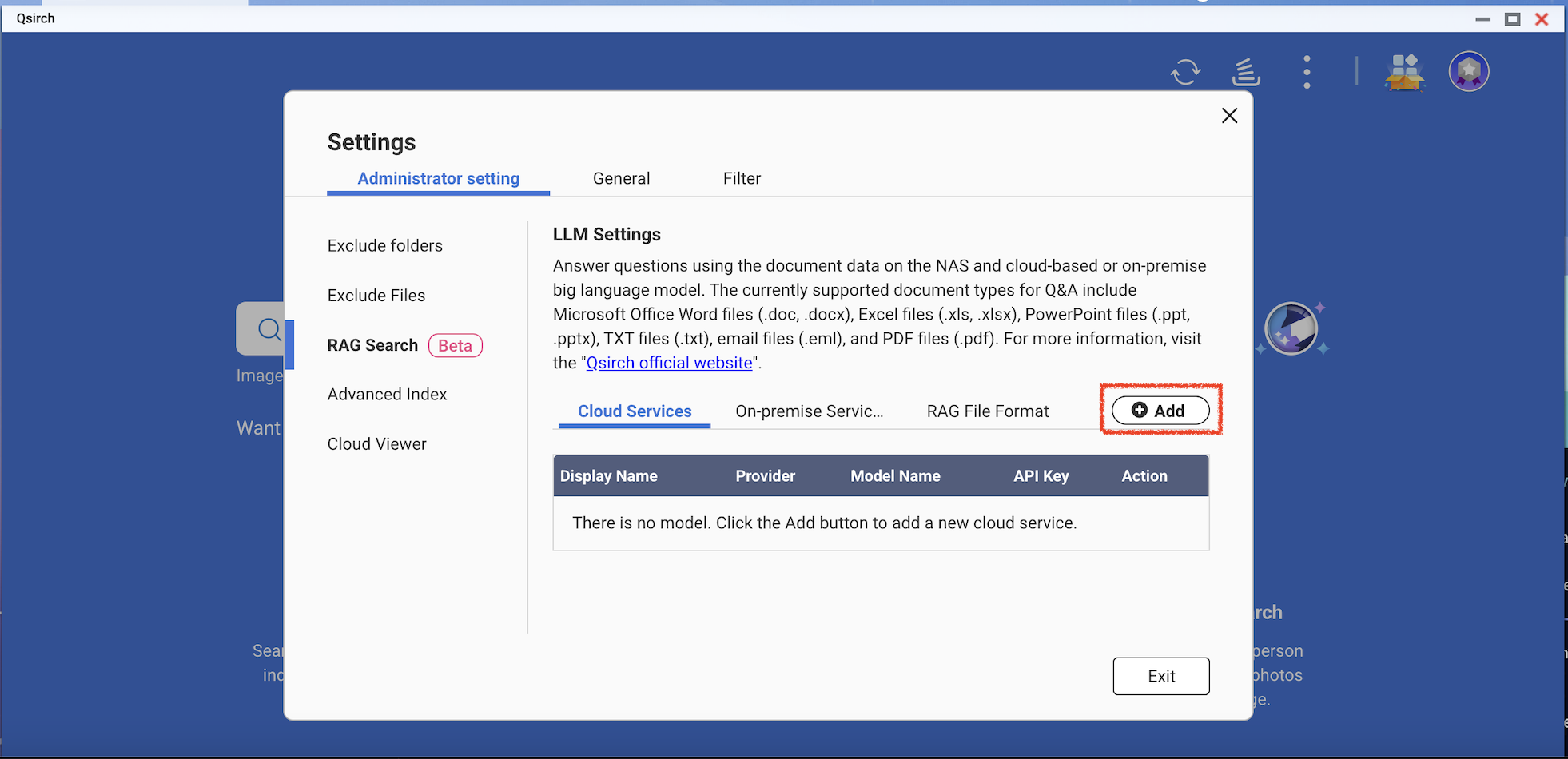

- Agregue uno o más servicios en la nube para usar la búsqueda RAG.

(Opcional) Verifique su clave API. Esto ayuda a comprobar si una clave API es válida.

Descargue uno o más modelos de Edge de los servicios en las instalaciones. Esta función solo se puede usar en modelos específicos de NAS.

- Agregue más modelos de IA que sean compatibles con la API de OpenAI, incluidos los modelos de la serie GPT, modelos de DeepSeek y modelos de Grok.

- Elija formatos de archivo para su búsqueda RAG.

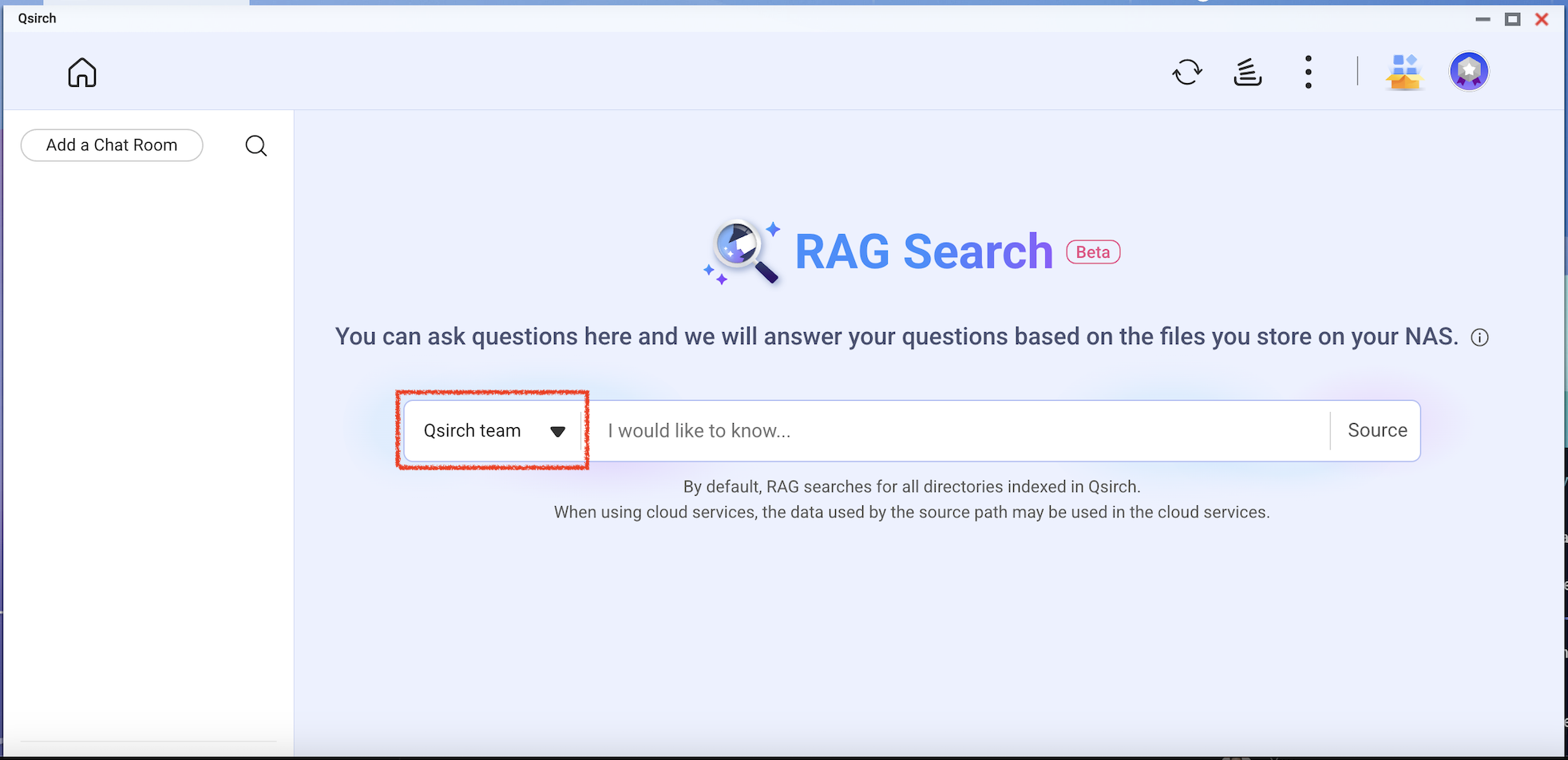

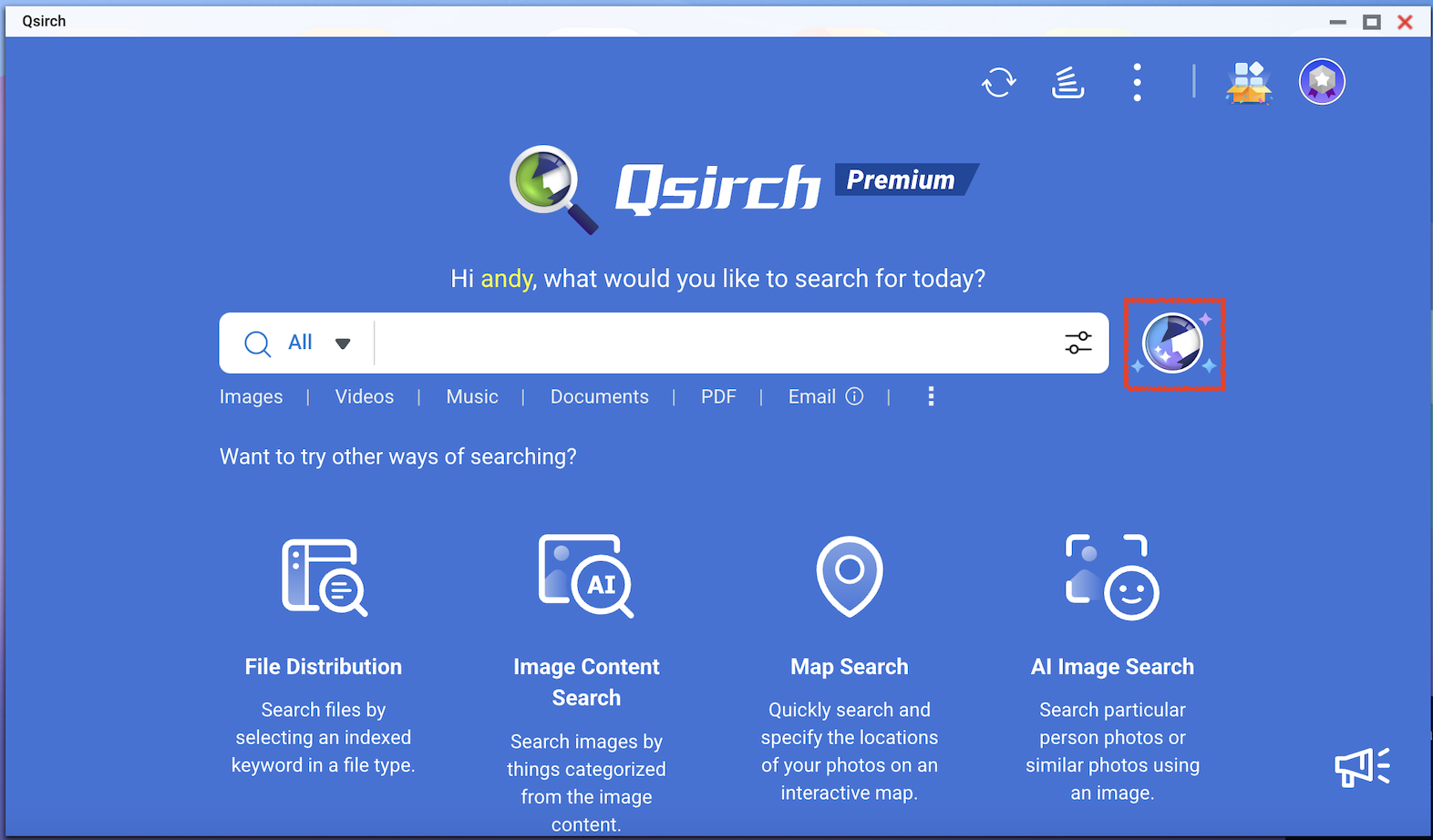

- Vaya a la página de inicio de Qsirch y haga clic en el botón de búsqueda RAG.

La búsqueda RAG de Qsirch solo utilizará los archivos incluidos en "Fuente" para la recuperación de datos.

Verifique el modelo que desea usar y luego comience a usar la búsqueda RAG.