Applicable Products

Qsirch 6.0.0 (or later) on all platforms

Qsirch RAG Search with Cloud and On-Premise LLMs

Qsirch supports using Retrieval-Augmented Generation (RAG) with cloud-based large language models (LLMs) to deliver accurate and context-aware responses. When you enter a query, Qsirch retrieves relevant documents from your NAS and uses them as context for the language model. This combination of search and generative AI enables Qsirch to generate precise and informed answers based on your own data.

Qsirch also supports multi-turn conversation, enabling natural and context-aware interactions. Users can ask follow-up questions without repeating prior context, and context is preserved across turns for coherent answers. Multi-turn conversation support works with both cloud and on-premise RAG modes.

Integrate RAG with Cloud-based AI Services

To integrate RAG search, you must first obtain an API key from an AI service of your choice.

ChatGPT (OpenAI API)

ChatGPT (OpenAI API) provides powerful GPT models for both RAG embeddings and generative responses. Follow the steps below to apply for an API key:

- Sign up for an account on OpenAI: https://auth.openai.com/create-account

- Create an API key in the account settings.

For more information, see OpenAI API Documentation.

Azure OpenAI

Azure OpenAI provides access to OpenAI models (like GPT-4.1) via Azure infrastructure, which is ideal for enterprise solutions. Follow the steps below to apply for an API key:

- Sign in to the Azure Portal.

- Select your OpenAI resource (or create one if you do not already have one).

- On the left menu, click Keys and Endpoint.

- Copy an API key and copy the endpoint (base URL) for API requests.

For more information, see Azure OpenAI Documentation.

Gemini (Google Cloud AI)

Gemini (Google Cloud AI) provides a set of models designed for high-performance reasoning and RAG. Follow the steps below to apply for an API key:

- Visit the Google Gemini API Documentation.

- Get a Gemini API key in Google AI Studio.

- Sign in to your Google account.

- Click Create API key.

For more information, see Google Cloud AI Documentation.

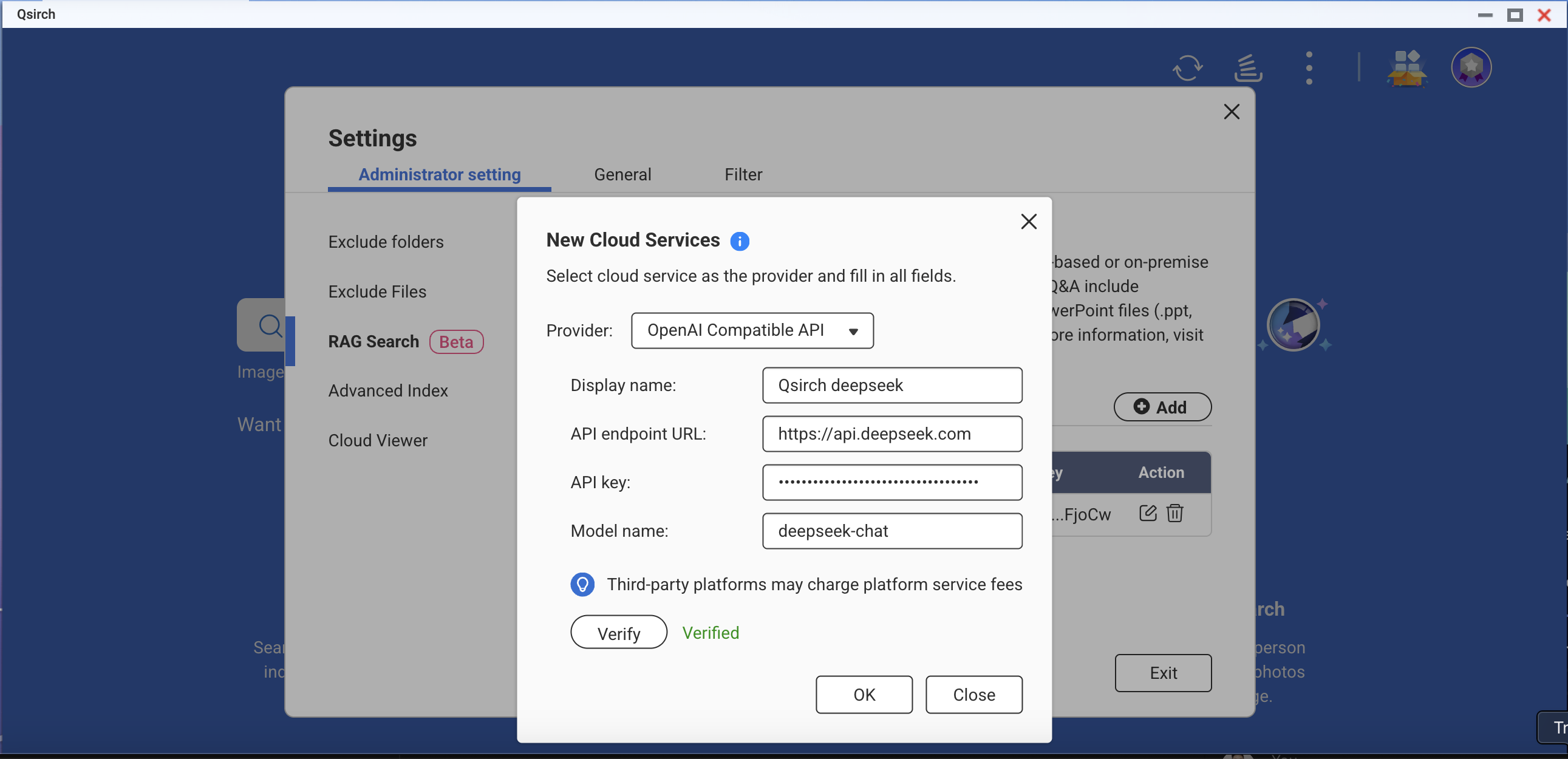

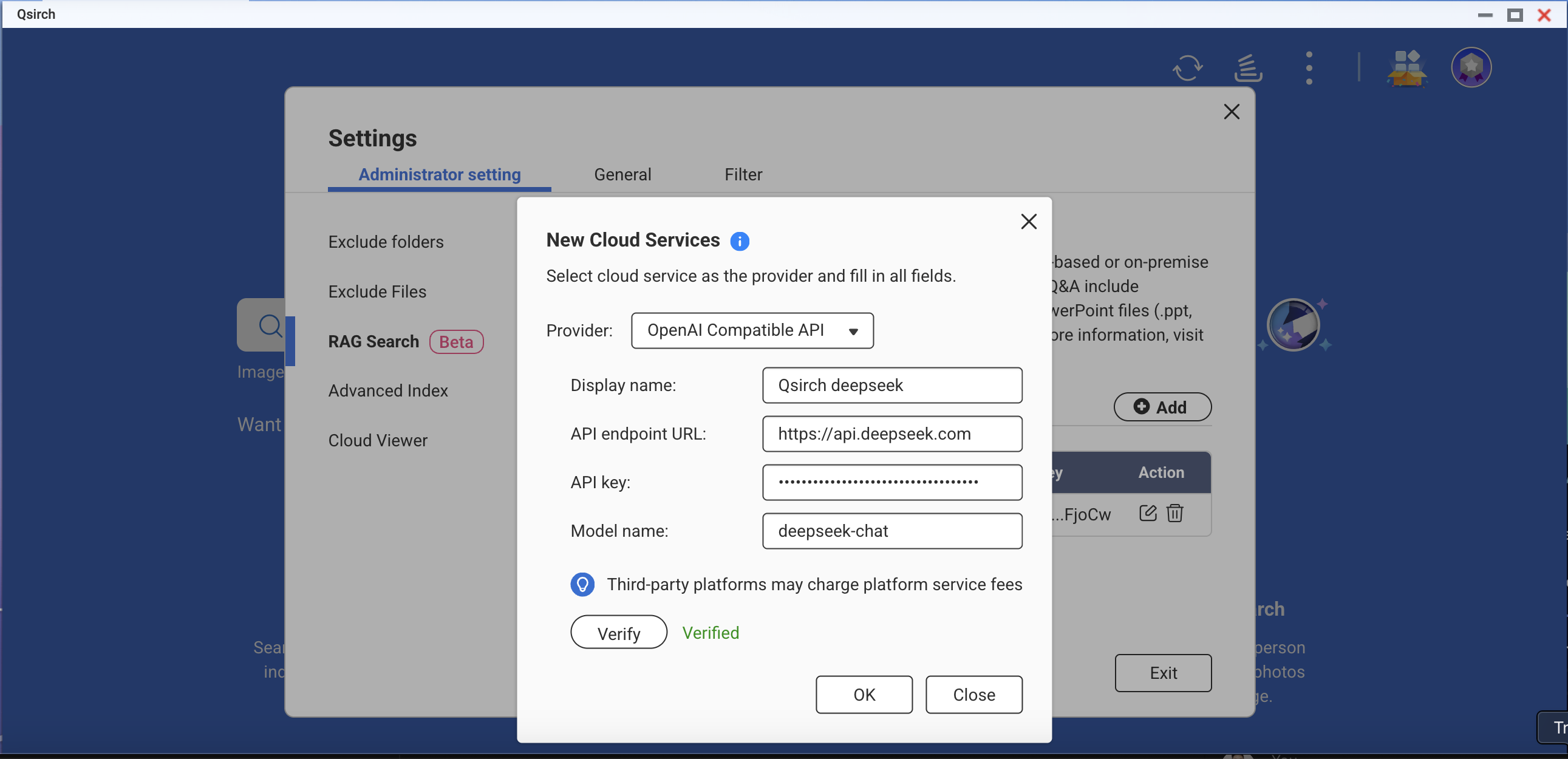

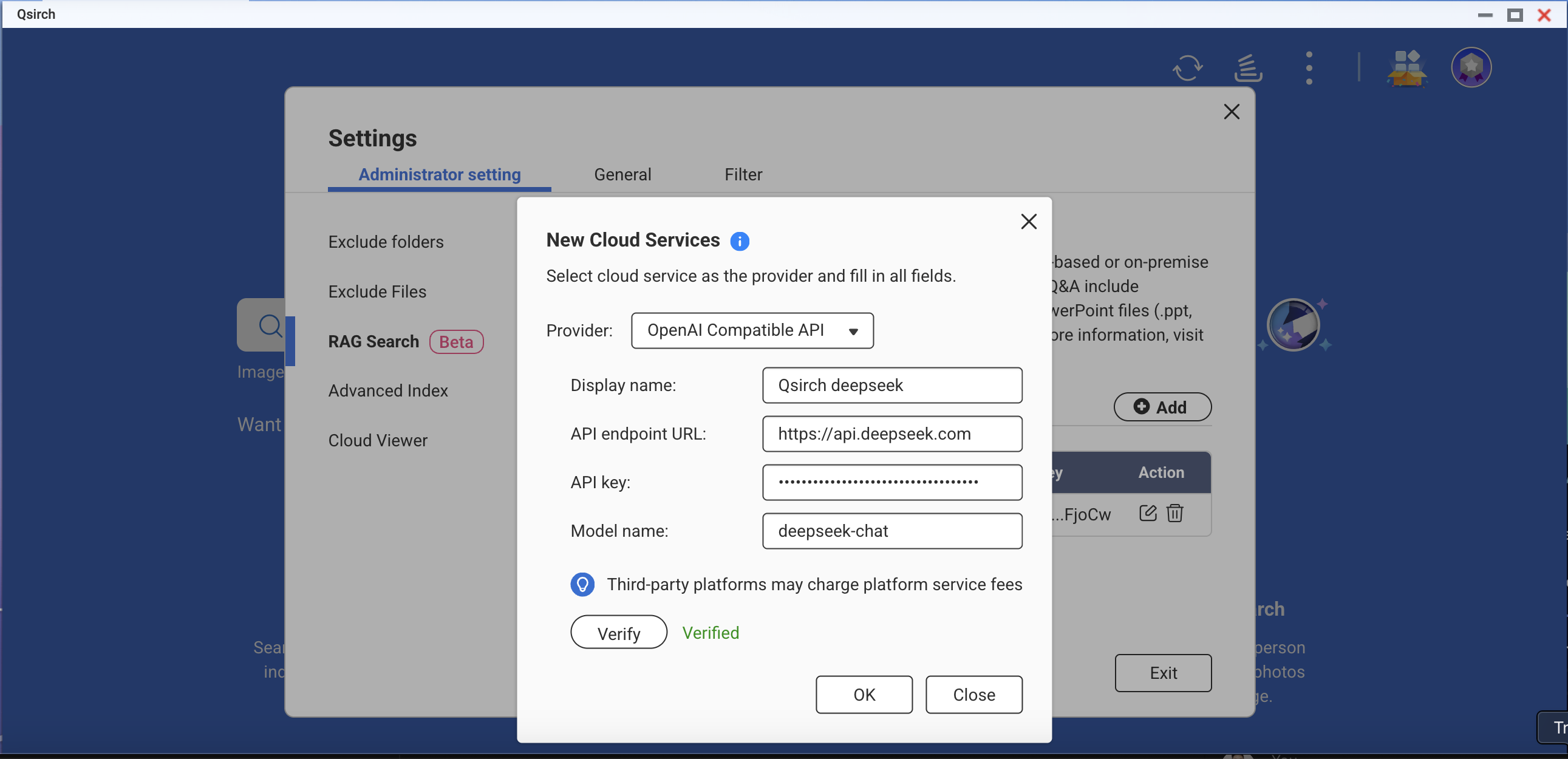

OpenAI-Compatible API

OpenAI Compatible API allows users to access various AI models beyond OpenAI’s own offerings, including models like DeepSeek and Grok, using the same API format. This enables seamless integration with existing applications built for OpenAI API. Follow the steps below to apply for an API key:

- Choose a provider that supports OpenAI-compatible API (for example, DeepSeek or Grok).

- Sign up on the provider's platform.

- Generate an API key in the account settings.

- Update your API endpoint and model settings as required.

For more information, refer to the provider's official API documentation.

On-Premise RAG Search

For advanced users and enterprises who require full data privacy or offline AI capabilities, Qsirch offers on-premise RAG search powered by locally hosted LLMs. This mode runs entirely on your NAS or connected hardware, without sending data to external services.

To enable on-premise RAG:

- Ensure that the LLM Core is ready.

- Set the GPU to Container Station mode (Go to Control Panel > Hardware > Hardware Resources > Resource Use > Container Station mode).

How to Use RAG Search in Qsirch

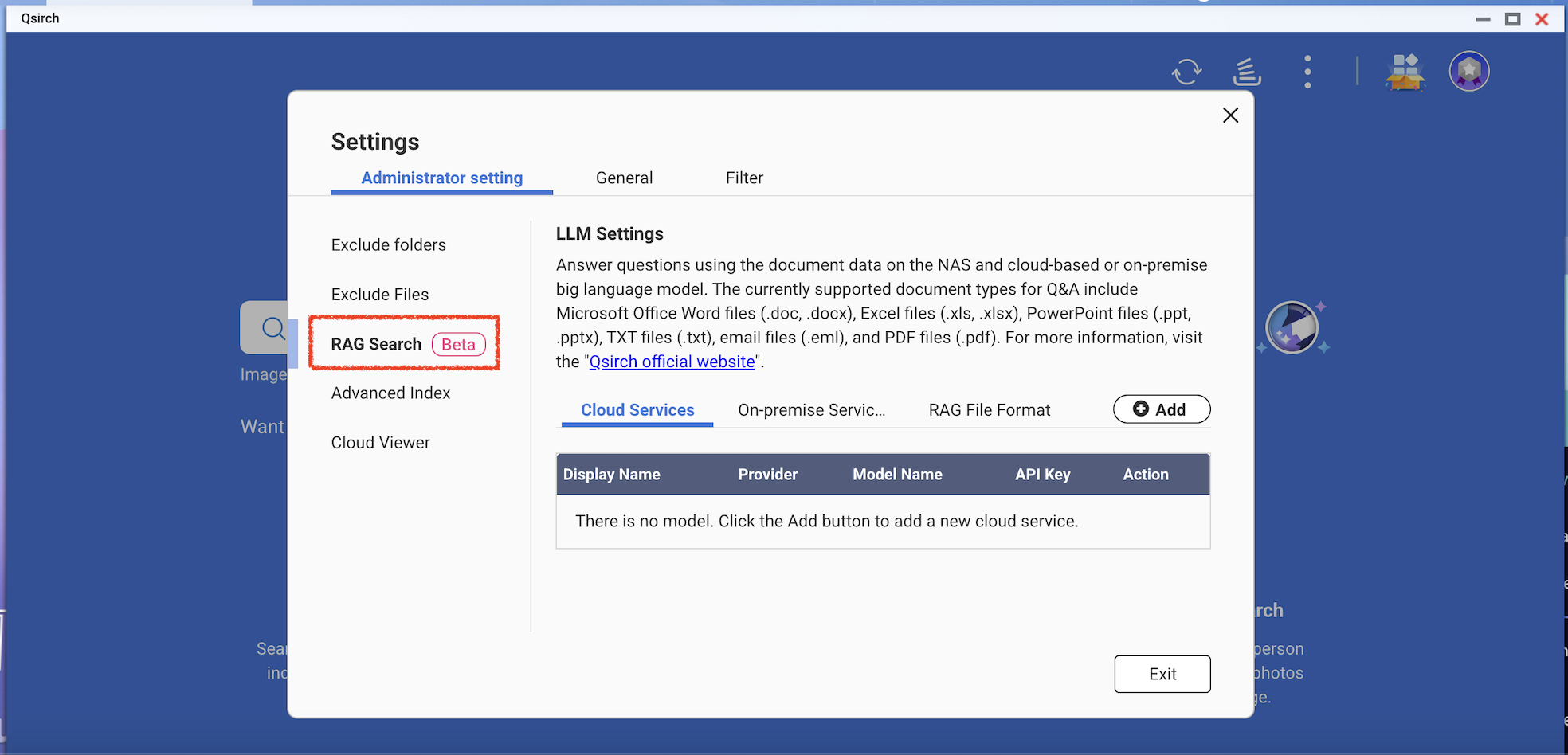

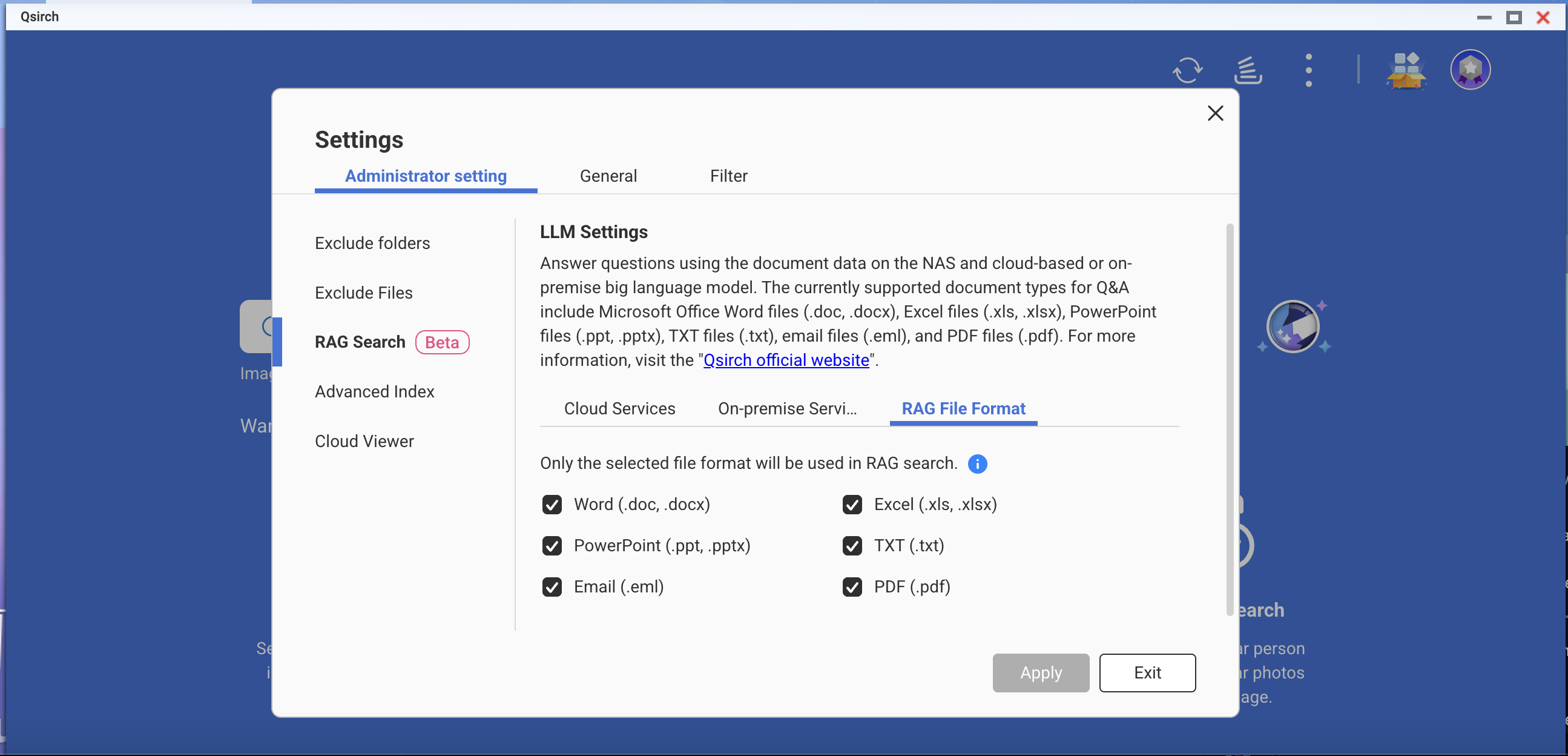

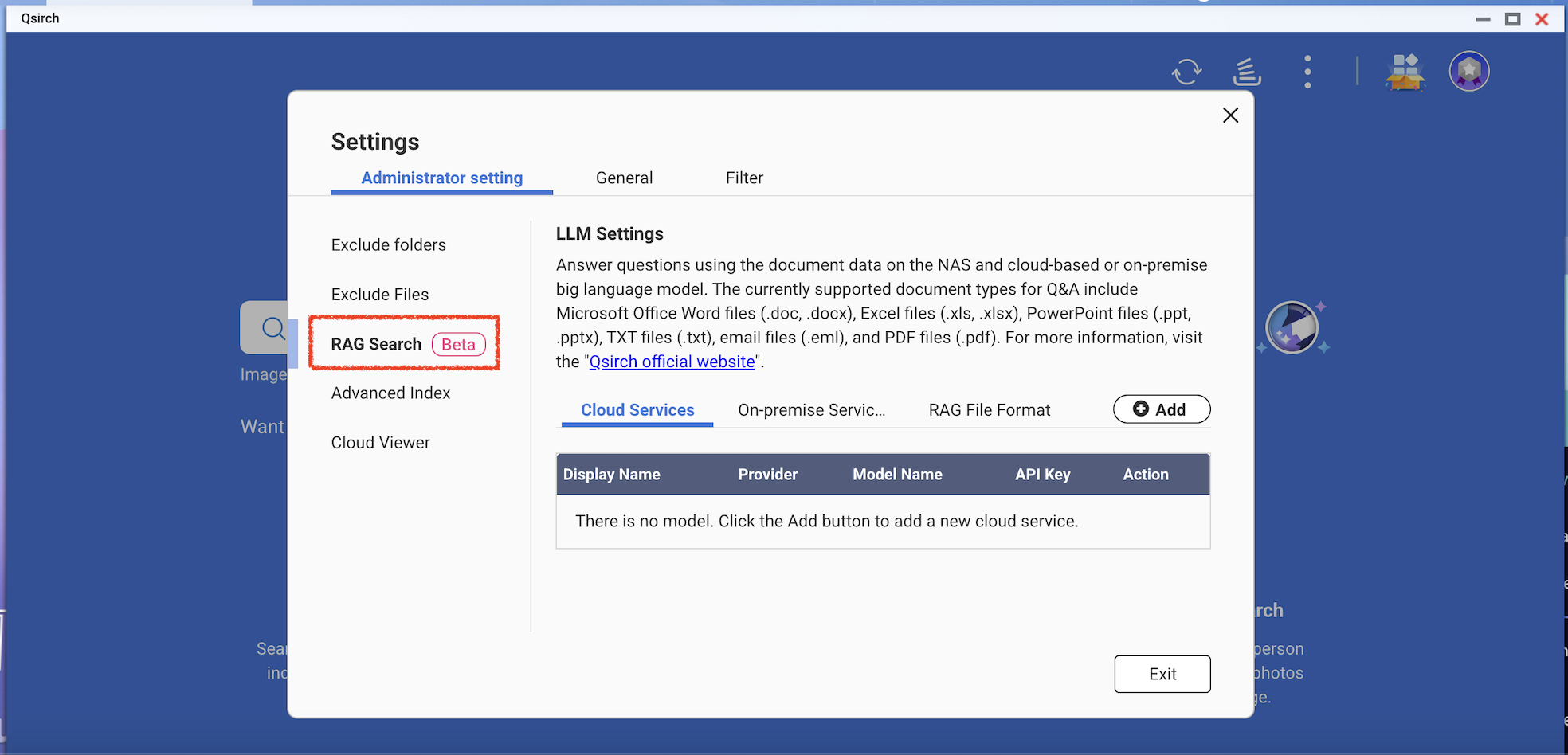

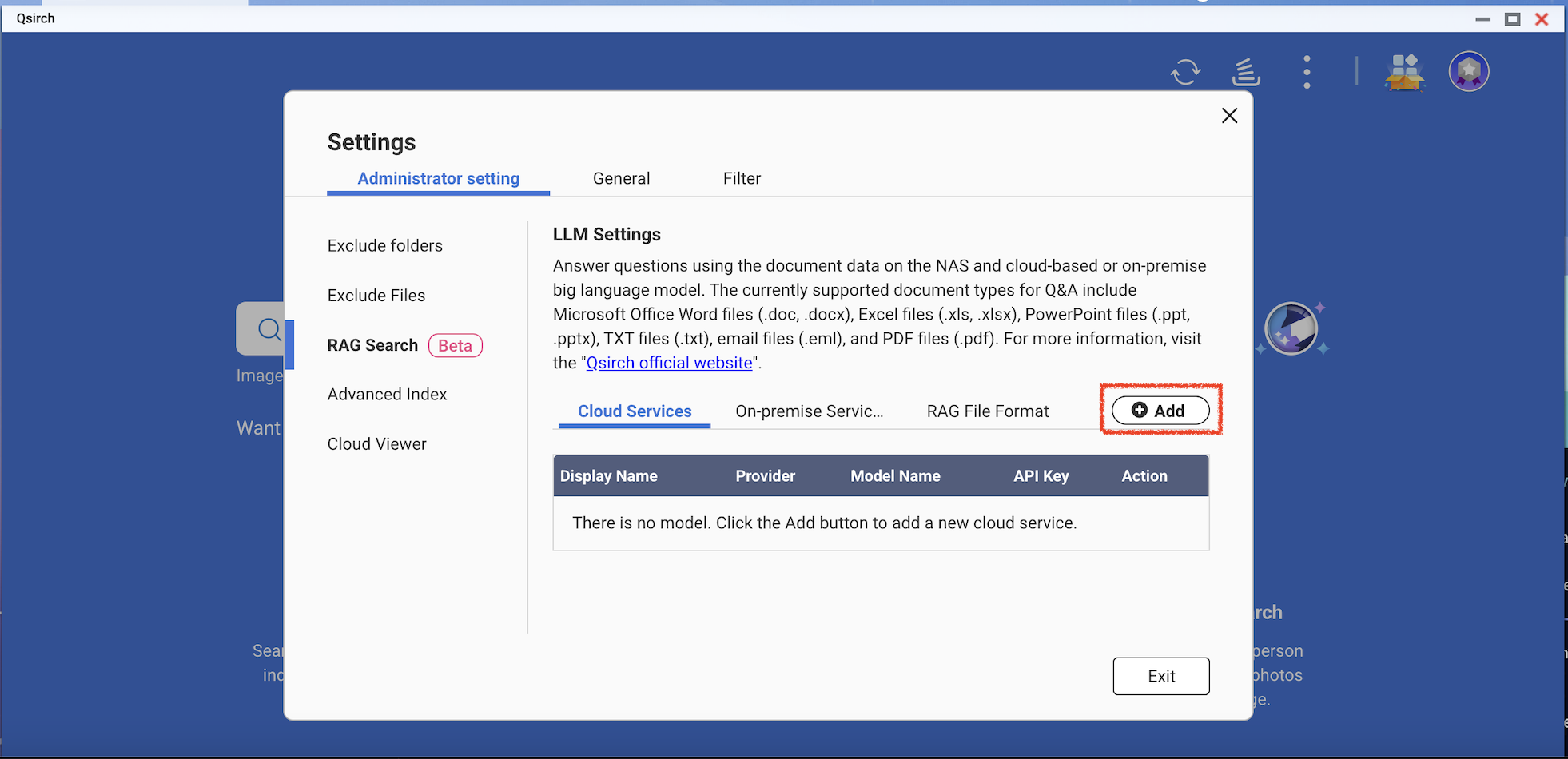

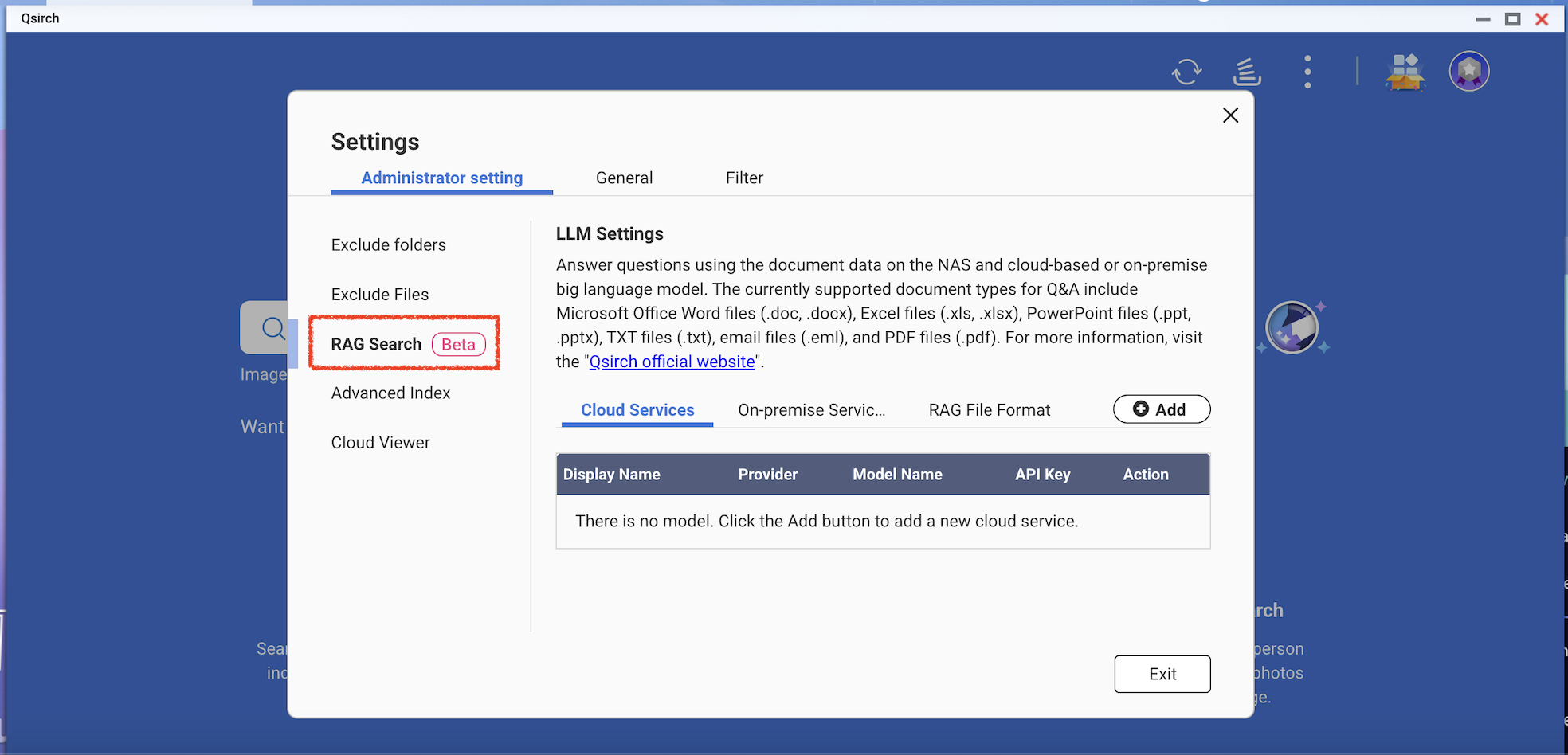

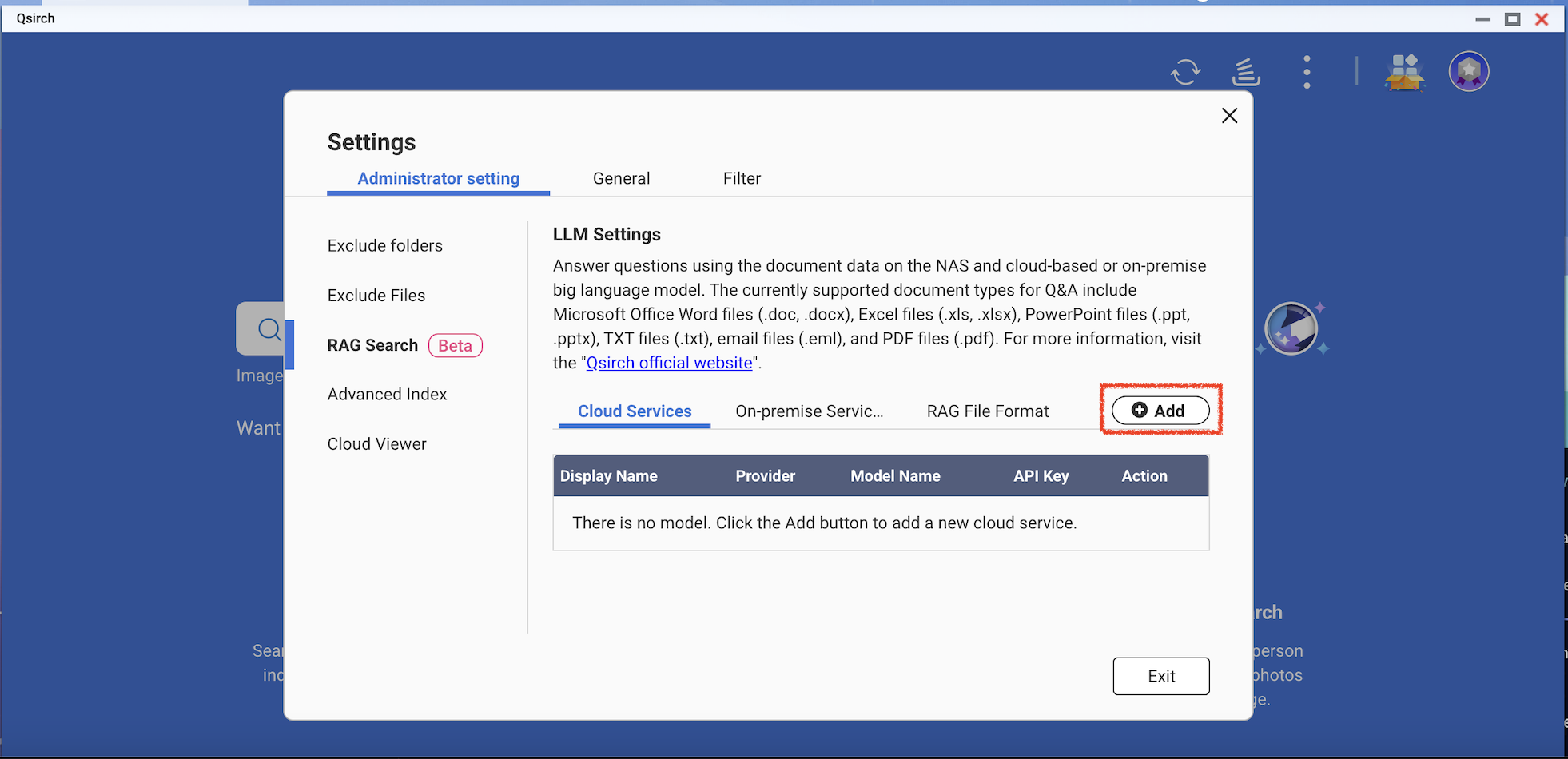

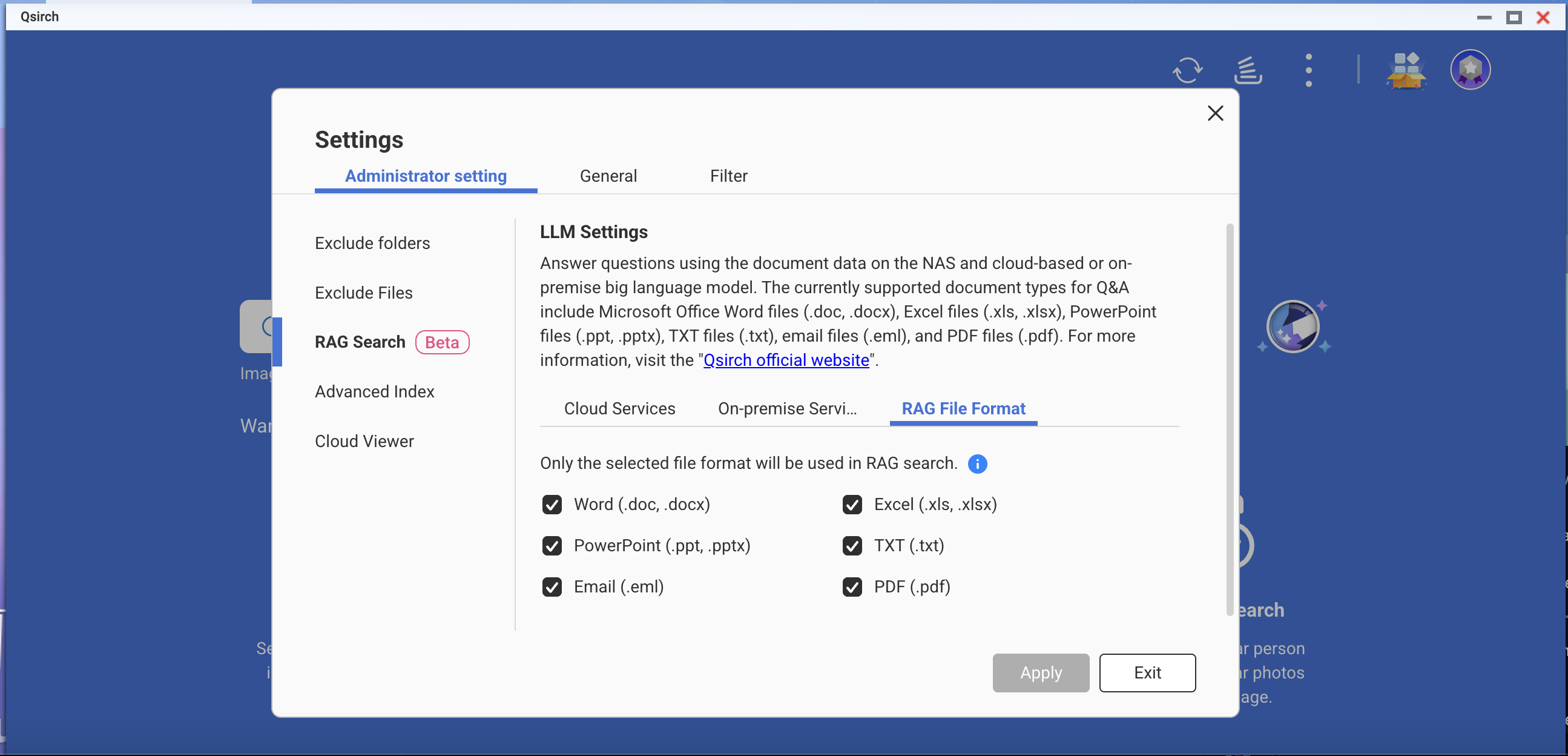

- Go to Settings > Administrative setting > RAG Search.

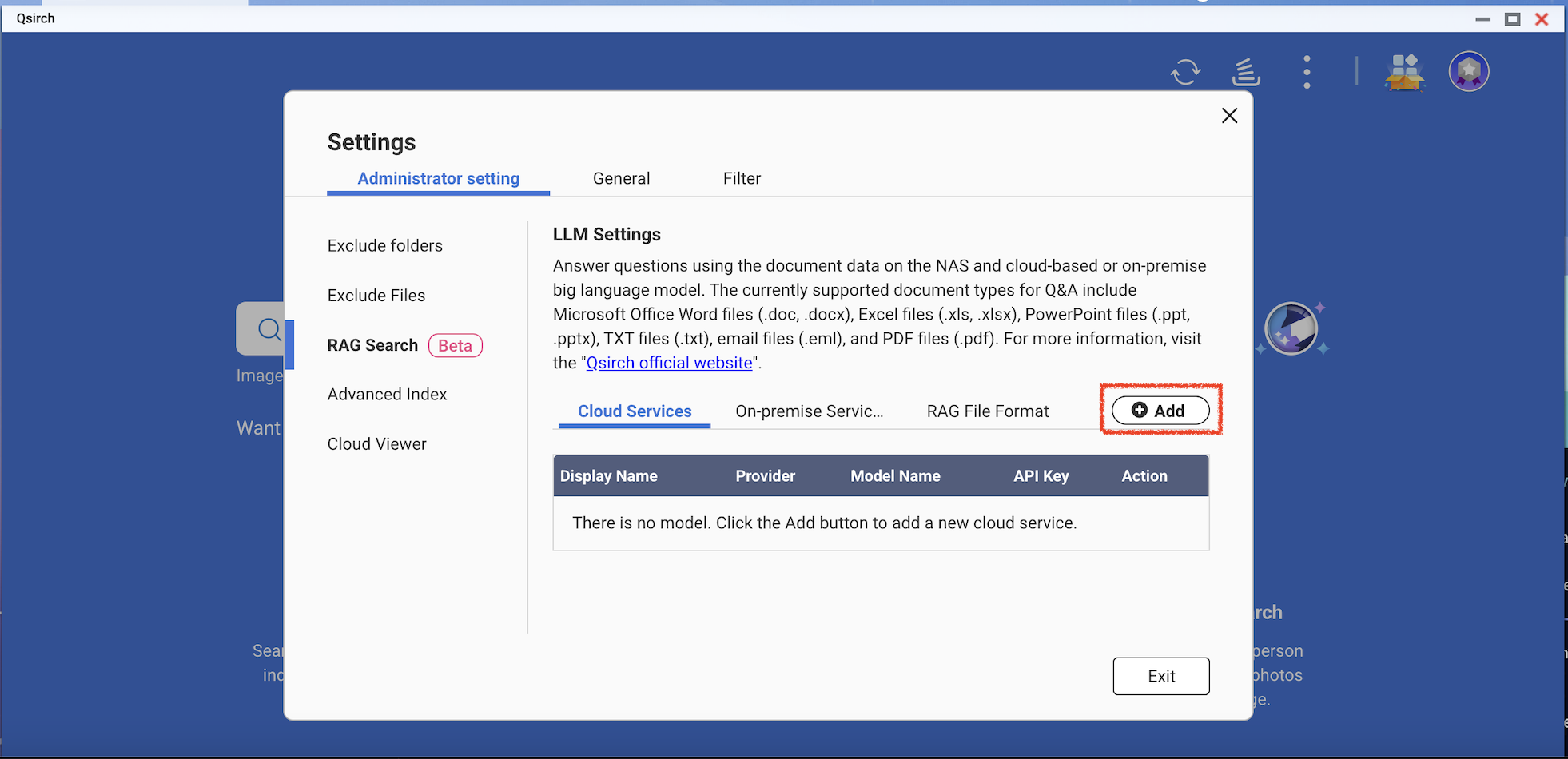

- Add one or more cloud services to use RAG search.

(Optional) Verify your API key. This helps check whether an API key is valid.

Download one or more edge models from the on-premise services. This feature can only be used on the specific NAS models.

- Add more AI models that are compatible with OpenAI API, including the GPT series, DeepSeek models, and Grok models.

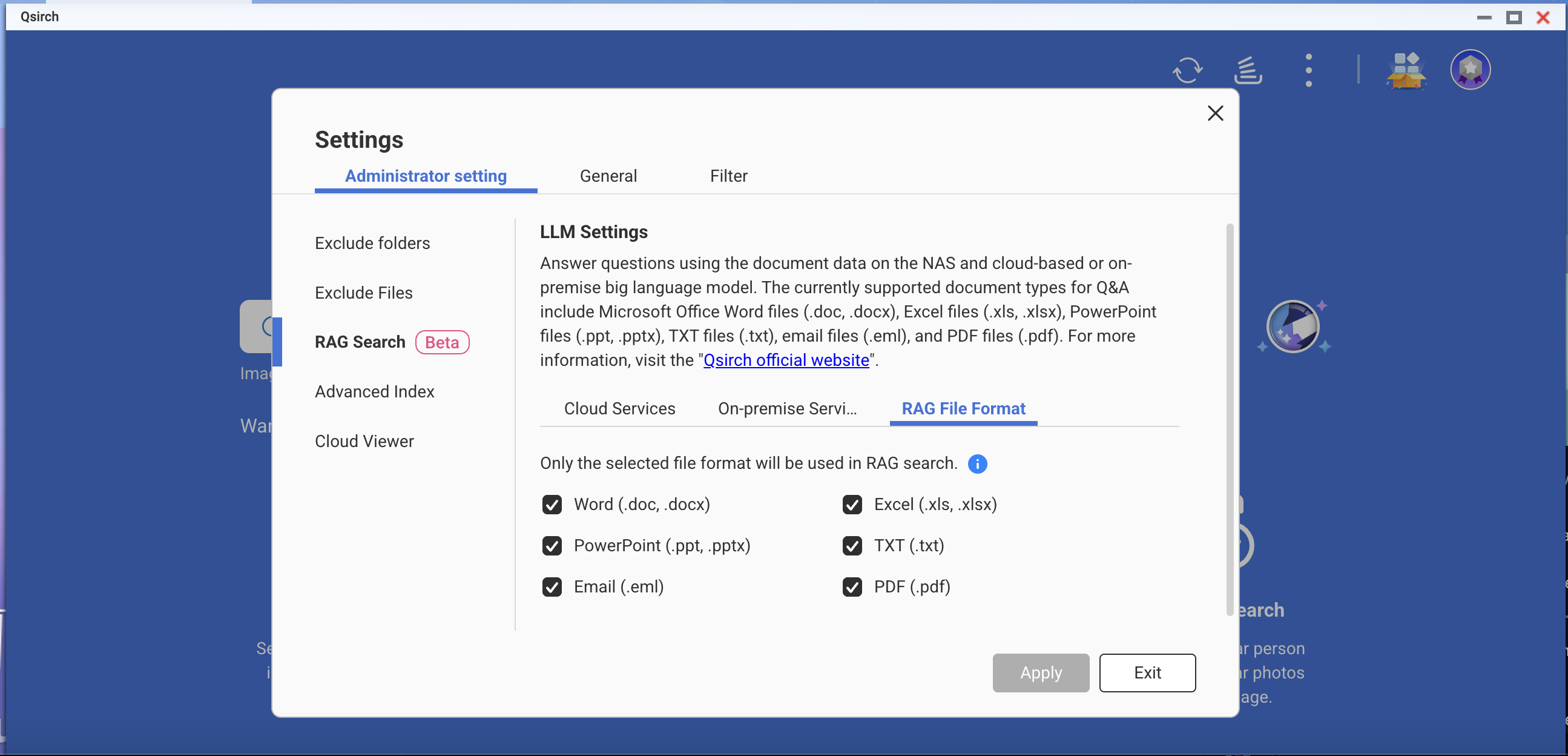

- Choose file formats for your RAG search.

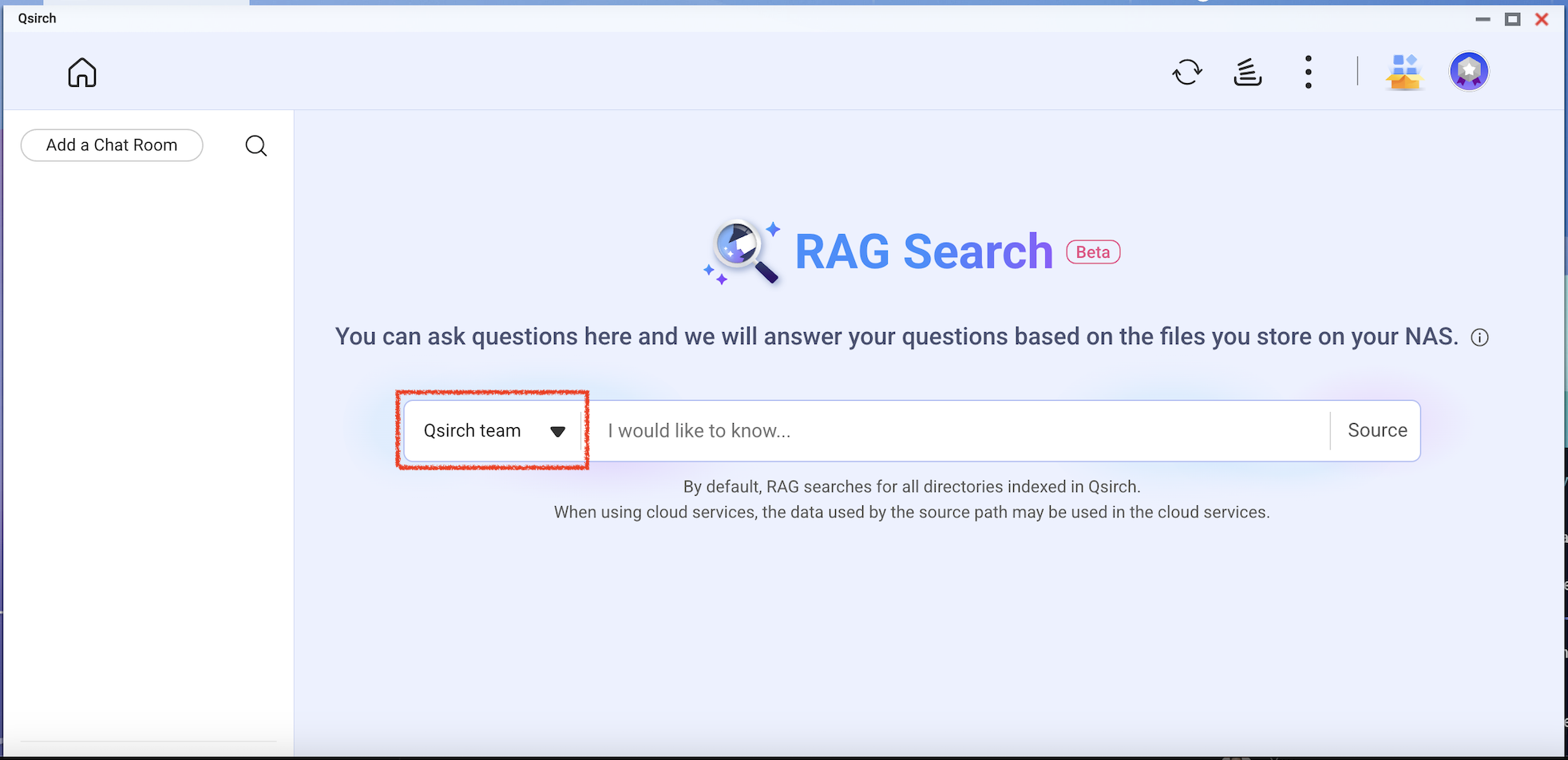

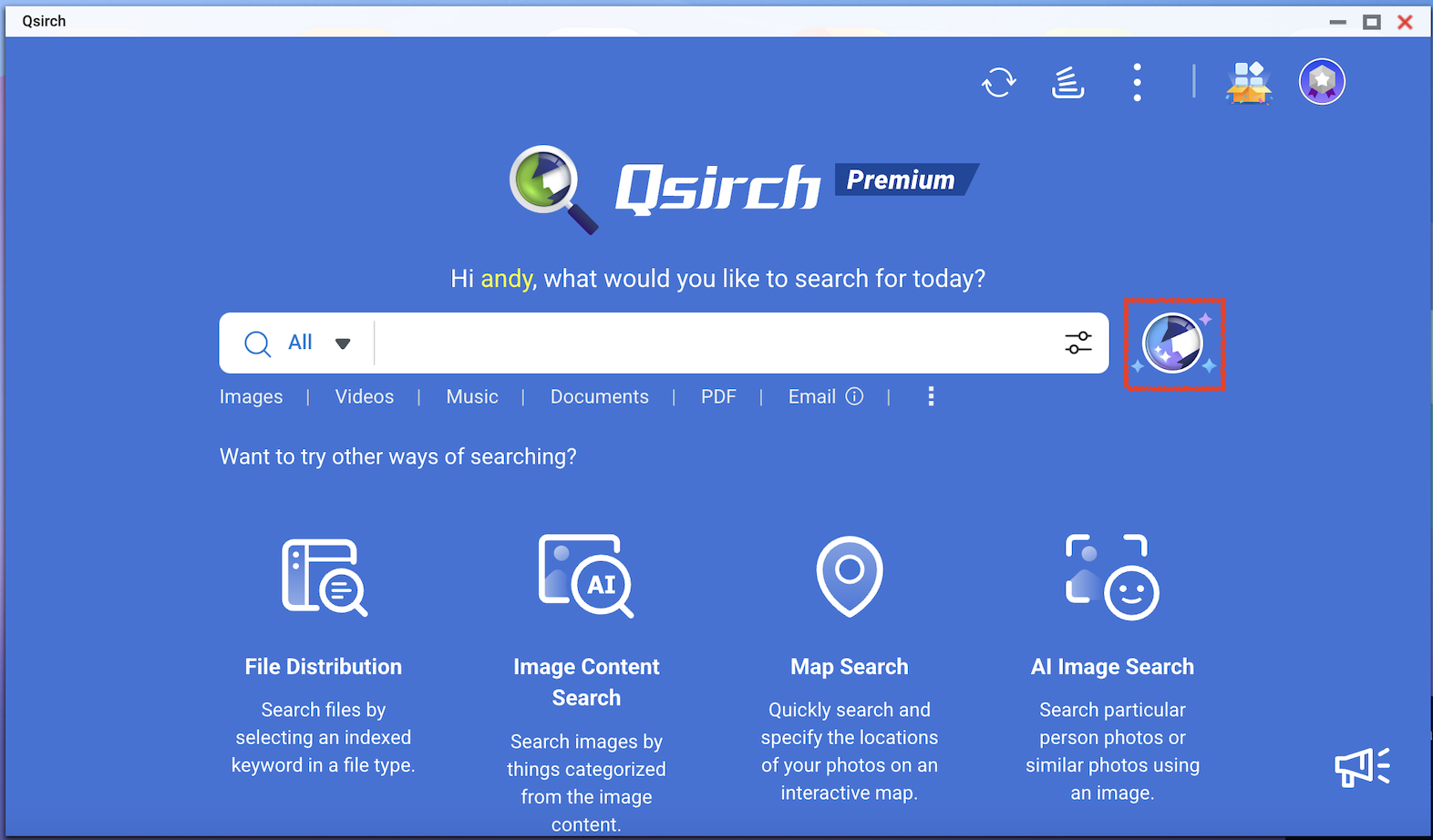

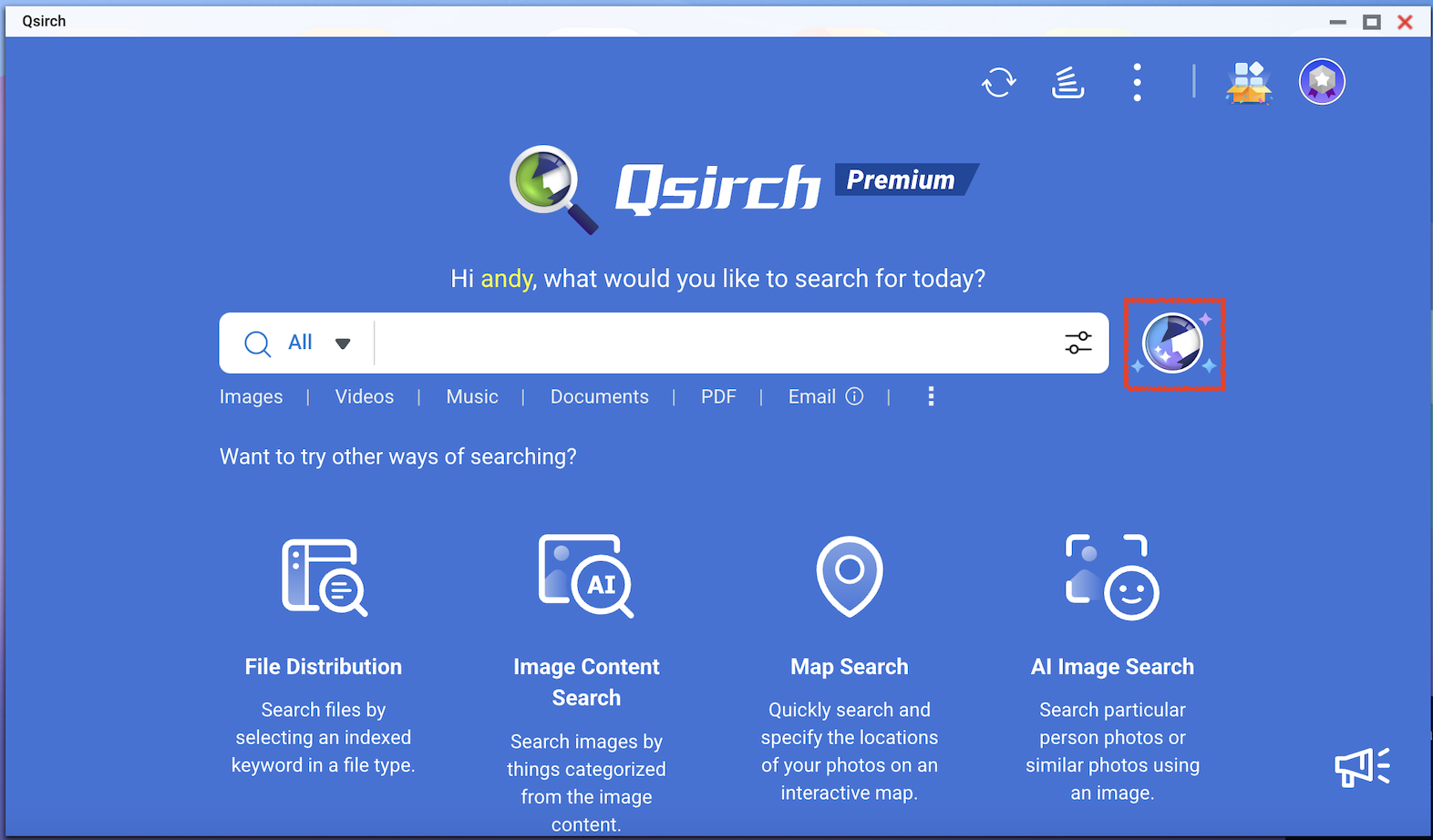

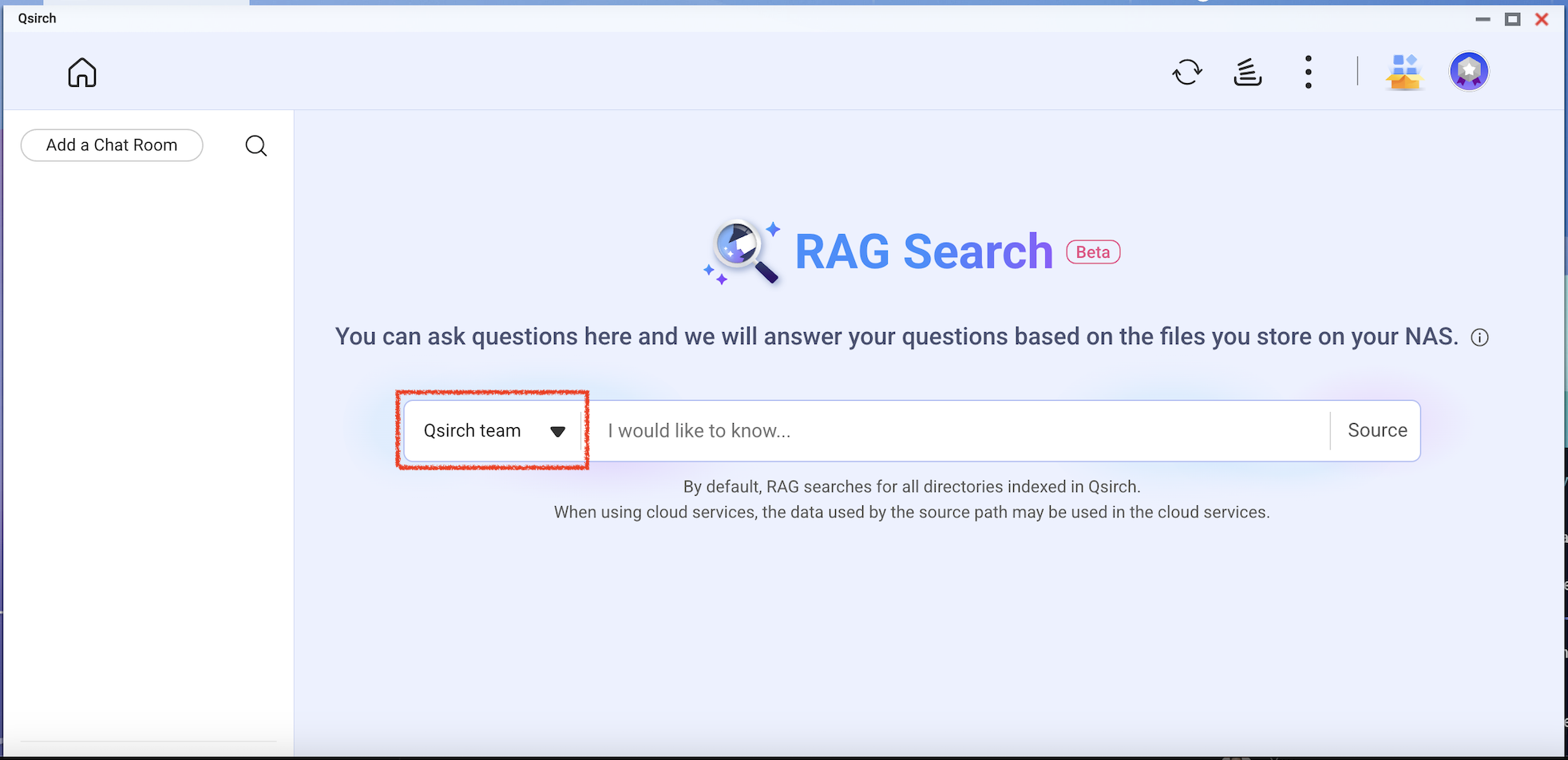

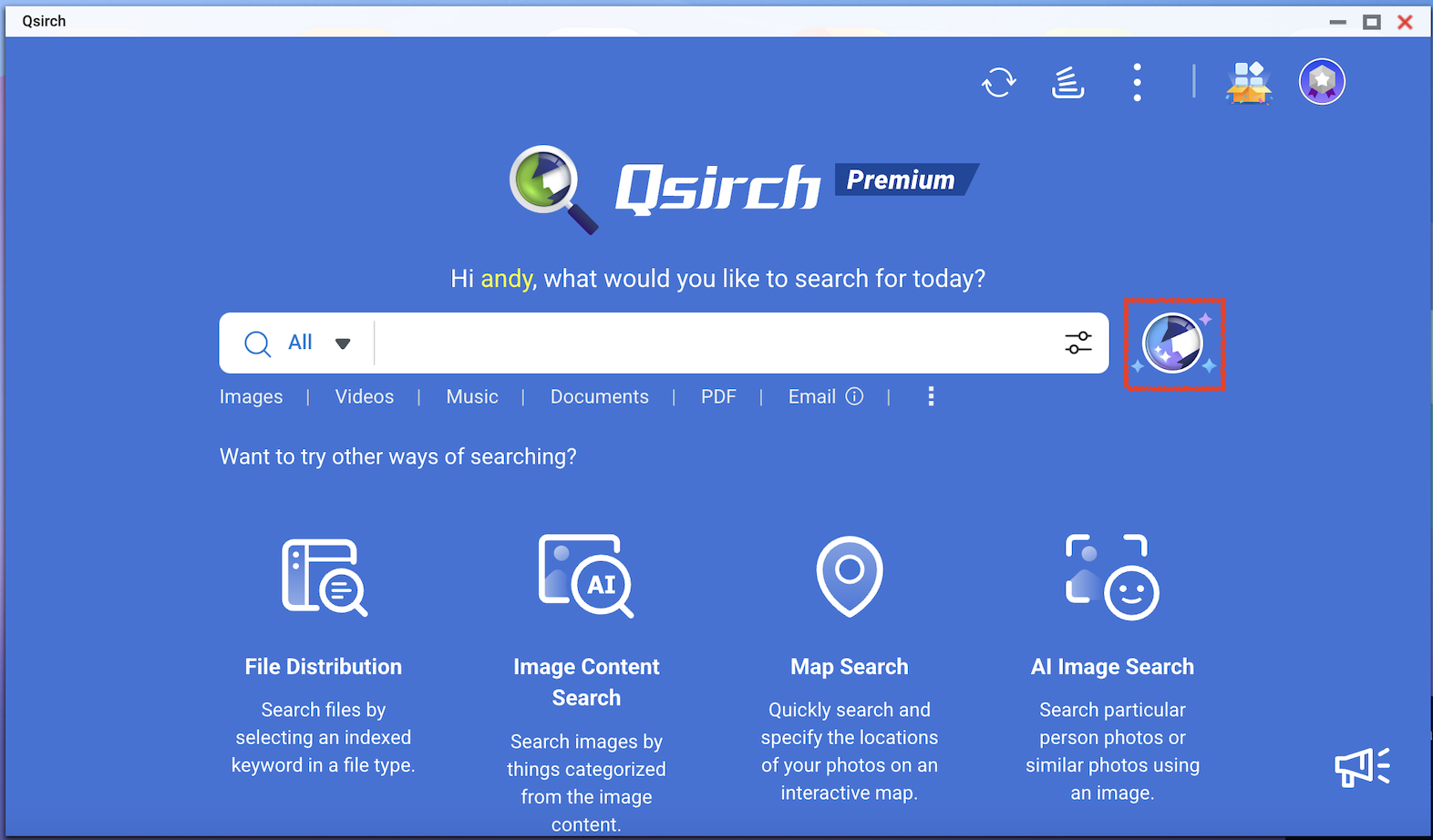

- Go to Qsirch home page and click the RAG search button.

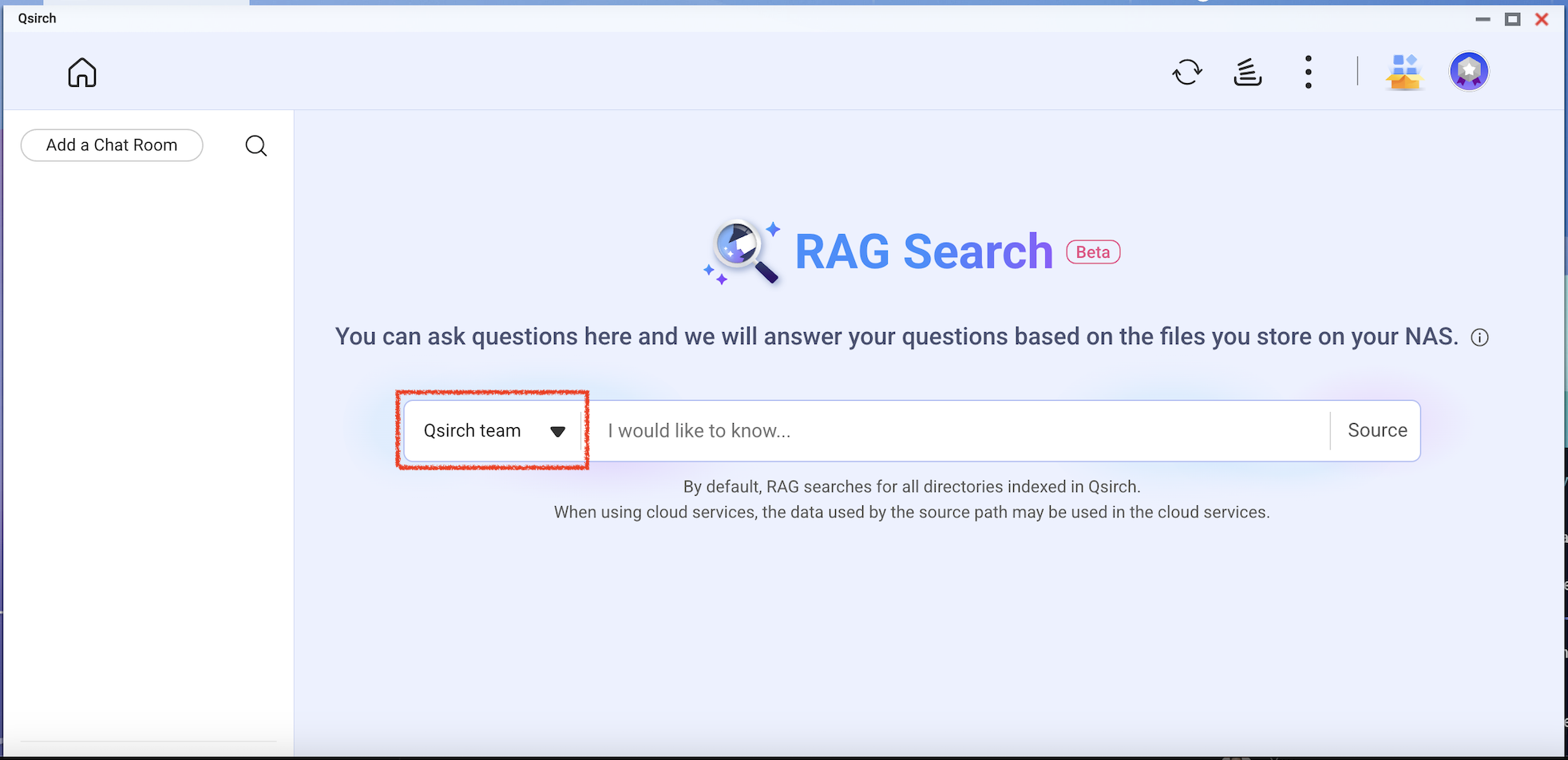

Qsirch RAG search will only use the files included in "Source" for data retrieval.

Check the model you want to use and then start using RAG search.

対象製品

すべてのプラットフォームでの Qsirch 6.0.0(以降)

クラウドを使用した Qsirch RAG 検索およびオンプレミス LLM

Qsirch は、クラウドベースの大規模言語モデル(LLM)を使用した検索強化生成(RAG)をサポートし、正確でコンテキストに基づいた応答を提供します。クエリを入力すると、Qsirch は NAS から関連するドキュメントを取得し、それらを言語モデルのコンテキストとして使用します。この検索と生成 AI の組み合わせにより、Qsirch は自身のデータに基づいた正確で情報に基づいた回答を生成できます。

Qsirch はまた、マルチターン会話をサポートし、自然でコンテキストに基づいた対話を可能にします。ユーザーは以前のコンテキストを繰り返すことなくフォローアップの質問をすることができ、コンテキストはターンをまたいで保持され、一貫した回答が得られます。マルチターン会話のサポートは、クラウドとオンプレミスの両方の RAG モードで機能します。

クラウドベースの AI サービスと RAG を統合

RAG 検索を統合するには、まず選択した AI サービスから API キーを取得する必要があります。

ChatGPT (OpenAI API)

ChatGPT (OpenAI API) は、RAG 埋め込みと生成応答の両方に強力な GPT モデルを提供します。API キーを申請するには、以下の手順に従ってください。

- OpenAI にアカウントを登録する: https://auth.openai.com/create-account

- アカウント設定で API キーを作成します。

詳細については、OpenAI API ドキュメントを参照してください。

Azure OpenAI

Azure OpenAI は、Azure インフラストラクチャを介して OpenAI モデル(GPT-4.1 など)へのアクセスを提供し、エンタープライズソリューションに最適です。API キーを申請するには、以下の手順に従ってください。

- Azure ポータルにサインインします。

- OpenAI リソースを選択します(まだ持っていない場合は作成します)。

- 左側のメニューでクリックしますキーとエンドポイント。

- API キーをコピーし、API リクエストのエンドポイント(ベース URL)をコピーします。

詳細については、 Azure OpenAI ドキュメントを参照してください。

Gemini (Google Cloud AI)

Gemini (Google Cloud AI) は、高性能な推論と RAG のために設計されたモデルセットを提供します。API キーを申請するには、以下の手順に従ってください。

- Google Gemini API ドキュメントを訪問します。

- Google AI Studio で Gemini API キーを取得します。

- Google アカウントにサインインします。

- クリックしますAPI キーを作成。

詳細については、 Google Cloud AI ドキュメントを参照してください。

OpenAI 互換 API

OpenAI 互換 API は、DeepSeek や Grok などのモデルを含む、OpenAI の提供するもの以外のさまざまな AI モデルにアクセスすることを可能にします。同じ API 形式を使用することで、OpenAI API 用に構築された既存のアプリケーションとシームレスに統合できます。API キーを申請するには、以下の手順に従ってください:

- OpenAI 互換 API をサポートするプロバイダーを選択します(例:DeepSeek や Grok)。

- プロバイダーのプラットフォームでサインアップします。

- アカウント設定で API キーを生成します。

- 必要に応じて API エンドポイントとモデル設定を更新します。

詳細については、プロバイダーの公式 API ドキュメントを参照してください。

オンプレミス RAG 検索

完全なデータプライバシーやオフライン AI 機能を必要とする高度なユーザーや企業向けに、Qsirch はローカルにホストされた LLM によるオンプレミス RAG 検索を提供します。このモードは、データを外部サービスに送信することなく、NAS または接続されたハードウェア上で完全に動作します。

注意

この機能は特定の NAS モデルでのみ利用可能です。詳細は QNAP のウェブサイトで

RAG 検索の紹介をご覧ください。

オンプレミス RAG を有効にするには:

- LLM コアが準備完了であることを確認します。

- GPU を Container Station モードに設定します(移動先:コントロールパネル > ハードウェア > ハードウェアリソース > リソース使用 > Container Station モード)。

Qsirch で RAG 検索を使用する方法

- 移動先:設定 > 管理設定 > RAG 検索。

- RAG 検索を使用するために 1 つ以上のクラウドサービスを追加します。

(オプション)API キーを確認します。これにより、API キーが有効かどうかを確認できます。

オンプレミスサービスから 1 つ以上のエッジモデルをダウンロードします。この機能は特定の NAS モデルでのみ使用できます。

- GPT シリーズ、DeepSeek モデル、Grok モデルを含む、OpenAI API と互換性のある AI モデルを追加します。

- RAG 検索のためのファイル形式を選択します。

- Qsirch のホームページに移動し、RAG 検索ボタンをクリックします。

Qsirch RAG 検索は、データ取得のために「ソース」に含まれるファイルのみを使用します。

使用したいモデルを確認し、RAG 検索を開始します。