Come utilizzare i modelli linguistici avanzati per la ricerca RAG di Qsirch?

Prodotti applicabili

Qsirch 6.0.0 (o versione successiva) su tutte le piattaforme

Ricerca RAG di Qsirch con Cloude LLM On-Premise

Qsirch supporta l'uso di Retrieval-Augmented Generation (RAG) con modelli linguistici di grandi dimensioni (LLM) basati su cloud per fornire risposte accurate e consapevoli del contesto. Quando inserisci una query, Qsirch recupera documenti pertinenti dal tuo NAS e li utilizza come contesto per il modello linguistico. Questa combinazione di ricerca e AI generativa consente a Qsirch di generare risposte precise e informate basate sui tuoi dati.

Qsirch supporta anche la conversazione multi-turn, consentendo interazioni naturali e consapevoli del contesto. Gli utenti possono fare domande di follow-up senza ripetere il contesto precedente, e il contesto è preservato tra i turni per risposte coerenti. Il supporto alla conversazione multi-turn funziona sia con modalità RAG cloud che on-premise.

Integra RAG con servizi AI basati su cloud

Per integrare la ricerca RAG, devi prima ottenere una chiave API da un servizio AI a tua scelta.

ChatGPT (API OpenAI)

ChatGPT (API OpenAI) fornisce potenti modelli GPT sia per embedding RAG che per risposte generative. Segui i passaggi seguenti per richiedere una chiave API:

- Registrati per un account su OpenAI: https://auth.openai.com/create-account

- Crea una chiave API nelle impostazioni dell'account.

Per ulteriori informazioni, vedere Documentazione API di OpenAI.

Azure OpenAI

Azure OpenAI fornisce accesso ai modelli OpenAI (come GPT-4.1) tramite infrastruttura Azure, ideale per soluzioni aziendali. Segui i passaggi seguenti per richiedere una chiave API:

- Accedi al Portale Azure.

- Seleziona la tua risorsa OpenAI (o creane una se non ne hai già una).

- Nel menu a sinistra, fai clic su Chiavi e Endpoint.

- Copia una chiave API e copia l'endpoint (URL base) per le richieste API.

Per ulteriori informazioni, vedere Documentazione OpenAI di Azure.

Gemini (Google Cloud AI)

Gemini (Google Cloud AI) fornisce un insieme di modelli progettati per ragionamenti ad alte prestazioni e RAG. Segui i passaggi seguenti per richiedere una chiave API:

- Visita il Documentazione API di Google Gemini.

- Ottieni una chiave API Gemini in Google AI Studio.

- Accedi al tuo account Google.

- Fai clic su Crea chiave API.

Per ulteriori informazioni, vedere Documentazione AI di Google Cloud.

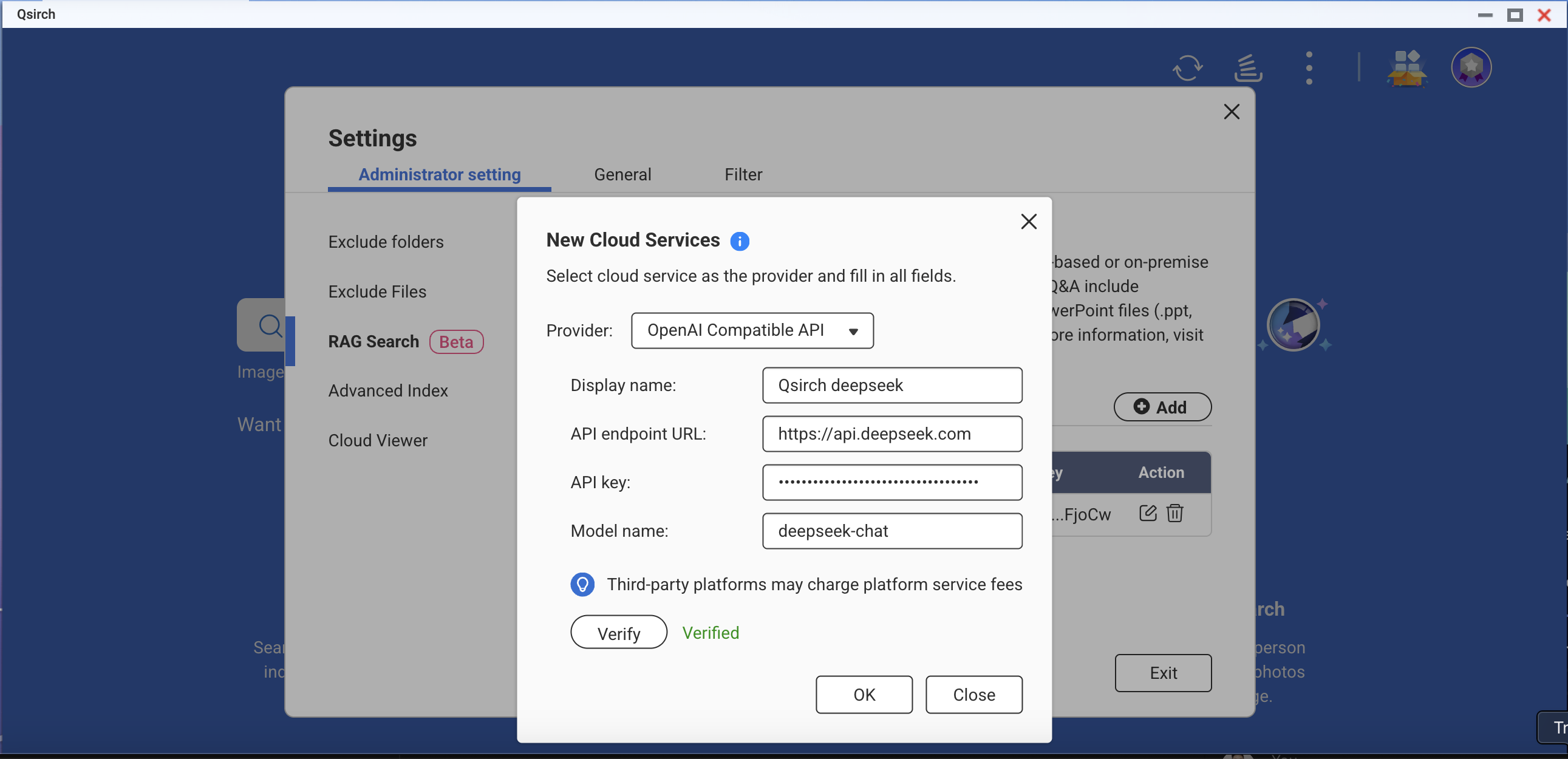

API compatibile con OpenAI

L'API compatibile con OpenAI consente agli utenti di accedere a vari modelli AI oltre alle offerte di OpenAI, inclusi modelli come DeepSeek e Grok, utilizzando lo stesso formato API. Questo consente un'integrazione senza soluzione di continuità con le applicazioni esistenti costruite per l'API OpenAI. Segui i passaggi seguenti per richiedere una chiave API:

- Scegli un fornitore che supporti l'API compatibile con OpenAI (ad esempio, DeepSeek o Grok).

- Registrati sulla piattaforma del fornitore.

- Genera una chiave API nelle impostazioni dell'account.

- Aggiorna il tuo endpoint API e le impostazioni del modello come richiesto.

Per ulteriori informazioni, fare riferimento alla documentazione ufficiale dell'API del fornitore.

Ricerca RAG on-premise

Per abilitare la ricerca RAG on-premise:

- Assicurati che il Core LLM sia pronto.

- Imposta la GPU in modalità Container Station (Vai a Pannello di controllo > Hardware > Risorse hardware > Uso delle risorse > modalità Container Station ).

Come utilizzare la ricerca RAG in Qsirch

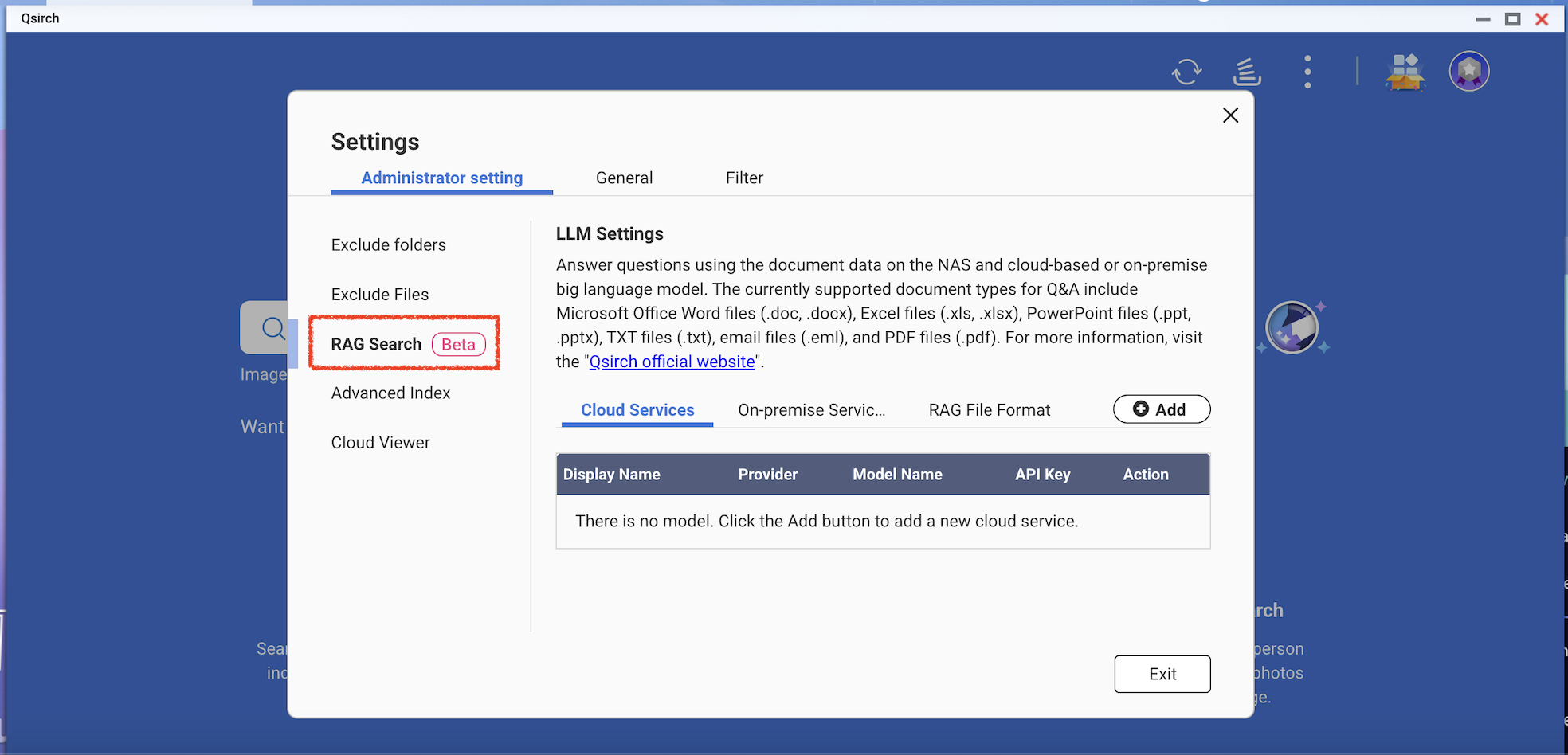

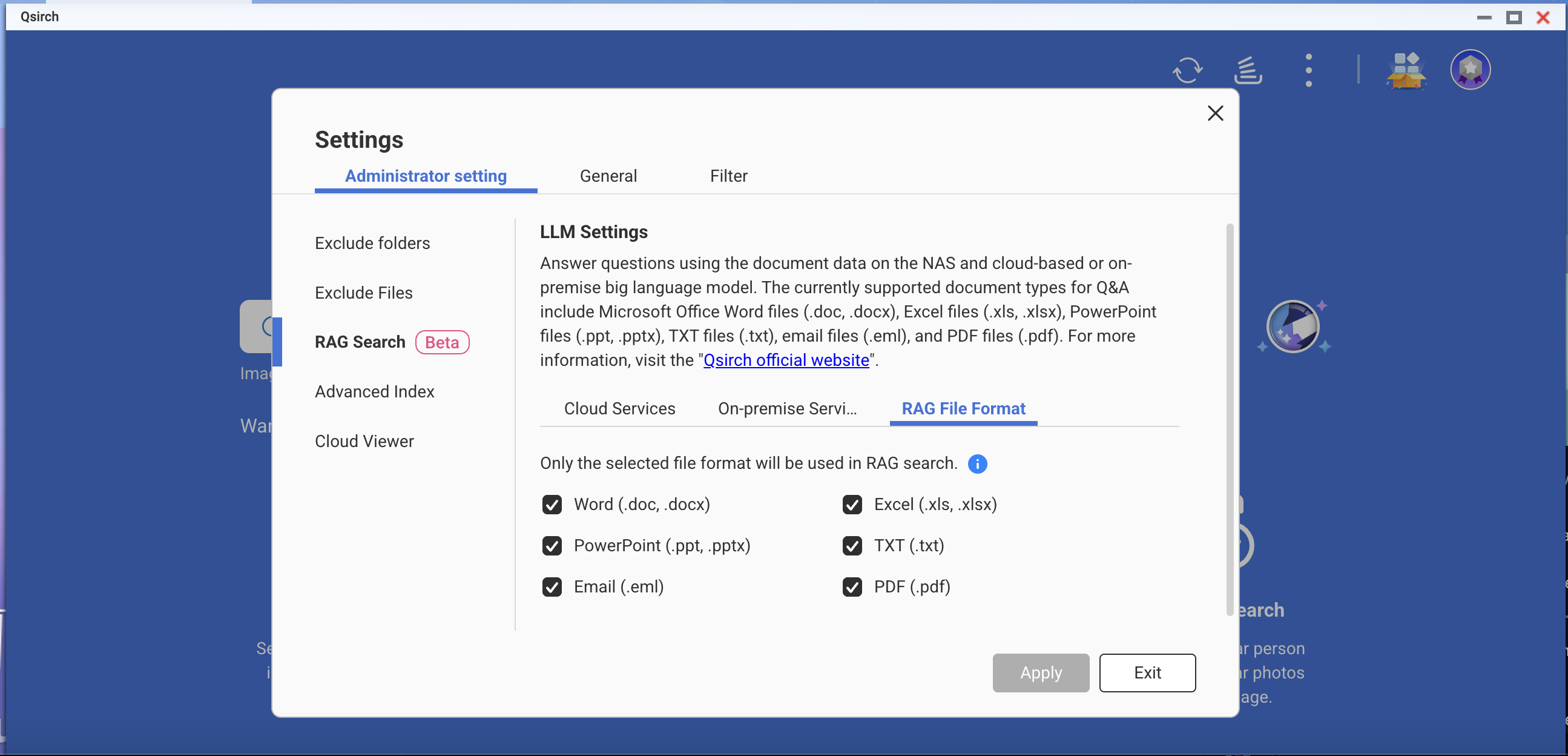

- Vai a Impostazioni > Impostazioni amministrative > Ricerca RAG.

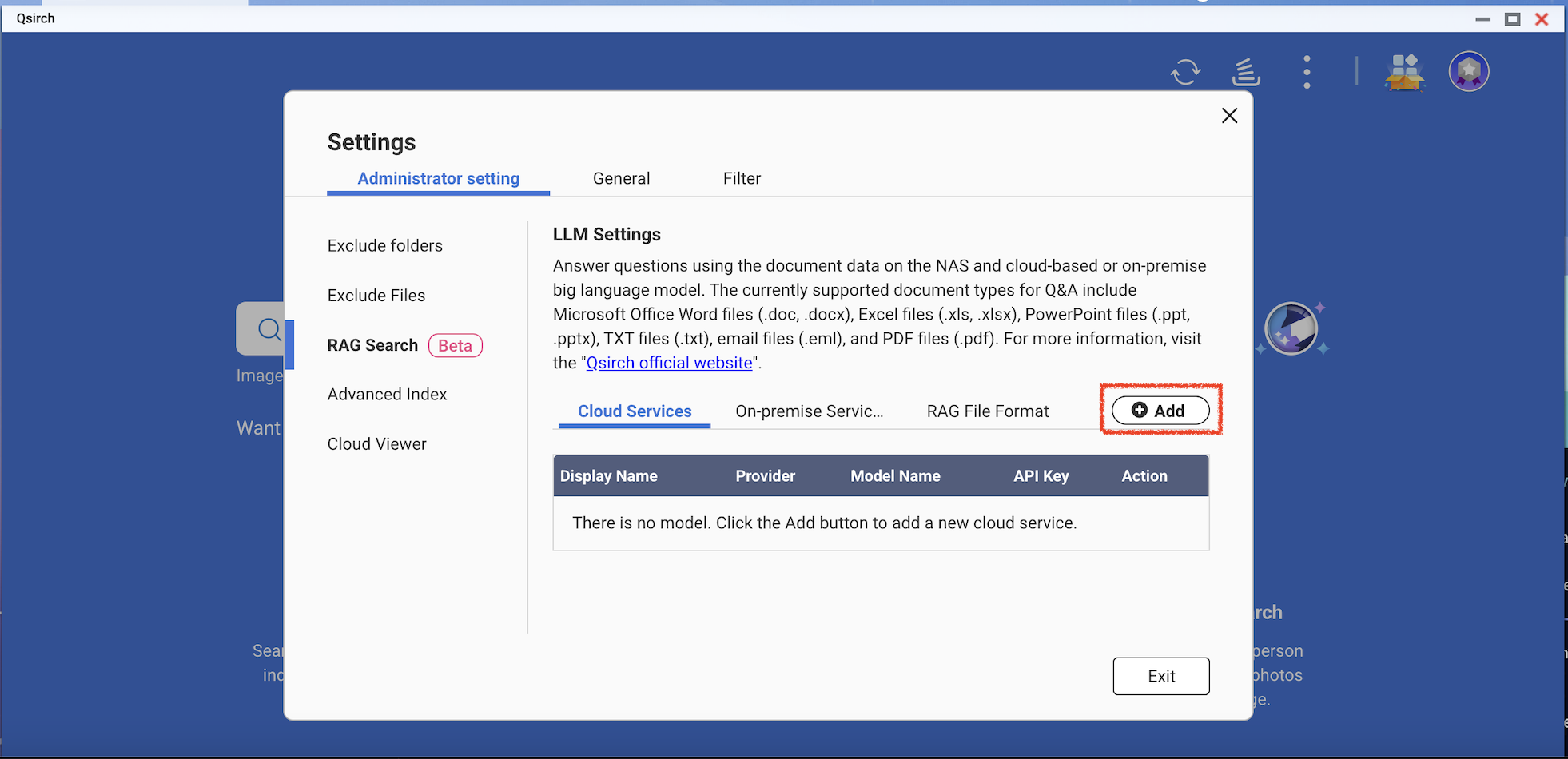

- Aggiungi uno o più servizi cloud per utilizzare la ricerca RAG.

(Opzionale) Verifica la tua chiave API. Questo aiuta a controllare se una chiave API è valida.

Scarica uno o più modelli Edge dai servizi on-premise. Questa funzione può essere utilizzata solo sui modelli NAS specifici.

- Aggiungi più modelli AI compatibili con l'API OpenAI, inclusi i modelli della serie GPT, i modelli DeepSeek e i modelli Grok.

- Scegli i formati di file per la tua ricerca RAG.

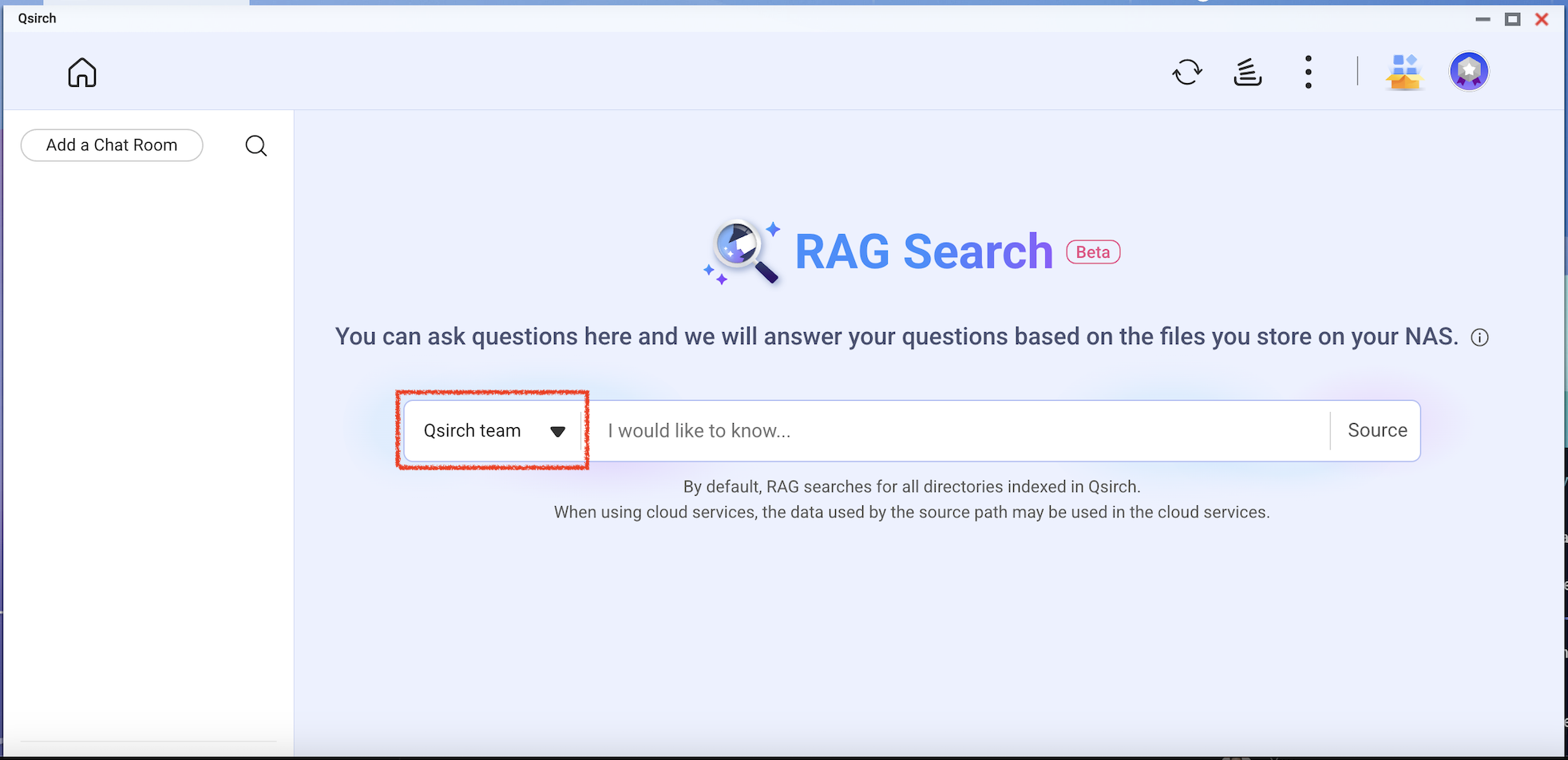

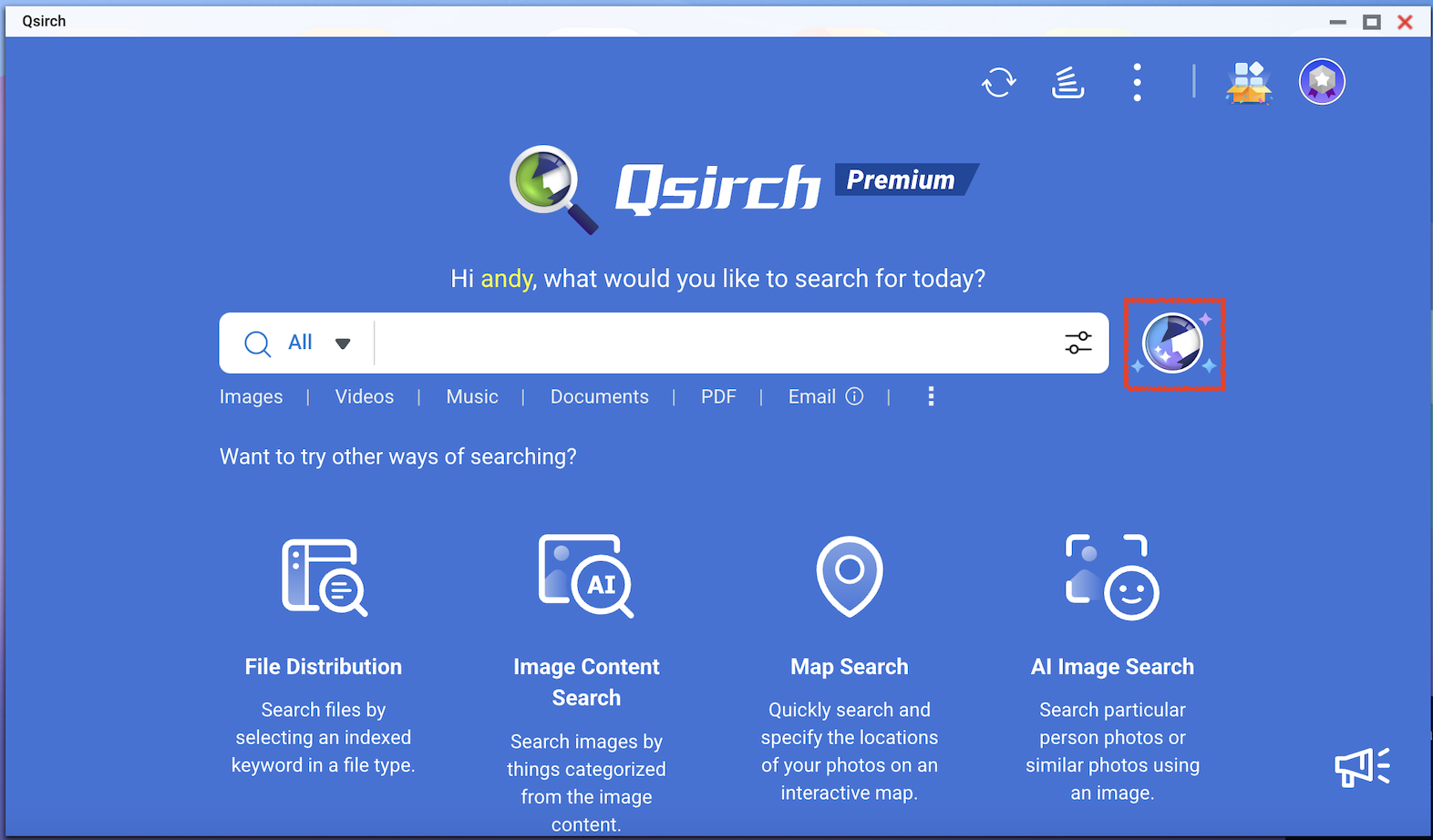

- Vai alla home page di Qsirch e fai clic sul pulsante di ricerca RAG.

La ricerca RAG di Qsirch utilizzerà solo i file inclusi in "Source" per il recupero dei dati.

Controlla il modello che desideri utilizzare e poi inizia a utilizzare la ricerca RAG.