Applicable Products

Qsirch 6.0.0 (or later) on all platforms

Qsirch RAG Search with Cloud and On-Premise LLMs

Qsirch supports using Retrieval-Augmented Generation (RAG) with cloud-based large language models (LLMs) to deliver accurate and context-aware responses. When you enter a query, Qsirch retrieves relevant documents from your NAS and uses them as context for the language model. This combination of search and generative AI enables Qsirch to generate precise and informed answers based on your own data.

Qsirch also supports multi-turn conversation, enabling natural and context-aware interactions. Users can ask follow-up questions without repeating prior context, and context is preserved across turns for coherent answers. Multi-turn conversation support works with both cloud and on-premise RAG modes.

Integrate RAG with Cloud-based AI Services

To integrate RAG search, you must first obtain an API key from an AI service of your choice.

ChatGPT (OpenAI API)

ChatGPT (OpenAI API) provides powerful GPT models for both RAG embeddings and generative responses. Follow the steps below to apply for an API key:

- Sign up for an account on OpenAI: https://auth.openai.com/create-account

- Create an API key in the account settings.

For more information, see OpenAI API Documentation.

Azure OpenAI

Azure OpenAI provides access to OpenAI models (like GPT-4.1) via Azure infrastructure, which is ideal for enterprise solutions. Follow the steps below to apply for an API key:

- Sign in to the Azure Portal.

- Select your OpenAI resource (or create one if you do not already have one).

- On the left menu, click Keys and Endpoint.

- Copy an API key and copy the endpoint (base URL) for API requests.

For more information, see Azure OpenAI Documentation.

Gemini (Google Cloud AI)

Gemini (Google Cloud AI) provides a set of models designed for high-performance reasoning and RAG. Follow the steps below to apply for an API key:

- Visit the Google Gemini API Documentation.

- Get a Gemini API key in Google AI Studio.

- Sign in to your Google account.

- Click Create API key.

For more information, see Google Cloud AI Documentation.

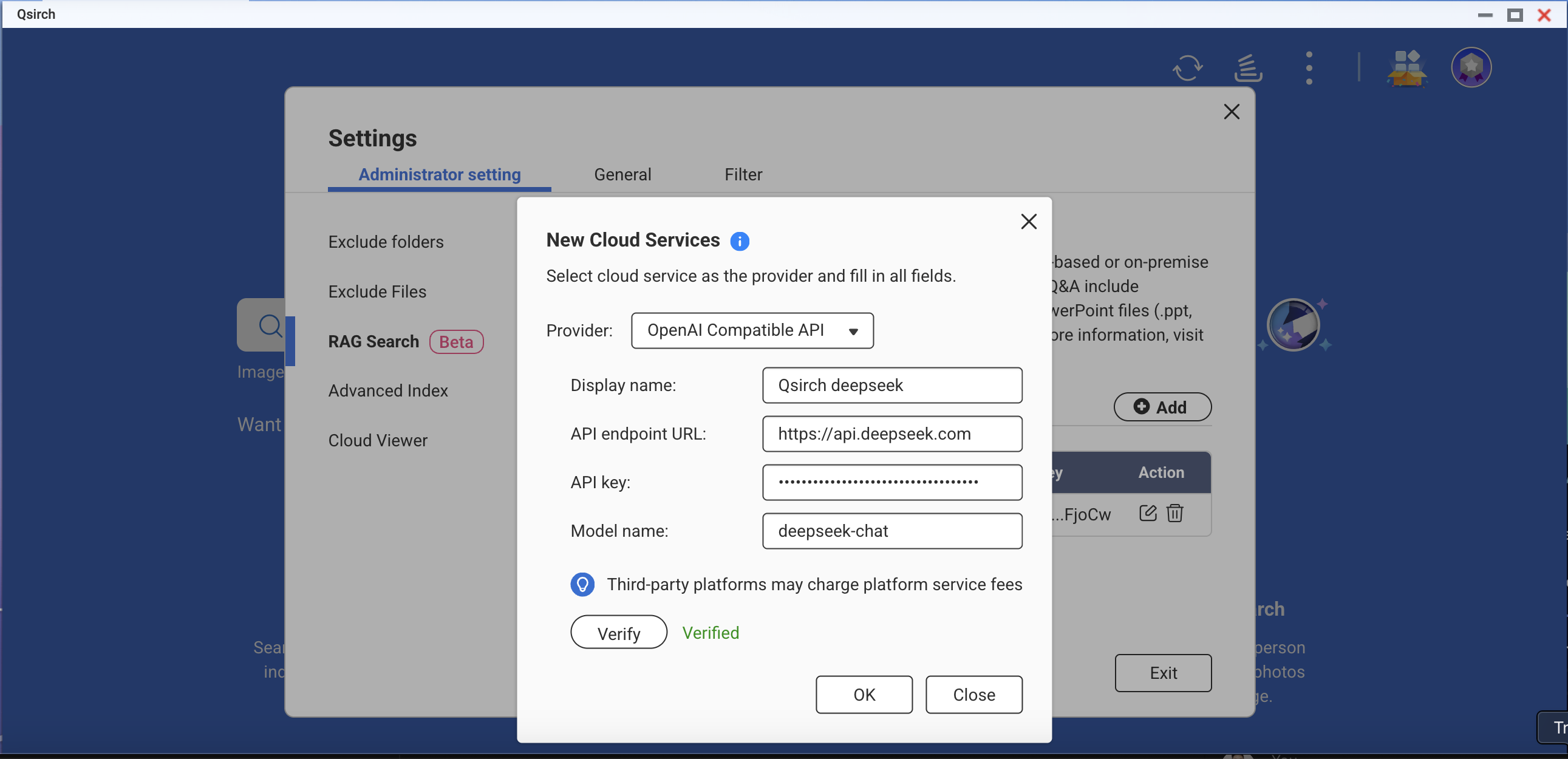

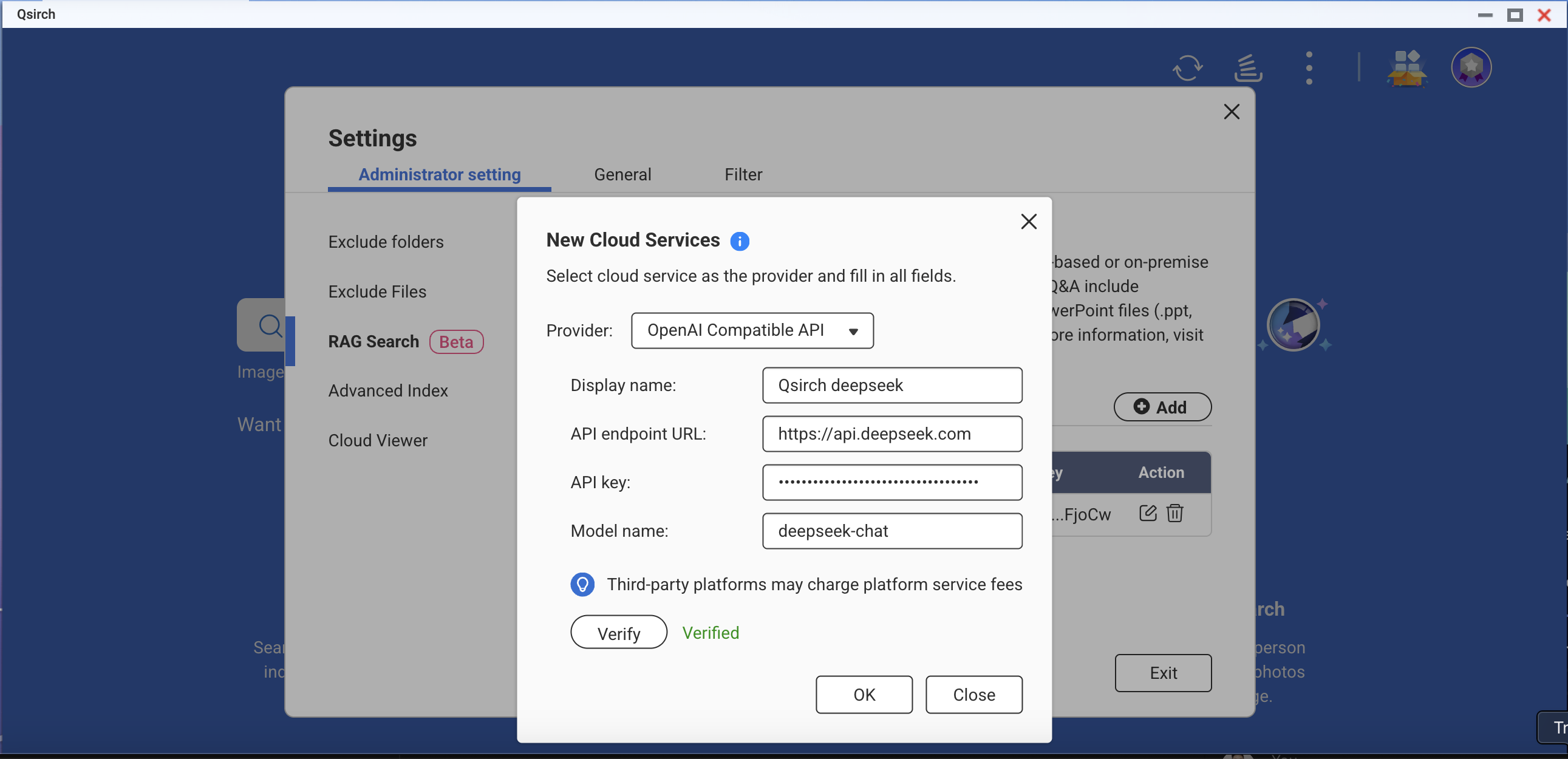

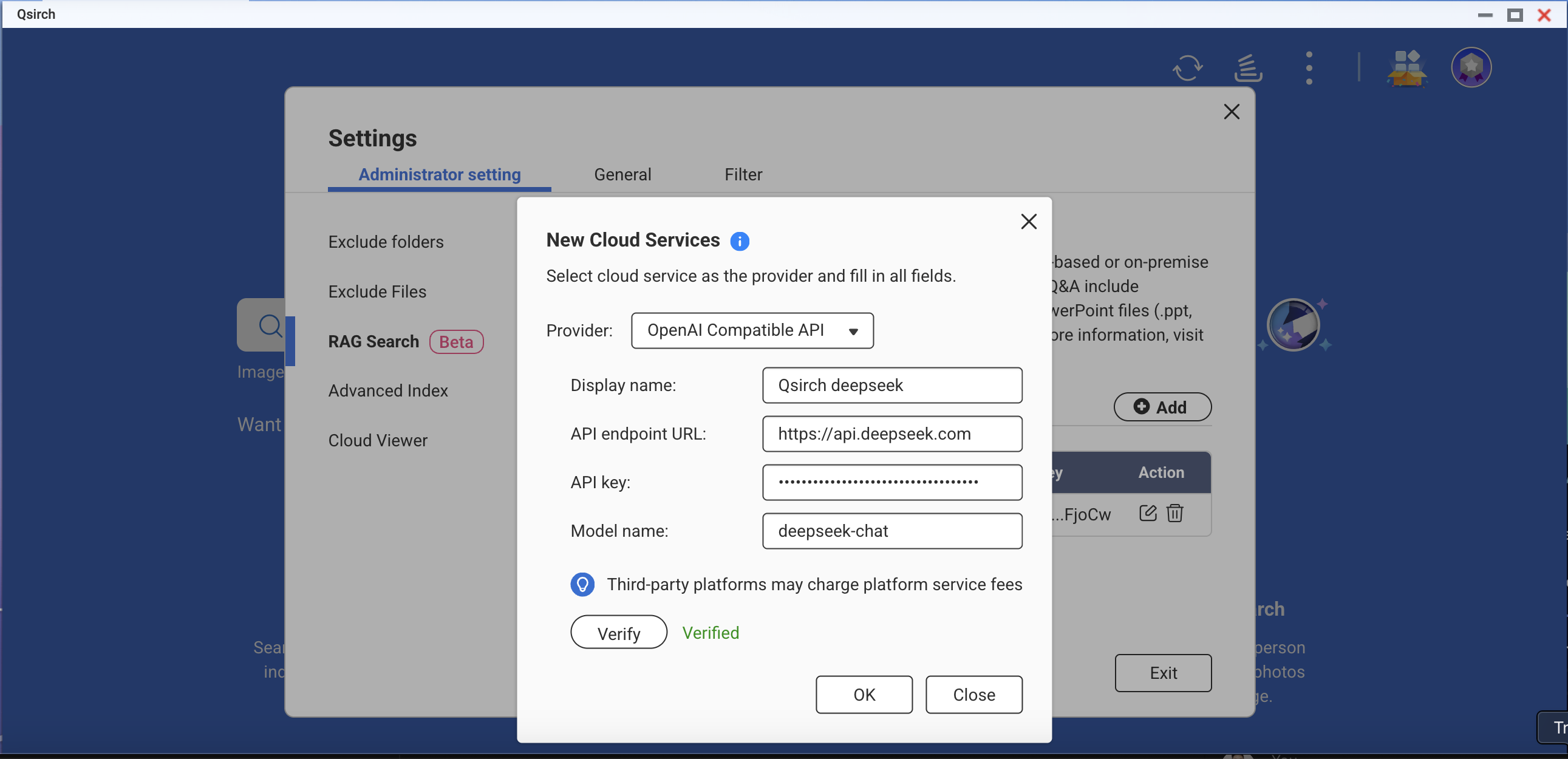

OpenAI-Compatible API

OpenAI Compatible API allows users to access various AI models beyond OpenAI’s own offerings, including models like DeepSeek and Grok, using the same API format. This enables seamless integration with existing applications built for OpenAI API. Follow the steps below to apply for an API key:

- Choose a provider that supports OpenAI-compatible API (for example, DeepSeek or Grok).

- Sign up on the provider's platform.

- Generate an API key in the account settings.

- Update your API endpoint and model settings as required.

For more information, refer to the provider's official API documentation.

On-Premise RAG Search

For advanced users and enterprises who require full data privacy or offline AI capabilities, Qsirch offers on-premise RAG search powered by locally hosted LLMs. This mode runs entirely on your NAS or connected hardware, without sending data to external services.

To enable on-premise RAG:

- Ensure that the LLM Core is ready.

- Set the GPU to Container Station mode (Go to Control Panel > Hardware > Hardware Resources > Resource Use > Container Station mode).

How to Use RAG Search in Qsirch

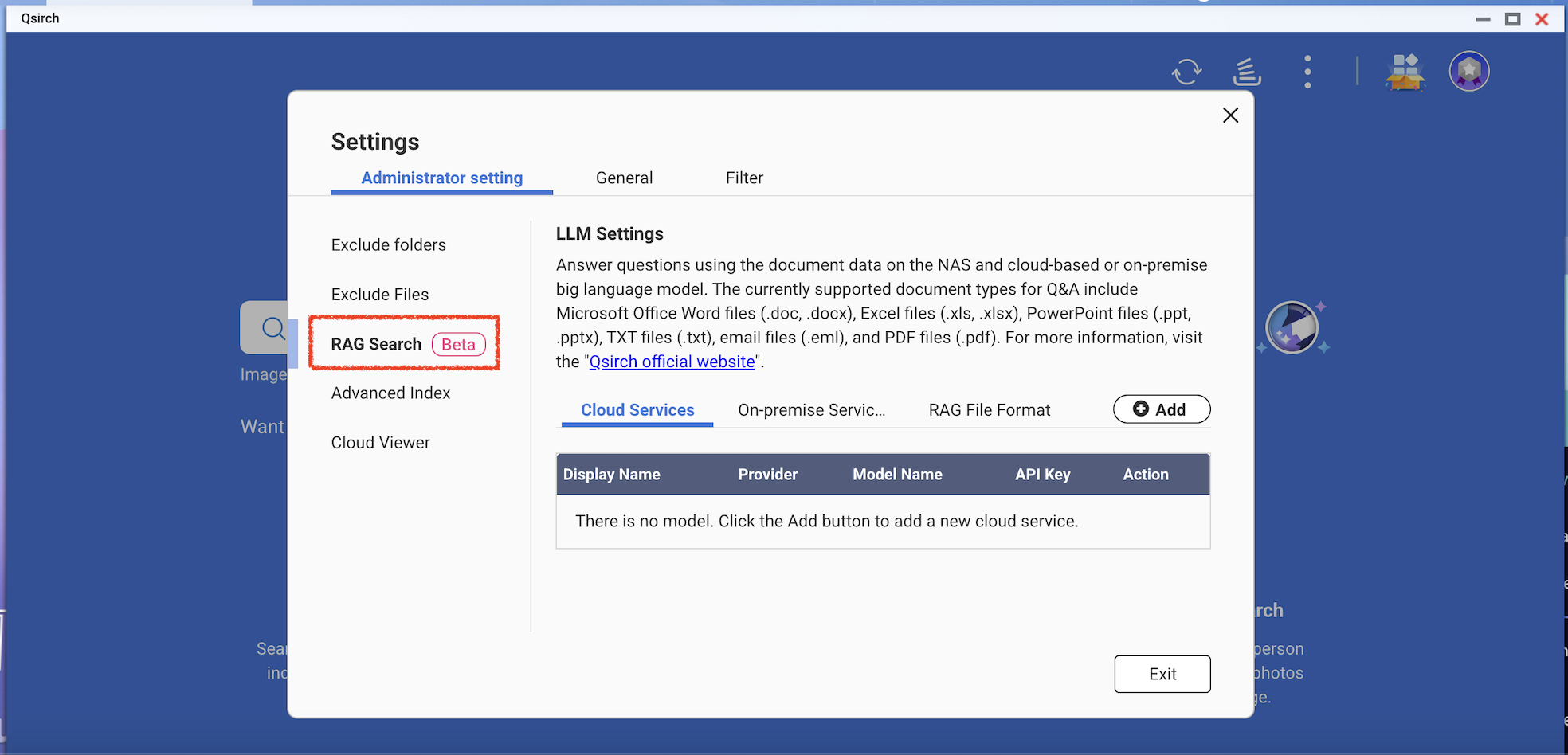

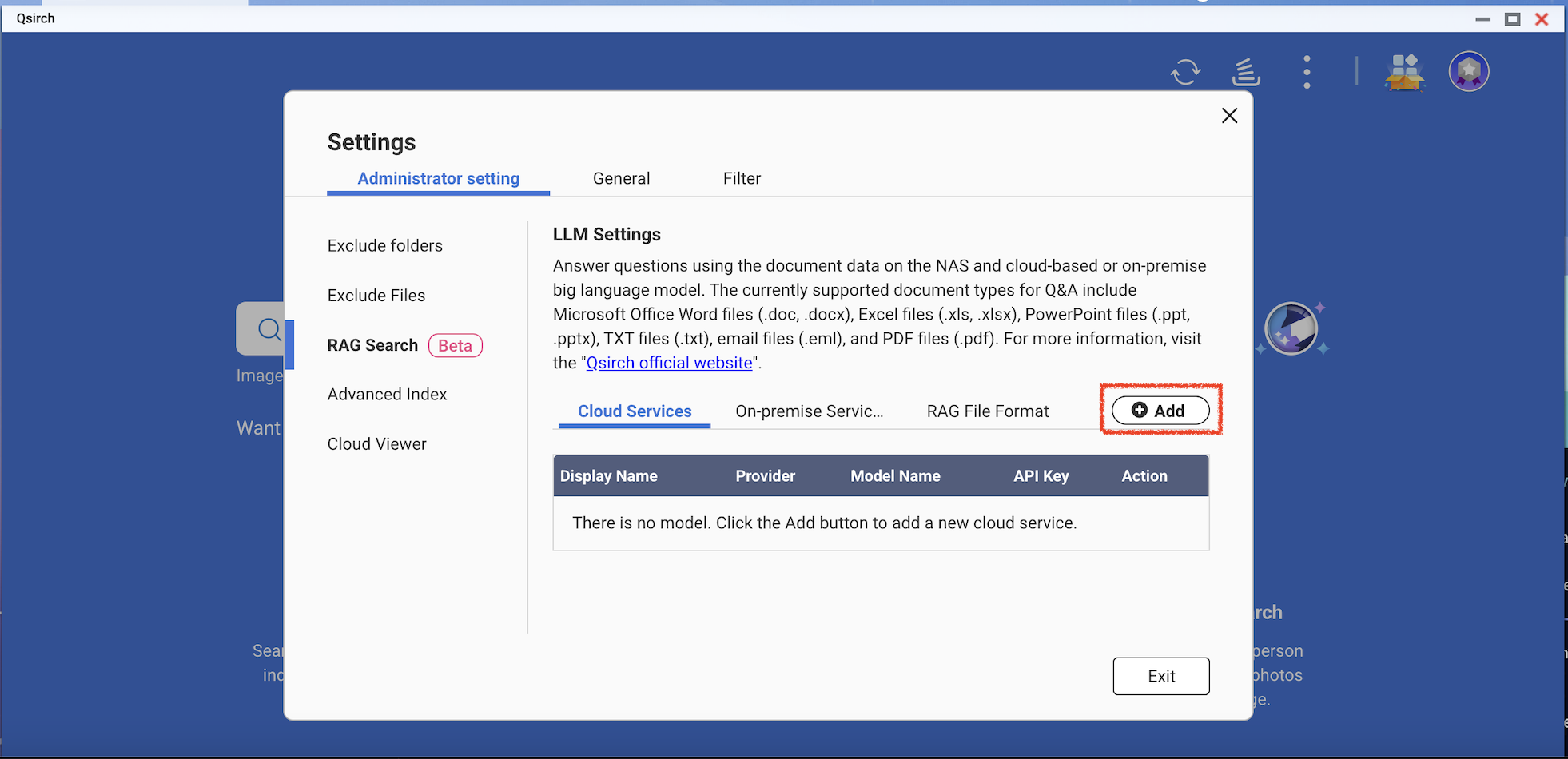

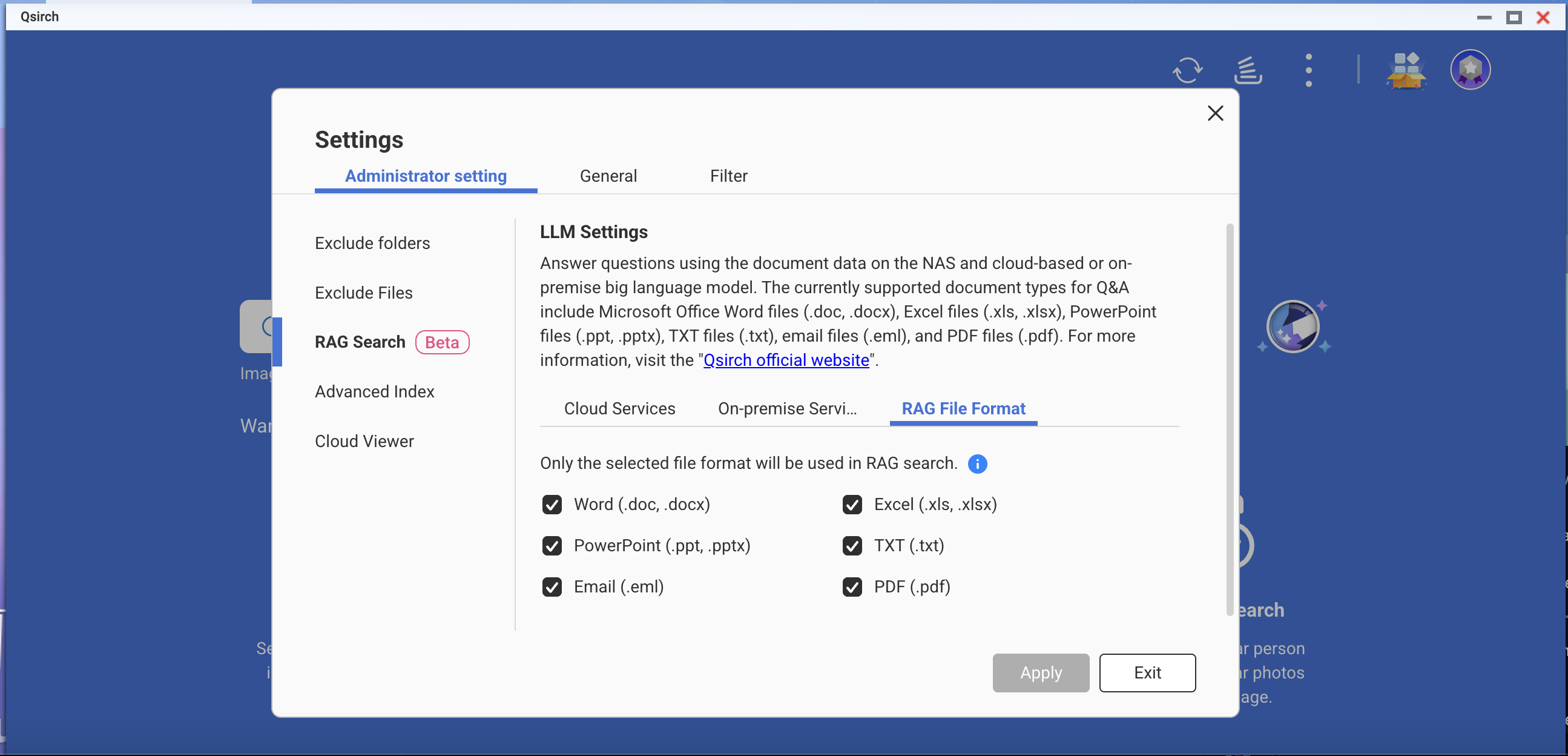

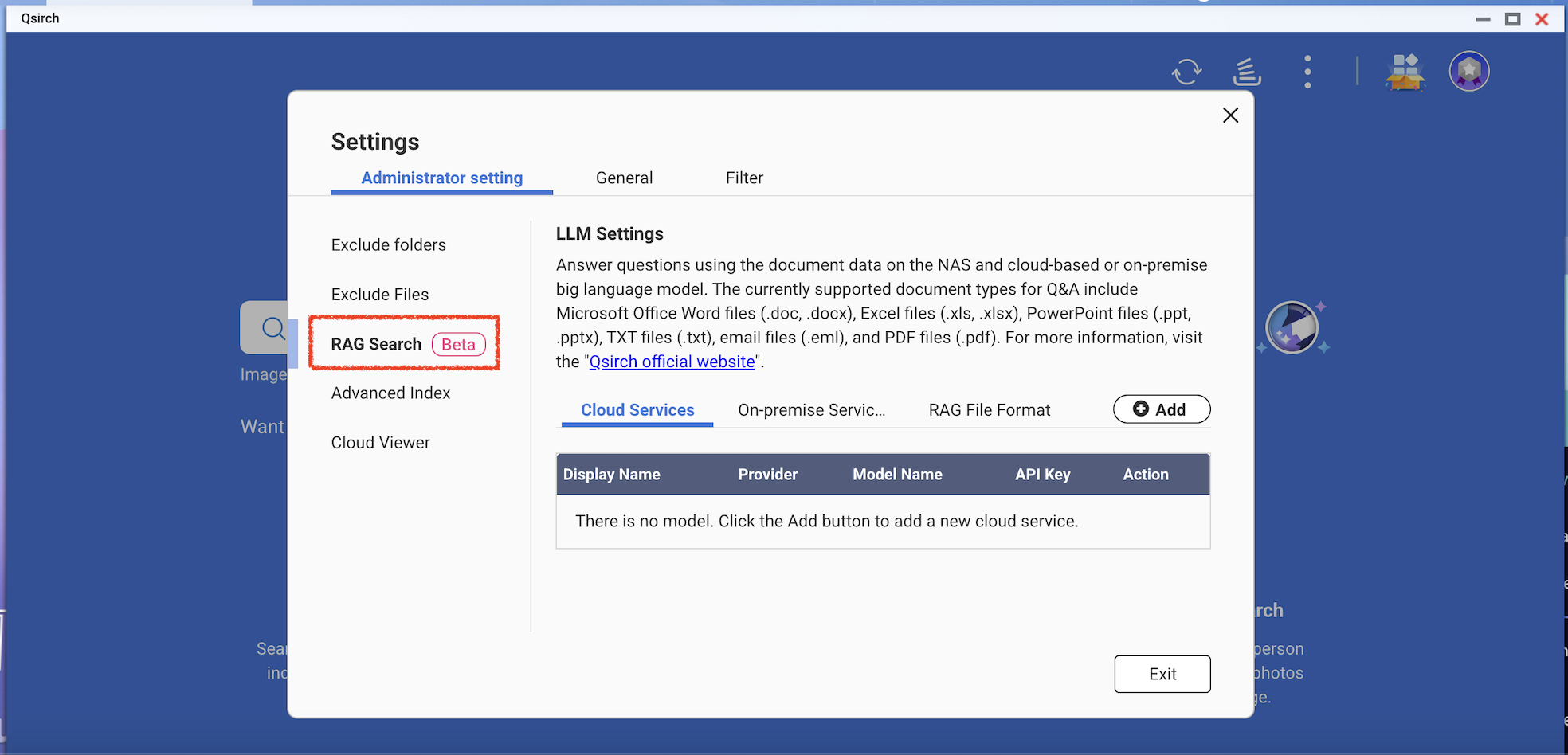

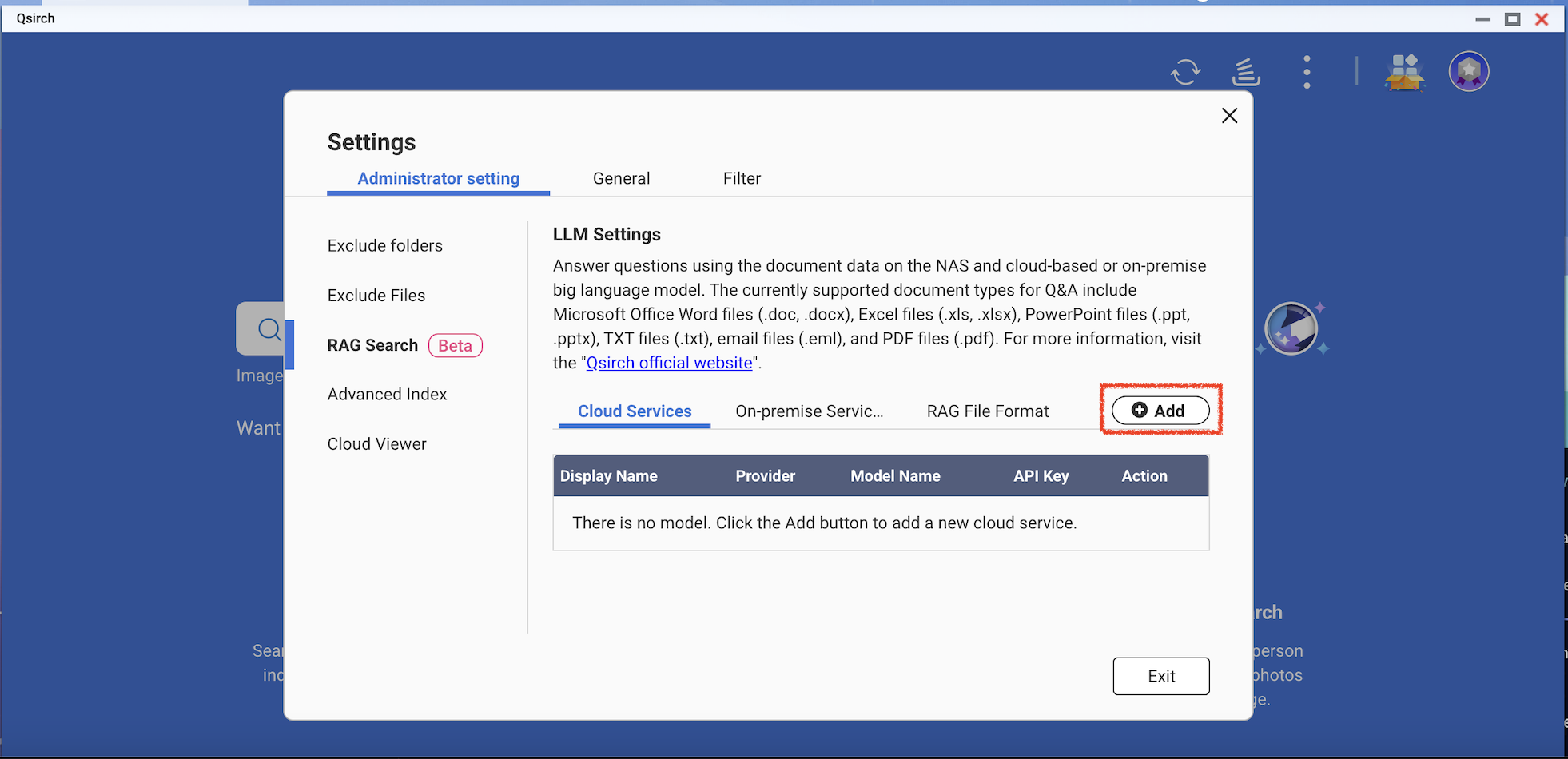

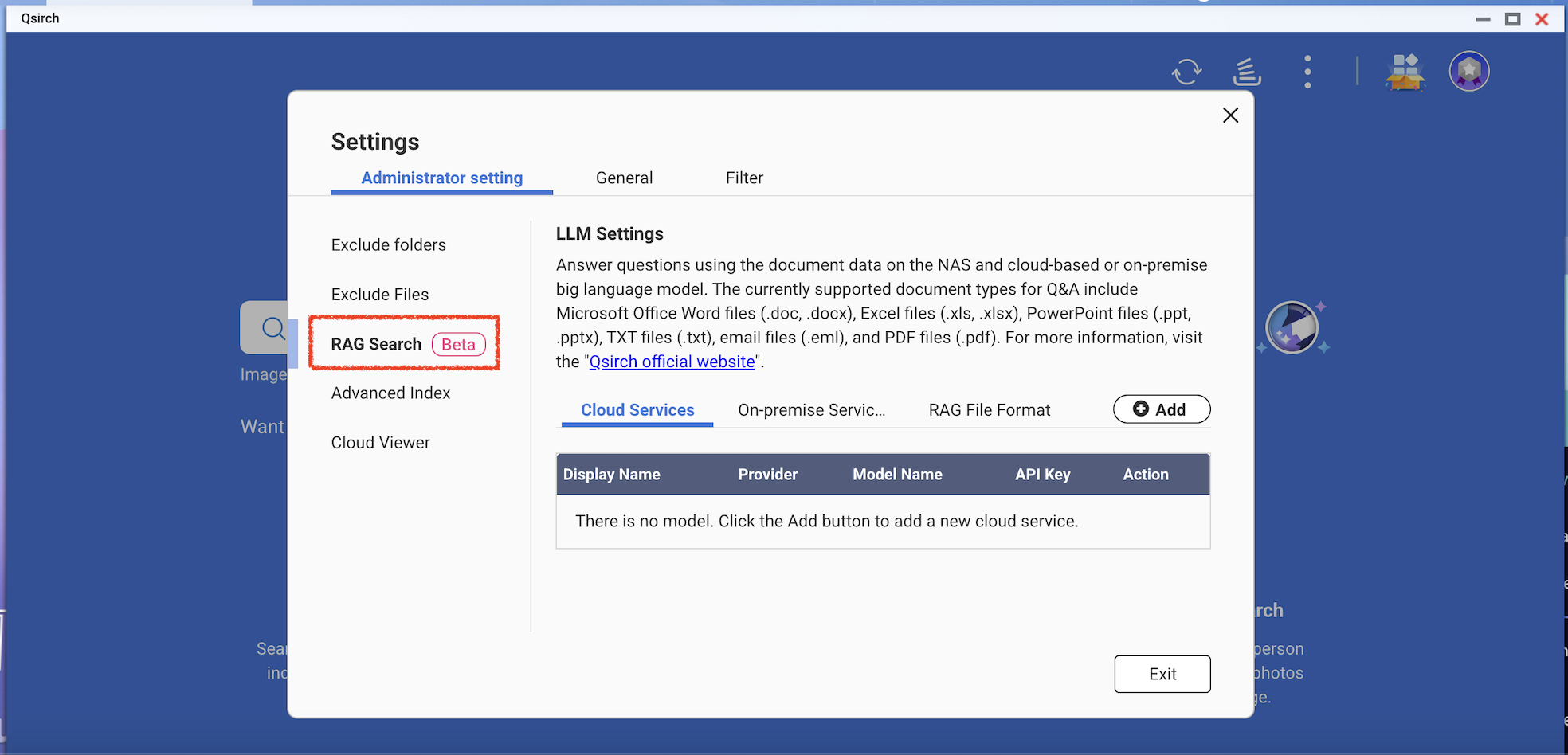

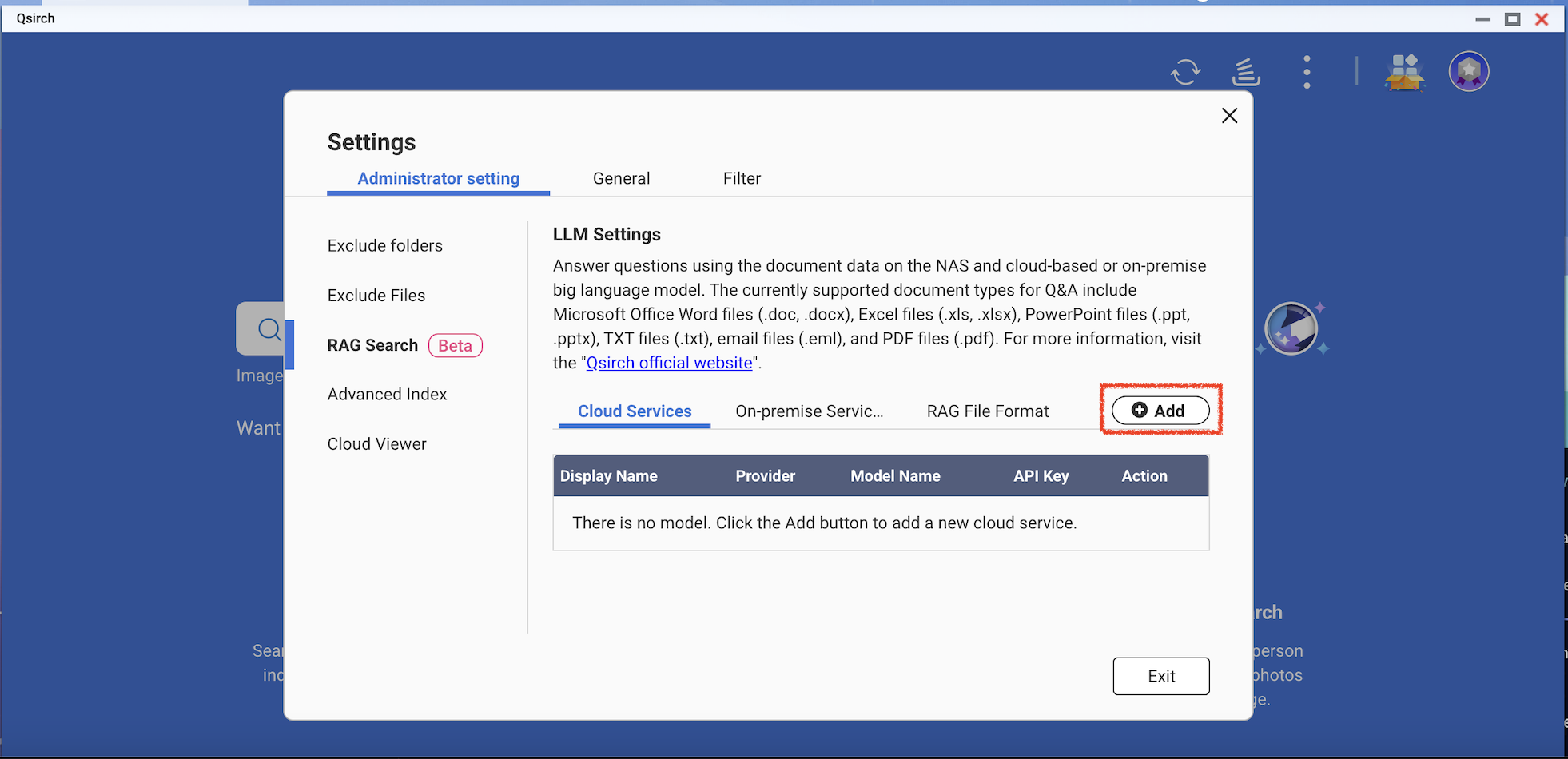

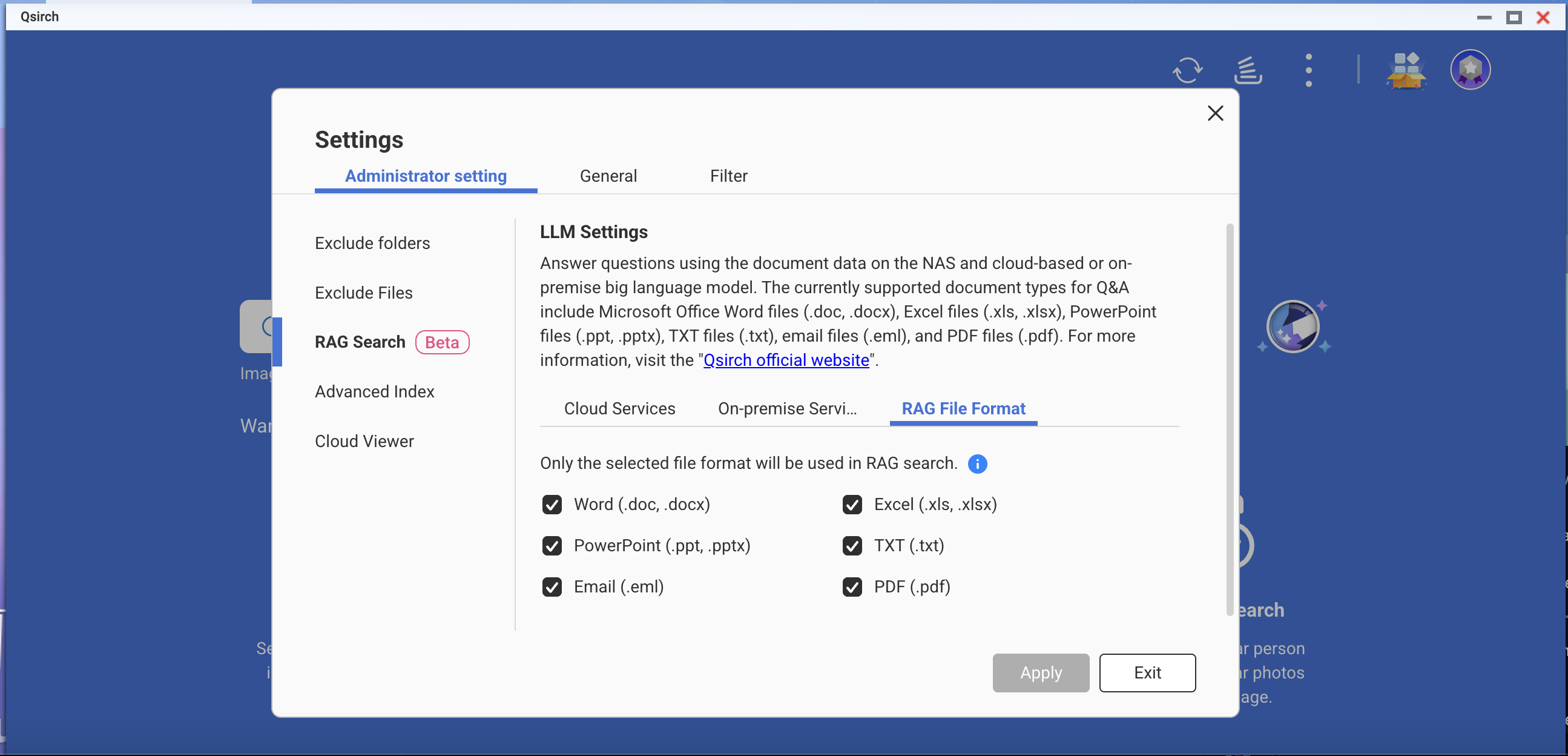

- Go to Settings > Administrative setting > RAG Search.

- Add one or more cloud services to use RAG search.

(Optional) Verify your API key. This helps check whether an API key is valid.

Download one or more edge models from the on-premise services. This feature can only be used on the specific NAS models.

- Add more AI models that are compatible with OpenAI API, including the GPT series, DeepSeek models, and Grok models.

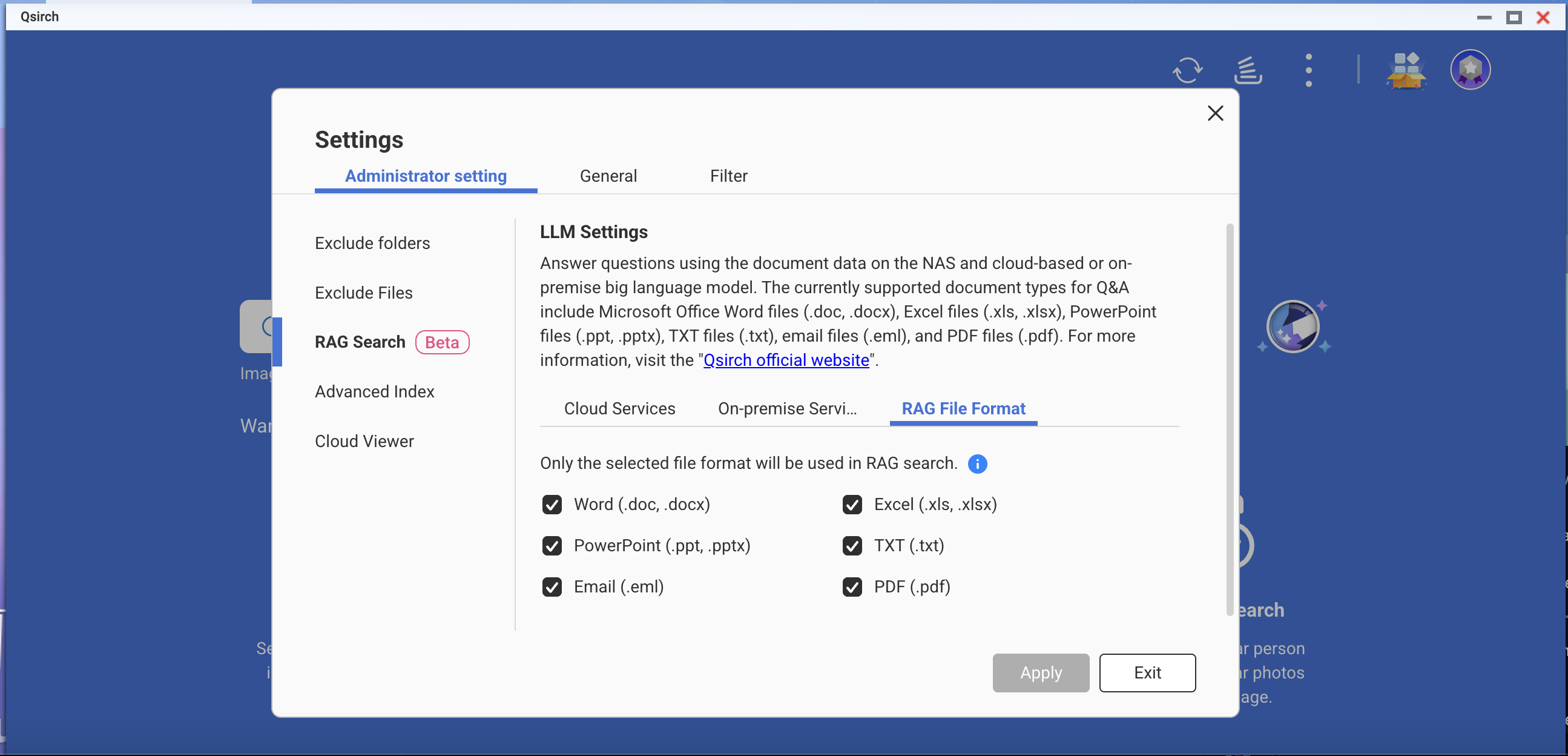

- Choose file formats for your RAG search.

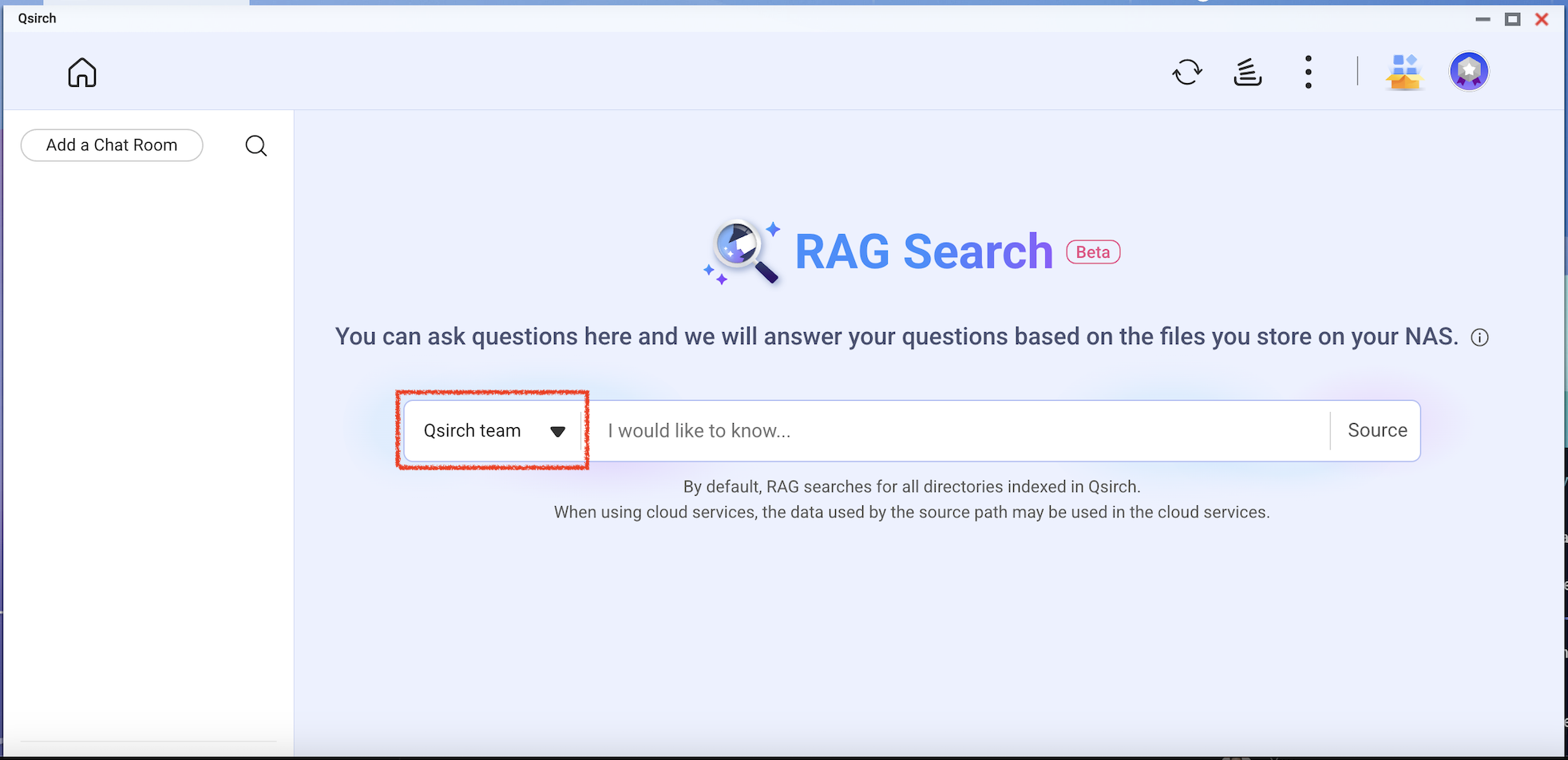

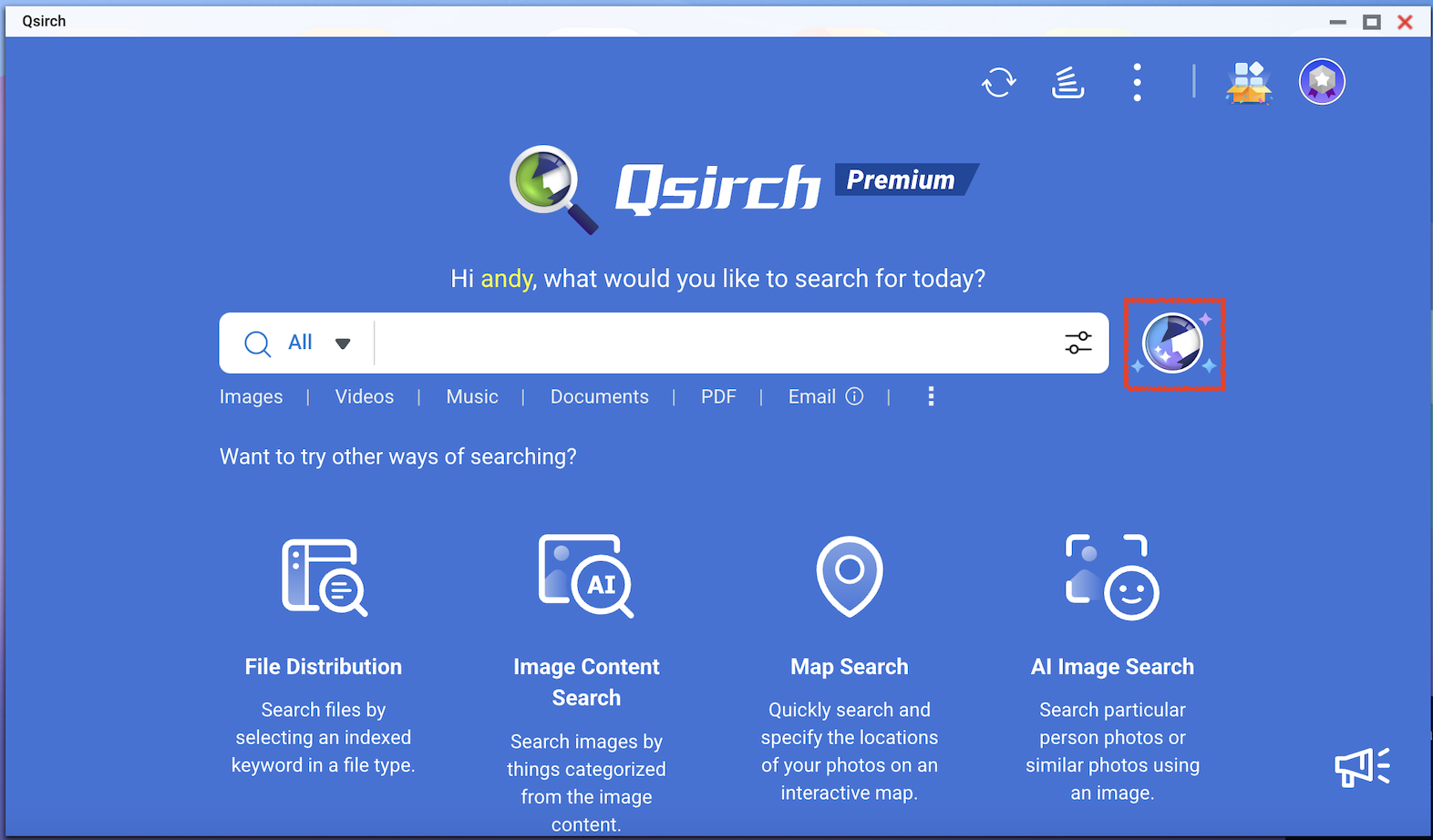

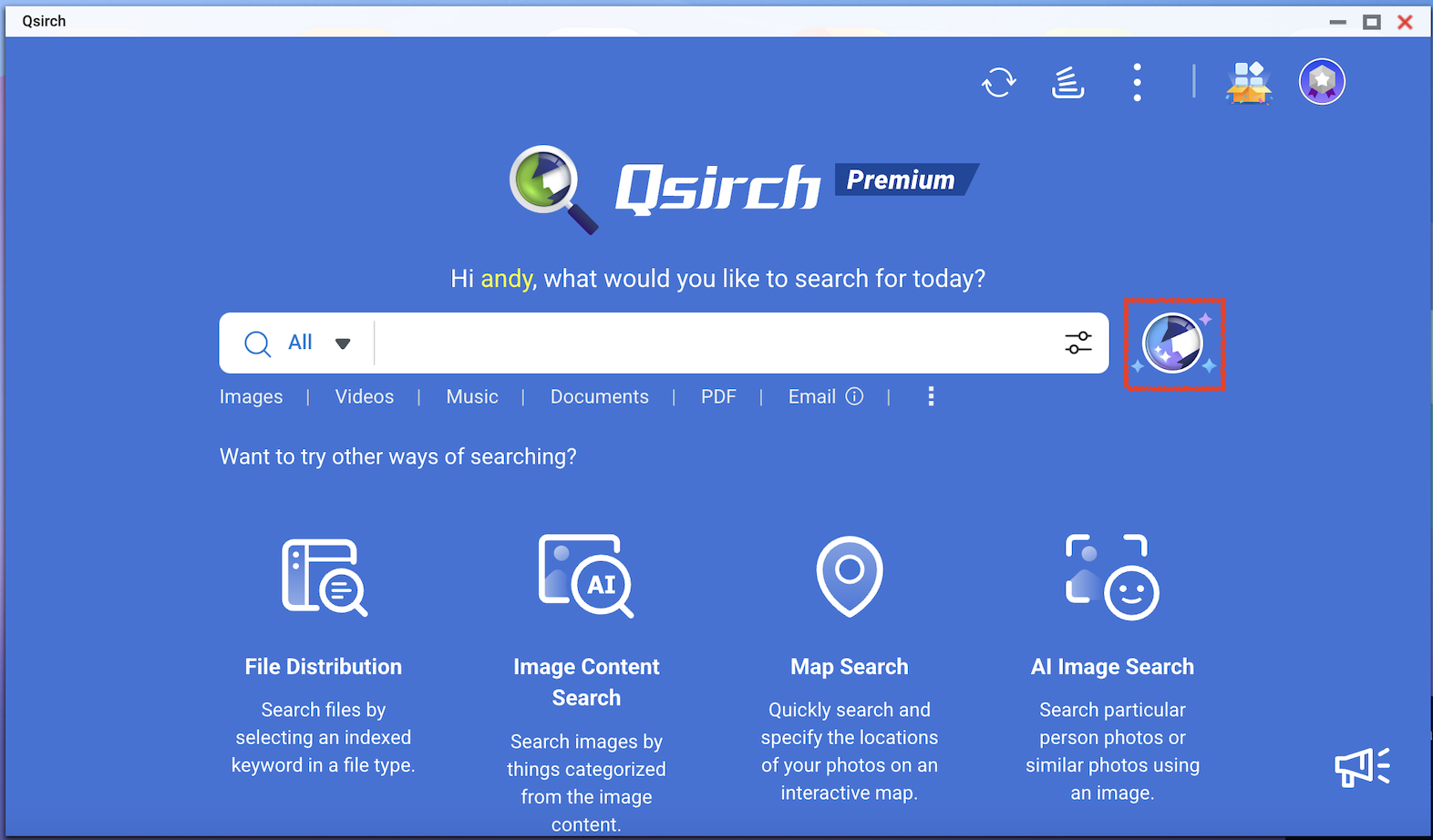

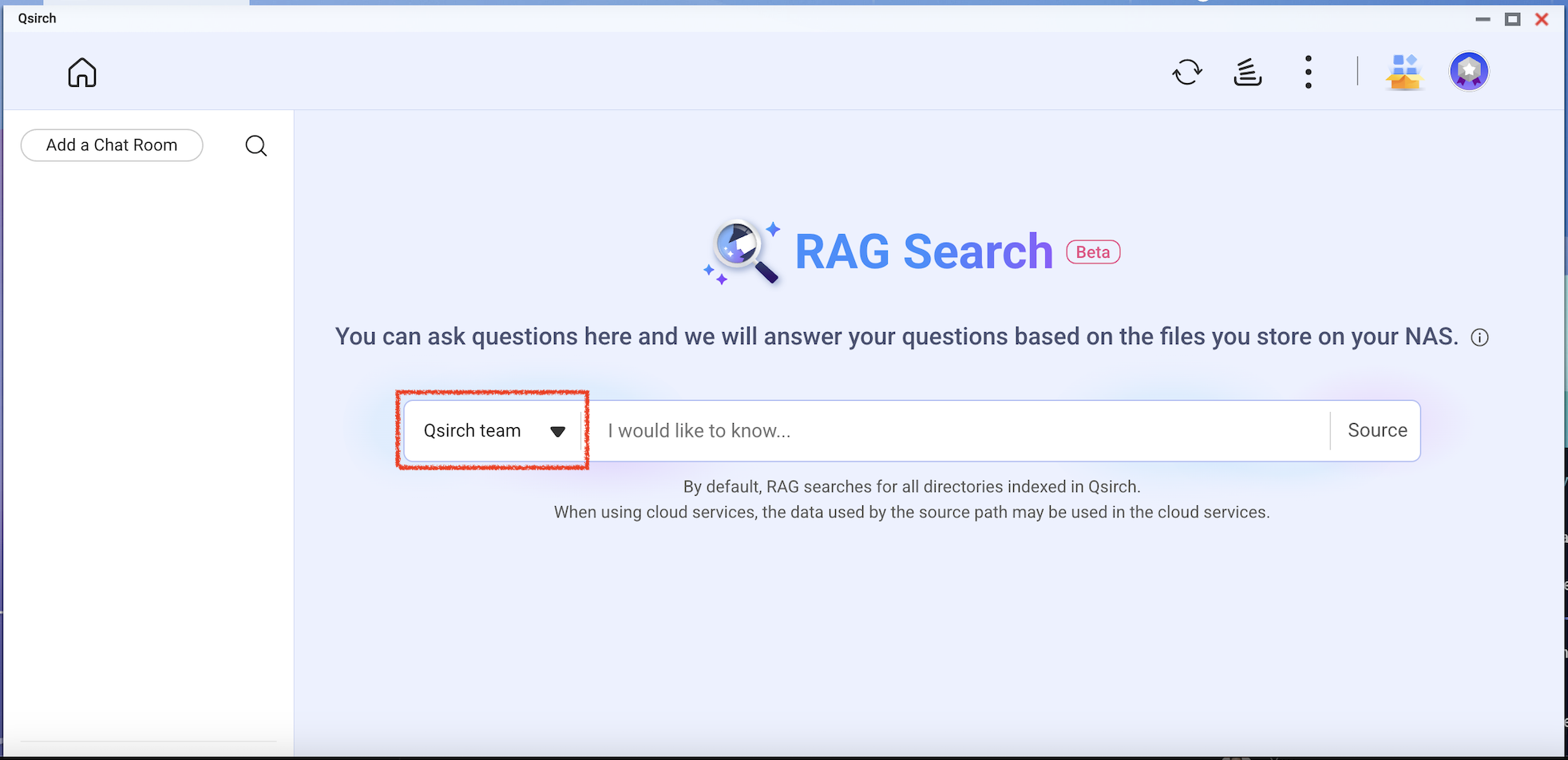

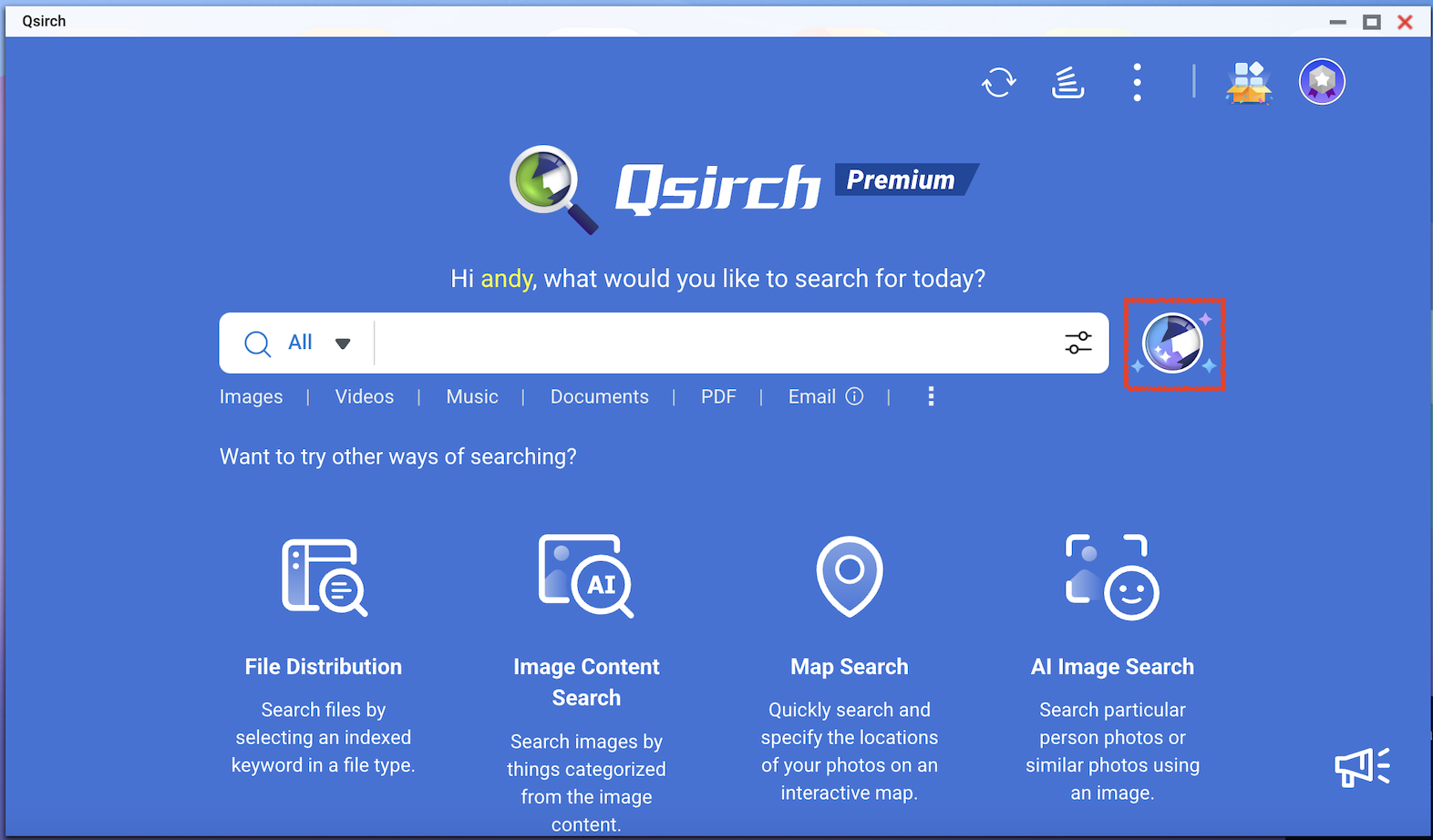

- Go to Qsirch home page and click the RAG search button.

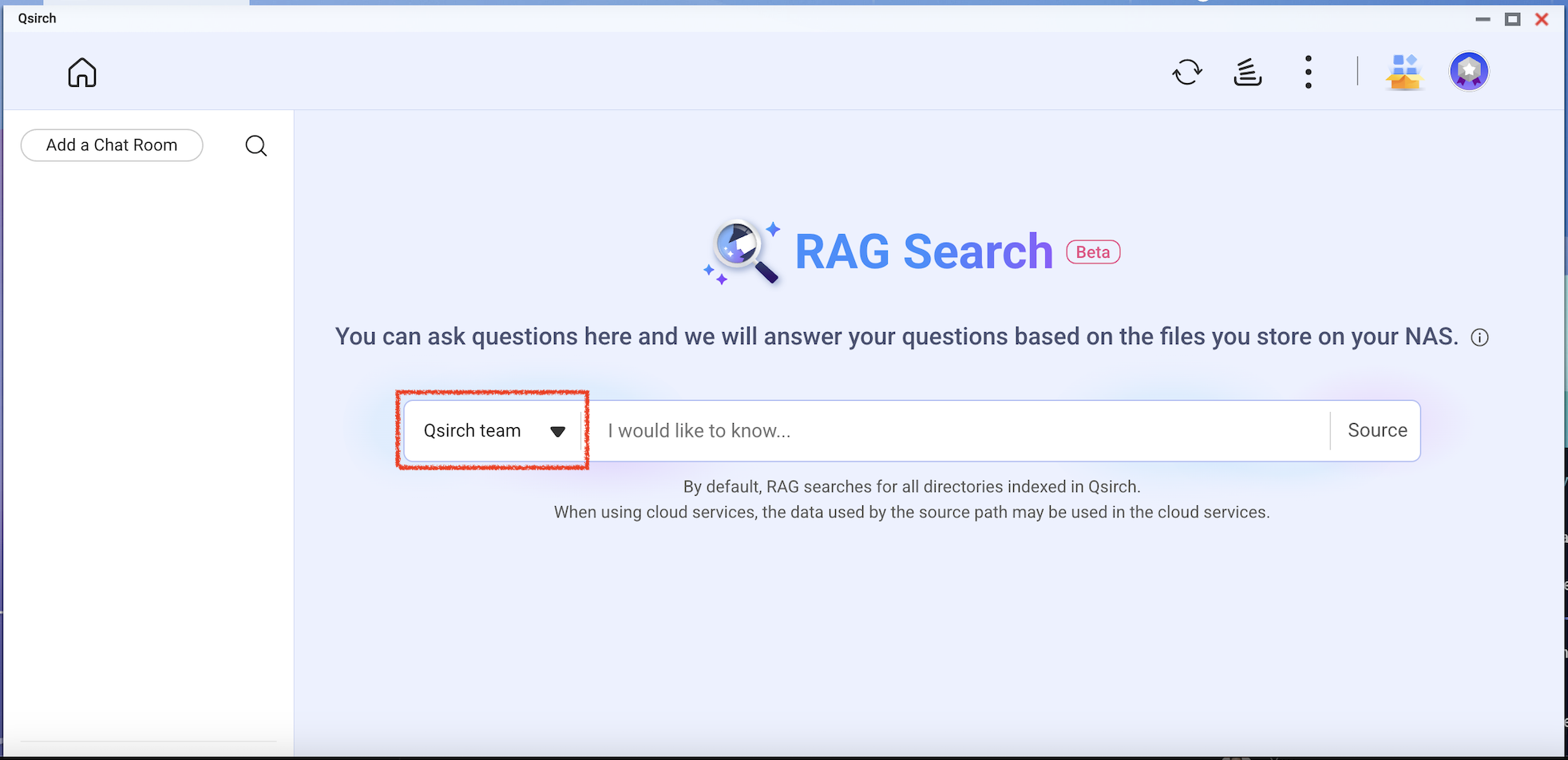

Qsirch RAG search will only use the files included in "Source" for data retrieval.

Check the model you want to use and then start using RAG search.

ผลิตภัณฑ์ที่รองรับ

Qsirch 6.0.0 (หรือใหม่กว่า) บนทุกแพลตฟอร์ม

Qsirch RAG ค้นหาด้วยคลาวด์และ LLMs ภายในองค์กร

Qsirch รองรับการใช้ Retrieval-Augmented Generation (RAG) กับโมเดลภาษาขนาดใหญ่บนคลาวด์ (LLMs) เพื่อให้คำตอบที่แม่นยำและมีบริบท เมื่อคุณป้อนคำค้นหา Qsirch จะดึงเอกสารที่เกี่ยวข้องจาก NAS ของคุณและใช้เป็นบริบทสำหรับโมเดลภาษา การผสมผสานระหว่างการค้นหาและ AI เชิงสร้างสรรค์นี้ทำให้ Qsirch สามารถสร้างคำตอบที่แม่นยำและมีข้อมูลตามข้อมูลของคุณเอง

Qsirch ยังรองรับการสนทนาแบบหลายรอบ ทำให้สามารถโต้ตอบได้อย่างเป็นธรรมชาติและมีบริบท ผู้ใช้สามารถถามคำถามต่อเนื่องได้โดยไม่ต้องทวนบริบทก่อนหน้า และบริบทจะถูกเก็บรักษาไว้ในแต่ละรอบเพื่อให้คำตอบที่สอดคล้อง การสนับสนุนการสนทนาแบบหลายรอบทำงานได้ทั้งในโหมด RAG บนคลาวด์และภายในองค์กร

ผสานรวม RAG กับบริการ AI บนคลาวด์

ในการผสานรวมการค้นหา RAG คุณต้องได้รับคีย์ API จากบริการ AI ที่คุณเลือกก่อน

ChatGPT (OpenAI API)

ChatGPT (OpenAI API) ให้บริการโมเดล GPT ที่ทรงพลังสำหรับทั้งการฝัง RAG และการตอบสนองเชิงสร้างสรรค์ ทำตามขั้นตอนด้านล่างเพื่อสมัครคีย์ API:

- สมัครบัญชีบน OpenAI: https://auth.openai.com/create-account

- สร้างคีย์ API ในการตั้งค่าบัญชี

สำหรับข้อมูลเพิ่มเติม ดูที่ เอกสาร API ของ OpenAI

Azure OpenAI

Azure OpenAI ให้การเข้าถึงโมเดล OpenAI (เช่น GPT-4.1) ผ่านโครงสร้างพื้นฐานของ Azure ซึ่งเหมาะสำหรับโซลูชันระดับองค์กร ทำตามขั้นตอนด้านล่างเพื่อสมัครคีย์ API:

- ลงชื่อเข้าใช้ พอร์ทัล Azure

- เลือกทรัพยากร OpenAI ของคุณ (หรือสร้างใหม่หากคุณยังไม่มี)

- ในเมนูด้านซ้าย คลิก คีย์และจุดสิ้นสุด

- คัดลอกคีย์ API และคัดลอกจุดสิ้นสุด (URL พื้นฐาน) สำหรับการร้องขอ API

สำหรับข้อมูลเพิ่มเติม ดูที่ เอกสาร Azure OpenAI

Gemini (Google Cloud AI)

Gemini (Google Cloud AI) ให้ชุดโมเดลที่ออกแบบมาสำหรับการให้เหตุผลที่มีประสิทธิภาพสูงและ RAG ทำตามขั้นตอนด้านล่างเพื่อสมัครคีย์ API:

- เยี่ยมชม เอกสาร Google Gemini API

- รับคีย์ API ของ Gemini ใน Google AI Studio

- ลงชื่อเข้าใช้บัญชี Google ของคุณ

- คลิก สร้างคีย์ API

สำหรับข้อมูลเพิ่มเติม ดูที่ เอกสาร Google Cloud AI

API ที่เข้ากันได้กับ OpenAI

API ที่เข้ากันได้กับ OpenAI ช่วยให้ผู้ใช้สามารถเข้าถึงโมเดล AI ต่างๆ นอกเหนือจากที่ OpenAI มีให้ รวมถึงโมเดลอย่าง DeepSeek และ Grok โดยใช้รูปแบบ API เดียวกัน ซึ่งช่วยให้สามารถผสานรวมกับแอปพลิเคชันที่สร้างขึ้นสำหรับ OpenAI API ได้อย่างราบรื่น ทำตามขั้นตอนด้านล่างเพื่อสมัครขอรับคีย์ API:

- เลือกผู้ให้บริการที่รองรับ API ที่เข้ากันได้กับ OpenAI (เช่น DeepSeek หรือ Grok)

- ลงทะเบียนบนแพลตฟอร์มของผู้ให้บริการ

- สร้างคีย์ API ในการตั้งค่าบัญชี

- อัปเดตจุดเชื่อมต่อ API และการตั้งค่าโมเดลตามที่ต้องการ

สำหรับข้อมูลเพิ่มเติม โปรดดูเอกสาร API อย่างเป็นทางการของผู้ให้บริการ

การค้นหา RAG ภายในองค์กร

สำหรับผู้ใช้ขั้นสูงและองค์กรที่ต้องการความเป็นส่วนตัวของข้อมูลอย่างเต็มที่หรือความสามารถ AI แบบออฟไลน์ Qsirch มีการค้นหา RAG ภายในองค์กรที่ขับเคลื่อนโดย LLMs ที่โฮสต์ในเครื่อง โหมดนี้ทำงานทั้งหมดบน NAS ของคุณหรือฮาร์ดแวร์ที่เชื่อมต่อ โดยไม่ส่งข้อมูลไปยังบริการภายนอก

หมายเหตุ

ฟีเจอร์นี้มีให้ใช้งานเฉพาะในรุ่น NAS บางรุ่นเท่านั้น สำหรับรายละเอียด โปรดดูที่

แนะนำการค้นหา RAG บนเว็บไซต์ QNAP

เพื่อเปิดใช้งาน RAG ภายในองค์กร:

- ตรวจสอบให้แน่ใจว่า LLM Core พร้อมใช้งาน

- ตั้งค่า GPU เป็นโหมด Container Station (ไปที่ แผงควบคุม > ฮาร์ดแวร์ > ทรัพยากรฮาร์ดแวร์ > การใช้ทรัพยากร > โหมด Container Station )

วิธีใช้การค้นหา RAG ใน Qsirch

- ไปที่ การตั้งค่า > การตั้งค่าผู้ดูแลระบบ > การค้นหา RAG

- เพิ่มบริการคลาวด์หนึ่งหรือมากกว่าเพื่อใช้การค้นหา RAG

(ไม่บังคับ) ตรวจสอบคีย์ API ของคุณ สิ่งนี้ช่วยตรวจสอบว่าคีย์ API ใช้ได้หรือไม่

ดาวน์โหลดโมเดล อุปกรณ์ปลายทาง (Edge) หนึ่งหรือมากกว่าจากบริการภายในองค์กร ฟีเจอร์นี้สามารถใช้ได้เฉพาะในรุ่น NAS บางรุ่นเท่านั้น

- เพิ่มโมเดล AI เพิ่มเติมที่เข้ากันได้กับ OpenAI API รวมถึงซีรีส์ GPT โมเดล DeepSeek และโมเดล Grok

- เลือกประเภทไฟล์สำหรับการค้นหา RAG ของคุณ

- ไปที่หน้าแรกของ Qsirch และคลิกปุ่มค้นหา RAG

การค้นหา RAG ของ Qsirch จะใช้เฉพาะไฟล์ที่รวมอยู่ใน "แหล่งที่มา" สำหรับการดึงข้อมูล

ตรวจสอบโมเดลที่คุณต้องการใช้แล้วเริ่มใช้การค้นหา RAG