Hur använder man stora språkmodeller för Qsirch RAG-sökning?

Tillämpliga produkter

Qsirch 6.0.0 (eller senare) på alla plattformar

Qsirch RAG-sökning med molnoch lokala LLM:er

Qsirch stöder användning av Retrieval-Augmented Generation (RAG) med molnbaserade stora språkmodeller (LLM) för att leverera exakta och kontextmedvetna svar. När du skriver in en fråga hämtar Qsirch relevanta dokument från din NAS och använder dem som kontext för språkmodellen. Denna kombination av sökning och generativ AI gör det möjligt för Qsirch att generera precisa och informerade svar baserat på dina egna data.

Qsirch stöder också flervändsamtal, vilket möjliggör naturliga och kontextmedvetna interaktioner. Användare kan ställa följdfrågor utan att upprepa tidigare kontext, och kontext bevaras över flera turer för sammanhängande svar. Stöd för flervändsamtal fungerar med både moln- och lokala RAG-lägen.

Integrera RAG med molnbaserade AI-tjänster

För att integrera RAG-sökning måste du först skaffa en API-nyckel från en AI-tjänst du väljer.

ChatGPT (OpenAI API)

ChatGPT (OpenAI API) tillhandahåller kraftfulla GPT-modeller för både RAG-inbäddningar och generativa svar. Följ stegen nedan för att ansöka om en API-nyckel:

- Registrera ett konto på OpenAI: https://auth.openai.com/create-account

- Skapa en API-nyckel i kontoinställningarna.

För mer information, se OpenAI API-dokumentation.

Azure OpenAI

Azure OpenAI ger tillgång till OpenAI-modeller (som GPT-4.1) via Azure-infrastruktur, vilket är idealiskt för företagslösningar. Följ stegen nedan för att ansöka om en API-nyckel:

- Logga in på Azure Portal.

- Välj din OpenAI-resurs (eller skapa en om du inte redan har en).

- I den vänstra menyn, klicka på Nycklar och slutpunkt.

- Kopiera en API-nyckel och kopiera slutpunkten (bas-URL) för API-förfrågningar.

För mer information, se Azure OpenAI-dokumentation.

Gemini (Google Cloud AI)

Gemini (Google Cloud AI) tillhandahåller en uppsättning modeller designade för högpresterande resonemang och RAG. Följ stegen nedan för att ansöka om en API-nyckel:

- Besök Google Gemini API-dokumentation.

- Skaffa en Gemini API-nyckel i Google AI Studio.

- Logga in på ditt Google-konto.

- Klicka på Skapa API-nyckel.

För mer information, se Google Cloud AI-dokumentation.

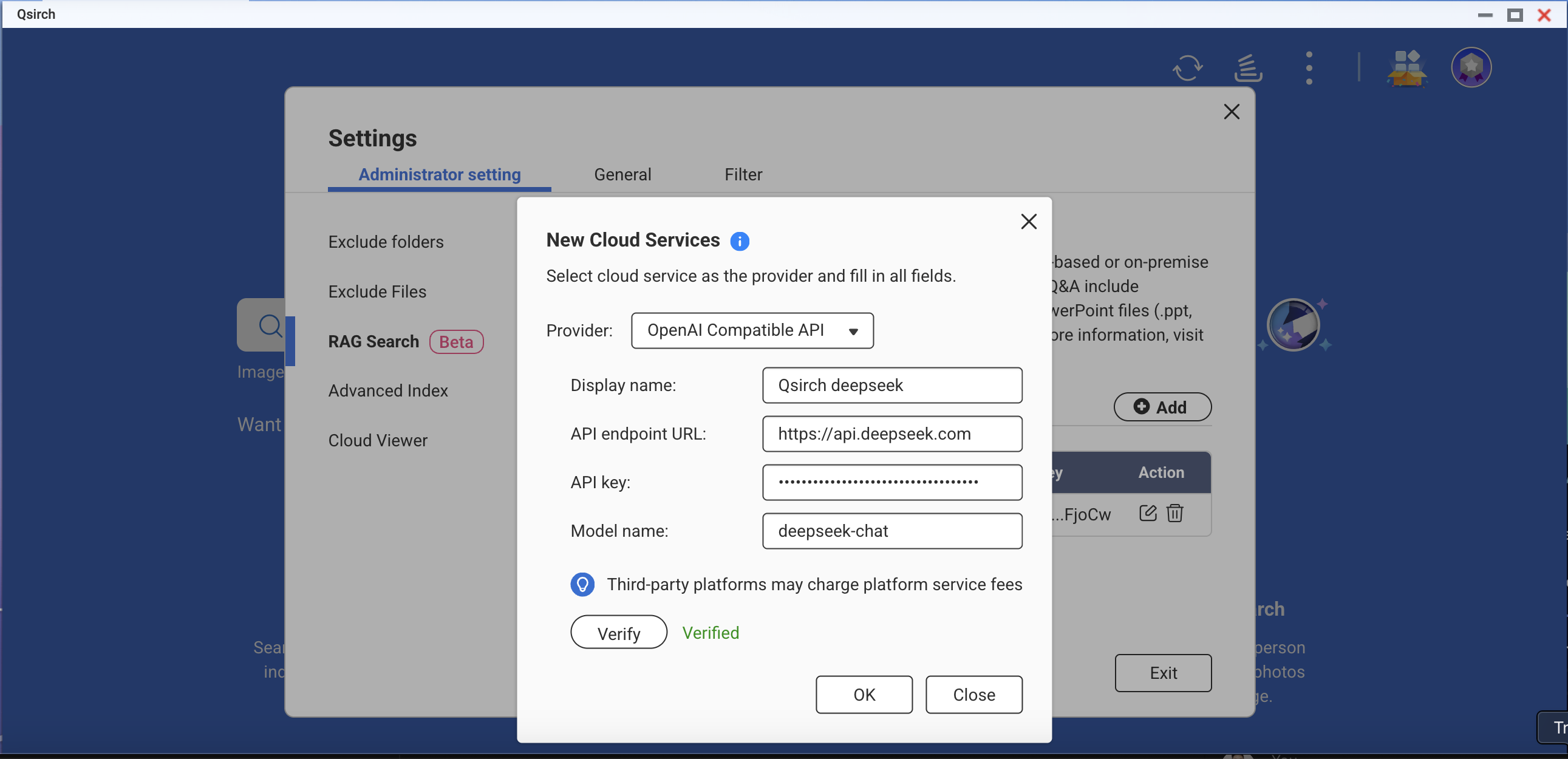

OpenAI-kompatibelt API

OpenAI-kompatibelt API tillåter användare att få tillgång till olika AI-modeller utöver OpenAIs egna erbjudanden, inklusive modeller som DeepSeek och Grok, med samma API-format. Detta möjliggör sömlös integration med befintliga applikationer byggda för OpenAI API. Följ stegen nedan för att ansöka om en API-nyckel:

- Välj en leverantör som stöder OpenAI-kompatibelt API (till exempel DeepSeek eller Grok).

- Registrera dig på leverantörens plattform.

- Generera en API-nyckel i kontoinställningarna.

- Uppdatera din API-endpoint och modellinställningar efter behov.

För mer information, se leverantörens officiella API-dokumentation.

On-Premise RAG-sökning

För att aktivera on-premise RAG:

- Säkerställ att LLM Core är redo.

- Ställ in GPU:n på Container Station-läge (Gå till Kontrollpanelen > Hårdvara > Hårdvaruresurser > Resursanvändning > Container Station-läge ).

Hur man använder RAG-sökning i Qsirch

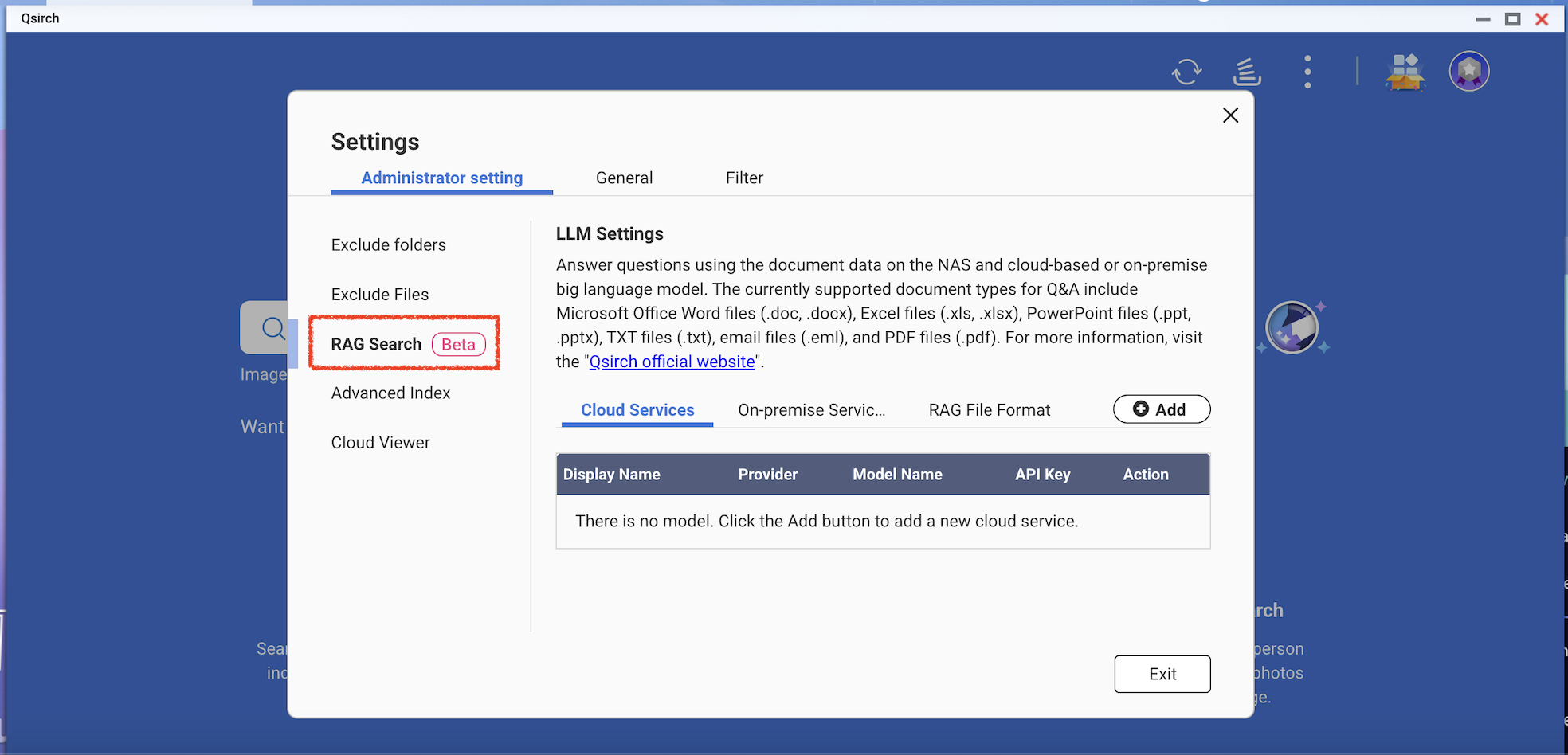

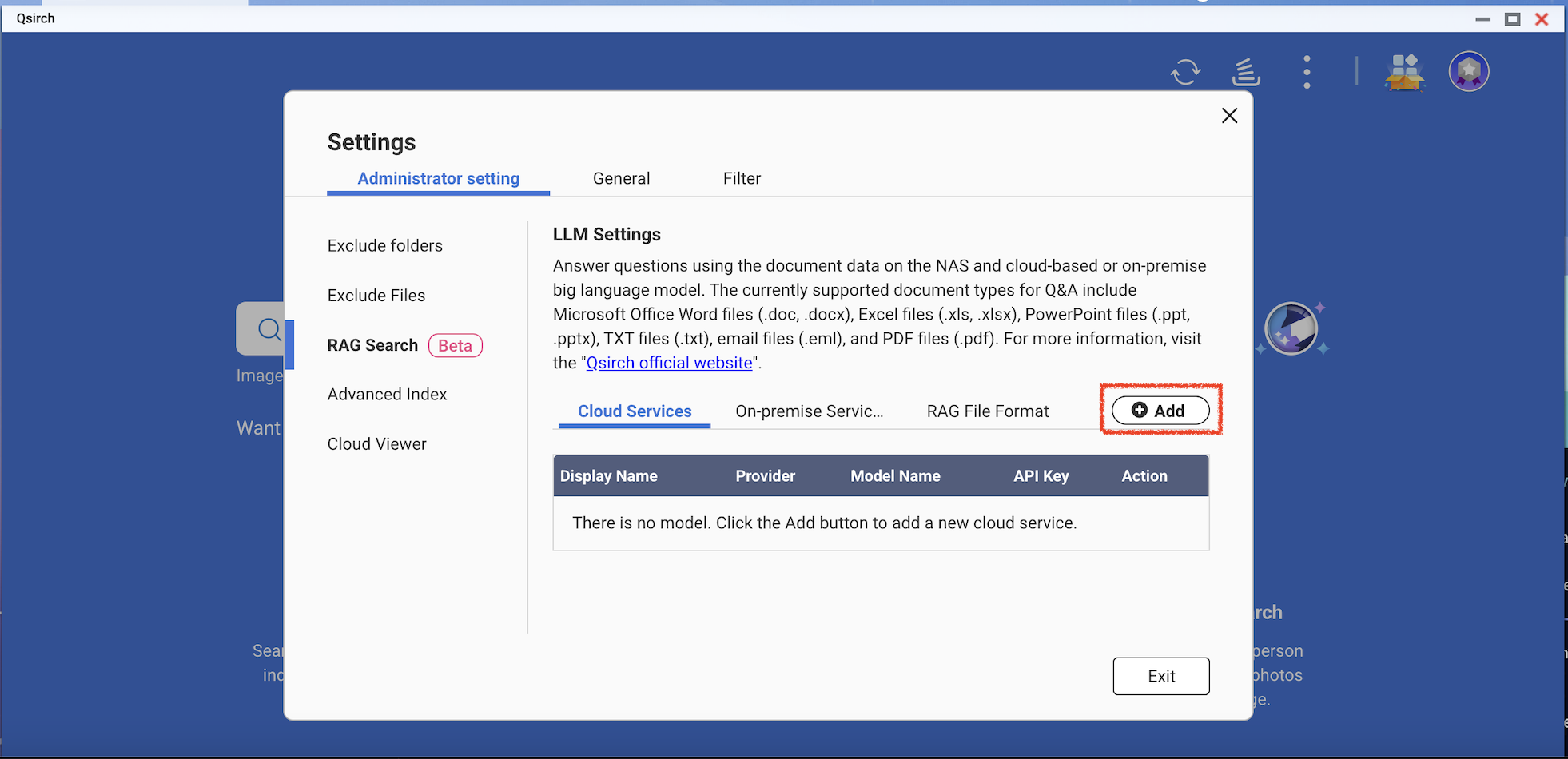

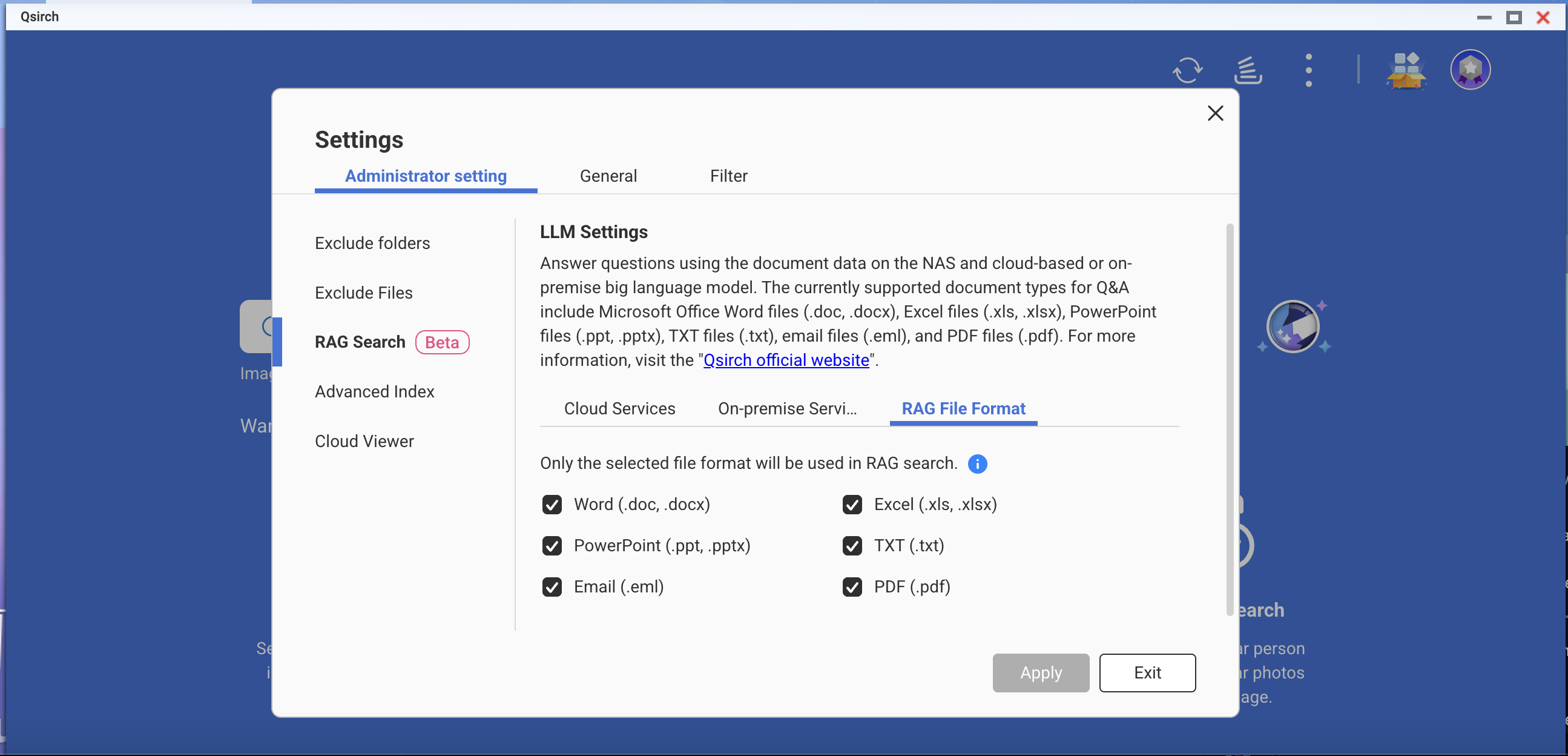

- Gå till Inställningar > Administrativa inställningar > RAG-sökning.

- Lägg till en eller flera molntjänster för att använda RAG-sökning.

(Valfritt) Verifiera din API-nyckel. Detta hjälper till att kontrollera om en API-nyckel är giltig.

Ladda ner en eller flera Gräns-modeller från on-premise-tjänsterna. Denna funktion kan endast användas på specifika NAS-modeller.

- Lägg till fler AI-modeller som är kompatibla med OpenAI API, inklusive GPT-serien, DeepSeek-modeller och Grok-modeller.

- Välj filformat för din RAG-sökning.

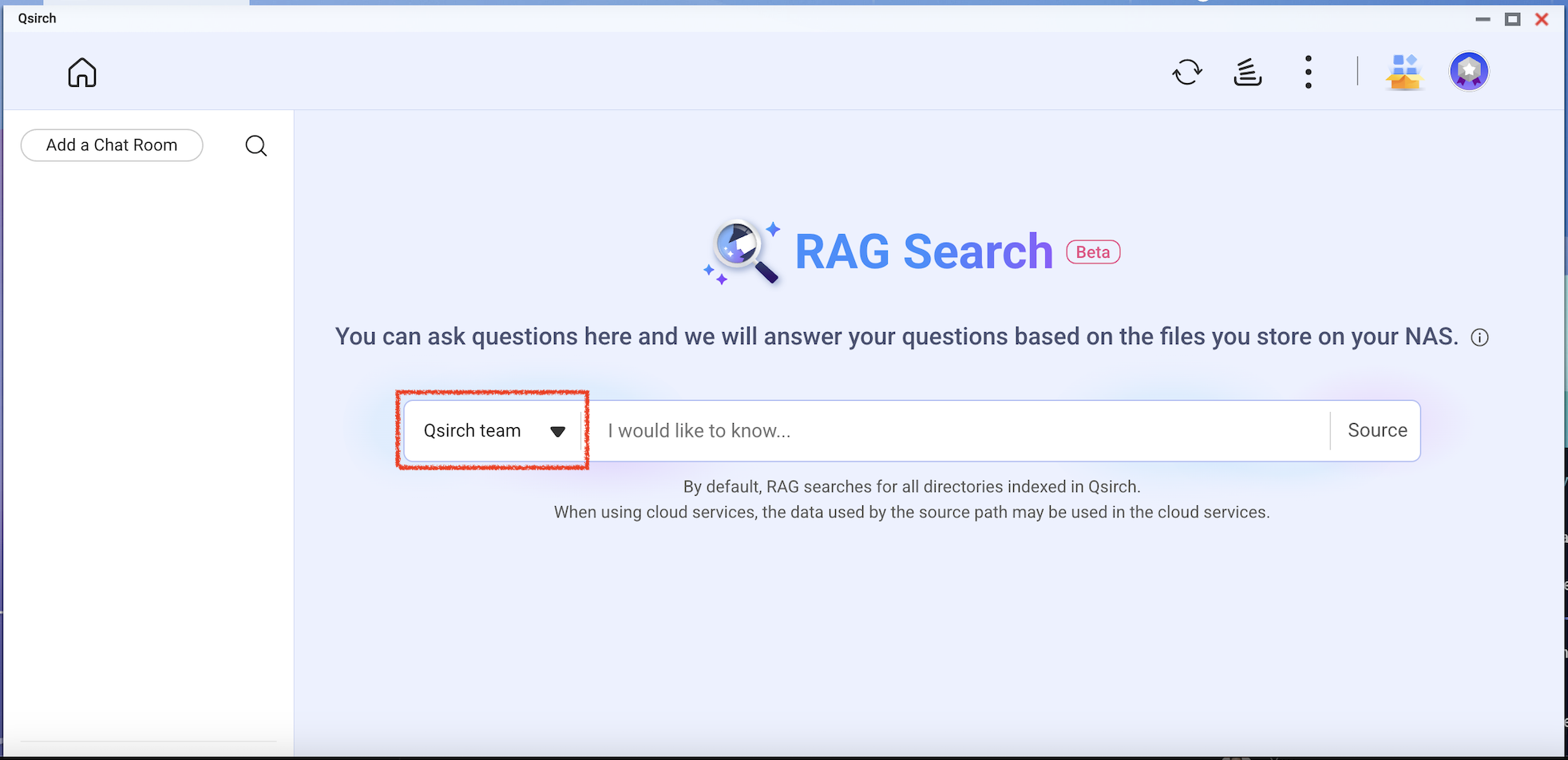

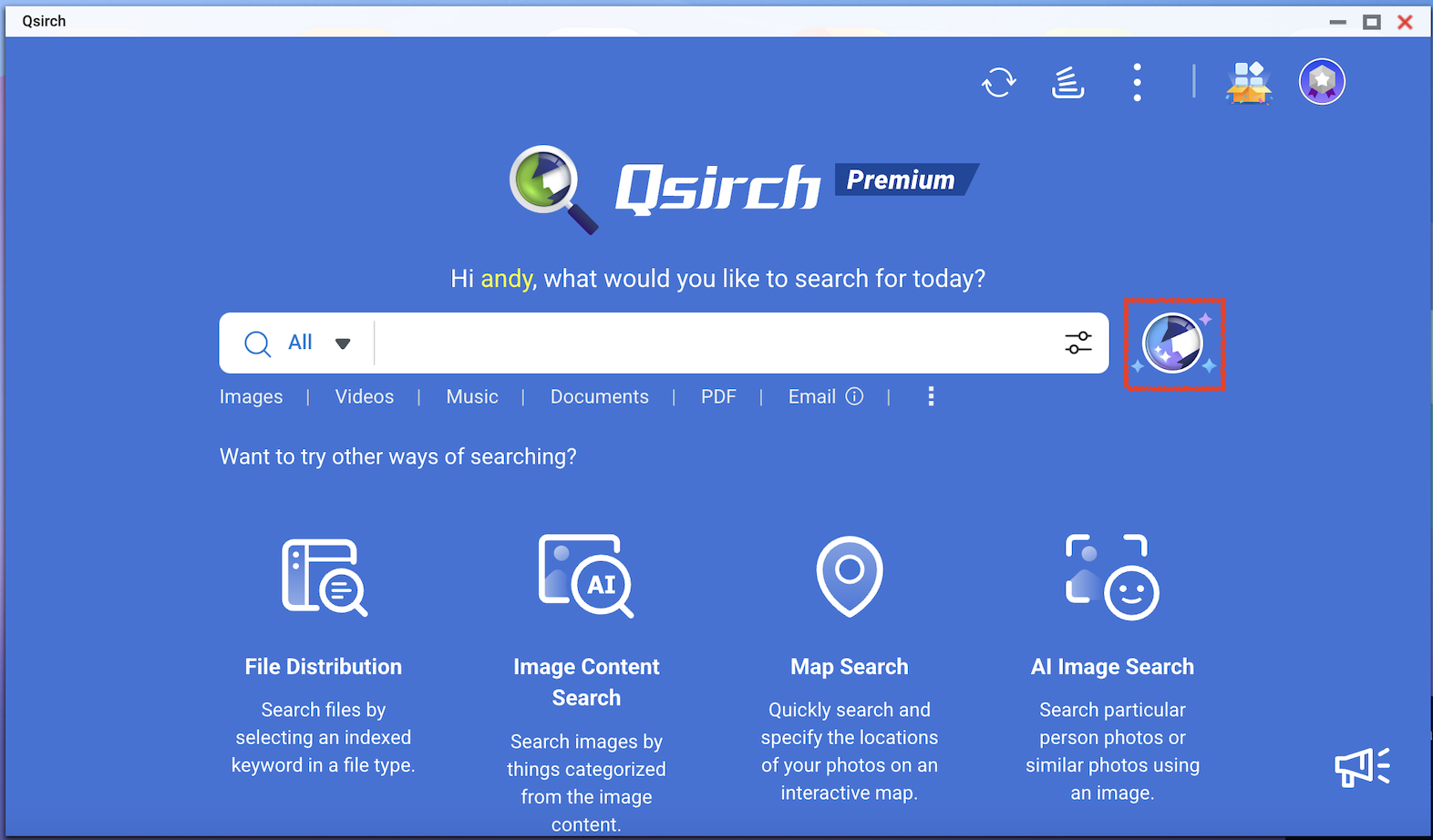

- Gå till Qsirch startsida och klicka på RAG-sökningsknappen.

Qsirch RAG-sökning kommer endast att använda de filer som ingår i "Källa" för datahämtning.

Kontrollera modellen du vill använda och börja sedan använda RAG-sökning.