Tutorial de la Herramienta de consolidación del flujo de trabajo OpenVINO™

Información

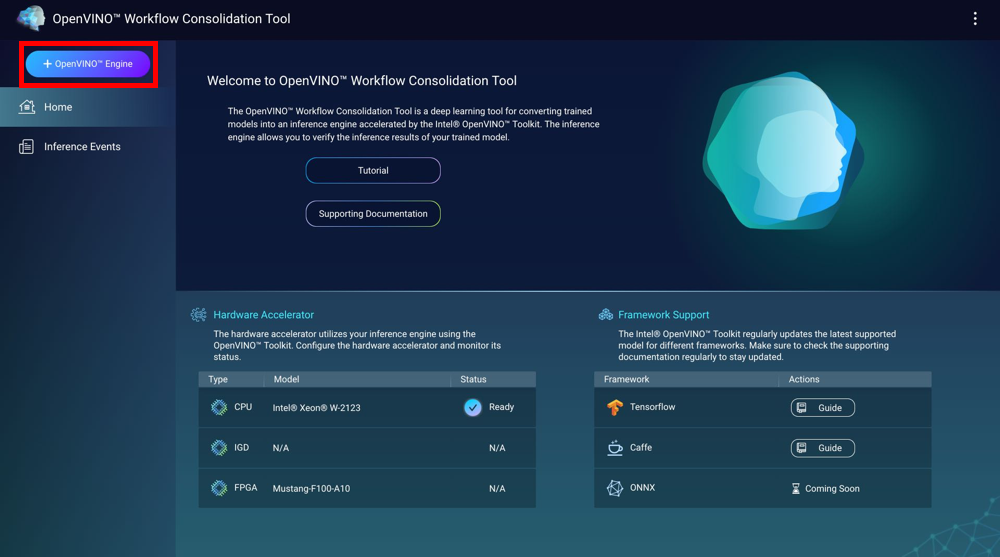

La Herramienta de consolidación del flujo de trabajo OpenVINO™ (OWCT) es una herramienta de aprendizaje profundo para convertir los modelos configurados en motores de inferencia acelerados mediante la Distribución Intel® del conjunto de herramientas OpenVINO™. Los motores de inferencia le permiten verificar los resultados de inferencia de los modelos configurados.

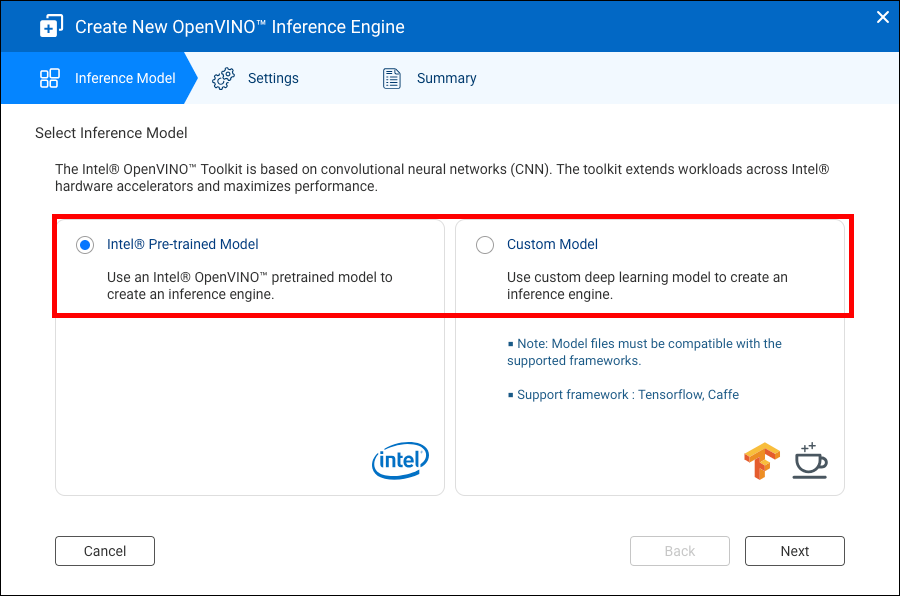

La Distribución Intel® del conjunto de herramientas OpenVINO™ se basa en redes neurológicas convolucionales (CNN, convolutional neural networks). El conjunto de herramientas amplía las cargas de trabajo en todos los aceleradores de hardware Intel® y maximiza el rendimiento.

Container Station debe estar instalado para usar el OWCT.

- Compatibilidad

- Aceleradores de hardware

- Creación de motores de inferencia

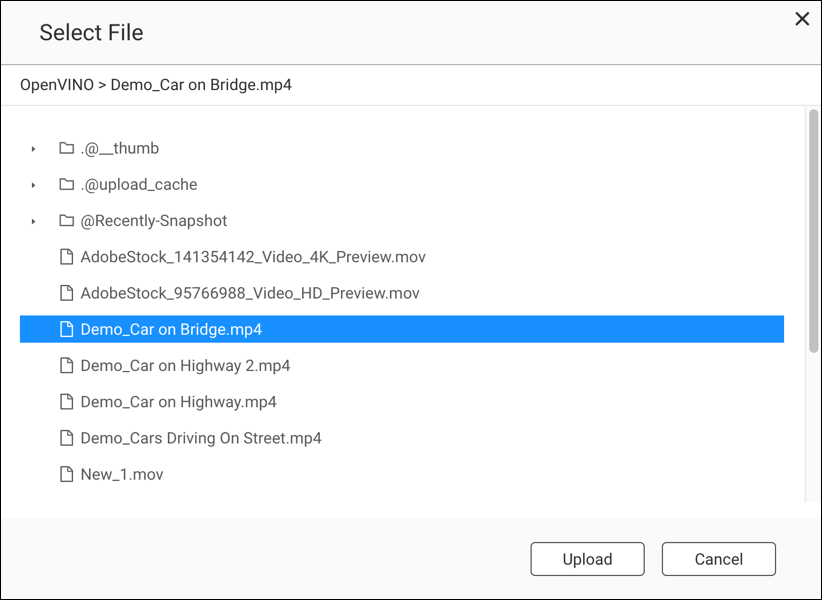

- Uso de la visión informática con motores de inferencia

- Administración de motores de inferencia

Compatibilidad

|

Plataforma |

Compatibilidad |

|---|---|

|

Modelos de NAS |

Nota:

Solo los modelos de NAS basados en Intel admiten la herramienta de consolidación del flujo de trabajo OpenVINO™. |

|

SO |

QTS 4.4 |

|

Distribución Intel® del Conjunto de herramientas OpenVINO™ versión |

2018R5 Para obtener más información, vaya a https://software.intel.com/en-us/articles/OpenVINO-RelNotes. |

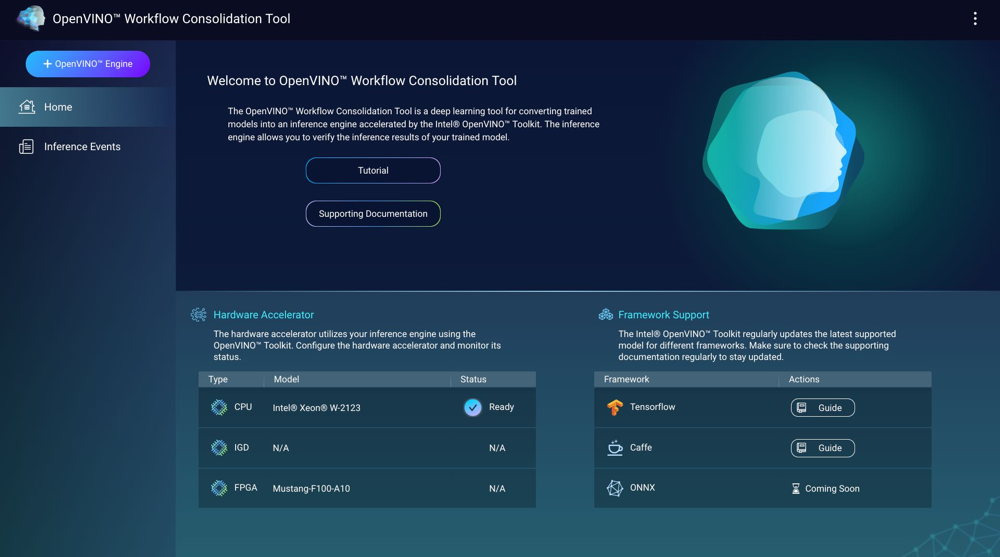

Aceleradores de hardware

Puede usar los aceleradores de hardware instalados en su NAS para mejorar el rendimiento de sus motores de inferencia.

Los aceleradores de hardware instalados en el NAS se muestran en la pantalla Inicio.

Los aceleradores de hardware con el estado Listo se pueden usar al crear motores de inferencia.

Si el estado que se muestra es Configuración, vaya a para configurar el acelerador de hardware.

-

Para usar tarjetas de matriz de puertas programables en campo (FPGA) en un NAS de QNAP, se debe deshabilitar la salida directa de la máquina virtual (VM).

-

Cada recurso FPGA puede crear un motor de inferencia.

- Cada unidad de procesamiento de visión (VPU) puede crear un motor de inferencia.

Creación de motores de inferencia

Utilice el OWCT para crear motores de inferencia y configurar parámetros de inferencia.

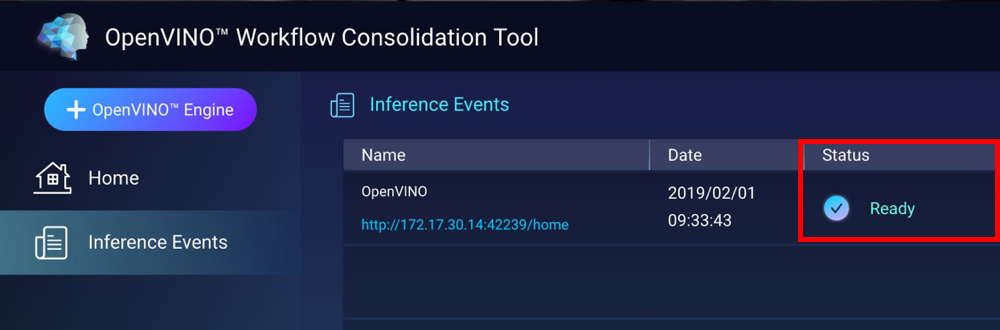

El OWCT crea el motor de inferencia y se muestra en la pantalla Eventos de inferencia.

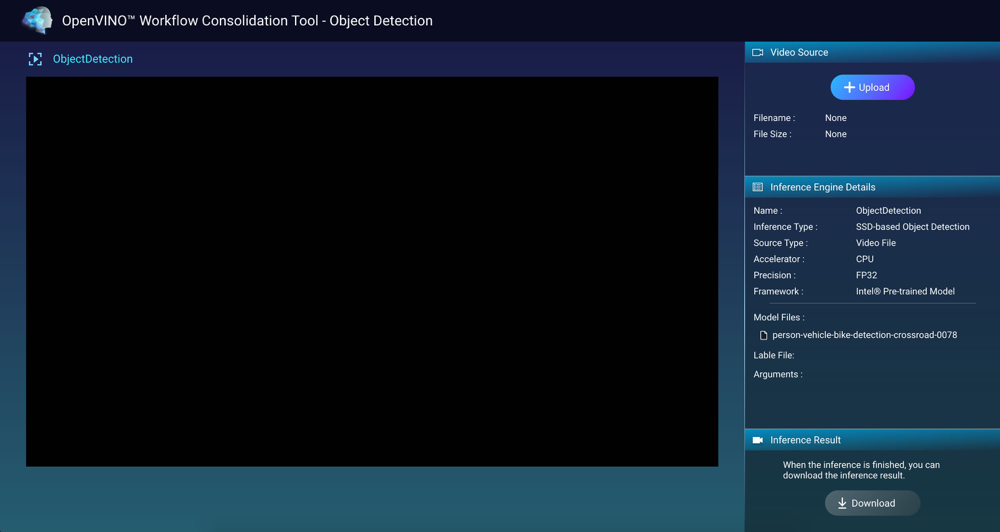

Uso de la visión informática con motores de inferencia

Administración de motores de inferencia

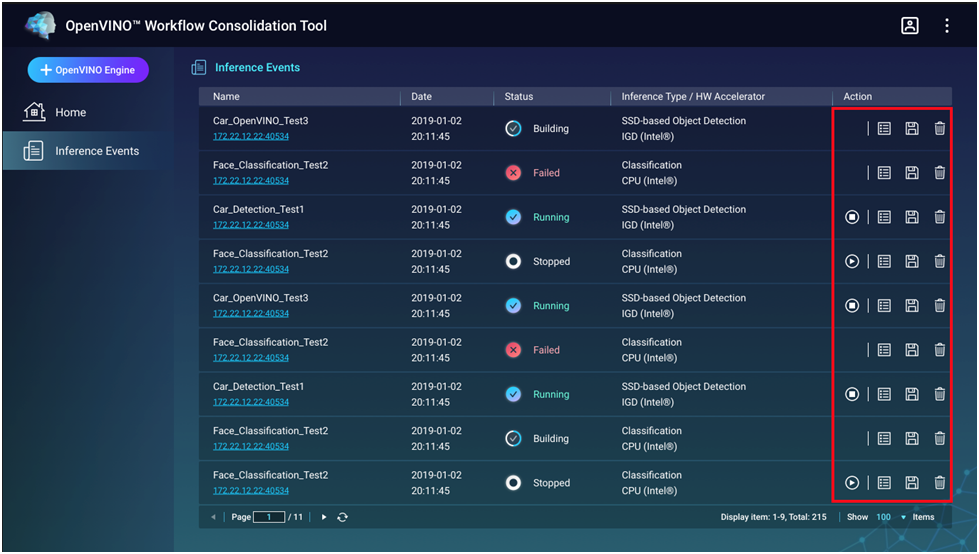

Puede ver y administrar los motores de inferencia en la pantalla Eventos de inferencia.

|

Botón |

Descripción |

|---|---|

|

|

Se inicie el proceso de inferencia. |

|

|

Se detiene el proceso de inferencia. |

|

|

Muestra los detalles y el estado de registro del motor de inferencia. |

|

|

Guarde el motor de inferencia como un archivo de Representación intermedia (IR) para aplicaciones avanzadas. |

|

|

Elimina el motor de inferencia. |