Outil de consolidation du flux de travail OpenVINO™

Accélérez, simplifiez et vérifiez l’inférence de l’apprentissage profond

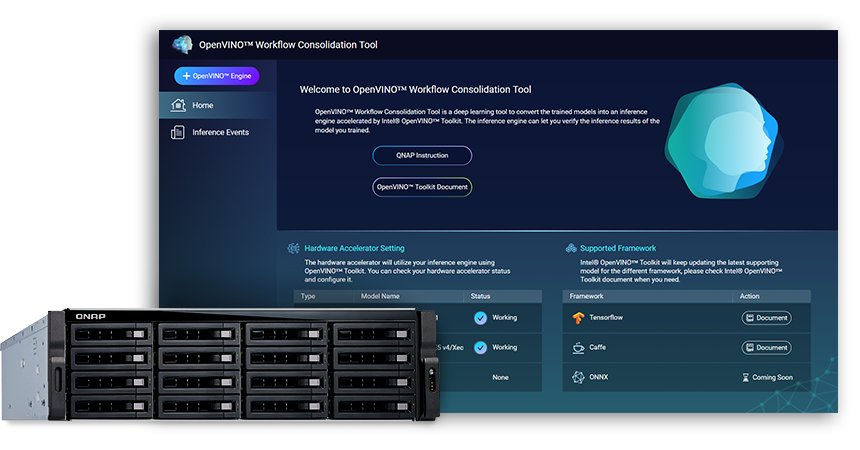

L’Outil de consolidation du flux de travail OpenVINO™ (OWTC) (disponible via le QTS App Center) est un outil d’apprentissage profond pour convertir des modèles formés en un service d’inférence accéléré par la Distribution Intel® du kit d’outils OpenVINO™ (Inférence visuelle ouverte et Optimisation du réseau neuronal) qui aide à distribuer de façon économique les solutions de vision qui tirent profit de l’IA.

QNAP propose l’Outil de consolidation du flux de travail OpenVINO™ pour renforcer le NAS QNAP en tant que Serveur d’inférence.

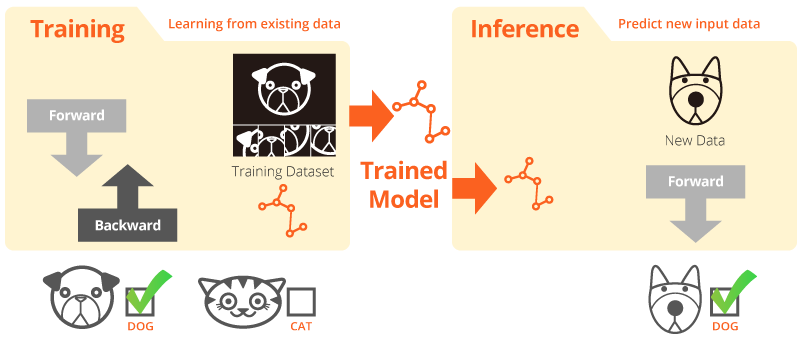

Formation et inférence

La « formation » est lorsque le système apprend à partir de données existantes. « L’inférence » est lorsqu’un modèle est utilisé pour effectuer des prédictions utiles avec les données du monde réel.

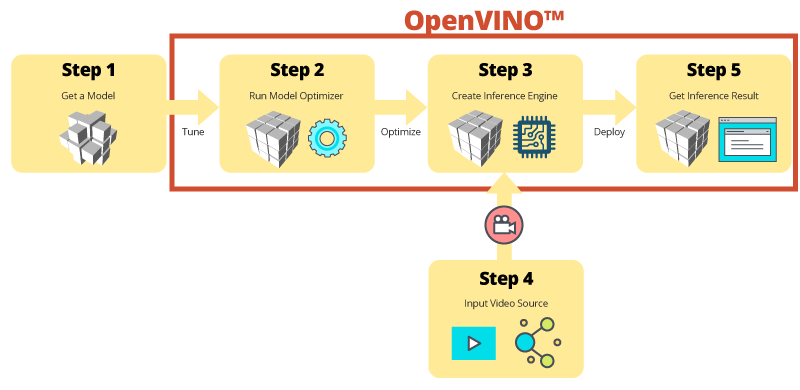

Distribution Intel® du kit d’outils OpenVINO™

Le kit d’outils OpenVINO™ aide au développement accéléré de la vision informatique et de l’apprentissage profond de haute performance en applications de vision. Il permet l’apprentissage profond sur des accélérateurs matériels et l’exécution simple et hétérogène sur les plates-formes Intel®, dont les processeurs, les cartes graphiques, les FPGA et les VPU. Les principaux composants incluent :

- Le kit d’outils de déploiement pour l’apprentissage profond Intel® (Optimisateur de modèle et moteur d’inférence)

- Fonctions optimisées pour OpenCV* et OpenVX*

- Fournit plus de 15 exemples de codes et modèles préformés pour un déploiement facile

Source : Intel

Votre inférence IA pour la vision informatique, désormais plus rapide !

Avantages clés d’utiliser l’Outil de consolidation du flux de travail OpenVINO™ (OWCT) :

-

Accélération

Le kit d’outils OpenVINO™ contient une bibliothèque open source qui permet de réduire le temps de développement, et qui simplifie l’inférence de l’apprentissage profond et le déploiement des solutions axées sur la vision.

-

Optimisation

L’optimisateur de modèle convertit les modèles formés en une représentation intermédiaire (IR) et effectue les optimisations de base d’une inférence efficace.

-

GUI

OWCT utilise une GUI qui permet aux utilisateurs d’utiliser facilement les capacités d’OpenVINO™, d’afficher les visuels et de télécharger le résultat de l’inférence.

Inférence étape par étape avec OWCT

L’OWCT consolide toutes les fonctionnalités nécessaires d’OpenVINO™ pour vous aider à créer le Moteur d’inférence et à examiner les résultats d’inférence du modèle. Suivez simplement l’assistant de l’appli, puis configurez les choses en quelques étapes !

Utilisez les modèles préformés pour accélérer le développement

En plus de rechercher ou de former vos propres modèles, le kit d’outils OpenVINO™ fournit également des modèles préformés et optimisés Intel® dans les applications d’utilisateurs, désignés par le terme Moteur d’inférence.

-

Le kit d’outils OpenVINO™ comprend deux ensembles de modèles optimisés. Vous pouvez ajouter directement ces modèles à votre environnement et accélérer votre développement.

Modèles préformés :

- Reconnaissance de l’âge et du genre

- Croisement

- Position de tête

- Barrières de sécurité

- Reconnaissance des fonctionnalités d’un véhicule

- ... et plus encore

-

Importez vos propres modèles formés afin de tirer profit de l’optimisation à partir de l’Optimisateur de modèle et du Moteur d’inférence. Ainsi, vous pouvez facilement exécuter une inférence pour la vision informatique sur les architectures Intel® actuelles et futures pour répondre à vos besoins d’IA. Le kit d’outils OpenVINO™ fonctionne avec des modèles préformés qui utilisent les formats Caffe ou TensorFlow.

NAS QNAP comme serveur d’inférence

Le kit d’outils OpenVINO™ augmente les charges de travail sur le matériel Intel® (dont les accélérateurs) et maximise les performances. S’il est utilisé avec l’Outil de consolidation du flux de travail OpenVINO™, le NAS QNAP sous Intel® représente un Serveur d’inférence idéal qui aide les organisations à établir rapidement un système d’inférence. En fournissant un optimisateur de modèle et un moteur d’inférence, le kit d’outils OpenVINO™ est simple d'utilisation et flexible pour la vision par ordinateur à haute performance et à faible latence qui améliore l’inférence de l’apprentissage profond. Les développeurs IA peuvent déployer des modèles formés sur un NAS QNAP pour l’inférence, et installer des accélérateurs matériels basés sur les plates-formes Intel® afin d’atteindre des performances optimales pour exécuter l’inférence.

Moteur d’inférence facile à gérer

-

Transférez un fichier vidéo

-

Téléchargez le résultat de l’inférence

Performances améliorées avec les cartes accélératrices

Le kit d’outil OpenVINO™ prend en charge l’exécution hétérogène sur des accélérateurs de vison informatique (processeur, carte graphique, FPGA et VPU) en utilisant une API courante pour l’optimisation spécifique aux appareils.

-

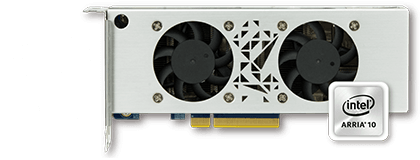

AccélérateurFPGA

- Intel® Arria® 10 GX 1150 FPGA

- PCIe 3.0 x8

- Low profile, demi-format, deux emplacements

-

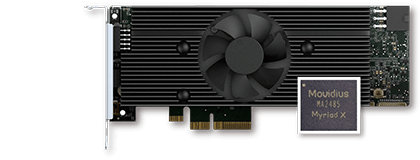

AccélérateurVPU

- Solution Intel® Movidius™

- 8x Myriad™ X VPU

- PCIe 2.0 x4

- Low profile, demi-format, un emplacement

Série TVS-x72XU |

Série TVS-x72XT |

TS-2888X |

|---|---|---|

Remarque :

- QTS 4.4.0 (ou version ultérieure) et OWCT v1.1.0 sont requis pour les NAS QNAP.

- Pour utiliser le calcul de la carte FPGA sur le NAS QNAP, la fonction de passthrough VM sera désactivée. Afin d’éviter une éventuelle perte de données, assurez-vous que toutes les tâches en cours sur le NAS sont terminées avant de redémarrer.

- Liste complète des modèles pris en charger (consultez la note de publication OWCT)

- TVS-x72XT : Processeur, iGD, VPU (Remarque : le modèle TVS-472XT n'est pas pris en charge)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINO et le logo OpenVINO sont des marques commerciales d'Intel Corporation ou de ses filiales aux États-Unis et/ou dans d'autres pays.