Nástroj OpenVINO™ pro konsolidaci pracovních postupů

Urychlení, zefektivnění a ověřování inference hlubokého učení

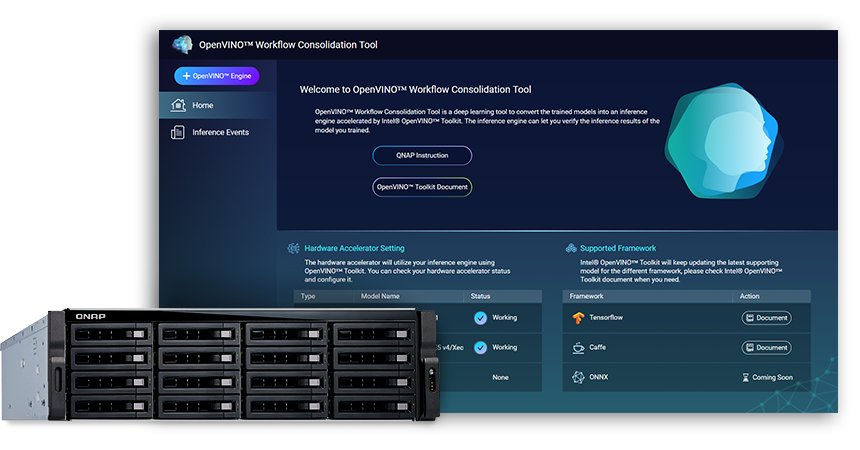

Nástroj pro konsolidaci pracovních postupů OpenVINO™ (OWCT) (k dispozici na QTS App Center) je nástrojem pro hluboké učení pro převádění vycvičených modelů na inferenční službu akcelerovanou pomocí sady nástrojů Intel® Distribution of OpenVINO™ Toolkit (Open Visual Inference and Neural Network Optimization), která napomáhá ekonomicky distribuovat vizuální řešení podporující AI.

Společnost QNAP poskytuje nástroj pro konsolidaci pracovních postupů OpenVINO™, který umožňuje, aby zařízení QNAP NAS mohlo pracovat jako inferenční server.

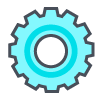

Cvičení a inference

„Cvičením“ se míní učení systému ze stávajících dat. „Inference“ je využití vycvičeného modelu k provádění užitečných predikcí pomocí dat z reálného světa.

Sada nástrojů Intel® Distribution of OpenVINO™ Toolkit

Sada nástrojů OpenVINO™ napomáhá s rychlým převodem vysoce výkonného počítačového vidění a hlubokého učení na vizuální aplikace. Umožňuje hluboké učení na hardwarových akcelerátorech a snadnou heterogenní realizaci napříč platformami Intel®, včetně CPU, GPU, FPGA a VPU. K hlavním komponentům patří:

- Sada nástrojů Intel® Deep Learning Deployment Toolkit (Optimalizátor modelů a inferenční modul)

- Optimalizované funkce pro OpenCV* a OpenVX*

- Nabízí více než 15 vzorových kódů a předem vycvičené modely pro snadnou implementaci

Zdroj: Intel

Vaše inference AI pro počítačové vidění, nyní rychleji!

Hlavní výhody používání nástroje pro konsolidaci pracovních postupů OpenVINO™ (OWCT):

-

Urychlení

Sada nástrojů OpenVINO™ obsahuje knihovnu s otevřeným zdrojovým kódem, která pomáhá snížit dobu vývoje a zefektivnit inferenci hlubokého učení a implementaci řešení v oblasti vidění.

-

Optimalizace

Optimalizátor modelů převádí vycvičené modely na přechodné zastoupení (intermediate representation, IR) a provádí základní optimalizaci pro efektivní inferenci.

-

GUI

OWCT využívá rozhraní GUI, které uživatelům umožňuje snadno využívat možnosti OpenVINO™, zobrazovat vizuály a stáhnout výsledek inference.

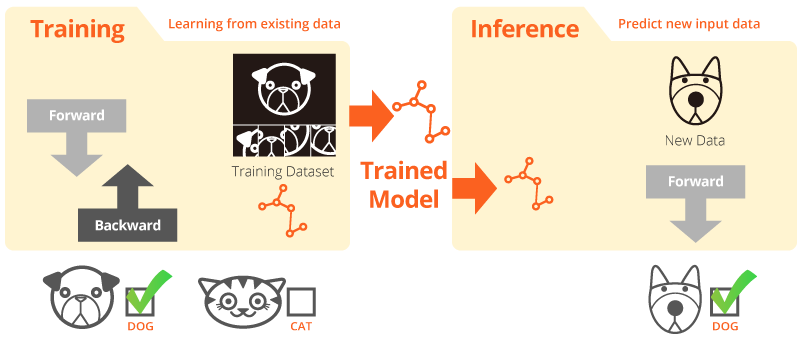

Postup inference s využitím OWCT

OWCT konsoliduje všechny nezbytné funkce OpenVINO™, abyste mohli vytvořit inferenční modul a kontrolovat inferenční výsledky modelu. Jednoduše postupujte podle průvodce aplikace a v pouhých několika krocích si věci nastavte!

Urychlení vývoje pomocí předem vycvičených modelů

Kromě vyhledávání nebo školení vlastních modelů sada nástrojů OpenVINO™ také poskytuje předem vycvičené modely optimalizované pro Intel® v uživatelských aplikacích, které se označují jako inferenční moduly.

-

Sada nástrojů OpenVINO™ obsahuje dvě sady optimalizovaných modelů. Tyto modely můžete přímo přidat do svého prostředí a vývoj akcelerovat.

Předem vycvičené modely:

- Rozpoznávání věku a pohlaví

- Křižovatka

- Poloha hlavy

- Bezpečnostní zábrany

- Rozpoznávání funkcí vozidel

- ... atd.

-

Importujte si vlastní vycvičené modely a využijte optimalizace pomocí optimalizátoru modelů a inferenčního modulu, abyste nakonec mohli snadno používat inferenci pro počítačové vidění u současné a budoucích architektur Intel® podle svých potřeb v oblasti AI. Sada nástrojů OpenVINO™ pracuje s předem vycvičenými modely využívající formáty Caffe nebo TensorFlow.

Zařízení QNAP NAS jako inferenční server

Sada nástrojů OpenVINO™ rozšiřuje pracovní zatížení na hardware Intel® (včetně akcelerátorů) a maximalizuje výkon. Pokud QNAP NAS na bází Intel® použijete s nástrojem OpenVINO™ pro konsolidaci pracovních postupů, může tato řada sloužit jako ideální inferenční server, který organizacím pomáhá rychle vybudovat inferenční systém. Sada nástrojů OpenVINO™ s modelovým optimizátorem a inferenčním modulem se snadné používá a je flexibilní pro vizi výkonného, nízkolatenčního počítače pro vylepšení inference hlubokého zkoumání. Vývojáři AI mohou do zařízení QNAP NAS zavádět vycvičené modely za účelem inference a instalovat hardwarové akcelerátory na bázi platforem Intel® pro dosažení optimálního výkonu pro běžící inferenci.

Inferenční modul pro snadnou správu

-

Odeslat soubor videa

-

Stáhnout výsledek inference

Vylepšený výkon s akcelerátorovými kartami

Sada nástrojů OpenVINO™podporuje heterogenní realizaci napříč akcelerátory počítačového vidění (CPU, GPU, FPGA a VPU) pomocí společné optimalizace API pro příslušná zařízení.

-

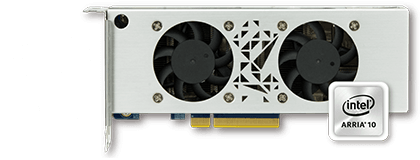

AkcelerátorFPGA

- Intel® Arria® 10 GX 1150 FPGA

- PCIe 3.0 x8

- Nízký profil, poloviční velikost, dva sloty

-

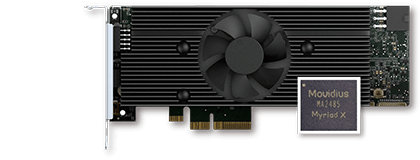

AkcelerátorVPU

- Řešení Intel® Movidius™

- 8x Myriad™ X VPU

- PCIe 2.0 x4

- Nízký profil, poloviční velikost, jeden slot

Řada TVS-x72XU |

Řada TVS-x72XT |

TS-2888X |

|---|---|---|

Poznámka:

- QTS 4.4.0 (nebo novější) a OWCT v1.1.0 jsou požadovány pro QNAP NAS.

- Pokud chcete v QNAP NAS používat kartu FPGA, funkce propusti VM bude zakázána. Aby nedošlo k potenciální ztrátě dat, zajistěte, aby všechny probíhající úkoly NAS byly dokončeny před restartováním.

- Kompletní podporované modely (Ověřte dokument Poznámky k vydání aktuální verze OWCT)

- TVS-x72XT: CPU, iGD, VPU (Poznámka: model TVS-472XT není podporován)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINO a logo OpenVINO jsou obchodní značky společnosti Intel Corporation nebo jejích přidružených společností v USA a/nebo v jiných zemích.