Herramienta de consolidación del flujo de trabajo OpenVINO™

Acelere, optimice y verifique la inferencia del aprendizaje estructurado

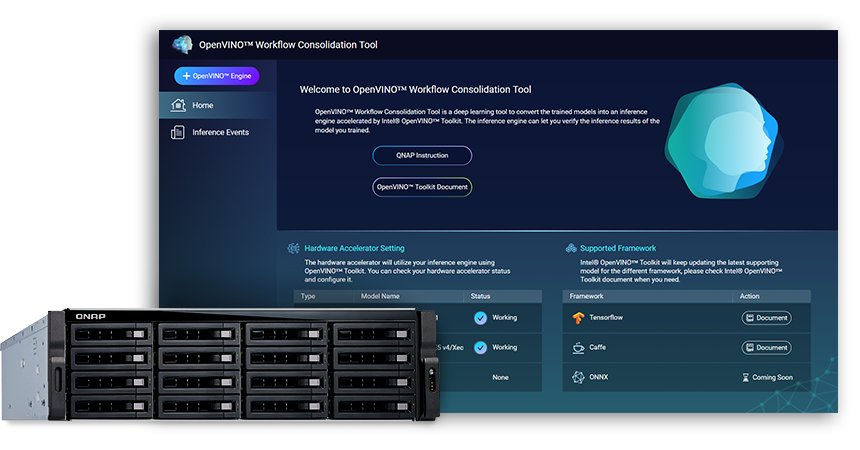

La Herramienta de consolidación del flujo de trabajo OpenVINO™ (OWCT) (disponible en el QTS App Center) es una herramienta de aprendizaje profundo para convertir modelos formados en un servicio de inferencia acelerado por la Distribución Intel® del Conjunto de herramientas OpenVINO™ (Open Visual Inference y Neural Network Optimization) que ayuda a distribuir de forma económica soluciones de visión aprovechando la IA.

QNAP proporciona la Herramienta de consolidación del flujo de trabajo OpenVINO™ para permitir que el NAS de QNAP funcione como un servidor de inferencia.

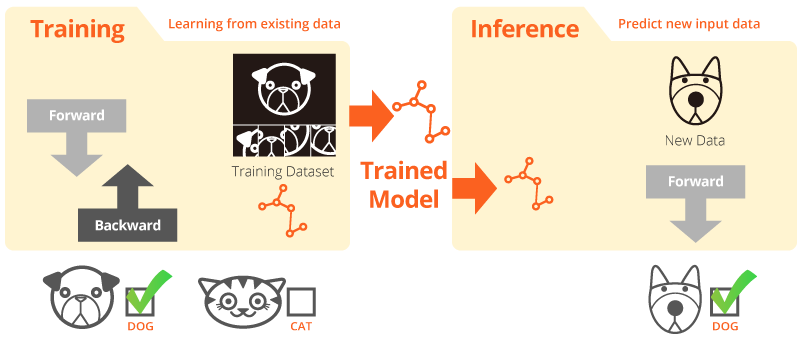

Formación de inferencia

"Formación" es cuando el sistema aprende de los datos existentes. "Inferencia" es cuando se utiliza un modelo capacitado para hacer predicciones útiles con datos del mundo real.

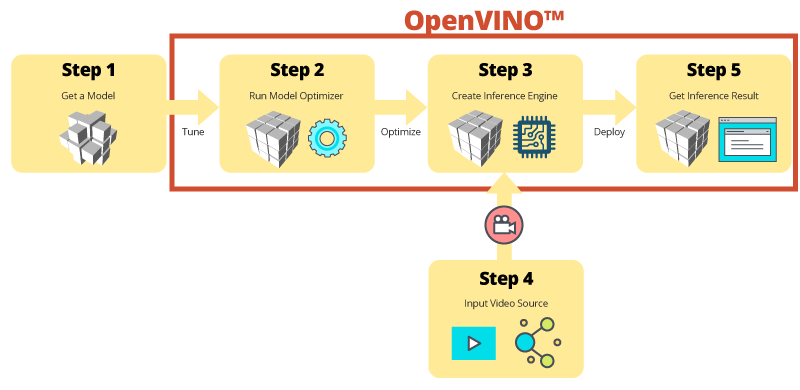

Distribución Intel® del Conjunto de herramientas OpenVINO™

El conjunto de herramientas OpenVINO™ ayuda a acelerar el desarrollo de la visión de alto rendimiento del ordenador y el aprendizaje estrcuturado en aplicaciones de visión. Permite un aprendizaje estructurado en aceleradores de hardware y una ejecución heterogénea y fácil en plataformas Intel®, incluidas CPU, GPU, FPGA y VPU. Los componentes principales incluyen:

- El conjunto de herramientas de implementación de aprendizaje estructurado Intel® (Optimizador de modelos y motor de inferencia)

- Funciones optimizadas para OpenCV* y OpenVX*

- Proporciona más de 15 códigos de muestra y modelos pre-formados para una fácil implementación

Origen: Intel

¡Su inferencia IA para la visión por ordenador, ahora más rápida!

Principales ventajas del uso de la Herramienta de consolidación del flujo de trabajo OpenVINO™ (OWCT):

-

Agilizar

El conjunto de herramientas OpenVINO™ contiene una biblioteca de código abierto que ayuda a reducir el tiempo de desarrollo y agiliza la inferencia del aprendizaje estructurado y la implantación de soluciones orientadas a la visión.

-

Optimización

El Optimizador de modelos convierte modelos formados en una representación intermedia (IR) y realiza optimizaciones básicas para una inferencia eficiente.

-

GUI

OWCT utiliza una GUI que permite a los usuarios utilizar fácilmente las capacidades de OpenVINO™, visualizar imágenes y descargar el resultado de la inferencia.

Inferencia paso a paso con OWCT

El OWCT consolida todas las funciones necesarias de OpenVINO™ para ayudarle a crear el motor de inferencia y revisar los resultados de inferencia del modelo. ¡Solo tiene que seguir al asistente de la aplicación y realizar la configuración en pocos pasos!

Utilice modelos pre-capacitados para acelerar el desarrollo

Además de buscar o entrenar sus propios modelos, el conjunto de herramientas OpenVINO™ también proporciona modelos pre-formados optimizados por Intel® en aplicaciones de usuario, que se conocen como Motor de inferencia.

-

El conjunto de herramientas OpenVINO™ incluye dos conjuntos de modelos optimizados. Puede añadir estos modelos directamente a su entorno y acelerar su desarrollo.

Modelos pre-capacitados:

- Reconocimiento de edad y género

- Confluencia

- Posición del cabezal

- Barreras de seguridad

- Reconocimiento de las funciones del vehículo

- … y más

-

Importe sus propios modelos capacitados, para aprovechar la optimización del Optimizador de modelos y el Motor de interferencia, de modo que finalmente pueda ejecutar fácilmente la inferencia para la visión por ordenador en las arquitecturas Intel® actuales y futuras para satisfacer sus necesidades de IA. El conjunto de herramientas OpenVINO™ funciona con modelos pre-capacitados que usan formatos Caffe o TensorFlow.

NAS de QNAP como un servidor de inferencia

El conjunto de herramientas OpenVINO™ amplía las cargas de trabajo a través del hardware Intel® (incluidos los aceleradores) y maximiza el rendimiento. Cuando se usa con la Herramienta de consolidación del flujo de trabajo OpenVINO™, el NAS de QNAP basado en Intel® ofrece un servidor de inferencia ideal que ayuda a las organizaciones en la rápida creación de un sistema de inferencia. Con un modelo optimizador y un motor de inferencia, el conjunto de herramientas OpenVINO™, es flexible y fácil de usar para obtener un alto rendimiento, una visión por ordenador de baja latencia lo que mejora la inferencia de aprendizaje estructurado. Los desarrolladores de IA pueden implementar modelos capacitados en un NAS de QNAP, para inferencia e instalar aceleradores de hardware, basados en plataformas Intel® para conseguir un rendimiento óptimo para la ejecución de inferencia.

Motor de inferencia fácil de usar

-

Subir un archivo de vídeo

-

Descargar el resultado de la inferencia

Mejorar el rendimiento con tarjetas aceleradoras

El conjunto de herramientas OpenVINO™ admite la ejecución heterogénea en aceleradores de visión por ordenador (CPU, GPU, FPGA y VPU) que usa una API común para la optimización específica del dispositivo.

-

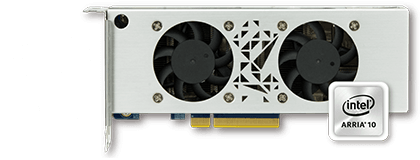

AceleradorFPGA

- Intel® Arria® 10 GX 1150 FPGA

- PCIe 3.0 x8

- Perfil bajo, tamaño medio, dobles ranuras

-

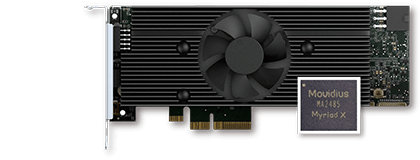

AceleradorVPU

- Solución Intel® Movidius™

- 8x Myriad™ X VPU

- PCIe 2.0 x4

- Perfil bajo, tamaño medio, ranura individual

Serie TVS-x72XU |

Serie TVS-x72XT |

TS-2888X |

|---|---|---|

Nota:

- Se necesita QTS 4.4.0 (o posterior) y OWCT v1.1.0 para el NAS de QNAP.

- Para usar la tarjeta FPGA en el NAS de QNAP, se deshabilitará la función de salida directa de VM. Para evitar una posible pérdida de datos, asegúrese de que todas las tareas en curso del NAS hayan finalizado antes de reiniciar.

- Modelos compatibles completos (verifique la nota de lanzamiento de OWCT)

- TVS-x72XT: CPU, iGD, VPU (Nota: TVS-472XT no es compatible)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINO y el logotipo de OpenVINO son marcas comerciales de Intel Corporation o sus filiales en los EE. UU. y/o en otros países.