Strumento di consolidamento del flusso di lavoro OpenVINO™

Accelerare, semplificare e verificare l'inferenza dell’apprendimento profondo

Lo Strumento di consolidamento del flusso di lavoro OpenVINO™ (OWCT) (disponibile da QTS App Center) è uno strumento di apprendimento specifico per la conversione dei modelli impiegati nel servizio di inferenza accelerato da Intel® Distribution of OpenVINO™ Toolkit (Open Visual Inference e Neural Network Optimization) che aiuta a distribuire in modo economico le soluzioni di visione che sfruttano l’AI.

QNAP offre lo Strumento di consolidamento del flusso di lavoro OpenVINO™ per rendere il QNAP NAS un Server di inferenza.

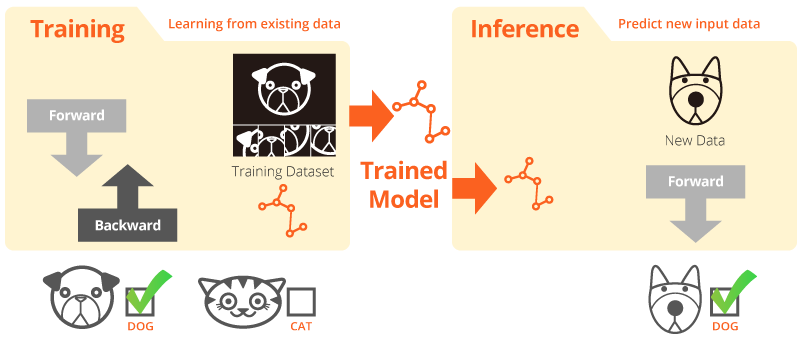

Formazione e inferenza

“Formazione” è quando il sistema impara dai dati esistenti. “Inferenza” è quando il modello adottato è utilizzato per ricevere predizioni utili con i dati del mondo reale.

Intel® Distribution of OpenVINO™ Toolkit

Il kit di strumenti OpenVINO™ aiuta a sviluppare la tracciatura rapida della visione computer e dell’apprendimento profondo a prestazioni elevate nelle applicazioni di visione. Consente l’apprendimento specifico negli acceleratori hardware e l’esecuzione eterogenea semplificata tra piattaforme Intel®, tra cui CPU, GPU, FPGA e VPU. I principali componenti includono:

- Intel® Deep Learning Deployment Toolkit (Model Optimizer e Inference Engine)

- Funzioni ottimizzate per OpenCV* e OpenVX*

- Offre oltre 15 codici campione e modelli pre addestrati per rendere più semplice l’implementazione

Origine: Intel

Inferenze AI per la visione computer, ora più veloci!

Vantaggi chiave per l’uso dello Strumento di consolidamento del flusso di lavoro OpenVINO™ (OWCT):

-

Accelerazione

Il kit di strumenti OpenVINO™ contiene una libreria open-source che aiuta a ridurre i tempi di sviluppo, e rendere più semplice l’inferenza dell’apprendimento profondo e l’implementazione delle soluzioni orientate alla visione.

-

Ottimizzazione

Model Optimizer converte i modelli specifici in una rappresentazione intermedia (IR) ed esegue le ottimizzazioni di base per un’inferenza efficiente.

-

Interfaccia utente

OWCT utilizza un’Interfaccia utente che consente agli utenti di utilizzare in modo semplice le funzionalità OpenVINO™, display visivi, e scaricare i risultati dell’inferenza.

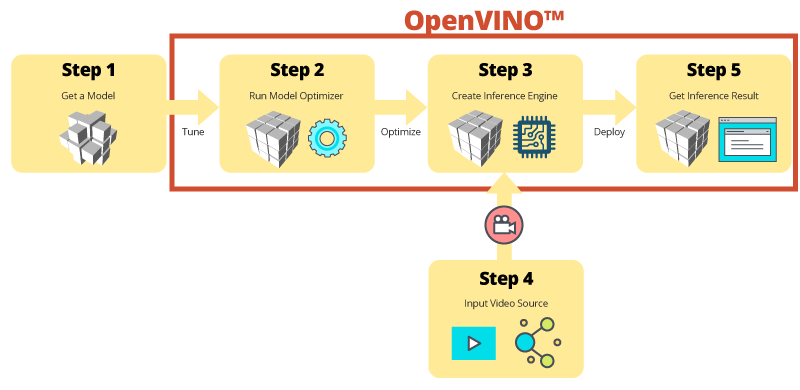

Inferenza assistita con OWCT

OWCT consolida tutte le funzioni necessarie di OpenVINO™ che aiutano a creare l’Inference Engine e rivedere i risultati di inferenza del modello. Seguire la semplice applicazione guidata per eseguire l’impostazione in pochi passi!

Usare i modelli pre-implementati per rendere lo sviluppo più rapido

Oltre alla ricerca e alla formazione di propri modelli, il kit di strumenti OpenVINO™ offre modelli pre-addestrati Intel® nelle applicazioni utente, che prendono il nome di Inference Engine.

-

Il kit di strumenti OpenVINO™ include due set di modelli ottimizzati. È possibile aggiungere questi modelli direttamente all’ambiente e accelerare lo sviluppo.

Modelli pre-implementati:

- Riconoscimento di età e sesso

- Incroci

- Posizione della testa

- Barriere di sicurezza

- Riconoscimento delle caratteristiche del veicolo

- ... e altro

-

Importare i propri modelli pre-addestrati per sfruttare l’ottimizzazione da Model Optimizer e Inference Engine in modo da poter eseguire l’inferenza della visione computer e le funzioni delle architetture Intel® per soddisfare le richiede AI. Il kit di strumenti OpenVINO™ funziona con i modelli pre-addestrati che utilizzano i formati Caffe o TensorFlow.

QNAP NAS come Server di inferenza

Il kit di strumenti OpenVINO™ estende i flussi di lavoro sull’hardware Intel® (incusi gli acceleratori) e massimizza le prestazioni. Quando utilizzato con lo Strumento di consolidamento del flusso di lavoro di OpenVINO™, il QNAP NAS basato su Intel® presenta un Server di inferenza ideale che aiuta le organizzazioni a creare rapidamente un sistema di inferenza. Offrendo un ottimizzatore di modelli e un motore di interferenze, il kit di strumenti OpenVINO™ è facile da usare e offre la flessibilità per prestazioni elevate, visione computer a bassa latenza che migliora le interferenze di apprendimento profondo. Gli sviluppatori AI possono implementare i modelli addestrati su un QNAP NAS per eseguire l’inferenza e installare gli acceleratori hardware basati sulle piattaforme Intel® per ottenere prestazioni ottimali per l’esecuzione dell’inferenza.

Inference Engine facile da gestire

-

Caricare un file video

-

Scaricare i risultati dell’inferenza

Prestazioni migliorate con le schede acceleratore

Il kit di strumenti OpenVINO™ supporta l’esecuzione eterogenea sugli acceleratori visione computer (CPU, GPU, FPGA, e VPU) utilizzando API comuni per l’ottimizzazione specifica del dispositivo.

-

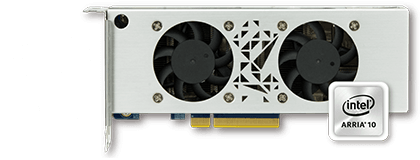

AcceleratoreFPGA

- Intel® Arria® 10 GX 1150 FPGA

- PCIe 3.0 x8

- Basso profilo, dimensione ridotta, due slot

-

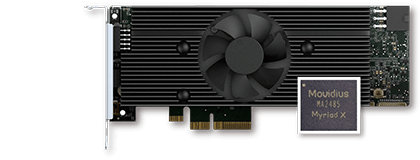

AcceleratoreVPU

- Soluzione Intel® Movidius™

- 8 Myriad™ X VPU

- PCIe 2.0 x4

- Basso profilo, dimensione ridotta, singolo slot

Serie TVS-x72XU |

Serie TVS-x72XT |

TS-2888X |

|---|---|---|

Nota:

- Per il QNAP NAS sono richiesti QTS 4.4.0 (o versione successiva) e OWCT v1.1.0.

- Per usare la potenza di calcolo della scheda FPGA sul QNAP NAS, sarà disabilitata la funzione pass-through VM. Per evitare la perdita potenziale di dati, verificare che tutte le attività NAS in corso siano completate prima del riavvio.

- Modelli supportati completi (consultare la nota di rilascio OWCT)

- TVS-x72XT: CPU, iGD, VPU (Nota: TVS-472XT non è supportato)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINO e il logo OpenVINO sono marchi registrati di Intel Corporation o sue sussidiarie negli Stati Uniti e/o altri paesi.