OpenVINO™ Workflow Consolidation Tool

Beschleunigen, rationalisieren und verifizieren Sie Deep Learning Inferenzen

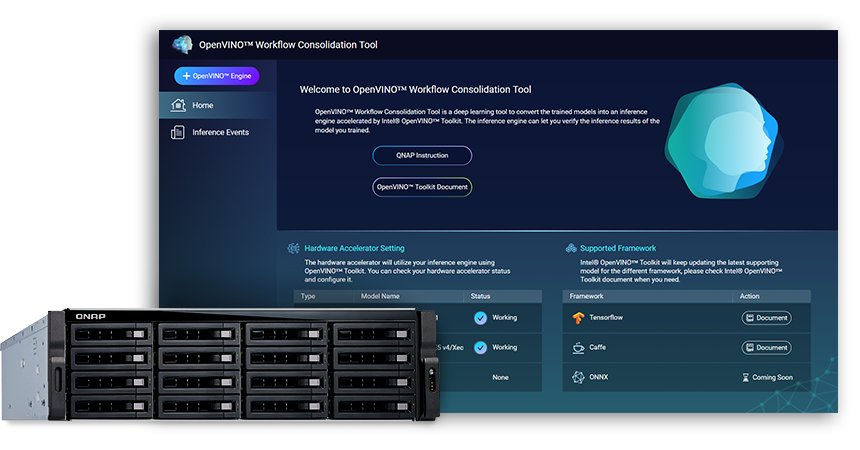

Das OpenVINO™ Workflow Consolidation Tool (OWCT) (erhältlich im QTS App Center) ist ein Deep Learning Tool zur Konvertierung von trainierten Modellen in einen Inferenzdienst, der durch das Intel® Distribution of OpenVINO™ Toolkit (Open Visual Inference and Neural Network Optimization) beschleunigt wird und die wirtschaftliche Verteilung von Visionslösungen unter Nutzung von KI unterstützt.

QNAP stellt das OpenVINO™ Workflow Consolidation Tool zur Verfügung, um das QNAP NAS als Inferenzserver zu nutzen.

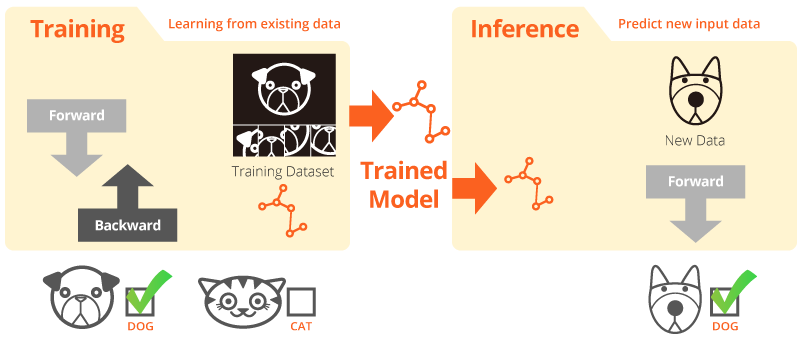

Training und Inferenz

"Training" bedeutet, dass das System aus vorhandenen Daten lernt. "Inferenz" bedeutet, dass ein trainiertes Modell verwendet wird, um nützliche Vorhersagen mit realen Daten treffen zu können.

Intel® Distribution of OpenVINO™-Toolkit

Das OpenVINO™-Toolkit hilft bei der beschleunigten Entwicklung von leistungsfähiger Computervision und dem Deep Learning in Visionsanwendungen. Es ermöglicht Deep Learning über Hardwarebeschleuniger sowie eine einfache, heterogene Ausführung auf Intel® Plattformen, darunter CPU, GPU, FPGA und VPU. Zu den Hauptkomponenten gehören:

- Das Intel® Deep Learning Deployment Toolkit (Modelloptimierer und Inferenzmaschine)

- Optimierte Funktionen für OpenCV* und OpenVX*

- Bietet über 15 Beispielcodes und vortrainierte Modelle für eine einfache Bereitstellung

Quelle: Intel

Ihre KI-Inferenz für die Computer Vision, jetzt schneller denn je!

Die wichtigsten Vorteile des Einsatzes des OpenVINO™ Workflow Consolidation Tool (OWCT):

-

Beschleunigung

Das OpenVINO™-Toolkit enthält eine Open Source Bibliothek, die hilft, die Entwicklungszeit zu verkürzen und die Deep Learning Inferenz und den Einsatz von visionsorientierten Lösungen optimiert.

-

Optimierung

Der Modelloptimierer wandelt trainierte Modelle in eine Zwischendarstellung (IR) um und führt grundlegende Optimierungen für eine effiziente Inferenz durch.

-

Grafische Benutzeroberfläche

OWCT verwendet eine Benutzeroberfläche, die es dem Benutzer ermöglicht, die OpenVINO™ Funktionen einfach zu nutzen, Visualisierungen anzuzeigen und das Inferenzergebnis herunterzuladen.

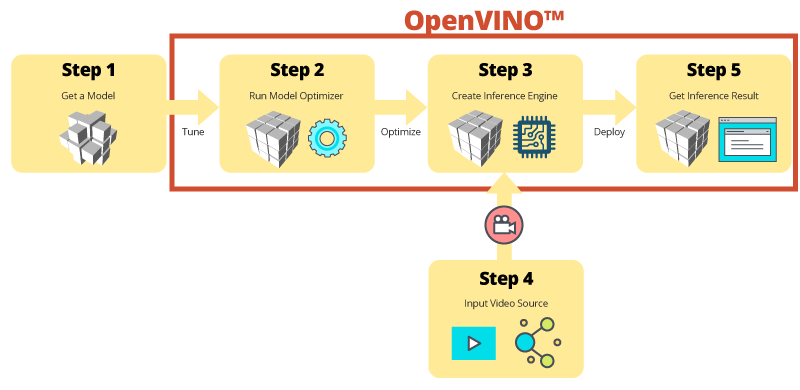

Schritt für Schritt Inferenz mit OWCT

Das OWCT konsolidiert alle notwendigen Funktionen von OpenVINO™, um Ihnen bei der Erstellung der Inferenz Engine und der Überprüfung der Inferenzergebnisse des Modells zu helfen. Folgen Sie einfach dem App-Assistenten und richten Sie alles in nur wenigen Schritten ein!

Verwenden Sie vortrainierte Modelle, um die Entwicklung zu beschleunigen

Neben der Suche nach oder dem Training eigener Modelle bietet das OpenVINO™-Toolkit auch Intel® optimierte vortrainierte Modelle in Benutzeranwendungen, die als Inferenz Engine bezeichnet werden.

-

Das OpenVINO™-Toolkit enthält zwei Gruppen von optimierten Modellen. Sie können diese Modelle direkt in Ihre Umgebung integrieren und so Ihre Entwicklung beschleunigen.

Vortrainierte Modelle:

- Alters- und Geschlechtererkennung

- Kreuzung

- Kopfposition

- Sicherheitsbarrieren

- Erkennung von Fahrzeugmerkmalen

- ... und mehr

-

Importieren Sie Ihre eigenen trainierten Modelle, um die Optimierung aus Model Optimizer und Inferenzmaschine derart zu nutzen, sodass Sie am Ende problemlos Inferenzen für die Computer Vision auf aktuellen und zukünftigen Intel®-Architekturen ausführen können, um Ihre KI-Anforderungen zu erfüllen. Das OpenVINO™-Toolkit arbeitet mit vortrainierten Modellen, die Caffe oder TensorFlow Formate verwenden.

QNAP NAS als Inferenz-Server

Das OpenVINO™-Toolkit erweitert die Arbeitslasten auf Intel® Hardware (einschließlich Beschleuniger) und maximiert die Leistung. In Verbindung mit dem OpenVINO™ Workflow Consolidation Tool stellt das Intel®-basierte QNAP NAS einen idealen Inferenz Server dar, der Unternehmen dabei unterstützt, schnell ein Inferenzsystem aufzubauen. Das OpenVINO™-Toolkit bietet eine Modelloptimierungs- und Inferenzmaschine und ist einfach zu bedienen und flexibel für eine leistungsstarke, latenzarme Computervision, welche die Deep Learning Inferenz verbessert. KI-Entwickler können trainierte Modelle auf einem QNAP NAS für Inferenzen einsetzen und Hardwarebeschleuniger auf Basis von Intel®-Plattformen installieren, um eine optimale Leistung für die Ausführung von Inferenzen zu erzielen.

Leicht zu verwaltende Inferenzmaschine

-

Hochladen einer Videodatei

-

Herunterladen des Inferenzergebnisses

Eine verbesserte Leistung mithilfe von Beschleunigerkarten

Das OpenVINO™-Toolkit unterstützt mit einer gemeinsamen API zur gerätespezifischen Optimierung die heterogene Ausführung über Computer Visionsbeschleuniger (CPU, GPU, FPGA und VPU) hinweg.

-

BeschleunigerFPGA

- Intel® Arria® 10 GX 1150 FPGA

- PCIe 3.0 x8

- Low Profile, halbe Größe, doppelte Steckplätze

-

BeschleunigerVPU

- Intel® Movidius™ Lösung

- 8x Myriad™ X VPU

- PCIe 2.0 x4

- Low Profile, halbe Größe, einzelner Steckplatz

TVS-x72XU Serie |

TVS-x72XT Serie |

TS-2888X |

|---|---|---|

Hinweis:

- QTS 4.4.0 (oder höher) und OWCT v1.1.0 sind für das QNAP NAS erforderlich.

- Um FPGA-Karten-Computing auf dem QNAP NAS zu verwenden, wird die VM Passthrough-Funktion deaktiviert. Stellen Sie vor dem Neustart sicher, dass alle laufenden NAS-Aufgaben abgeschlossen sind, um einen potentiellen Datenverlust zu vermeiden.

- Vollständig unterstützte Modelle (OWCT-Versionshinweis überprüfen)

- TVS-x72XT: CPU, iGD, VPU (Hinweis: TVS-472XT wird nicht unterstützt)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINO und das OpenVINO-Logo sind Marken der Intel Corporation oder ihrer Tochtergesellschaften in den USA und/oder anderen Ländern.