OpenVINO™ İş Akışı Birleştirme Aracı

Derin öğrenme çıkarımını hızlandırın, ve aynı zamanda doğrulayın

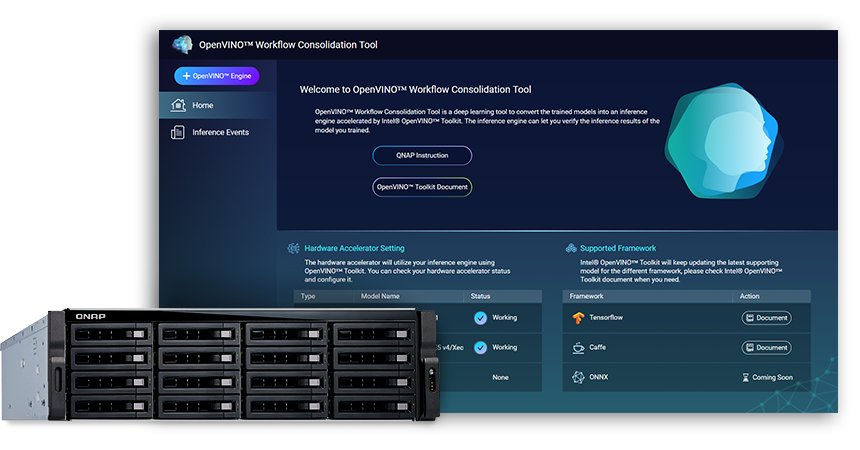

OpenVINO™ İş Akışı Konsolidasyon Aracı (OWCT) (QTS App Center'dan edinilebilir), önceden programlanmış modeller tarafından hızlandırılmış bir çıkarım servisine dönüştürmek için kullanılan derin bir öğrenme aracıdır. Intel® OpenVINO™ Araç Takımının Dağılımı (Açık Görsel Çıkarım ve Yapay Sinir Ağı Optimizasyonu) AI'dan yararlanan vizyon çözümlerini ekonomik olarak modellemeye yardımcı olur.

QNAP, QNAP NAS'ı Inference Server olarak güçlendirmek için OpenVINO™ İş Akışı Konsolidasyon Aracı'nı sağlar.

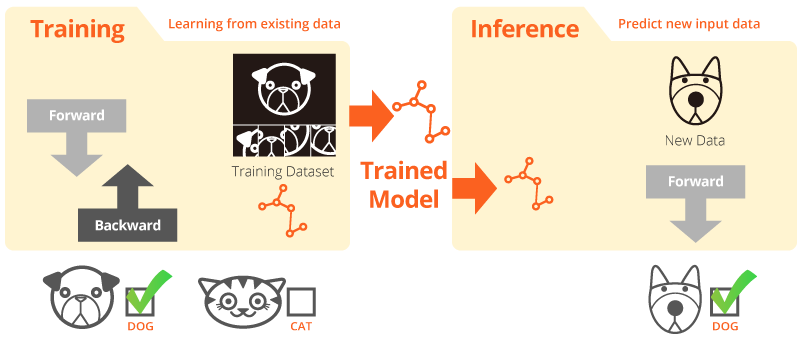

Eğitim ve Çıkarım (Inference)

“Eğitim” sistemin mevcut verileri öğrendiği zamandır. “Çıkarım”, gerçek dünya verileriyle faydalı tahminler yapmak için eğitimli bir model kullanıldığı zamandır.

OpenVINO™ Araç Takımının Intel® Dağıtımı

OpenVINO™ araç seti, yüksek performanslı bilgisayar vizyonunun gelişimini ve vizyon uygulamalarına derinlemesine öğrenmeyi hızlandırmaya yardımcı olur. CPU, GPU, FPGA ve VPU dahil olmak üzere donanım hızlandırıcıları hakkında derinlemesine öğrenme ve Intel® platformlarında kolay heterojen uygulama sağlar. Ana bileşenler şunları içerir:

- Intel® Derin Öğrenme Dağıtım Araç Takımı (Model Optimizasyonu ve Çıkarım Motoru)

- OpenCV* ve OpenVX* için optimize edilmiş fonksiyonlar

- Kolay kurulum için 15'ten fazla örnek kod ve önceden programlanmış modeller sunar

Kaynak: Intel

Bilgisayarla görü için AI Çıkarımınız, şimdi daha hızlı!

OpenVINO™ İş Akışı Konsolidasyon Aracını (OWCT) kullanmanın temel faydaları:

-

Hızlanma

OpenVINO™ araç seti, geliştirme süresini azaltmaya yardımcı olan ve vizyon odaklı çözümlerin derin öğrenme çıkarımını ve dağıtımını kolaylaştıran açık kaynaklı bir kütüphane içerir.

-

Optimizasyon

Model Optimizatörü, programlanmış modelleri bir ara gösterime (IR) dönüştürür ve verimli çıkarım için temel optimizasyonlar gerçekleştirir.

-

GUI

OWCT, kullanıcıların OpenVINO™ yeteneklerini kolayca kullanmalarını, görselleri görüntülemelerini ve çıkarım sonucunu indirmelerini sağlayan bir GUI kullanır.

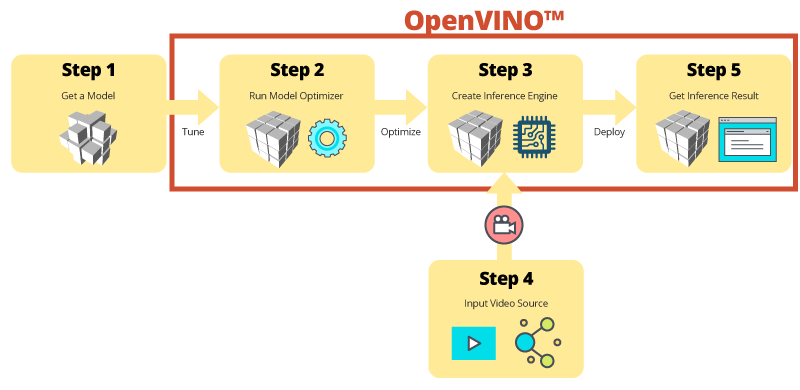

OWCT ile Adım Adım Çıkarım

OWCT, Çıkarım Motorunu oluşturmanıza ve modelin çıkarım sonuçlarını gözden geçirmenize yardımcı olmak için OpenVINO™'nin gerekli tüm özelliklerini birleştirir. Basitçe uygulama sihirbazını takip edin ve sadece birkaç adımda işleri ayarlayın!

Gelişimi hızlandırmak için önceden programlanmış modeller kullanın

OpenVINO™ araç kiti kendi modellerini aramanın ya da programlamanın yanı sıra, Inference Engine olarak adlandırılan kullanıcı uygulamalarında Intel® için optimize edilmiş önceden programlanmış modeller de sağlar.

-

OpenVINO™ araç seti iki tane optimize edilmiş model seti içerir. Bu modelleri doğrudan ortamınıza ekleyebilir ve gelişiminizi hızlandırabilirsiniz.

Önceden programlanmış modeller:

- Yaş ve Cinsiyet Tanıma

- Dönüşüm Noktası

- Baş Pozisyon

- Güvenlik Bariyerleri

- Araç Özellik Tanıma

- … ve dahası

-

Model Optimizer ve Inference Engine'deki optimizasyondan yararlanmak için kendi programlanmış modellerinizi alın, böylece sonunda AI ihtiyaçlarınızı karşılamak için mevcut ve gelecekteki Intel® mimarilerinde bilgisayar görüşü için kolayca çıkarım yapabilirsiniz. OpenVINO™ araç kiti, Caffe veya TensorFlow formatlarını kullanan önceden programlanmış modellerle çalışır.

Inference Server Olarak QNAP NAS

OpenVINO™ araç takımı, iş yüklerini Intel® donanımı (hızlandırıcılar dahil) üzerinden genişletir ve performansı en üst düzeye çıkarır. OpenVINO™ İş Akışı Konsolidasyon Aracı ile birlikte kullanıldığında, Intel® tabanlı QNAP NAS, kuruluşlara hızlı bir şekilde bir çıkarım sistemi oluşturmada yardımcı olan ideal bir Inference Server sunar. Bir model iyileştirici ve çıkarım motoru sunan OpenVINO™ araç seti, derin öğrenme çıkarımını geliştiren yüksek performanslı, düşük gecikmeli bilgisayar performansı için kullanımı kolaydır ve esnektir. AI geliştiricileri, çıkarım için programlanmış modelleri bir QNAP NAS üzerinde dağıtabilir ve çıkarımın yürütülmesi ve en iyi performansı elde etmek için Intel® platformlarına dayalı donanım hızlandırıcıları yükleyebilir.

Yönetimi kolay Inference Engine

-

Bir video dosyası yükle

-

Çıkarım sonucunu indir

Hızlandırıcı kartlarla geliştirilmiş performans

OpenVINO™ araç seti, cihaza özel optimizasyon için ortak bir API kullanarak bilgisayar kart hızlandırıcıları (CPU, GPU, FPGA ve VPU) arasında heterojen yürütmeyi destekler.

-

HızlandırıcıFPGA

- Intel® Arria® 10 GX 1150 FPGA

- PCIe 3.0 x8

- Düşük profil, yarı boyut, çift yuva

-

HızlandırıcıVPU

- Intel® Movidius™ solution

- 8x Myriad™ X VPU

- PCIe 2.0 x4

- Düşük profil, yarı boyut, tek yuva

TVS-x72XU Serisi |

TVS-x72XT Serisi |

TS-2888X |

|---|---|---|

Not:

- QNAP NAS için QTS 4.4.0 (veya üstü) ve OWCT v1.1.0 gereklidir.

- QNAP NAS'ta FPGA kartı hesaplama kullanmak için, VM geçiş işlevi devre dışı bırakılır. Potansiyel veri kaybını önlemek için, yeniden başlatmadan önce devam eden tüm NAS görevlerinin tamamlandığından emin olun.

- Desteklenen modeller (Kontrol edin OWCT Yayın Notu)

- TVS-x72XT: CPU, iGD, VPU (Not: TVS-472XT desteklenmiyor)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINO ve OpenVINO logosu, Intel Corporation'ın veya yan kuruluşlarının ABD'deki ve/veya diğer ülkelerdeki ticari markalarıdır.