Nutzung von TensorFlow in Container Station

Zuletzt geändertes Datum

2019-09-24

Über TensorFlow

TensorFlow™ ist eine Open Source Softwarebibliothek zur numerischen Berechnung mit Datenflussgraphen. Knoten im Graphen stellen mathematische Operationen dar, während die Graphenkanten die zwischen ihnen kommunizierten multidimensionalen Datenarrays (Tensoren) darstellen.

TensorFlow in Container Station installieren

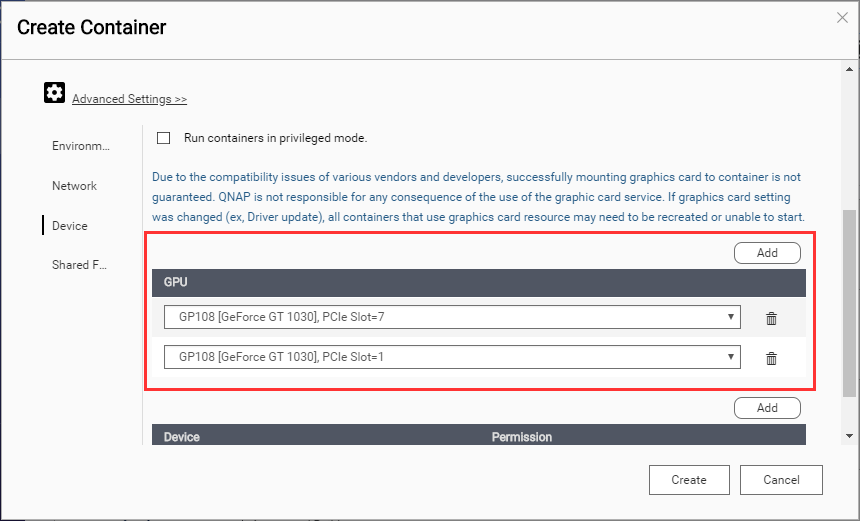

Einbinden eines NVIDIA Grafikprozessors über SSH

Zugriff auf den Container

Sie können nun das Jupyter Notebook mit TensorFlow verwenden.