Come usare TensorFlow con Container Station

Ultima data di modifica

2019-09-24

Informazioni su TensorFlow

TensorFlow™ è una libreria software open source per il calcolo numerico che utilizza grafici con flussi di dati. I nodi nel grafico rappresentano le operazioni matematiche, mentre i lati del grafico rappresentano le array dati multidimensionali (tensori) che comunicano tra di loro.

Installazione di TensorFlow in Container Station

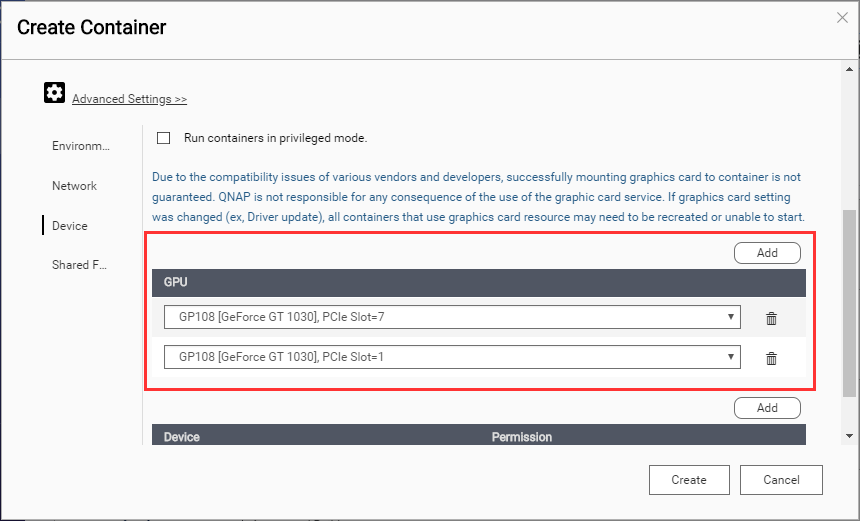

Montaggio di NVIDIA GPU tramite SSH

Accesso al container

È ora possibile usare il notebook Jupyter con TensorFlow.