Como usar o TensorFlow com o Container Station

Data da última modificação:

2019-09-24

Sobre o TensorFlow

O TensorFlow™ é uma biblioteca de software de código aberto para computação numérica que usa gráficos de fluxo de dados. Os nós no gráfico representam operações matemáticas, enquanto as bordas do gráfico representam matrizes de dados multidimensionais (tensores) comunicadas entre elas.

Instalar o TensorFlow no Container Station

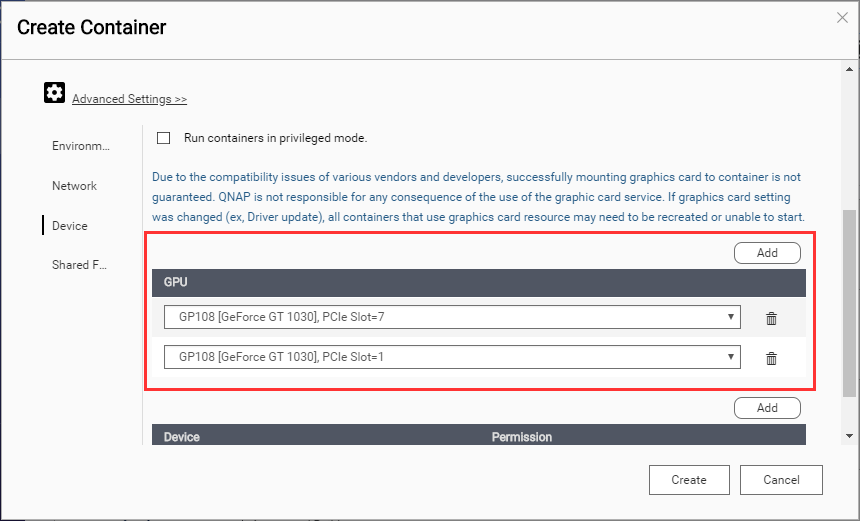

Montar uma GPU NVIDIA via SSH

Acessar o recipiente

Agora você pode usar o Jupyter Notebook com o TensorFlow.