OpenVINO™ Workflow Consolidation Tool

Versnel, stroomlijn en verifieer deep learning-inferentie

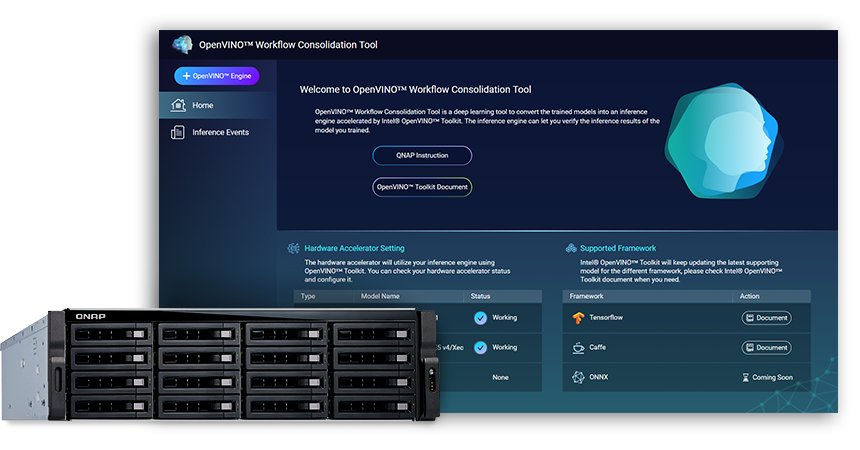

De OpenVINO™ Workflow Consolidation Tool (OWCT) (beschikbaar in het QTS App Center) is een deep learning tool om getrainde modellen om te zetten naar een inferntiedienst versneld door de Intel®-distributie van de OpenVINO™ Toolkit (Open Visual Inference en Neural Network Optimization) die helpt bij het op economische wijze distribueren van visie-oplossingen die gebruik maken van AI.

QNAP levert OpenVINO™ Workflow Consolidation Tool om van QNAP NAS een inferentieserver te maken.

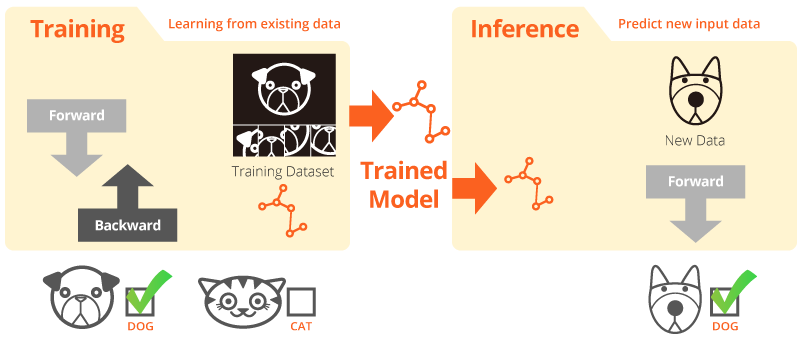

Training en inferentie

“Training” is waar het systeem uit bestaande gegevens leert. “Inferentie” is als een getraind model wordt gebruikt om nuttige voorspellingen te doen met realistische gegevens.

Intel® Distribution van de OpenVINO™ Toolkit

De OpenVINO™ toolkit helpt bij het snel ontwikkelen van hoogpresterende computervisie en deep learning in visie-toepassingen. Het maakt deep learning mogelijk op hardware-versnellers en eenvoudige heterogene uitvoering over Intel® platforms, waaronder CPU, GPU, FPGA en VPU. Belangrijke componenten zijn:

- De Intel® Deep Learning Deployment Toolkit (Model Optimizer en Inference Engine)

- Geoptimaliseerde functies voor OpenCV* en OpenVX*

- Biedt meer dan 15 voorbeeldcodes en voorgetrainde modellen voor eenvoudige inzet.

Bron: Intel

Uw AI-inferentie voor computervisie, nu sneller!

Belangrijke voordelen van het gebruik van het OpenVINO™ Workflow Consolidation Tool (OWCT):

-

Versnellen

De OpenVINO™ toolkit bevat een open-source bibliotheek die helpt bij het verkorten van de ontwikkeltijd, en die deep learning inferentie en de inzet van visie-georiënteerde oplossingen stroomlijnt.

-

Optimalisatie

De Model Optimizer converteert getrainde modellen naar een tussenrepresentatie (intermediate representation, IR) en voert basisoptimalisaties uit voor een efficiënte inferentie.

-

GUI

OWCT gebruikt een GUI waarmee gebruikers gemakkelijk de mogelijkheden en schermweergaven van OpenVINO™ kunnen gebruiken en het inferentie-resultaat downloaden.

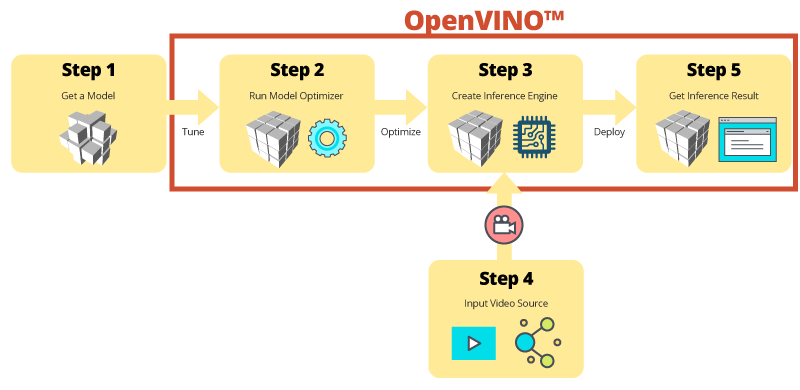

Stap-voor-stap inferentie met OWCT

De OWCT consolideert alle noodzakelijke functies van OpenVINO™ om u te helpen bij het bouwen van de Inference Engine en bij het beoordelen van de inferentie-resultaten van het model. Volg gewoon de app-wizard en installeer het geheel in een paar stappen!

Gebruik voorgetrainde modellen om de ontwikkeling te versnellen

Naast het zoeken naar of trainen van uw eigen modellen biedt de OpenVINO™ toolkit tevens Intel®-geoptimaliseerde modellen in gebruikerstoepassingen, waarnaar wordt verwezen met Inference Engine.

-

De OpenVINO™ toolkit bevat twee sets met geoptimaliseerde modellen. U kunt deze modellen rechtstreeks aan uw omgeving toevoegen en uw ontwikkeling versnellen.

Voorgetrainde modellen:

- Leeftijd- en geslachtsherkenning

- Crossroad

- Hoofdstand

- Veiligheidsbarrières

- Herkenning van voertuigkenmerken

- ... en meer

-

Importeer uw eigen getrainde modellen om gebruik te maken van de optimalisatie van Model Optimizer en Inference Engine, zodat u uiteindelijk eenvoudig inferentie voor computer-visie kunt uitvoeren op huidige en toekomstige Intel®-architecturen om aan uw AI-eisen te voldoen. De OpenVINO™ toolkit werkt met voorgetrainde modellen die de indelingen Caffe of TensorFlow gebruiken.

QNAP NAS als een inferentie-server

OpenVINO™ toolkit breidt workloads uit over Intel®-hardware (inclusief versnellers) en maximaliseert de prestaties. Bij gebruik in combinatie met het OpenVINO™ Workflow Consolidation Tool vormt de op Intel® gebaseerde QNAP NAS een ideale Inference Server die organisaties helpt bij het snel opzetten van een inferentiesysteem. Door een model-optimalisator en inferentie-engine te bieden, is de OpenVINO™ toolkit gemakkelijk in het gebruik en flexibel voor hoog-presterende computervisie met een lage latentie die diep-leren inferenties verbetert. AI-ontwikkelaars kunnen getrainde modellen inzetten op een QNAP NAS voor inferentie, en hardware-versnellers installeren gebaseerd op Intel®-platforms om optimale prestaties te bereiken bij het uitvoeren van inferentie.

Eenvoudig te beheren Inference Engine

-

Upload een videobestand

-

Download het inferentie-resultaat

Verbeterde prestaties met versnellerkaarten

De OpenVINO™ toolkit ondersteunt heterogene uitvoering tussen computer-visie versnellers (CPU, GPU, FPGA en VPU) met een gemeenschappelijke API voor apparaatspecifieke optimalisatie.

-

VersnellerFPGA

- Intel® Arria® 10 GX 1150 FPGA

- PCIe 3.0 x8

- Laag profiel, halve grootte, dubbele sleuven

-

VersnellerVPU

- Intel® Movidius™-oplossing

- 8x Myriad™ X VPU

- PCIe 2.0 x4

- Laag profiel, halve grootte, enkele sleuf

TVS-x72XU serie |

TVS-x72XT serie |

TS-2888X |

|---|---|---|

Opmerking:

- QTS 4.4.0 (of nieuwer) en OWCT v1.1.0 zijn vereist voor de QNAP NAS.

- Om berekeningen met de FPGA-kaart op de QNAP NAS te kunnen gebruiken, wordt de VM pass-through functie uitgeschakeld. Om mogelijk gegevensverlies te vermijden, moet u controleren of alle actieve NAS-taken zijn voltooid voordat u herstart.

- Volledig ondersteunde modellen (zie deversieopmerking voor OWCT)

- TVS-x72XT: CPU, iGD, VPU (Opmerking: TVS-472XT wordt niet ondersteund)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINO en het OpenVINO-logo zijn handelsmerken van Intel Corporation of diens dochterondernemingen in de V.S. en/of andere landen.