OpenVINO™ Workflow Consolidation Tool

Przyspieszanie, usprawnianie i weryfikowanie inferencji głębokiego uczenia

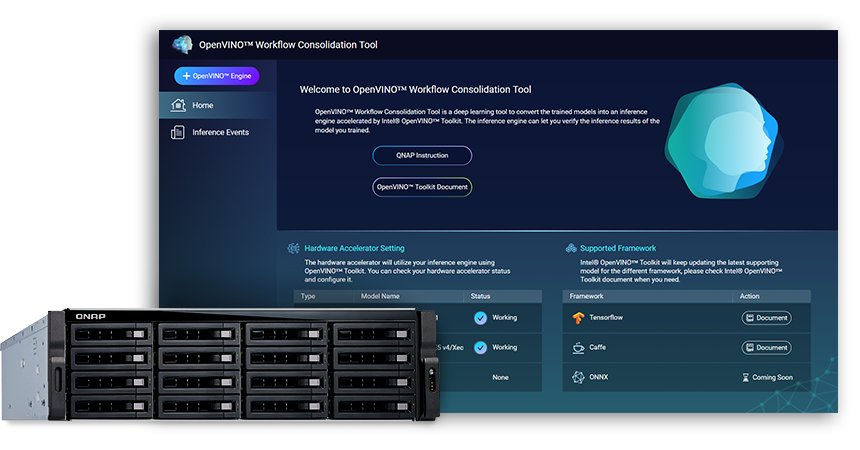

Narzędzie OpenVINO™ Workflow Consolidation Tool (OWCT) (dostępne do pobrania w QTS App Center) to narzędzie głębokiego uczenia, służące do konwertowania modeli szkoleniowych w usługę inferencji, co przyspiesza zestaw Intel® Distribution of OpenVINO™ Toolkit (Open Visual Inference and Neural Network Optimization), usprawniając ekonomiczną dystrybucję rozwiązań w zakresie komputerowej technologii wizyjnej, korzystających ze sztucznej inteligencji.

Firma QNAP udostępnia narzędzie do konsolidacji przepływu pracy, OpenVINO™ Workflow Consolidation Tool, wyposażające serwer QNAP NAS w funkcje pozwalające na korzystanie z niego jako z serwera inferencji.

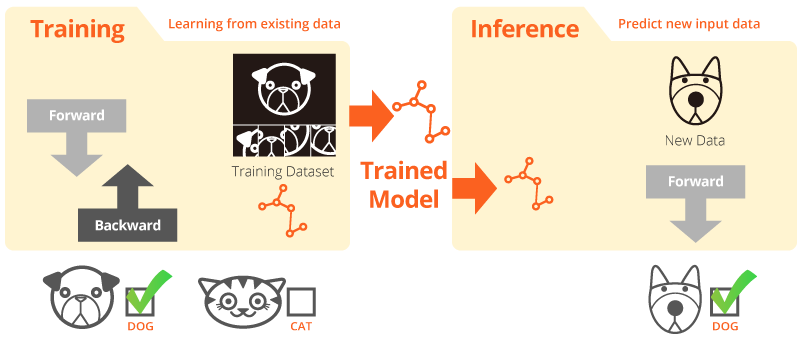

Szkolenie i inferencja

„Szkolenie” ma miejsce wtedy, kiedy system uczy się w oparciu o istniejące dane. „Inferencja” następuje w przypadku dokonywania praktycznych prognoz przy użyciu nauczonego modelu i danych rzeczywistych.

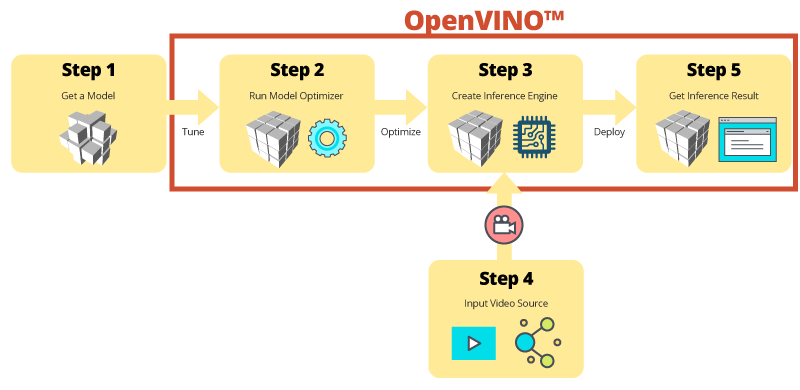

Intel® Distribution of OpenVINO™ Toolkit

Zestaw narzędzi OpenVINO™ umożliwia szybki rozwój wysokowydajnego widzenia komputerowego i głębokiego uczenia na potrzeby zastosowań tej technologii. Zestaw ten umożliwia korzystanie z głębokiego uczenia na akceleratorach sprzętowych i łatwego uruchamiania w heterogenicznym środowisku na platformach Intel®, w tym CPU, GPU, FPGA i VPU. Główne komponenty to:

- Zestaw narzędzi do wdrażania funkcji głębokiego uczenia Intel® Deep Learning Deployment Toolkit (oprogramowanie do optymalizacji modelu i silnik inferencji)

- Zoptymalizowane funkcje dla OpenCV* i OpenVX*

- Zestaw zapewnia ponad 15 kodów przykładowych i modeli wstępnie nauczone modele, umożliwiając łatwe wdrożenie

Źródło: Intel

Teraz jeszcze szybsza funkcja Inferencji sztucznej inteligencji w zakresie obrazowania komputerowego!

Główne korzyści używania narzędzia OpenVINO™ Workflow Consolidation Tool (OWCT):

-

Większa szybkość

Zestaw narzędzi OpenVINO™ obejmuje bibliotekę typu open-source, która pomaga skrócić czas rozwoju i usprawnić inferencję głębokiego uczenia, oraz wdrożyć rozwiązania w zakresie komputerowej technologii wizyjnej.

-

Optymalizacja

Oprogramowanie do optymalizacji modelu umożliwia konwertowanie nauczonych modeli w pośrednią reprezentację (IR, Intermediate Representation) i wykonywanie podstawowych optymalizacji w celu uzyskania wydajnej inferencji.

-

Interfejs graficzny

Narzędzie OWCT korzysta z interfejsu graficznego, który umożliwia użytkownikom łatwe korzystanie z funkcji OpenVINO™, wyświetlanie pomocy wizualnych i pobieranie wyniku inferencji.

Szczegółowo opisana Inferencja przy użyciu narzędzia OWCT

Narzędzie OWCT łączy w sobie wszystkie potrzebne funkcje OpenVINO™, umożliwiające tworzenie Silnika inferencji i przeglądanie wyników inferencji danego modelu. Wystarczy wykonywać instrukcje kreatora aplikacji, aby przeprowadzić konfigurację w zaledwie kilku krokach!

Skorzystanie uprzednio nauczonych modeli możne przyspieszyć programowanie

Oprócz funkcji wyszukiwania lub szkolenia własnych modeli, zestaw narzędzi OpenVINO™ zapewnia także zoptymalizowane uprzednio nauczone modele Intel® w aplikacjach użytkownika, nazywanych Silnikiem inferencji.

-

Zestaw narzędzi OpenVINO™ udostępnia dwa zestawy zoptymalizowanych modeli. Modele te można dodać bezpośrednio do swojego środowiska, aby przyspieszyć jego rozwój.

Uprzednio nauczone modele:

- Wykrywanie wieku i płci

- Skrzyżowanie

- Pozycja głowy

- Barierki bezpieczeństwa

- Wykrywanie funkcji pojazdu

- ...i wiele innych

-

Importuj swoje własne nauczone modele, aby użyć funkcji optymalizacji z narzędzia do optymalizacji modelu oraz z silnika inferencji, dzięki czemu można w łatwy sposób aktywować inferencję dla komputerowego widzenia w bieżących i przyszłych architekturach Intel® w zależności od potrzeb sztucznej inteligencji. Zestaw narzędzi OpenVINO™ współpracuje z uprzednio nauczonymi modelami, korzystającymi z formatów Caffe lub TensorFlow.

QNAP NAS jako serwer inferencji

Zestaw narzędzi OpenVINO™ umożliwia dystrybucję obciążenia pracą na osprzęt Intel® (w tym akceleratory), zwiększając maksymalnie wydajność. W przypadku korzystania z narzędzia OpenVINO™ Workflow Consolidation Tool, urządzenie QNAP NAS oparte na Intel® służy jako idealny serwer inferencji, pozwalając organizacjom na szybkie tworzenie systemu inferencji. Zestaw narzędzi OpenVINO™ zawiera narzędzie do optymalizacji modelu i silnik inferencji, dzięki czemu jest łatwy w obsłudze i zapewnia elastyczność umożliwiającą uzyskanie wysokiej wydajności, niewielkie opóźnienia widzenia komputerowego, ulepszając inferencje głębokiego uczenia. Projektanci sztucznej inteligencji (AI) mogą wdrażać w urządzeniach QNAP NAS nauczone modele w celu uzyskania inferencji i instalować akceleratory sprzętowe w oparciu o platformy Intel®, aby uzyskać optymalną wydajność potrzebną do pracy inferencji.

Łatwy w zarządzaniu silnik inferencji

-

Prześlij plik wideo

-

Pobierz wynik inferencji

Zwiększona wydajność dzięki kartom akceleratorów

Zestaw narzędzi OpenVINO™ obsługuje heterogeniczne uruchamianie w akceleratorach widzenia komputerowego (CPU, GPU, FPGA i VPU), korzystając z popularnego interfejsu API do optymalizacji dla danego urządzenia.

-

AkceleratorFPGA

- Intel® Arria® 10 GX 1150 FPGA

- PCIe 3.0 x8

- Niski profil, dwukrotnie mniejszy rozmiar, podwójne gniazda

-

AkceleratorVPU

- Rozwiązanie Intel® Movidius™

- 8x Myriad™ X VPU

- PCIe 2.0 x4

- Niski profil, dwukrotnie mniejszy rozmiar, pojedyncze gniazdo

Seria TVS-x72XU |

Seria TVS-x72XT |

TS-2888X |

|---|---|---|

Uwaga:

- Serwer QNAP NAS wymaga systemu QTS 4.4.0 (lub nowszej wersji) oraz OWCT v1.1.0.

- Aby korzystać z funkcji obliczeniowej karty FPGA na serwerze QNAP NAS, zostanie wyłączona funkcja pass-through maszyny wirtualnej. Aby nie dopuścić do potencjalnej utraty danych, przed ponownym uruchomieniem upewnij się, że wszystkie bieżące zadania na serwerze NAS zostały zakończone.

- Pełna lista obsługiwanych modeli (zapoznaj się z informacjami o wersji OWCT)

- TVS-x72XT: CPU, iGD, VPU (Uwaga: model TVS-472XT nie jest obsługiwany)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINO i logo OpenVINO są znakami towarowymi firmy Intel Corporation lub jej spółek zależnych w Stanach Zjednoczonych lub innych krajach.