OpenVINO™ワークフロー統合ツール

ディープラーニング推論のスピードアップ、合理化、検証

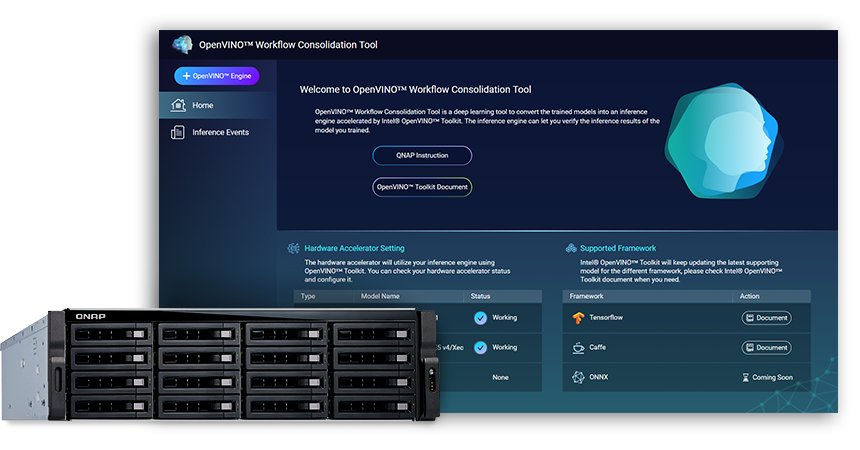

OpenVINO™ワークフロー統合ツール(OWCT)(QTS App Centerから入手可能)は、AIを活用した画像ソリューションを合理的に配布するIntel® Distribution of OpenVINO™ Toolkit(Open Visual InferenceおよびNeural Network Optimization)によって促進される推論サービスに、学習済みモデルを変換するためのディープラーニングツールです。

QNAPは、推論サーバーとしてQNAP NASを強化するために OpenVINO™ワークフロー統合ツールを提供しています。

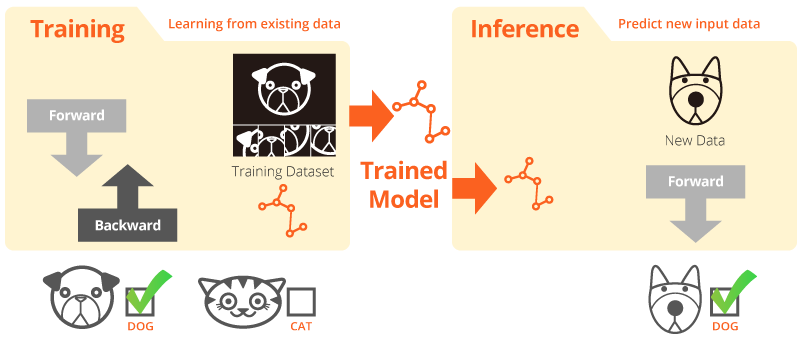

学習と推論

「学習」とは、システムが既存のデータから学びとる状況を意味します。「推論」とは、学習済みモデルが実際のデータによって有用な予測を行うために使用される状況を意味します。

Intel® Distribution of OpenVINO™ Toolkit

OpenVINO™ツールキットは、高パフォーマンス画像処理とディープラーニングを画像アプリケーションに発展させることを支援します。このツールキットを使用することで、CPU、GPU、FPGA、VPUを含む、Intel®プラットフォーム上での簡単なヘテロジニアス実行と、ハードウェアアクセラレーターによるディープラーニングが可能になります。主要なコンポーネントには以下が含まれます。

- Intel®ディープラーニング展開ツールキット(モデルオプティマイザーおよび推論エンジン)

- OpenCV*とOpenVX*に最適化された関数

- 展開を容易にするために15以上のサンプルコードと学習済みモデルを提供します

ソース: Intel

画像処理のAI推論がさらに高速に!

OpenVINO™ワークフロー統合ツール(OWCT)を使う主なメリット:

-

速度を上げる

OpenVINO™ツールキットには、開発時間を短縮し、ディープラーニング推論と画像志向のソリューションの展開を合理化する、オープンソースライブラリーが含まれます。

-

最適化

モデルオプティマイザーは、学習済みモデルを中間表現(IR)に変換し、効率的な推論を行うために基本的な最適化を行います。

-

GUI

OWCTは、ユーザーがOpenVINO™機能を利用して、ビジュアルの表示、推論結果のダウンロードを簡単に利用できるようにするGUIを使用しています。

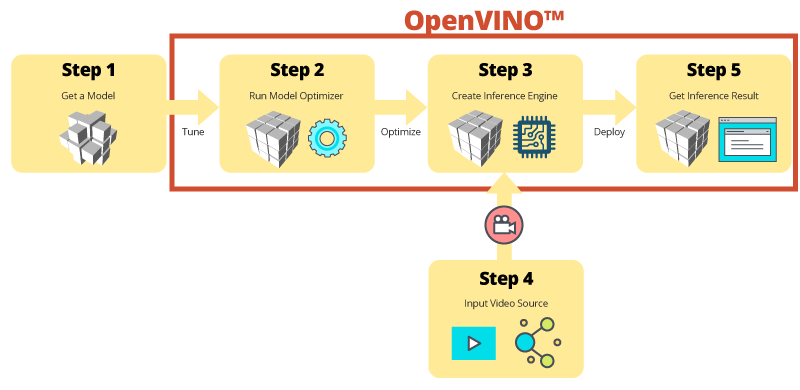

OWCTによるステップbyステップの推論

OWCTは、OpenVINO™の不可欠な機能を統合し、推論エンジンを作成し、モデルの推論結果を確認できるように支援します。アプリのウィザードに従うだけで、わずか数ステップでセットアップできます!

学習済みモデルを使用して開発を促進

独自のモデルを探求したり、学習させる代わりに、OpenVINO™ツールキットでは、推論エンジンと呼ばれるユーザーアプリケーションにおいてIntel®の学習済みたモデルを利用できます。

-

OpenVINO™ツールキットには、2つのセットの最適化されたモデルが含まれています。これらのモデルはお使いの環境に直接追加して、開発速度を向上することができます。

学習済みモデル:

- 年齢・性別認識

- 交差点

- 頭の位置

- セキュリティバリア

- 車両機能認識

- ...その他

-

独自の学習済みモデルをインポートして、モデルオプティマイザーと推論エンジンの最適化を利用します。それにより、AIニーズを満たすために現在と今後のIntel®アーキテクチャにおいて画像処理の推論を簡単に実行することができます。OpenVINO™ツールキットは、CaffeまたはTensorFlow形式を使用する学習済みモデルで動作します。

推論サーバーとしてのQNAP NAS

OpenVINO™ツールキットは、Intel®ハードウェア(アクセラレーターを含む)上でワークロードを拡張し、パフォーマンスを最大化します。OpenVINO™ワークフロー統合ツールとともに使用することで、Intel®ベースのQNAP NASは、組織が推論システムを素早く構築できるように支援する理想的な推論サーバーとなります。モデルオプティマイザーと推論エンジンを提供するOpenVINO™ツールキットは簡単に使用でき、高パフォーマンスで柔軟な、ディープラーニング推論を改善する低レイテンシな画像処理ツールです。AI開発者は、学習済みモデルを推論用にQNAP NAS上に展開することができ、Intel®プラットフォームベースのハードウェアアクセラレーターを導入することで、推論を実行するための最適なパフォーマンスを実現することができます。

簡単に管理できる推論エンジン

-

ビデオファイルのアップロード

-

推論結果のダウンロード

アクセラレーターカードで向上したパフォーマンス

OpenVINO™ツールキットは、デバイス固有の最適化を行うために、共通のAPIを使用して画像処理アクセラレーター(CPU、GPU、FPGA、VPU)上での異機種環境の実行をサポートしています。

-

アクセラレーターFPGA

- Intel® Arria® 10 GX 1150 FPGA

- PCIe 3.0 x8

- ロープロファイル、ハーフサイズ、ダブルスロット

-

アクセラレーターVPU

- Intel® Movidius™ソリューション

- 8x Myriad™ X VPU

- PCIe 2.0 x4

- ロープロファイル、ハーフサイズ、シングルスロット

注記:

- QNAP NASに、QTS 4.4.0(またはそれ以降)およびOWCT v1.1.0が必要です。

- FPGAカードコンピューティングをQNAP NASで使用するために、VMパススルー機能が無効化されます。データ損失の可能性を避けるためにも、進行中のNASタスクは再起動前に終了されます。

- フルサポートモデル (OWCTリリースノート参照)

- TVS-x72XT: CPU、iGD、VPU (注意: TVS-472XTには対応していません。)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINOとOpenVINOロゴは、米国またはその他の国におけるIntel Corporationまたはその子会社の商標です。