OpenVINO™ Workflow Consolidation Tool

Påskynda, förenkla och verifiera djup inlärningsinferens

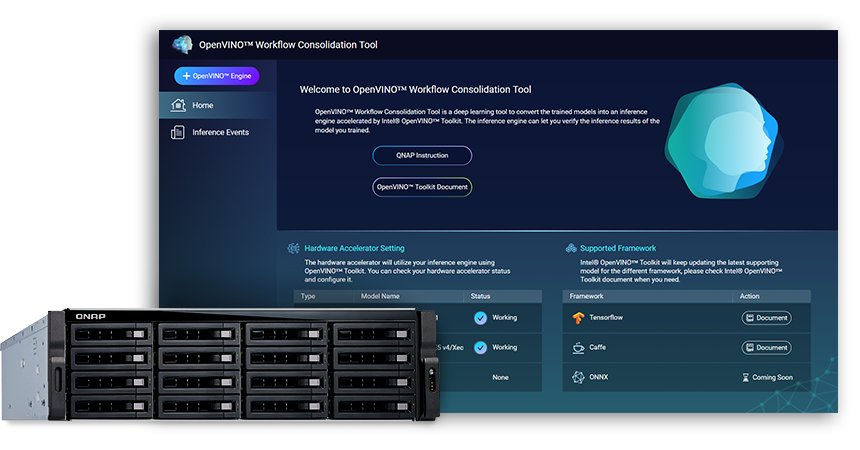

OpenVINO™ Workflow Consolidation Tool (OWCT) (tillgängligt i QTS App Center) är ett djupinlärningsverktyg som konverterar inlärda modeller till en inferenstjänst accelererad av Intel® Distribution of OpenVINO™ Toolkit (Open Visual Inference and Neural Network Optimization) som distribuerar visuella lösningar ekonomiskt med hjälp av AI.

QNAP tillhandahåller OpenVINO™ Workflow Consolidation Tool för att göra QNAP NAS till en inferensserver.

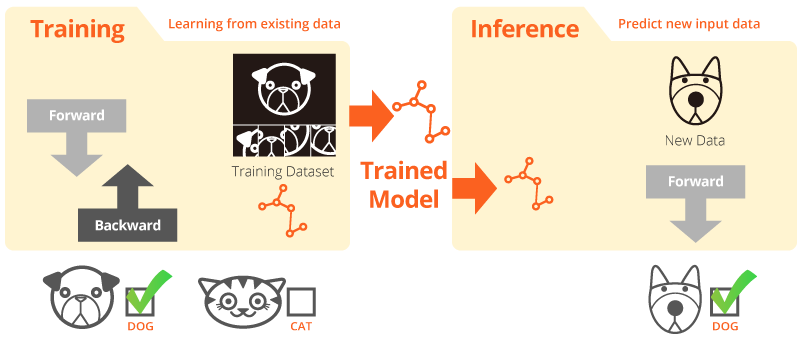

Inlärning och inferens

Inlärning innebär att systemet lär från befintliga data. Inferens innebär att en inlärd modell används till att göra användbara förutsägelser med verkliga data.

Intel® Distribution of OpenVINO™ Toolkit

OpenVINO™ påskyndar utveckling av högpresterande datorseende och djup inlärning till program för seende. Det möjliggör djup inlärning på maskinvaruacceleratorer och enkel heterogen körning på Intel®-plattformar, inklusive CPU, GPU, FPGA och VPU. Huvudkomponenterna inkluderar:

- Intel® Deep Learning Deployment Toolkit (Model Optimizer och Inference Engine)

- Optimerade funktioner för OpenCV* och OpenVX*

- Tillhandahåller över 15 exempelkoder och förinlärda modeller för enklare distribution

Källa:Intel

Din AI-inferens för datorseende, nu ännu snabbare!

Huvudfördelar med att använda OpenVINO™ Workflow Consolidation Tool (OWCT):

-

Snabbare

OpenVINO™ innehåller ett bibliotek med öppen källkod som minskar utvecklingstiden och förenklar djup inlärningsinferens och distribution av seendeorienterade lösningar.

-

Optimering

Model Optimizer omvandlar inlärda modeller till en IR (Intermediate Representation) och utför grundläggande optimeringar för effektiv inferens.

-

Grafiskt gränssnitt

OWCT använder ett grafiskt gränssnitt som gör det möjligt för användare att enkelt dra nytta av funktionerna i OpenVINO™, visa bilder och ladda ned inferensresultatet.

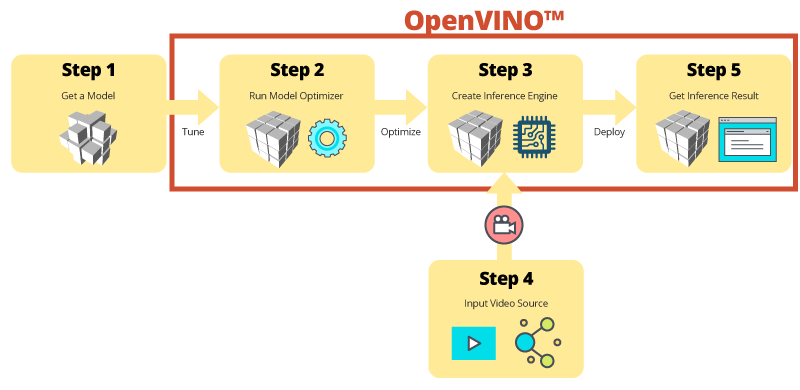

Inferens steg för steg med OWCT

OWCT konsoliderar alla nödvändiga funktioner i OpenVINO™ för att hjälpa dig att skapa inferensmotorn och granska modellens inferensresultat. Följ helt enkelt appens guide och konfigurera det hela med några få steg!

Använd förinlärda modeller för att påskynda utvecklingen

Förutom att söka efter eller lära in dina egna modeller, tillhandahåller OpenVINO™ även Intel®-optimerade förinlärda modeller i användartillämpningar, kallad inferensmotorn (Inference Engine).

-

OpenVINO™ inkluderar två uppsättningar optimerade modeller. Det går att lägga till dessa modeller direkt i din miljö och accelerera utvecklingen.

Förinlärda modeller:

- Igenkänning av ålder och kön

- Vägkorsning

- Huvudets läge

- Säkerhetsbarriärer

- Igenkänning av fordonsfunktioner

- … med mera

-

Importera dina egna inlärda modeller för att utnyttja optimeringen i Model Optimizer och Inference Engine så att det till slut blir enkelt att köra inferens för datorseende på aktuella och framtida Intel®-arkitekturer för att uppfylla dina AI-behov. OpenVINO™ fungerar med förinlärda modeller i formaten Caffe eller TensorFlow.

QNAP NAS som inferensserver

OpenVINO™ förlägger arbetsbelastningen på Intel®-maskinvara (inklusive acceleratorer) och maximerar prestanda. Använd med OpenVINO™ Workflow Consolidation Tool blir en Intel®-baserad QNAP NAS en perfekt inferensserver som hjälper organisationer att snabbt bygga ett inferenssystem. Tillsammans med en modelloptimerare och inferensmotor blir OpenVINO™ lättanvänt och flexibelt för snabbt och högpresterande datorseende som förbättrar djup inlärningsinferens. AI-utvecklare kan distribuera inlärda modeller på en QNAP NAS för inferens och installera maskinvaruacceleration baserad på Intel®-plattformar för att uppnå optimal prestanda för löpande inferens.

Lätthanterad inferensmotor

-

Ladda upp en videofil

-

Ladda ned inferensresultat

Förbättrad prestanda med acceleratorkort

OpenVINO™ stöder heterogen körning på datorseendeacceleratorer (CPU, GPU, FPGA och VPU) med ett gemensamt API för enhetsspecifik optimering.

-

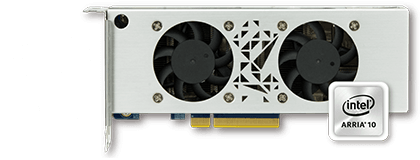

AcceleratorFPGA

- Intel® Arria® 10 GX 1150 FPGA

- 8 st. PCIe 3.0

- Låg profil, halv storlek, dubbla fack

-

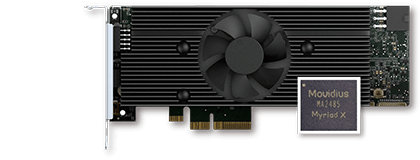

AcceleratorVPU

- Intel® Movidius™-lösning

- 8 st. Myriad™ X VPU

- 4 st. PCIe 2.0

- Låg profil, halv storlek, ett fack

Obs!

- QTS 4.4.0 (eller senare) och OWCT v1.1.0 krävs för QNAP NAS.

- Funktionen för genomströmning i virtuell dator inaktiveras för att använda FPGA-kortet på QNAP NAS. Undvik dataförlust genom att säkerställa att alla pågående NAS-uppgifter avslutas före omstart.

- Modeller som stöds fullständigt (Kontrollera OWCT-utgåveanteckning)

- TVS-x72XT: CPU, iGD, VPU (Obs: TVS-472XT stöds inte)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINO och logotypen OpenVINO är varumärken som tillhör Intel Corporation i USA och/eller andra länder.