OpenVINO™ Workflow Consolidation Tool

속도 향상, 간소화 및 딥 러닝 추론 확인

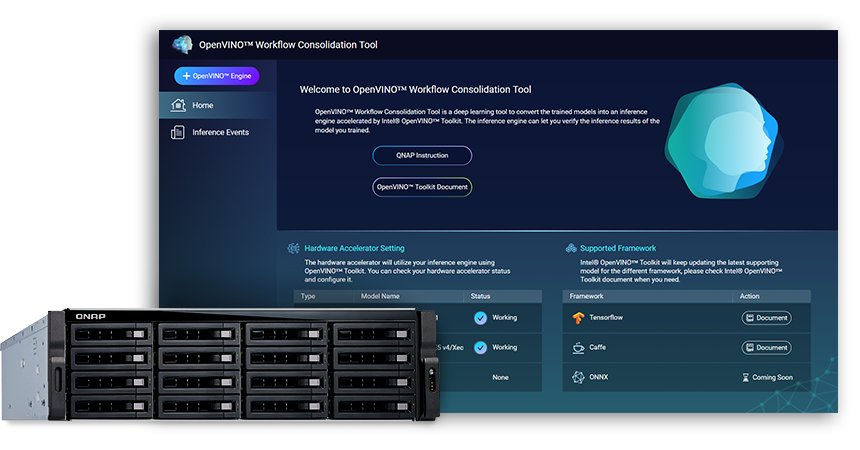

OWCT(OpenVINO™ Workflow Consolidation Tool)(QTS App Center에서 사용 가능)는 AI를 활용하는 비전 솔루션을 경제적으로 배포하는 것을 돕는 Intel® Distribution of OpenVINO™ 툴킷(Open Visual Inference and Neural Network Optimization)에 의해 가속화된 추론 서비스로 훈련된 모델을 변환하기 위한 딥 러닝 도구입니다.

QNAP는 OpenVINO™ Workflow Consolidation Tool을 제공하여 QNAP NAS를 Inference Server로 만듭니다.

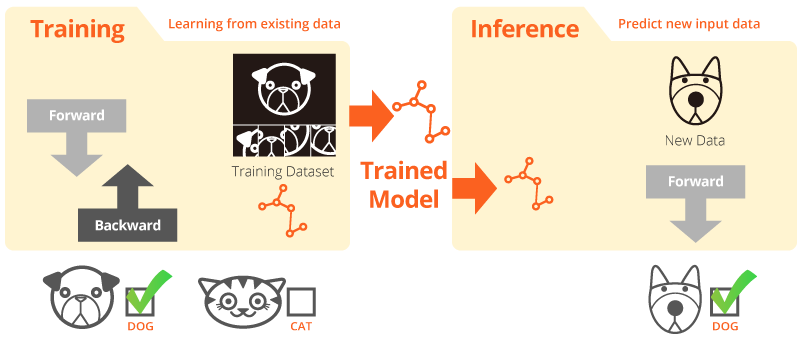

훈련과 추론

“훈련”은 시스템이 기존 데이터에서 학습하는 것입니다. “추론”은 훈련된 모델을 사용하여 실제 데이터로 유용한 예측을 하는 것입니다.

Intel® Distribution of OpenVINO™ 툴킷

OpenVINO™ 툴킷은 고성능 컴퓨터 비전 개발과 비전 애플리케이션에 대한 딥 러닝을 빨리 추적하도록 돕습니다. 하드웨어 가속기에 대한 딥 러닝과 CPU, GPU, FPGA 및 VPU를 비롯한 Intel® 플랫폼 전반에 대한 쉬운 여러 종류의 실행을 가능하게 합니다. 주요 구성 요소는 다음과 같습니다.

- Intel® Deep Learning Deployment Toolkit(모델 옵티마이저 및 추론 엔진)

- OpenCV* 및 OpenVX*에 대해 최적화된 기능

- 쉬운 배포를 위해 15개 이상의 샘플 코드와 사전 훈련된 모델 제공

소스: Intel

컴퓨터 비전용 AI 추론이 이제 더욱 빨라집니다!

OWCT(OpenVINO™ Workflow Consolidation Tool)를 사용할 경우 주요 장점은 다음과 같습니다.

-

속도 증가

OpenVINO™ 툴킷에는 개발 시간을 줄이고 딥러닝 추론과 비전 중심의 솔루션 배포를 간소화하는 오픈 소스 라이브러리가 포함되어 있습니다.

-

최적화

모델 옵티마이저는 훈련된 모델을 IR(Intermediate Representation)로 변환하고 효율적인 추론을 위해 기본 최적화를 수행합니다.

-

GUI

OWCT는 사용자가 OpenVINO™ 기능을 쉽게 활용하고, 비주얼을 표시하고 추론 결과를 다운로드하도록 허용하는 GUI를 사용합니다.

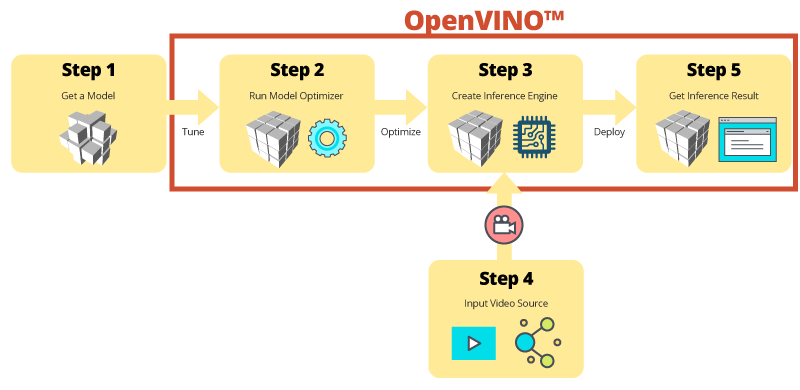

OWCT를 사용한 단계별 추론

OWCT는 OpenVINO™의 필요한 모든 기능을 통합하여 추론 엔진을 만들고 모델의 추론 결과를 검토하도록 돕습니다. 간단히 앱 마법사를 따르고 몇 단계 만에 필요한 사항을 설정하십시오!

사전 훈련된 모델을 사용하여 개발 가속화

사용자 개인의 모델을 검색하거나 훈련하는 것 외에도 OpenVINO™ 툴킷은 추론 엔진이라고 하는 사용자 애플리케이션에서 Intel® 최적화된 사전 훈련된 모델을 제공합니다.

-

OpenVINO™ 툴킷에는 2개의 최적화된 모델 세트가 포함되어 있습니다. 이 모델을 사용자 환경에 직접 추가하여 개발을 가속화할 수 있습니다.

사전 훈련된 모델은 다음과 같습니다.

- 나이 및 성 인식

- 크로스로드

- 머리 위치

- 보안 장애

- 차량 기능 인식

- 기타

-

사용자 개인의 훈련된 모델을 가져와서 모델 옵티마이저 및 추론 엔진에서 최적화를 활용하고, 결국에는 현재 및 미래의 Intel® 아키텍처에서 컴퓨터 비전을 위한 추론을 쉽게 실행하여 AI 필요를 만족시킬 수 있습니다. OpenVINO™ 툴킷은 Caffe 또는 TensorFlow 형식을 사용하는 사전 훈련된 모델과 작동합니다.

Inference Server로서의 QNAP NAS

OpenVINO™ 툴킷은 워크로드를 Intel® 하드웨어(가속기 포함) 전체로 확장하고 성능을 극대화합니다. OpenVINO™ Workflow Consolidation Tool과 함께 사용할 때 Intel® 기반 QNAP NAS는 조직에서 추론 시스템을 빨리 구축하도록 돕는 이상적인 Inference Server를 제공합니다. 모델 최적화 및 인퍼런스 엔진을 제공하는 OpenVINO™ 툴킷은 사용하기 쉽고 딥 러닝 인퍼런스를 개선하는 고성능, 낮은 지연 컴퓨터 비전에 유연합니다. AI 개발자는 추론을 위한 QNAP NAS에서 훈련된 모델을 배치하고 Intel® 플랫폼을 기반으로 하드웨어 가속기를 설치하여 추론을 실행하기 위한 최적의 성능을 얻습니다.

관리하기 쉬운 추론 엔진

-

비디오 파일 업로드

-

추론 결과 다운로드

가속기 카드로 향상된 성능

OpenVINO™ 툴킷은 장치별 최적화를 위한 공통 API를 사용하여 컴퓨터 비전 가속기(CPU, GPU, FPGA 및 VPU) 전체에 걸쳐 여러 종류의 실행을 지원합니다.

-

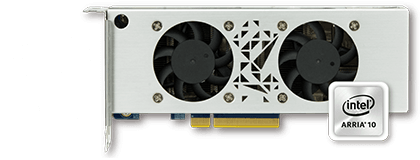

가속기FPGA

- Intel® Arria® 10 GX 1150 FPGA

- PCIe 3.0 x8

- 로우 프로필, 절반 크기, 이중 슬롯

-

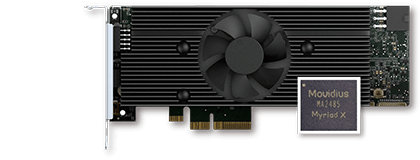

가속기VPU

- Intel® Movidius™ 솔루션

- 8x Myriad™ X VPU

- PCIe 2.0 x4

- 로우 프로필, 절반 크기, 단일 슬롯

참고:

- QTS 4.4.0(또는 이상) 및 OWCT v1.1.0이 QNAP NAS에 필요합니다.

- QNAP NAS에서 FPGA 카드 컴퓨팅을 사용하려면 VM 패스스루 기능이 비활성화됩니다. 잠재적인 데이터 손실을 방지하려면, 다시 시작 전에 진행 중인 모든 NAS 작업이 완료되었는지 확인하십시오.

- 전체 지원 모델 (OWCT 릴리즈 노트 확인)

- TVS-x72XT: CPU, iGD, VPU (참고: TVS-472XT는 지원되지 않음)

- TVS-x72XU: CPU, iGD, FPGA, VPU

- TS-x82: CPU, iGD, FPGA, VPU

- TS-x83: CPU, FPGA, VPU

- TS-x85: CPU, FPGA, VPU

- TS-x88: CPU, FPGA, VPU

- TS-x89U: CPU, FPGA, VPU

OpenVINO 및 OpenVINO 로고는 미국 및/또는 다른 국가에 있는 Intel Corporation 또는 그 지사의 상표입니다.